PISA-Studien

Die PISA-Studien der OECD sind internationale Schulleistungsuntersuchungen, die seit dem Jahr 2000 in dreijährlichem Turnus in den meisten Mitgliedstaaten der OECD und einer zunehmenden Anzahl von Partnerstaaten durchgeführt werden und die zum Ziel haben, alltags- und berufsrelevante Kenntnisse und Fähigkeiten Fünfzehnjähriger zu messen. Das Akronym PISA wird in den beiden Amtssprachen der OECD unterschiedlich aufgelöst: englisch als Programme for International Student Assessment (Programm zur internationalen Schülerbewertung) und französisch als Programme international pour le suivi des acquis des élèves (Internationales Programm zur Mitverfolgung des von Schülern Erreichten).[1]

Dieser Artikel behandelt die internationale Studie der OECD. Das Konzept der OECD sieht ausdrücklich die Möglichkeit vor, dass Teilnehmerstaaten den internationalen Test um nationale Komponenten erweitern. Diese Möglichkeit wurde in Deutschland 2000 bis 2018 in unterschiedlichem Ausmaß genutzt:[2]

- Für den Bundesländervergleich PISA-E wurden zehnmal so viele Schüler getestet wie für den deutschen Beitrag zur internationalen Studie.

- In PISA-International-Plus wurden einige Schulklassen nach einem Jahr ein zweites Mal getestet, um Lernfortschritte im Laufe des neunten oder zehnten Schuljahrs zu messen.

Außerdem bietet die OECD Erweiterungsmodule an, die nur von einem Teil der Staaten genutzt werden, z. B.:

- PISA-Elternstudie: Eltern nahmen an demselben Test teil wie zuvor ihre Kinder.

- computergestützte Tests: Pilotstudie 2006

Die OECD ließ 2011/12 eine weitere Studie umsetzen, die die Kompetenzen von 16- bis 65-Jährigen prüft: die PIAAC, von den Medien als „PISA für Erwachsene“ bezeichnet.

Konzept

Die folgenden Merkmale unterscheiden PISA zum Teil deutlich von früheren Schulleistungsuntersuchungen:

- PISA wird im Auftrag der Regierungen durchgeführt (in Deutschland: der Kultusministerkonferenz, in der Schweiz: Bund und Kantone).

- PISA soll in regelmäßigem Turnus fortgeführt werden.

- PISA untersucht Schüler einer Altersstufe, nicht einer schulischen Klassenstufe.

- PISA konzentriert sich nicht auf ein einzelnes Schulfach, sondern untersucht die drei Bereiche Lesekompetenz, mathematische Kompetenz und naturwissenschaftliche Grundbildung. Dieser Bildungsbegriff wird auf Englisch als literacy und numeracy bezeichnet.

- Aufgaben werden in „persönlich oder kulturell relevante Kontexte“ eingebettet.

- PISA orientiert sich nicht an der Schnittmenge nationaler Curricula, sondern erhebt den Anspruch, „... über die Messung von Schulwissen hinauszugehen und die Fähigkeit zu erfassen, bereichsspezifisches Wissen und bereichsspezifische Fertigkeiten zur Bewältigung von authentischen Problemen einzusetzen.“[3]

- Dies soll der Entwicklung von Humankapital dienen, welches die OECD als „das Wissen, die Fähigkeiten, die Kompetenzen, … die relevant sind für persönliches, soziales und ökonomisches Wohlergehen“ (OECD 1999) definiert.

Vertragsmäßige Aufgabe der OECD ist Politikberatung. PISA soll nicht nur eine Beschreibung des Ist-Zustandes liefern, sondern Verbesserungen auslösen. Insoweit PISA ein eigenes Bildungskonzept zugrunde liegt, wird zumindest implizit der Anspruch erhoben, auf die nationalen Lehrpläne zurückzuwirken.

Jede PISA-Studie umfasst die drei Bereiche Lesekompetenz, Mathematik und Naturwissenschaften. Bei jedem Durchgang wird ein Bereich vertieft untersucht: 2000 die Lesekompetenz, 2003 Mathematik, 2006 Naturwissenschaften. Dieser Zyklus wird derzeit (2018, 2021, 2024) ein drittes Mal durchlaufen. Die Ergebnisse werden jeweils im Dezember des Folgejahres veröffentlicht, die technischen Berichte einige Monate später.

Zusätzlich wird in jeder Studie ein Querschnittsthema untersucht: 2000 Lernstrategien und Selbstreguliertes Lernen, 2003 Problemlösung, 2006 Informationstechnologische Grundbildung. Diese Zusatzuntersuchung wird nicht in allen Staaten durchgeführt.

Testaufgaben

Nach jeder Testrunde wird ein Teil der Testaufgaben „freigegeben“ und veröffentlicht. Sämtliche freigegebenen Aufgaben finden sich auch online auf den Webseiten der OECD und der nationalen Projektleitungen. Die Testhefte umfassen typischerweise ungefähr zwanzig Aufgabeneinheiten. Jede Aufgabeneinheit besteht aus Einleitungsmaterial und eine bis sieben daran anschließenden Aufgaben.

Die Aufgabeneinheit „Tschadsee“ aus dem Lesetest von PISA 2000[4] zeigt beispielhaft, wie weit das literacy-Konzept von PISA gefasst ist. Die Einleitung dieser Aufgabe enthält keinen Lesetext im herkömmlichen Sinn, sondern besteht in der Hauptsache aus zwei Diagrammen („nicht-textuelles Lesematerial“), die die Schwankungen des Wasserstands in den letzten 12.000 Jahren und das Verschwinden und Auftauchen von Großtierarten darstellen. Daran schließen sich fünf Aufgaben an. Beispielhaft:

- Frage 1: „Wie tief ist der Tschadsee heute?“ (Multiple Choice, fünf Optionen)

- Frage 2: „In welchem Jahr ungefähr startet der Graph in Abbildung A?“ (freier Text)

- Frage 3: „Warum hat der Autor dieses Jahr als Anfang des Graphen gewählt?“ (freier Text)

Die Fragen 4 und 5 sind dann wieder im Multiple-Choice-Format.

Durchführung und Auswertung

PISA ist eines von mehreren Projekten, mit denen sich die OECD seit den 1990er Jahren verstärkt im Bereich Bildungsmonitoring engagiert. Die Koordination und die Endredaktion der internationalen Berichte obliegen einer kleinen Arbeitsgruppe am Hauptsitz der OECD in Paris unter Leitung des Deutschen Andreas Schleicher. Politisch wird das Projekt von einem Rat aus Regierungsvertretern gesteuert; wissenschaftlich wird es von einem Expertengremium nebst Unterausschüssen begleitet. Die Erstellung und Auswertung der Testaufgaben wurde ausgeschrieben und an ein Konsortium aus mehreren Unternehmen der Testindustrie unter Leitung des Australian Council for Educational Research (ACER) vergeben.

In den Teilnehmerstaaten wurden nationale Projektzentren eingerichtet.[5] In jedem Staat werden Stichproben von mindestens 5000 Schülern gezogen; in manchen Staaten, vor allem um Regionalvergleiche zu ermöglichen, ein Vielfaches davon.

Der Test umfasst eine zweistündige „kognitive“ Testsitzung, gefolgt von einer knapp einstündigen Fragebogensitzung („Questionnaire“). Im kognitiven Test bearbeiten nicht alle Schüler dieselben Aufgaben; 2003 wurden dreizehn verschiedene Testhefte (sowie in manchen Ländern in Sonderschulen ein Kurzheft) eingesetzt; von insgesamt 165 verschiedenen Aufgaben hatte jeder einzelne Schüler nur etwa 50 zu bearbeiten.

Die Schülerlösungen werden von angelernten Hilfskräften kodiert, digital erfasst und ans internationale Projektzentrum nach Australien zur weiteren Auswertung übermittelt. Die meisten Aufgaben werden letztlich nur als entweder „falsch“ oder „richtig“ bewertet. Je nachdem, wie viele Schüler eine Aufgabe richtig gelöst haben, wird der Aufgabe ein bestimmter „Schwierigkeitswert“ zugeordnet. Je nachdem, wie viele Aufgaben ein Schüler gelöst hat, wird dem Schüler eine bestimmte Spanne „plausibler“ „Kompetenzwerte“ zugeordnet. Schwierigkeits- und Kompetenzwerteskala werden nachträglich so skaliert, dass die Kompetenzwerte im OECD-Staatenmittel den Mittelwert 500 und die Standardabweichung 100 haben. Um auszugleichen, dass die Testhefte unterschiedlich schwierig waren und dass einzelne Aufgaben in einzelnen Staaten, zum Beispiel wegen Druckfehlern, nicht gewertet werden konnten, wird die gesamte „Skalierung“ der Schwierigkeits- und Kompetenzwerte unter Zuhilfenahme eines komplexen mathematischen Modells des Schülerantwortverhaltens, der sogenannten Item-Response-Theorie berechnet.

Die Aufgabenschwierigkeitswerte erlauben ansatzweise eine „didaktische“ Interpretation der Testergebnisse: Wenn ein Schüler beispielsweise 530 Kompetenzpunkte erzielt hat, dann kann er mit 62-prozentiger Wahrscheinlichkeit (die Zahl 62 Prozent ist willkürlich festgelegt worden) eine Aufgabe der Schwierigkeit 530 lösen. Wenn man sich nun veröffentlichte Aufgabenbeispiele anschaut, deren Schwierigkeitswert in der Nähe von 530 liegt, dann bekommt man einen Eindruck, was ein Kompetenzwert von 530 bedeutet. Allerdings muss man dabei beachten, dass der Test unter erheblichem Zeitdruck stattfindet (knapp über zwei Minuten pro Aufgabe).

Fast alle weiterführenden Auswertungen beruhen darauf, dass die statistische Verteilung der Schülerkompetenzwerte in den Teilnehmerstaaten oder feiner aufgeschlüsselten Populationen untersucht wird.

Quantitative Ergebnisse

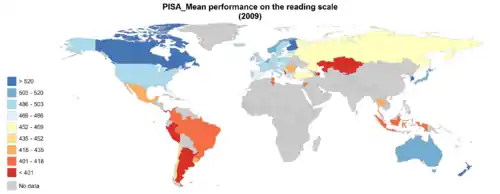

PISA misst Schülerleistung in Punkten auf einer willkürlichen Skala. Interpretierbar werden die Punktwerte erst, wenn sie in einen Kontext gesetzt werden. Das geschieht regelmäßig durch den Vergleich zwischen verschiedenen Ländern. Die Berichte der OECD und ihrer Projektpartner bestehen dementsprechend zu einem erheblichen Teil aus Länder-Ranglisten.

Entwicklung der Leistungen 2000–2015

Die elementarste und meistbeachtete Statistik fasst die Schülerleistungen zu Mittelwerten zusammen. In der folgenden Tabelle sind die bisherigen Ergebnisse der mehrheitlich deutschsprachigen Staaten, einiger weiterer OECD-Staaten sowie einiger Nicht-OECD-Staaten (kursiv) zusammengefasst; in Klammern der OECD-Rangplatz.

| Land | Mathematik | Lesefähigkeit | Naturwissenschaften | |||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| 2000 | 2003 | 2006 | 2009 | 2012 | 2015 | 2000 | 2003 | 2006 | 2009 | 2012 | 2015 | 2000 | 2003 | 2006 | 2009 | 2012 | 2015 | |

| 490±3 (20) | 503±3 (16) | 504±4 (14) | 513±3 (10) | 514 | 506 | 484±3 (21) | 491±3 (18) | 495±4 (14) | 497±3 (16) | 508 | 509 | 487±2 (20) | 502±4 (15) | 516±4 (8) | 520±3 (9) | 524 | 509 | |

| 514±7 | 536±4 | ± | 536±4 | 535 | 483±4 | 525±4 | ± | 499±3 | 516 | 476±7 | 525±4 | ± | 520±3 | 525 | ||||

| 446±2 (26) | 493±1 (20) | 490±1 (22) | 489±1 (24) | 490 | 486 | 441±2 (26) | 479±2 (23) | 479±1 (22) | 472±1 (30) | 488 | 481 | 443±2 (26) | 483±1 (24) | 486±1 (25) | 484±1 (29) | 491 | 483 | |

| 515±3 (11) | 506±3 (15) | 505±4 (13) | 496±3 (18) | 506 | 497 | 507±2 (10) | 491±4 (19) | 490±4 (14) | 470±3 (31) | 490 | 485 | 519±3 (8) | 491±3 (20) | 511±4 (12) | 494±3 (24) | 506 | 495 | |

| 529±4 (7) | 527±3 (7) | 530±3 (4) | 534±3 (3) | 531 | 521 | 494±4 (17) | 499±3 (11) | 499±3 (11) | 501±2 (11) | 509 | 492 | 496±4 (18) | 513±4 (9) | 512±3 (11) | 517±3 (10) | 515 | 506 | |

| 520±4 (9) | 529±2 (6) | 520±3 (8) | 515±2 (8) | 515 | 507 | 507±4 (11) | 507±3 (9) | 501±3 (10) | 506±2 (8) | 509 | 499 | 496±4 (17) | 509±3 (11) | 510±3 (13) | 507±3 (15) | 505 | 502 | |

| 536±2 (4) | 544±2 (1) | 548±2 (1) | 541±2 (2) | 519 | 511 | 546±3 (1) | 543±2 (1) | 547±2 (2) | 536±2 (2) | 524 | 526 | 538±3 (3) | 548±2 (1) | 563±2 (1) | 554±2 (1) | 545 | 531 | |

| 517±3 (10) | 511±3 (13) | 496±3 (17) | 497±3 (16) | 495 | 493 | 505±3 (14) | 496±3 (14) | 488±4 (17) | 496±3 (18) | 505 | 499 | 500±3 (12) | 511±3 (10) | 495±3 (19) | 498±4 (21) | 499 | 495 | |

| 457±3 (24) | 466±3 (26) | 462±2 (27) | 483±2 (29) | 485 | 490 | 487±3 (20) | 476±3 (25) | 469±2 (24) | 486±2 (23) | 490 | 485 | 478±3 (23) | 483±3 (24) | 475±2 (26) | 489±2 (27) | 494 | 481 | |

| 557±6 (1) | 534±4 (4) | 523±3 (6) | 529±3 (4) | 536 | 532 | 522±5 (8) | 498±4 (12) | 498±4 (12) | 520±4 (5) | 538 | 516 | 550±6 (2) | 548±4 (2) | 531±3 (3) | 539±3 (2) | 547 | 538 | |

| 533±1 (6) | 532±2 (5) | 527±2 (5) | 527±2 (5) | 518 | 516 | 534±2 (2) | 528±2 (3) | 527±2 (3) | 524±2 (3) | 523 | 527 | 529±2 (5) | 519±2 (8) | 534±2 (2) | 529±2 (5) | 525 | 528 | |

| 387±3 (27) | 385±4 (29) | 406±3 (30) | 419±2 (34) | 413 | 408 | 422±3 (27) | 400±4 (29) | 410±3 (29) | 425±2 (34) | 424 | 423 | 422±3 (27) | 405±3 (29) | 410±3 (30) | 416±2 (34) | 415 | 416 | |

| disq. | 538±3 (3) | 531±3 (3) | 526±5 (6) | 523 | 512 | disq. | 513±3 (8) | 507±3 (9) | 508±5 (7) | 511 | 503 | disq. | 524±3 (5) | 525±3 (6) | 522±5 (8) | 522 | 509 | |

| k. T. | 423±7 (28) | 424±5 (29) | 445±4 (32) | 448 | 420 | k. T. | 441±6 (28) | 447±4 (28) | 464±4 (32) | 475 | 428 | k. T. | 434±6 (28) | 424±4 (29) | 454±4 (32) | 463 | 425 | |

| 493±8 (19) | 483±3 (24) | 474±4 (25) | 487±4 (25) | 481 | 470 | 504±7 (15) | 495±3 (15) | ± () | 500±4 (14) | 498 | 497 | 499±7 (14) | ± () | 489±4 (21) | 502±4 (17) | 497 | 496 | |

Shanghai (China) belegt den ersten Platz in allen Fächern der Jahre 2009 und 2012. Im Jahr 2015 belegte Singapur den ersten Platz. Neben Finnland, Japan und Kanada befinden sich auch Südkorea, Neuseeland, Australien und das nicht zur OECD gehörige Territorium Hongkong regelmäßig in der Spitzengruppe. Vor der Türkei und Mexiko befinden sich am Tabellenende neben Italien regelmäßig Portugal, Griechenland und Luxemburg.

Bei einer Aufschlüsselung nach Sprachgruppen fällt auf:

- In Belgien sind die Leistungen im niederländischsprachigen Landesteil wesentlich besser als im französischsprachigen; sie liegen oft noch über den niederländischen Ergebnissen im internationalen Spitzenfeld.

- In der Schweiz sind die Unterschiede zwischen der deutschen und französischen Sprachgruppe eher gering; die italienischsprachige Schweiz liegt etwas zurück.

- Die Ergebnisse aus Südtirol sind beachtlich und liegen durchweg in der internationalen Spitzengruppe. Dabei haben die Schulen mit deutscher Unterrichtssprache leicht besser abgeschnitten als die italienischen.

- In Finnland schneidet die etwa fünfprozentige schwedischsprachige Minderheit um 10 bis 35 Punkte schlechter ab als die finnischsprachige Mehrheit.

- In Kanada schneidet die englischsprachige Mehrheit merklich besser ab als die französischsprachige Minderheit.

Die Ergebnisse aus Liechtenstein haben erhöhte Fehlerbalken, weil dort kaum mehr als 350 Fünfzehnjährige wohnen. Immerhin entfallen die diversen Probleme der Stichprobenziehung, denn es wurde, wie auch in Luxemburg, ein Kompletttest aller Schüler durchgeführt. Außerdem ist Liechtenstein das einzige Land, welches nicht von nationalen Organisationen getestet wird, sondern von der Pädagogischen Hochschule St. Gallen aus der benachbarten Schweiz.

Zu den starken Unterschieden zwischen den deutschen Bundesländern → PISA-E.

Die Korrelation mit den TIMSS-Studien, die in einigen Staaten parallel zu PISA fortgeführt werden, ist mäßig, was offiziell mit unterschiedlichen Inhalten und mit Normierungseffekten aufgrund unterschiedlicher Teilnehmerschaft erklärt wird.

Kompetenzstufen und Risikogruppen

Um den zahlenmäßigen Ergebnissen eine anschauliche Bedeutung zu geben, teilt das Konsortium die Punkteskala willkürlich in sechs »Kompetenzstufen« und eine darunter liegende Stufe absoluter Inkompetenz. Anhand der Aufgaben, die auf einer Stufe zu lösen sind, wird dann eine verbale Beschreibung dessen, was Schüler auf einer bestimmten Stufe typischerweise können, erarbeitet. Zu beachten ist dabei, dass der Anteil der Schüler auf einer bestimmten Stufe im OECD-Mittel konstant, weil durch die Konstruktion der Schwierigkeits- und Leistungsskalen festgelegt ist. Interpretierbar sind lediglich die zumeist geringen Unterschiede zwischen Staaten.

Schüler „unterhalb“ der Stufe 1 werden international als „at risk“ bezeichnet. Die deutsche Projektleitung hat den Begriff „Risikogruppe“ jedoch ausgedehnt und die Stufe 1 darin einbezogen. Das wurde in Teilen der Öffentlichkeit verkürzt und im Gegensatz zu Aussagen der internationalen Berichte so rezipiert, als sei ein knappes Viertel aller Fünfzehnjährigen nicht in der Lage, zu rechnen und sinnerfassend zu lesen.

Einfluss des sozialen Hintergrunds

Im Anschluss an die zweistündige Testsitzung zur Messung kognitiver Leistungen bearbeiten die Schüler einen Fragebogen mit Fragen zum familiären Hintergrund, zum schulischen Umfeld, zu Lerngewohnheiten und ähnlichem. In den offiziellen Ergebnisberichten und in zahlreichen Sekundärstudien wird dargestellt, wie sich diese Kontextvariablen auf die kognitive Testleistung auswirken.

In PISA 2000 wurde festgestellt, dass der Zusammenhang zwischen Testergebnis und elterlichem Beruf in Deutschland so stark ist wie nirgendwo sonst. In den Folgerunden wurde dieses Ergebnis jedoch nicht repliziert; der stärkste Zusammenhang wurde 2003 in Ungarn, 2006 in der Tschechischen Republik gefunden. Die deutschen Kennwerte (Quantildifferenzen, Gradienten und Korrelationskoeffizienten der Testleistung als Funktion einer Berufsklassifikation oder eines sozial-ökonomisch-kulturellen Indexes) lagen überwiegend im oberen Teil eines breiten Mittelfeldes; die Abweichungen vom OECD-Durchschnitt waren teilweise statistisch insignifikant.

Diesen Auswertungen liegen unterschiedliche Sozialindizes zugrunde, die zum Teil nur den Beruf der Eltern, zum Teil auch deren Bildungsabschlüsse und die Ausstattung des Haushalts mit kulturellen Besitztümern berücksichtigen. Zwischen dem deutschen Konsortium und der internationalen Projektleitung besteht Dissens über die sachgerechte Quantifizierung von sozialem Hintergrund; im deutschen Bericht zu PISA 2006 wird durchgehend ein anderer Index verwendet als im internationalen Bericht.

Ein weiteres Beispiel bei der Dateninterpretation besteht darin, dass sozialer Status und Einwanderungshintergrund stark miteinander korreliert sind. Die Daten alleine sagen nicht, inwieweit schwache Leistungen von Migrantenkindern ihrer unterdurchschnittlichen sozialen Lage oder zum Beispiel ihrer ungenügenden sprachlichen Integration zuzuschreiben sind.

In Deutschland ist überraschend, dass Einwanderer der ersten Generation (454 Punkte, Mathematikleistung 2003) im Schnitt besser abschneiden als im Land geborene Kinder zugewanderter Eltern (2. Generation, 432 Punkte); Schüler ohne Migrationshintergrund: 525 (OECD-weite Vergleichszahlen in derselben Reihenfolge: 475, 483, 523). Daraus wurde teilweise geschlossen, Kinder der zweiten Generation zeigten in Deutschland generell schlechtere Leistungen als Kinder der ersten Generation. Die weitere Aufschlüsselung hat dieses paradoxe Ergebnis jedoch damit erklärt, dass die Anteile der wichtigsten Herkunftsländer innerhalb der Kinder der ersten und der zweiten Generation deutlich unterschiedlich sind (z. B. größerer Anteil Jugendlicher aus der Türkei innerhalb der 2. Generation; vgl. die Erläuterungen zu Schülern mit Migrationshintergrund). Beim selben Herkunftsland sind die Ergebnisse der zweiten Generation durchweg besser als die der ersten.

Ein quantitativ bedeutsames Problem stellen die schwachen Leistungen türkischer Jugendlicher dar (Mathematikleistung 2003: erste Generation 382, zweite Generation 411). Erstaunlicherweise schnitten Schüler mit Migrationshintergrund bei sprachlastigen Aufgaben etwas besser ab als bei relativ sprachfreien; die Gründe dafür sind ungeklärt.[7]

Geschlechtsspezifische Leistungsdivergenzen

Die Ergebnisse aus PISA 2003 zeigen einen erheblichen Leistungsvorsprung der Mädchen im Lesen (34 Punkte international, 42 Punkte in Deutschland). Vierfach geringer ist der Vorsprung der Jungen in Mathematik (11 Punkte international, 9 Punkte in Deutschland). Im Problemlösen liegen Mädchen vorne (2 Punkte international, 6 Punkte in Deutschland), wobei diese Differenz nicht signifikant ist. In den Naturwissenschaften wurde ebenfalls kein signifikanter Geschlechterunterschied gefunden (international liegen Jungen vorne mit 6 Punkten, 6 Punkte in Deutschland).[8] Wuttke (2007) versucht nachzuweisen, dass dieses Ergebnis allein an der Mischung von Aufgaben aus verschiedensten Gebieten liege; in Übereinstimmung mit nationalen, lehrplannäheren Tests findet sie die Alltagsbeobachtung bestätigt, dass im Mittel Jungen in Physik, Mädchen in Biologie höhere Leistungen erzielten.

PISA 2009 hat gezeigt, dass die Kompetenzunterschiede zwischen Mädchen und Jungen seit PISA 2000 in Deutschland praktisch unverändert geblieben sind.[9] Der OECD-Bericht Equally prepared for life? How 15 year-old boys and girls perform in school untersucht geschlechtsspezifische Leistungsunterschiede und stützt sich dabei primär auf die Ergebnisse aus PISA 2009 (sowie auf die IGLU- und TIMSS-Studien). Die Forscher kommen zu dem Schluss, dass geschlechtsbezogene Vorurteile („Rollenmodelle“ und „Stereotype“ in der Sprache von PISA) die Bildungsergebnisse von Mädchen beeinflussen. Mädchen hätten eine geringere Selbsteinschätzung in Bezug auf mathematische Kompetenzen, weil Stereotype und falsche Rollenmodelle dieses forcierten, deshalb erbrächten sie schlechtere Leistungen – und nicht etwa umgekehrt. Auch die Entscheidung über den weiteren Bildungsweg und Beruf werde im Falle der Mädchen v. a. durch gesellschaftliche Entwicklungen und weniger durch die Mädchen und jungen Frauen selbst beeinflusst. Die stärker vorhandenen diagnostizierten Sprachschwächen unter Jungen werden da, wo sie überhaupt thematisiert werden, v. a. durch deren pädagogikinkompatibles Verhalten erklärt, Jungen passten weniger in eine feminisierte Lernumwelt wie Schule und lehnten als „unmännlich“ bewertete Tätigkeiten wie Lesen eher ab.[10]

Ergebnisse der PISA 2015-Studie

| Ergebnisse der PISA-Studie (2015)[11][12][13] Die Ergebnisse von PISA 2015 wurden am 6. Dezember 2016 präsentiert. Insgesamt 600.000 Schüler aus 72 Ländern hatten teilgenommen | |||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Mathematik | Naturwissenschaften | Leseverständnis | Gesamtdurchschnitt | ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

|

|

|

| ||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

*PISA-Tests wurden nur in den Provinzen Guangdong und Jiangsu sowie den Städten Shanghai und Peking durchgeführt, in denen zusammengenommen ca. 200 Millionen Einwohner leben.

Der Schwerpunkt der PISA-Studie von 2009 lag wie bei der ersten Studie aus dem Jahr 2000 auf der Lesekompetenz. Der Vergleich mit der ersten Studie dokumentiert für Deutschland eine positive Entwicklung auf breiter Basis:[14]

- Die Lesekompetenz hat seit 2000 signifikant zugenommen. Dies ist vor allem auf den Rückgang des Anteils an Jugendlichen mit sehr schwacher Lesekompetenz zurückzuführen.

- Jugendliche mit Migrationshintergrund verfügten 2009 mit 470 Punkten über eine deutlich bessere Lesekompetenz. Die Zunahme im Vergleich zu 2000 beträgt 26 Punkte. Der Unterschied zu Jugendlichen ohne Migrationshintergrund (im Schnitt 514) hat signifikant abgenommen.

- Der soziale Gradient, das heißt die Abhängigkeit der Kompetenzen vom sozialen Hintergrund hat im Vergleich zu 2000 signifikant abgenommen. Deutschland bewegt sich in dieser Hinsicht nun im OECD-Schnitt. Besonders profitierten Kinder aus Arbeiterfamilien und Kinder aus Familien, deren Eltern Routinetätigkeiten ausüben. Die Entwicklung ging nicht zu Lasten der Jugendlichen aus bildungsnahen Gruppen: Diese zeigten nach wie vor eine hohe Leistung.

- Der Zusammenhang zwischen Familiensprache und Lesekompetenz hat abgenommen. Dies spricht für eine bessere Kompensation von Benachteiligungen durch die Schulen.

- Die Lesefreude hat deutlich zugenommen.

- Die Expansion des Gymnasiums führte nicht zu einer Abnahme der Leistungen an dieser Schule, sondern zu einer Zunahme der Kompetenzen der Schülerschaft als Ganzes.

In einigen Feldern sind die positiven Entwicklungen schwächer ausgeprägt:

- Nach wie vor besteht ein sehr großer Unterschied der Lesekompetenz zwischen Jungen und Mädchen. Diese Diskrepanz hat leicht, aber nicht signifikant zugenommen. Diese Zunahme ist auf eine bessere Fähigkeit der Mädchen zum Umgang mit nicht-linearen Texten zurückzuführen. Jungen erreichen dagegen im Mittel eine höhere mathematische und naturwissenschaftliche Kompetenz. Die Geschlechtsunterschiede sind dort aber weniger stark ausgeprägt und betragen lediglich ein Viertel des Mädchenvorsprungs im Lesen.

- Trotz seiner Abflachung ist der soziale Gradient nach wie vor hoch.

- Die enorme Verbesserung der Lesekompetenz bei Kindern mit Migrationshintergrund ist bei Jugendlichen mit türkischem Hintergrund auch vorhanden, aber mit 18 Punkten deutlich schwächer ausgeprägt als bei den anderen Jugendlichen mit Migrationshintergrund.

- Nach wie vor gibt die Mehrheit der Jugendlichen an, nicht zum Vergnügen zu lesen.

Rezeption

PISA 2000, PISA 2003 und PISA 2006 haben in einigen Teilnehmerstaaten ein heftiges Medienecho ausgelöst; in Deutschland ist das Wort „PISA“ zum Inbegriff aller Probleme des Bildungswesens geworden.

In Deutschland

Deutschland hatte in den 1970er und 80er Jahren an keinem internationalen Schulvergleich teilgenommen. Der Richtungswechsel begann mit der Teilnahme an der Mathematikstudie TIMSS 1995. Die mittelmäßigen Ergebnisse wurden von Bildungspolitikern und Fachlehrern ausgiebig diskutiert, drangen aber nur kurz an die breite Öffentlichkeit.

Die Veröffentlichung der ersten PISA-Ergebnisse Ende 2001 wurde durch Vorabberichte mehrere Wochen lang vorbereitet und erzielte ein so überwältigendes Medien-Echo, dass bald von einem „PISA-Schock“ gesprochen wurde, was an den „Sputnikschock“ und die Debatte der 1960er Jahre um die von Georg Picht beschworene „Bildungskatastrophe“ erinnerte.

Ende 2002 beherrschte PISA erneut die Schlagzeilen, weil zum ersten Mal ein Leistungsvergleich zwischen den Bundesländern veröffentlicht wurde. Das Nord-Süd-Gefälle überraschte relativ wenig; in vielen Kommentaren wurde es durch den Verweis relativiert, dass in Bayern die Abiturquote zu niedrig und ein bestimmter statistischer Kennwert für soziale Selektivität besonders hoch sei (siehe Hauptartikel PISA-E).

Wenige Tage vor der Veröffentlichung von PISA 2006 (Teilergebnisse waren auch diesmal an die Presse durchgesickert) eskalierte der Konflikt zwischen der OECD und der deutschen Projektgruppe. Andreas Schleicher bezog sich auf den OECD-Bericht, dem zufolge weder in den drei Bereichen Naturwissenschaft, Mathematik, Leseleistung noch bei der Koppelung der Ergebnisse mit sozialer Herkunft Verbesserungen erreicht wurden, die über den statistischen Fehlerbereich hinausgingen. Die naturwissenschaftliche Aufgabenstellung sei im Wesentlichen neu konzipiert, in den wenigen Testaufgaben, die sowohl 2003 als auch 2006 verwendet wurden, seien die Leistungen unverändert. Umweltthemen hätten Deutschland 2006 begünstigt. Der deutsche Projektleiter Manfred Prenzel behauptete demgegenüber, die Ergebnisse seien sehr wohl zu vergleichen. Diese unterschiedlichen Einschätzungen stehen auch in den offiziellen Berichten.[15][16]

CDU-Kultusminister, insbesondere die hessische Ministerin Karin Wolff, nahmen das zum Anlass, Schleichers Entlassung zu fordern. Akut warf man ihm vor, mit der Kommentierung einer Vorveröffentlichung eine selbstgesetzte Sperrfrist verletzt zu haben. Die grundlegenden Vorwürfe an ihn waren:

- Schleicher maße sich die Rolle eines „Supervisors“ an, der vorgebe, wie die Daten interpretiert werden dürfen.

- Man gebe viel Geld aus, um Trends zu messen, und erfahre nun, wie problematisch Vergleiche über 3 und 6 Jahre hinweg sind.

Die OECD wies diese Vorwürfe zurück. Die Interpretation entspreche den Ergebnissen der Studie. Eine Vergleichbarkeit über die Jahre sei sehr wohl gegeben, allerdings nicht in den jeweils neu getesteten Einzelbereichen. Es sei so geplant gewesen, dass aufbauend alle drei Jahre ein neuer Bereich getestet werde. Nach der Leseleistung 2000 waren dies 2003 die mathematischen und 2006 erst die naturwissenschaftlichen Kenntnisse.

Einige CDU-Kultusminister erwogen laut, aus der PISA-Studie auszusteigen. Als Alternativen wurden der Bildungsmonitor der wirtschaftsnahen Initiative Neue Soziale Marktwirtschaft oder das Institut zur Qualitätsentwicklung im Bildungswesen genannt. Gleichzeitig drohte die OECD dem deutschen Projektleiter damit, dem ländervergleichenden PISA-E-Test das Label „PISA“ zu entziehen, wenn er die Daten nach seiner eigenen Methode skaliere, da dies dann nichts mehr mit PISA zu tun habe.

Der PISA-Konflikt reiht sich ein in eine Auseinandersetzung zwischen konservativen Bildungspolitikern in Deutschland und internationalen Organisationen. Streitpunkt war jedes Mal das dreigliedrige Schulsystem und die Frage, ob dieses Migrantenkinder und Kinder aus unteren Schichten benachteilige. Im Dezember 2006 wurde ein entsprechendes Papier der EU-Kommission zurückgewiesen, und im Frühjahr 2007 wurde der UN-Beobachter für das Menschenrecht auf Bildung, Vernor Muñoz, für seinen kritischen Bericht scharf angegriffen. Bereits im Sommer 2007 wurde die internationale jährlich erscheinende OECD-Studie Bildung auf einen Blick von konservativen Lehrerverbänden als „ideologisch“ bezeichnet. Ein großes Problem der Pisastudie liegt darin, dass die OECD lediglich zwischen Schülern, die in Deutschland geboren sind, und solchen, die im Ausland geboren sind, unterscheidet. Auf diese Weise lassen sich die schulischen Erfolge von Migrantenkindern und Kindern mit "rein deutschen Wurzeln" nur bedingt vergleichen.

In Österreich

In Österreich trat der „PISA-Schock“ verspätet ein: Nachdem man sich 2000 noch daran delektiert hatte, deutlich besser als Deutschland abgeschnitten zu haben, wurde das Ergebnis aus 2003 als „Absturz“ wahrgenommen. Daraufhin veranlasste Bildungsministerin Elisabeth Gehrer eine Überprüfung durch die Statistiker Erich Neuwirth, Ivo Ponocny und Wilfried Grossmann, die in ihrem 2006 erschienenen Untersuchungsbericht[17] zahlreiche Ungereimtheiten bei der Stichprobenziehung und Datenauswertung zutage förderten. Insbesondere war 2000 die Stichprobe in den Berufsschulen nicht korrekt gezogen worden. In einem Vorwort zu diesem Untersuchungsbericht spielt der PISA-Koordinator der OECD, Andreas Schleicher, die Korrekturen herunter und behauptet, die OECD habe bislang darauf hingewiesen, dass eine Interpretation der österreichischen Ergebnisse nur „eingeschränkt zulässig“ gewesen sei. Nach weiterer Verzögerung hat die OECD Anfang 2007 nahezu unbeachtet die Ergebnisse von Neuwirth et al. in den internationalen Datensatz übernommen und damit die österreichischen Ergebnisse aus 2000 offiziell nach unten korrigiert. Diesen korrigierten Daten zufolge hat es nie einen Absturz gegeben; 2000 und 2003 lagen die österreichischen Schülerleistungen gleichermaßen im Mittelfeld; es gab keine statistisch signifikanten Veränderungen.[18]

Aufschlussreich ist die offensichtliche Falschberechnung des PISA-Ergebnisses für 2000 deshalb, weil durch den angeblichen PISA-Absturz von 2000 auf 2003 zunächst der neu angetretenen konservativen Regierung bescheinigt werden sollte, sie habe durch ihre Bildungspolitik den Absturz verschuldet. Die nach den Wahlen im Oktober 2006 zurückgetretene konservative Unterrichtsministerin Elisabeth Gehrer (ÖVP) wollte hingegen durch die von ihr beauftragte Schlechter-Bewertung des unter einer sozialdemokratischen Regierung zustande gekommenen Ergebnisses für 2000 den Absturz widerlegen. Beide Male wurde das österreichische PISA-Ergebnis parteipolitisch instrumentalisiert bzw. nach oben und dann nach unten gerechnet, ohne dass das PISA-Reglement hinreichend klar festgelegt hätte, wie Ergebnisse richtig zu berechnen und Stichproben weltweit einheitlich festzulegen sind.

Auch das Ergebnis der PISA-Studie 2009 wirft grundsätzliche Fragen bezüglich Validität und Aussagekraft auf. Das PISA-Konsortium räumte offiziell ein, dass zahlreiche Fragebögen deutliche Spuren eines von den Lehrergewerkschaften ausgerufenen Boykotts aufwiesen.[19] Dennoch wurde die österreichische Stichprobe ausgewertet, nachdem jene Fragebögen ausgeschieden worden waren. Das Ergebnis fiel in allen drei Bereichen deutlich schlechter aus als in den Testdurchgängen davor (2000–2006) und danach (2012), was für eine Verfälschung des Ergebnisses durch den Boykott spricht. In jahresübergreifenden Trendvergleichen schließt die OECD die österreichischen Daten für 2009 jetzt aus und bezeichnet sie als fehlend, ohne eine Erklärung dafür zu liefern.[20]

Ähnlich wie in Deutschland sind soziale Unterschiede auffällig. Die Regierungsparteien (ÖVP und FPÖ) verwiesen bevorzugt auf schlechte Deutschkenntnisse von Ausländerkindern. Die damalige Ministerin Gehrer konstatierte weiterhin ein Fehlverhalten von Eltern, die sich zu wenig um ihre Kinder kümmern würden. Die Opposition (SPÖ und Grüne) äußerte den Vorschlag, statt des stark diversifizierten Schulensystems eine Gesamtschule einzuführen. Diese Idee ist stark beeinflusst vom finnischen Vorbild. Im dortigen Schulsystem gibt es zwar extreme Leistungsunterschiede innerhalb, aber kaum zwischen den Schulen. In Österreich jedoch war das Gegenteil zu spüren.

Ein am Fall Österreich virulent gewordenes technisch-statistisches Problem scheint indes weiterhin ungelöst zu sein, denn PISA wird in den einzelnen Ländern nach wie vor nicht nach einheitlichen Kriterien durchgeführt. In Österreich werden auch Lehrlinge, Migranten ohne Deutschkenntnisse und Sonderschüler getestet. Für PISA 2009 wurden in Tirol etwa an der Hauptschule Neustift ausschließlich drei Schüler mit Migrationshintergrund ausgelost, die keine reguläre Schullaufbahn hinter sich hatten, erst seit wenigen Jahren in Österreich lebten und mit 16 Jahren auch gar nicht der target population anzugehören scheinen.[21]

In Südtirol

Das italienische PISA-Zentrum INVALSI ermöglicht seit 2003 den Regionen und autonomen Provinzen an PISA mit einer so großen Stichprobe teilzunehmen, dass eine separate Auswertung zulässig ist. Für die Autonome Provinz Bozen – Südtirol werden die deutschsprachigen Testhefte aus Österreich übernommen. Die Provinz erzielt regelmäßig weit über dem nationalen Durchschnitt liegende Ergebnisse.

In Luxemburg

Luxemburg liegt in den drei geprüften Fächern – Lesen, Mathematik und Naturwissenschaften – unter dem OECD-Durchschnitt und rangiert hinter den meisten anderen europäischen Ländern. Bei der Interpretation der Resultate können u. a. folgende Hintergründe wichtig sein:

- Der Ausländeranteil liegt bei 44,5 % (2013, statec.lu).

- Die Vielsprachigkeit ist sehr stark ausgeprägt (Luxemburgisch, Deutsch, Französisch und Englisch sowie oft eine weitere Sprache wie Portugiesisch)

- Die Gesamtheit der Schülerschaft wurde getestet, es ist also keine Verzerrung möglich durch günstige Stichprobenwahl.

Das Modell Finnland

Finnland wurde in der öffentlichen Rezeption in Deutschland und Österreich allgemein als „Testsieger“ angesehen. Zahlreiche Erklärungen für das exzellente Abschneiden Finnlands wurden vorgeschlagen (siehe auch: Bildungssystem Finnland):

- eine in der Reformation verwurzelte Lesetradition,

- hohe Motivation, lesen zu lernen, durch Filme in Originalsprache mit Untertiteln in Fernsehen und Kino,

- Gemeinschaftsgefühl in einem kleinen Land: jeder Einzelne ist wichtig,

- vergleichsweise geringe soziale Unterschiede in der Bevölkerung,

- aufgrund der vergleichsweise geringen Zuwanderung wenig Probleme mit zuwanderungsbedingter mangelnder Sprachbeherrschung,

- ein ungegliedertes Gesamtschulsystem,

- hervorragende personelle Ausstattung der Schulen, unter anderem mit Sozialpädagogen; wo erforderlich, kommt eine zweite Lehrkraft in den Unterricht,

- höhere Qualität der Lehrer: Lehrer werden aus den besten 10 Prozent eines Jahrgangs in einem umfangreichen Verfahren vor, während und nach dem Studium ausgewählt.[22]

- Klassenstärken von in der Regel weniger als 20 Schülern,

- hervorragende materielle Ausstattung der Schulen: freundliche Gebäude, Bibliothek, Kantine,

- weitgehende Autonomie der Schulen verbunden mit wirkungsvoller Qualitätskontrolle. Statt detaillierte Lehrpläne vorzuschreiben, beschränkt sich die finnische Bildungsbürokratie darauf, Lernziele vorzugeben und landesweite Tests zu erarbeiten, mit denen überprüft wird, wie gut die Ziele erreicht wurden,

- Vertrautheit mit standardisierten Tests.

Die Begeisterung für Finnland rief auch kritische Stimmen auf den Plan, die darauf hinwiesen, dass Alkoholismus unter finnischen Schülern weitverbreitet und die Selbstmordrate alarmierend hoch sei. Aus statistischer Sicht relativiert sich das gute Abschneiden Finnlands, sobald man demographische, insbesondere soziale, Hintergrundvariablen kontrolliert.

Die Schulstrukturdebatte

Befürworter der Gesamtschule nutzten die PISA-Ergebnisse für eine Neuauflage der deutschen und österreichischen Schulstrukturdebatte. Sie verwiesen insbesondere auf:

- das hervorragende Abschneiden Finnlands und einiger anderer Staaten,

- die überdurchschnittliche Korrelation zwischen den deutschen Testergebnissen und dem sozialen bzw. Migrations-Hintergrund,

- die starke Korrelation zwischen Wahl des Schultyps und familiärem Hintergrund.

Gegner wenden ein, dass die PISA-Ergebnisse keineswegs eindeutig sind:

- Auch „Testverlierer“ haben Gesamtschulsysteme.

- Im innerdeutschen Vergleich schneiden Länder, die wie Bayern konsequent an einem gegliederten Schulsystem mit harten Aufnahmebedingungen für höhere Schulen festhalten, am besten ab.

- Die Verhältnisse in Deutschland und Finnland sind aus einer ganzen Reihe von Gründen nicht vergleichbar; es ist völlig spekulativ, den finnischen Erfolg primär der Schulstruktur zuzuschreiben.

- Die Lehrer in Finnland sind anders ausgewählt und besser ausgebildet als in Deutschland, so dass nicht die Schulform oder -struktur, sondern die Qualität der Lehrer über den Bildungsstandard mitentscheiden kann.

Politische Reaktionen

Als unmittelbare Reaktion auf den PISA-Schock beschlossen die deutschen Kultusminister die Entwicklung bundesweiter „Bildungsstandards“ und die Gründung des Instituts zur Qualitätsentwicklung im Bildungswesen, das diese Standards in Form von Testaufgaben operationalisiert.

Rückwirkung auf die Schulen

Es war politisch von Anfang an beabsichtigt, dass PISA auf die Schulwirklichkeit zurückwirken solle. Beteiligte Mathematikdidaktiker hofften beispielsweise, ihre Vorstellung von sinnvollem Unterricht durchzusetzen (Meyerhöfer in Jahnke/Meyerhöfer 2007). Konkret spürbar ist der Einfluss der PISA-Beispielaufgaben zum Beispiel, wenn in neuen Mathematiklehrplänen verstärktes Gewicht auf das Arbeiten mit Graphiken und Tabellen gelegt wird.

Kritik

Die PISA-Studien haben nicht nur ein außergewöhnliches Medienecho, sondern auch heftige wissenschaftliche Debatten ausgelöst. Aufgrund der Komplexität des Gegenstands ist die Kritik ein interdisziplinäres Unterfangen, an dem sich sowohl Pädagogen als auch Psychologen und andere Wissenschaftler mit statistischer Fachkunde (Mathematiker, Physiker, Ökonomen) beteiligen. Je nach Herkunft haben sie ihre Anmerkungen an weit gestreuten, zum Teil entlegenen Stellen veröffentlicht. Erst mit einiger Verzögerung erschienen erste Sammelbände, die die zuvor verstreute Kritik bündelten (Jahnke/Meyerhöfer 2006, erweitert 2007; Hopmann/Brinek/Retzl 2007).

Im Mai 2014 veröffentlichten der Pädagogikprofessor Heinz-Dieter Meyer (State University of New York) und die Schulleiterin Katie Zahedi einen offenen Brief,[23] der auf negative Folgen von PISA hinwies und die Forderung erhob, den dreijährigen Testzyklus zugunsten einer Denkpause zu unterbrechen; diesem Aufruf schlossen sich Hunderte Pädagogikprofessoren, Vertreter von Lehrerverbänden und prominente Intellektuelle (u. a. Noam Chomsky, Konrad Liessmann) an.

Zielsetzung von PISA

Das utilitaristische Bildungsziel von PISA wird insbesondere von frankophonen Autoren kritisiert: Es bewirke zunächst einmal eine Verzerrung der Testergebnisse zugunsten angelsächsischer Staaten und sodann einen Druck, Lehrpläne so anzupassen, dass unmittelbar alltagsrelevante Fertigkeiten ein größeres Gewicht bekämen. Das bedrohe zum Beispiel die Spezifität des französischen Mathematikunterrichts, der großen Wert auf strenge Beweise legt. In diesem Zusammenhang wird auf die ökonomische Zielsetzung der OECD und auf die Intransparenz und mangelnde demokratische Legitimität der Entscheidungsprozesse bei PISA hingewiesen. Ein ähnlicher Einwand lautet, dass PISA mit seinen Schwerpunkten Mathematik, Muttersprache und Naturwissenschaften die Marginalisierung gesellschaftswissenschaftlicher und musischer Fächer forciere.

Der Mathematikdidaktiker Thomas Jahnke kritisiert den Grundgedanken, Bildung „standardisieren“ zu wollen (vgl. Bildungsstandards), und deutet PISA auch als Markterschließung der Testindustrie.[24] Der Philosoph Konrad Paul Liessmann kritisiert PISA als ökonomischen Versuch, die (humanistische) Bildung im Grunde abschaffen zu wollen und durch simples Wissen (im Gegensatz zu Bildung) zu ersetzen. Er beklagt die Transformation der Bildungseinrichtung Schule in eine Berufsschule für Kinder und damit das Ende des bewussten und geistigen Menschen und seine Reduktion auf einen Arbeitnehmer und Konsumenten.[25]

Zentral an der PISA-Studie beteiligte Wissenschaftler, wie der Bildungsforscher Eckhard Klieme, bestätigen in diesem Zusammenhang durchaus, dass die Studie auch ein Instrument der Bildungspolitik sei und die OECD eine Agenda mit PISA verfolge. Sie halten dem aber entgegen, dass sie als verantwortliche Wissenschaftler eigene Beiträge in die öffentliche Debatte einbringen, um PISA nicht instrumentalisieren zu lassen, und alle Ergebnisse offen vorlägen. Denn letztlich seien die Studien dennoch ein „Instrument der Aufklärung, das uns viel über die Probleme unseres Bildungssystems verrät und zu mehr Ehrlichkeit und Transparenz beiträgt“.[26]

Methodik: Validität der Instrumente

Im Anschluss an die Testungen 2000 und 2003 wurde jeweils nur ein kleiner Teil der eingesetzten Aufgaben (der „Instrumente“ in der Sprache der Psychologie) veröffentlicht. Eine Vielzahl von Autoren hat diese Aufgabenbeispiele kritisiert, besonders gründlich der Mathematikdidaktiker Meyerhöfer. In einer didaktischen Analyse mit Methoden der objektiven Hermeneutik zeigt er, dass PISA dem Anspruch, eine spezielle „Mathematische Literalität“ zu testen, nicht gerecht wird.

Das seit den allerersten vergleichenden Schulstudien ungelöste Übersetzungsproblem bewirkt auf verschiedenen Wegen eine Verzerrung der internationalen Vergleiche:

- Herkunft der Aufgaben (überwiegend aus dem angelsächsischen Bereich und den Niederlanden)

- unterschiedliche Lesbarkeit verschiedener Sprachen

- Texte werden beim Übersetzen tendenziell länger; Aufgabentexte sind im Deutschen um ca. 16 % länger als im Englischen (Puchhammer in Hopmann/Brinek/Retzl 2007).

- Wenn Übersetzer die Aufgabe verstehen, neigen sie dazu, Hilfen zu geben (Freudenthal 1975).

- Wenn Übersetzer nicht alle Fußangeln erkennen, kann die Aufgabe wiederum erheblich schwerer geraten.

- In einzelnen Aufgaben sind manifeste Übersetzungsfehler unterlaufen.[27][28]

Ein weiteres Problem ist die unterschiedliche Vertrautheit mit dem Aufgabenformat. Meyerhöfer spricht hier von „Testfähigkeit“; in den USA wird schon lange über die Bedeutung von „testwiseness“ diskutiert. Wuttke (2007) hat entdeckt, dass bis zu 10 Prozent der deutschsprachigen Schüler das Multiple-Choice-Format nicht verstehen und mehr als eine Antwortalternative ankreuzen.

Zusätzlich ist zu berücksichtigen, dass dieselben Aufgaben in verschiedenen Sprach- und Kulturkontexten nicht als gleichwertig bezüglich ihrer Schwierigkeit betrachtet werden können. Damit ist ein Unterschied der Ergebnisse zu erwarten, der nicht in der Leistungsfähigkeit der Probanden, sondern im Bereich der sprachlichen Übersetzbarkeit und Interpretierbarkeit der Aufgabenstellung liegt.[29]

Methodik: Validität der Statistik

Bei der Auswertung von PISA und ähnlichen Studien stellt sich das Grundproblem, dass Leistungsunterschiede innerhalb eines jeden Staats wesentlich größer sind als typische Unterschiede zwischen Staaten. Es ist deshalb eine Messgenauigkeit im unteren Prozentbereich erforderlich, um statistisch signifikante Aussagen über solche Unterschiede treffen zu können. In PISA wird das formal durch die Verwendung sehr großer Stichproben (etwa 5000 Schüler/Staat) erreicht. Die offiziellen Standardfehler berücksichtigen jedoch nicht mögliche systematische Verzerrungen (Wuttke 2007). Solche Verzerrungen werden unter anderem bewirkt durch:

- Unzuverlässige Ausgangsdaten (es gibt keine Urlisten mit allen Fünfzehnjährigen; die Stichprobenziehung ist extrem kompliziert und nicht überprüfbar).

- Leistungsabhängige Teilnahmeneigung (2007 wurde bekannt, dass die Teilnahmeneigung in manchen Staaten so gering ist, dass Schüler mit bis zu 50 Dollar oder einem freien Tag für die Teilnahme belohnt wurden).

- uneinheitlicher Ausschluss von lernbehinderten Schülern (Hörmann in Hopmann/Brinek/Retzl 2007)

- Einige Staaten, darunter Finnland, haben Legastheniker vom Test ausgeschlossen (OECD: Technische Berichte).

Interpretation der Ergebnisse

Aus systemtheoretischer Sicht wird kritisiert, dass die Systemgrenzen in PISA nicht sachgerecht seien (verglichen werden Staaten, auch wenn diese kein einheitliches Bildungssystem haben); dass die Gleichsetzung von Schülerleistung mit Schulsystemleistung nicht gerechtfertigt ist (weil es außer dem Schulsystem eine ganze Reihe anderer Eingangsgrößen gibt); dass ein Systemvergleich nur Denkanstöße, aber keine politischen Handlungsempfehlungen liefern kann (Bank 2008). Konkret kann man zum Beispiel die Vorbildfunktion des finnischen Schulsystems in Zweifel ziehen, wenn man die Eingangsgröße „Migrantenanteil“ herausrechnet und nicht mit einem fiktiven gesamtdeutschen Schulsystem, sondern konkret mit dem sächsischen oder bayerischen vergleicht (Bender 2006). Wenn man die PISA-Erfolge in Relation zu den Bildungsausgaben setzt, erscheint das finnische System sogar als vergleichsweise ineffizient (Bank 2008).

Das von PISA postulierte Bildungsziel „literacy“ führt zu einer Verwischung der Grenze zwischen den einzelnen Testgebieten. Die Ergebnisse sind hochkorreliert. Deshalb argumentiert Heiner Rindermann (2006), dass man PISA in guter Näherung als einen Intelligenztest deuten kann.

Weitere Analysen

Das kriminologische Forschungsinstitut Niedersachsen e. V. stellte 2007 fest, dass jene Gruppen bei PISA am schlechtesten abschnitten, die sich durch den höchsten Medienkonsum auszeichnen.[30]

Datennutzung

Die Daten der Studie können zudem auf verschiedenen Wegen weiterverwendet werden, um auch über den ursprünglich geplanten Rahmen hinaus für Forschung und öffentliche Information von Nutzen zu sein.

- Die OECD bietet auf ihrer Website einen Data-Explorer an, mit dem verschiedene grundlegende Auswertungen auch ohne ein eigenes Statistikprogramm angefordert werden können.

- Ebenfalls auf der OECD-Seite stehen die internationalen Originaldaten aller Erhebungszeitpunkte öffentlich zum Download zur Verfügung.

- Forschende können außerdem auf Antrag am Forschungsdatenzentrum am Institut zur Qualitätsentwicklung im Bildungswesen für Re- und Sekundäranalysen Zugriff auf die deutschen Originaldaten aller Erhebungen erhalten.

Siehe auch

- Fremdsprachenlehr- und -lernforschung

- Kulturvergleichende Sozialforschung

- CIVIC Education Study zur Politischen Bildung 14- bis 19-Jähriger (1999–2000)

- DESI-Studie

- Liste der Länder nach Bildungsausgaben

Literatur

PISA-Studien, International

- OECD (1999): Measuring Student Knowledge and Skills. A New Framework for Assessment. Paris: OECD, ISBN 92-64-17053-7 Download Englische Version (PDF; 717 kB) Download Französische Version (PDF; 794 kB) Download Spanische Version (PDF; 4 MB)

- OECD: Lernen für das Leben. Erste Ergebnisse der internationalen Schulleistungsstudie PISA 2000. Paris: OECD, 2001, ISBN 92-64-59671-2.

- OECD (2003a): The PISA 2003 Assessment Framework. Mathematics, Reading, Science and Problem Solving Knowledge and Skills. Paris: OECD, ISBN 978-92-64-10172-2 Download Englische Version (PDF; 1,7 MB) Download Französische Version (PDF; 1,9 MB) Download Spanische Version (Memento vom 1. August 2010 im Internet Archive) (PDF; 2,7 MB)

- OECD (2004a): Learning for Tomorrow's World. First Results from PISA 2003. Paris: OECD, ISBN 978-92-64-00724-6.

- OECD (2004b): Problem Solving for Tomorrow's World. First Measures of Cross-Curricular Competencies from PISA 2003. Paris: OECD, ISBN 978-92-64-00642-3.

- OECD: PISA 2003 Technical Report. Paris: OECD, 2005, ISBN 92-64-01053-X.

PISA-Studien, Deutschland

- J. Baumert u. a.: PISA 2000. Basiskompetenzen von Schülerinnen und Schülern im internationalen Vergleich. Deutsches PISA-Konsortium. Leske + Budrich, Opladen 2001, ISBN 3-8100-3344-8.

- M. Prenzel u. a. (Hrsg.): PISA 2003. Ergebnisse des zweiten internationalen Vergleichs. Deutsches PISA-Konsortium. Zusammenfassung. Leibniz-Institut für die Pädagogik der Naturwissenschaften, Kiel 2004 (Kurzfassung (Memento vom 18. Juni 2006 im Internet Archive); PDF; 235 kB)

- M. Prenzel u. a. (Hrsg.): PISA 2003. Der Bildungsstand der Jugendlichen in Deutschland – Ergebnisse des zweiten internationalen Vergleichs. Waxmann, Münster 2004, ISBN 3-8309-1455-5.

- M. Prenzel u. a. (Hrsg.): PISA 2006. Die Ergebnisse der dritten internationalen Vergleichsstudie. Waxmann, Münster u. a. 2007, ISBN 978-3-8309-1900-1.

- OECD: PISA 2006 – Schulleistungen im internationalen Vergleich – Naturwissenschaftliche Kompetenzen für die Welt von morgen W. Bertelsmann Verlag, Bielefeld 2008, ISBN 978-3-7639-3582-6.

- PISA-Konsortium Deutschland (Hrsg.): PISA 2006 in Deutschland. Die Kompetenzen der Jugendlichen im dritten Ländervergleich. Waxmann, Münster u. a. 2008, ISBN 978-3-8309-2099-1.

- Andreas Frey, Päivi Taskinen, Kerstin Schütte, PISA-Konsortium Deutschland (Hrsg.): PISA 2006 Skalenhandbuch. Dokumentation der Erhebungsinstrumente. Waxmann, Münster u. a. 2009, ISBN 978-3-8309-2160-8.

- Eckhard Klieme, Cordula Artelt, Johannes Hartig, Nina Jude, Olaf Köller, Manfred Prenzel, Wolfgang Schneider, Petra Stanat (Hrsg.): PISA 2009. Bilanz nach einem Jahrzehnt. Waxmann, Münster u. a. 2010, ISBN 978-3-8309-2450-0.

Übersicht Schulleistungsstudien

- Heiner Rindermann: Was messen internationale Schulleistungsstudien? Schulleistungen, Schülerfähigkeiten, kognitive Fähigkeiten, Wissen oder allgemeine Intelligenz?. In: Psychologische Rundschau. Band 57, Göttingen 2006, S. 69–86. ISSN 0033-3042

- Detlef Rost: Interpretation und Bewertung pädagogisch-psychologischer Studien. Beltz, Weinheim 2005, ISBN 3-407-25379-6.

Zusammenfassungen, Rezensionen, Kritiken

- Dittmar Graf: Die schiefe Tour von PISA – Wieso die Vorzeigestudie nicht wissenschaftlich ist. In: Skeptiker (Zeitschrift). Nr. 3, 2017, S. 112–120.

- Hans Brügelmann: PISA & Co: Nutzen und Grenzen von Leistungsvergleichen – auf internationaler, institutioneller und individueller Ebene. Vorbereitungstext für einen Beitrag zur Enzyklopädie Erziehungswissenschaft Online. Online unter Hans Brügelmann PISA & Co: Nutzen und Grenzen von Leistungsvergleichen 1 – auf internationaler, institutioneller und individueller Ebene2 [Abruf: 30. Juni 2012]

- Johann C. Fuhrmann, Norbert Beckmann-Dierkes: „Finnlands PISA-Erfolge: Mythos und Übertragbarkeit“, KAS-Auslandsinformationen 07/2011. Berlin 2011, S. 6–22.

- Joachim Wuttke: PISA: Nachträge zu einer nicht geführten Debatte. In: Mitteilungen der Gesellschaft für Didaktik der Mathematik. Band 87, 2009, S. 22–34. (didaktik-der-mathematik.de; PDF; 843 kB)

- Armin von Bogdandy, Matthias Goldmann: The Exercise of International Public Authority through National Policy Assessment. The OECD’s PISA Policy as a Paradigm for a New International Standard Instrument. In: International Organizations Law Review. Band 5, 2008, S. 241–298. (online verfügbar als NYU Institute for International Law and Justice Working Paper (Memento vom 12. Januar 2016 im Internet Archive))

- Volker Bank: Vom Wert des Vergleichs. In: Chemnitzer Europastudien. Band 8, 2008, S. 257–274.

- Stefan Hopmann, Gertrude Brinek, Martin Retzl (Hrsg.): PISA zufolge PISA. PISA According to PISA. LIT-Verlag, Wien 2007, ISBN 978-3-8258-0946-1. (Zweisprachiger Sammelband mit Beiträgen von siebzehn Forschern)

- Joachim Wuttke: Die Insignifikanz signifikanter Unterschiede. Der Genauigkeitsanspruch von PISA ist illusorisch. In: T. Jahnke, Meyerhöfer: PISA & Co – Kritik eines Programms. 2. Auflage. Franzbecker, Hildesheim 2007. Online-Fassung (2013) im SSOAR (PDF; 1,4 MB)

- Thomas Jahnke, Wolfram Meyerhöfer (Hrsg.): PISA & Co – Kritik eines Programms. 2. Auflage. Franzbecker, Hildesheim 2007, ISBN 978-3-88120-464-4. (Sammelband mit Beiträgen von neun Forschern)

- Erich Neuwirth, Ivo Ponocny, Wilfried Grossmann (Hrsg.): PISA 2000 und PISA 2003. Vertiefende Analysen und Beiträge zur Methodik. Leykam, Graz 2006, ISBN 3-7011-7569-1 (Umfassendes Erratum zu den österreichischen Ergebnissen aus PISA 2000)

- Peter Bender: Was sagen uns PISA & Co., wenn wir uns auf sie einlassen? in: Jahnke, Meyerhöfer (2006), S. 281–337.

- Hans Brügelmann, Hans Werner Heymann: PISA – Befunde, Deutungen, Folgerungen. In: Pädagogik. Band 54, Heft 3, Berlin 2002, S. 40–43. ISSN 0233-0873

- Josef Kraus: Der PISA Schwindel. Unsere Kinder sind besser als ihr Ruf. Wie Eltern und Schule Potentiale fördern können. Signum, Wien 2005, ISBN 3-85436-376-1 (Bewusst polemische Streitschrift)

- W. Potthoff, J. Schneider, F. Schrage: Impulse für die aktive Schule. Vorschläge zur besseren Zentrierung und Profilierung des Bildungswesens nach PISA. Reformpädagogischer Verlag, Freiburg 2004, ISBN 3-925416-27-7.

- Volker Ladenthin: PISA – Recht und Grenzen einer globalen empirischen Studie. Eine bildungstheoretische Betrachtung. (PDF; 255 kB). In: Vierteljahrsschrift für wissenschaftliche Pädagogik. Band 79, Nr. 3, Paderborn 2003, S. 354–375.

- Hans Freudenthal: Pupils achievements internationally compared --- the IEA. In: Educational studies in mathematics. Band 6, Dordrecht 1975, S. 127–186. ISSN 0013-1954 (Kritik am grundsätzlichen Ansatz internationaler Vergleichsstudien)

Weblinks

- International

- Deutschsprachige PISA-Webseite der OECD (Ergebnisse von PISA 2000, 2003, 2006 und 2009, alle Zusatzstudien, alle technischen Berichte sowie alle freigegebenen Aufgaben)

- Deutschland

- Deutschland 2000 (Max-Planck-Institut für Bildungsforschung, Berlin)

- Deutschland 2003, 2006 (Archivseiten des IPN in Kiel zu PISA; dort finden sich insbesondere ein Kurzbericht und viele freigegebene Aufgabenbeispiele)

- PISA 2009 (DIPF, Frankfurt; Informationen über die wechselnden Aufgaben des Instituts bei der Konzeption und Auswertung der PISA-Studien 2009)

- an PISA anknüpfenden Forschungsprojekte (Zentrum für internationale Bildungsvergleichsstudien, München; Informationen zu den PISA-Studien in Deutschland)

- PISA seit 2012 (Nationale Projektkoordination, Technische Universität München; Informationen zu den aktuellen PISA-Studien seit 2012; mit Links zu den veröffentlichten nationalen Berichten als PDF)

- http://bildung-wissen.eu/fachbeitraege/kompetenzorientierung-als-indiz-padagogischer-orientierungslosigkeit.html

- Österreich

- Schweiz

- Südtirol

- andere Teilnehmerstaaten

- Kritik

Einzelnachweise

- Organisation für wirtschaftliche Zusammenarbeit und Entwicklung

- Deutsche Projektleitung 2012, 2015 und 2018 Deutsche Projektleitung 2009 am Deutschen Institut für Internationale Pädagogische Forschung Deutsche Projektleitung 2003 und 2006 – IPN an der Uni Kiel

- Internationale Grundkonzeption laut deutscher Projektleitung 2000

- OECD-Veröffentlichung mit Aufgabenbeispielen (PDF; 418 kB). Es ist nicht ganz klar, ob die Lizenzbedingungen der OECD ein Einbinden in die WP gestatten würden.

- Für Details siehe Methodik der PISA-Studien.

- Quellen: OECD-Berichte „First Results“ 2001, 2004 (für PISA 2000 bzw. 2003); für die Ergebnisse von PISA 2006: „PISA 2006. Science Competencies for Tomorrow's World.“; für die Ergebnisse von PISA 2009: „Eckhard Klieme, Cordula Artelt, Johannes Hartig, u. a. (2010): PISA 2009 – Bilanz nach einem Jahrzehnt. Waxmann Verlag“. Abkürzungen: „k. T.“ = keine Teilnahme; „disq.“ = disqualifiziert wegen zu geringer Teilnahmequote. Dies sind die ursprünglich veröffentlichten Daten; die 2006 für die österreichischen Ergebnisse aus 2000 veröffentlichte Korrektur ist nicht berücksichtigt. Die Zahl hinter dem „±“-Zeichen ist der offizielle Standardfehler, der die stochastische Unsicherheit der Stichprobenziehung sowie der Item-Response-Modellierung angibt; in den Originalberichten ist auch die erste Nachkommastelle angegeben.

- Ramm et al. 2004: Ramm u. a.: Soziokulturelle Herkunft: Migration. In: PISA 2003: Der Bildungsstand der Jugendlichen in Deutschland – Ergebnisse des zweiten internationalen Vergleichs. Waxmann, Münster, ISBN 3-8309-1455-5, S. 269/270.

- PISA-Konsortium Deutschland: PISA 2003: Ergebnisse des zweiten internationalen Vergleichs – Zusammenfassung. (Memento vom 17. Mai 2012 im Internet Archive) (PDF; 263 kB) S. 20–21.

- E. Klieme u. a.: PISA 2009 Bilanz nach einem Jahrzehnt – Zusammenfassung. (Memento vom 20. September 2011 im Internet Archive) (PDF; 1,5 MB) S. 16.

- OECD: Geschlechtsbezogene Vorurteile beeinflussen die Bildungsergebnisse von Jungen und Mädchen. Abgerufen am 22. Dezember 2010.

- OECD Programme for the International Student Assessment. (Memento vom 27. Februar 2015 im Internet Archive) Abgerufen am 11. September 2012 (englisch, offizielle PISA-Daten, bzgl. der Liste siehe "Executive Summary").

- Comparing Countries’ and Economies’ performance.

- PISA-Studie - Organisation for Economic Co-operation and Development. Abgerufen am 13. April 2018 (englisch).

- Klieme u. a.: PISA 2009: Bilanz nach einem Jahrzehnt. Waxmann, Münster 2010..

- PISA 2006: Naturwissenschaftliche Kompetenzen für die Welt von Morgen. OECD Briefing Note für Deutschland

- Zusammenfassung der deutschen Ergebnisse durch das Kieler (Memento vom 24. März 2012 im Internet Archive) (PDF; 391 kB) IPN

- E. Neuwirth, I. Ponocny, W. Grossmann (Hrsg.): PISA 2000 und PISA 2003: Vertiefende Analysen und Beiträge zur Methodik. Leykam, Graz 2006.

- Vgl. den diesbezüglichen Artikel in der Online-Fassung der liberalen österreichischen Tageszeitung Der Standard: Stichprobenfehler verursachte «Pisa-Absturz». Abgerufen am 19. April 2011.

- Siehe S. 135 des PISA-Berichtes PISA 2009 RESULTS: LEARNING TRENDS. Change in Student Performance since 2000. Vol. V. Abgerufen am 18. April 2011.

- PISA 2012 Ergebnisse: Was Schülerinnen und Schüler wissen und können. Band 1, 2014, ISBN 978-3-7639-5321-9, S. 400, 323, 417.

- Und dann sind wieder die Lehrer schuld. In: Tiroler Tageszeitung. Nr. 128, 10. Mai 2009, S. 2.

- McKinsey-Studie zu PISA September 2007 (englisch) (Memento vom 10. August 2011 im Internet Archive)

- oecdpisaletter.org

- T. Jahnke: Die PISA-Unternehmer. In: Forschung & Lehre. Band 15, 2008, S. 26–27.

- K. P. Liessmann: Theorie der Unbildung. Die Irrtümer der Wissensgesellschaft. Paul Zsolnay, Wien 2006.

- Eckhard Klieme, DIPF, Warum wir PISA brauchen. (= Leibniz-Journal. 1/2015). leibniz-gemeinschaft.de

- „Dachboden“ statt „Boden des Dachgeschosses“ für „attic floor“, „Hemisphäre“ statt „Erdhälfte“ für „hemisphere“, „Forschung“ für „scientific experiments“ – vgl. Wuttke (2007)

- Joachim Wuttke: Pisa – ein teurer Zufallsgenerator. In: Berliner Zeitung. 8. Dezember 2007, abgerufen am 18. Juni 2015.

- More or Less. BBC Radio 4, 22. April 2011, abgerufen am 14. Juni 2013.

- Christian Pfeiffer u. a.: Die PISA-Verlierer – Opfer des Medienkonsums. (PDF; 150 kB). KFN Hannover. (kfn.de (Memento vom 25. Februar 2016 im Internet Archive))