Eigenwertproblem

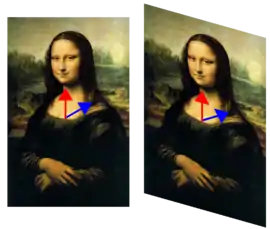

Ein Eigenvektor einer Abbildung ist in der linearen Algebra ein vom Nullvektor verschiedener Vektor, dessen Richtung durch die Abbildung nicht verändert wird. Ein Eigenvektor wird also nur skaliert und man bezeichnet den Skalierungsfaktor als Eigenwert der Abbildung.

Eigenwerte charakterisieren wesentliche Eigenschaften linearer Abbildungen, etwa ob ein entsprechendes lineares Gleichungssystem eindeutig lösbar ist oder nicht. In vielen Anwendungen beschreiben Eigenwerte auch physikalische Eigenschaften eines mathematischen Modells. Die Verwendung des Präfixes „Eigen-“ für charakteristische Größen in diesem Sinne lässt sich auf eine Veröffentlichung von David Hilbert aus dem Jahre 1904 zurückführen[1] und wird als Germanismus auch in einigen weiteren Sprachen, darunter dem Englischen, verwendet.

Die im Folgenden beschriebene mathematische Problemstellung heißt spezielles Eigenwertproblem und bezieht sich nur auf lineare Abbildungen eines endlichdimensionalen Vektorraums in sich (Endomorphismen), wie sie durch quadratische Matrizen dargestellt werden.

Hierbei stellt sich die Frage, unter welchen Bedingungen eine Matrix ähnlich zu einer Diagonalmatrix ist.[2]

Definition

Ist ein Vektorraum über einem Körper (in Anwendungen meist der Körper der reellen Zahlen oder der Körper der komplexen Zahlen) und eine lineare Abbildung von in sich selbst (Endomorphismus), so bezeichnet man als Eigenvektor einen Vektor , der durch auf ein Vielfaches von sich selbst mit abgebildet wird:

Den Faktor nennt man dann den zugehörigen Eigenwert.

Anders formuliert: Hat für ein die Gleichung

eine Lösung (der Nullvektor ist natürlich immer eine Lösung), so heißt Eigenwert von Jede Lösung heißt Eigenvektor von zum Eigenwert

Hat der Vektorraum eine endliche Dimension so kann jeder Endomorphismus durch eine quadratische -Matrix beschrieben werden. Die obige Gleichung lässt sich dann als Matrizengleichung

schreiben, wobei hier einen Spaltenvektor bezeichnet. Man nennt in diesem Fall eine Lösung Eigenvektor und Eigenwert der Matrix

Diese Gleichung kann man auch in der Form

schreiben, wobei die Einheitsmatrix bezeichnet, und äquivalent zu

oder

umformen.

Berechnung der Eigenwerte

Bei kleinen Matrizen können die Eigenwerte symbolisch (exakt) berechnet werden. Bei großen Matrizen ist dies oft nicht möglich, sodass hier Verfahren der numerischen Mathematik zum Einsatz kommen.

Symbolische Berechnung

Die Gleichung

definiert die Eigenwerte und stellt ein homogenes lineares Gleichungssystem dar.

Da vorausgesetzt wird, ist dieses genau dann lösbar, wenn

gilt. Diese Determinante heißt „charakteristisches Polynom“. Es handelt sich um ein normiertes Polynom -ten Grades in Seine Nullstellen, also die Lösungen der Gleichung

über , sind die Eigenwerte. Da ein Polynom vom Grad höchstens Nullstellen hat, gibt es auch höchstens Eigenwerte. Zerfällt das Polynom vollständig in Linearfaktoren, so gibt es genau Nullstellen, wobei mehrfache Nullstellen mit ihrer Vielfachheit gezählt werden. Ist der Grad eine ungerade Zahl und gilt , dann ist mindestens einer der Eigenwerte reell.

Eigenraum zum Eigenwert

Ist ein Eigenwert der linearen Abbildung , dann nennt man die Menge aller Eigenvektoren zu diesem Eigenwert vereinigt mit dem Nullvektor den Eigenraum zum Eigenwert . Der Eigenraum ist durch

definiert. Falls die Dimension des Eigenraums größer als 1 ist, wenn es also mehr als einen linear unabhängigen Eigenvektor zum Eigenwert gibt, so nennt man den zum Eigenraum zugehörigen Eigenwert entartet.[3] Die Dimension des Eigenraums wird als geometrische Vielfachheit von bezeichnet.

Eine Verallgemeinerung des Eigenraums ist der Hauptraum.

Spektrum und Vielfachheiten

Für den Rest dieses Abschnittes sei Dann besitzt jede genau Eigenwerte, wenn man diese mit ihren Vielfachheiten zählt. Mehrfaches Vorkommen eines bestimmten Eigenwertes fasst man zusammen und erhält so nach Umbenennung die Aufzählung der verschiedenen Eigenwerte mit ihren Vielfachheiten Dabei ist und

Die eben dargestellte Vielfachheit eines Eigenwertes als Nullstelle des charakteristischen Polynoms bezeichnet man als algebraische Vielfachheit. Eigenwerte der algebraischen Vielfachheit werden als einfacher Eigenwert bezeichnet.

Die Menge der Eigenwerte wird Spektrum genannt und geschrieben, sodass also

gilt. Als Spektralradius bezeichnet man den größten Betrag aller Eigenwerte.

Gilt für einen Eigenwert, dass seine algebraische Vielfachheit gleich seiner geometrischen Vielfachheit ist, so spricht man von einem halbeinfachen Eigenwert (aus dem englischen ‚semisimple‘). Dies entspricht genau der Diagonalisierbarkeit der Blockmatrix zum gegebenen Eigenwert.

Kennt man die Eigenwerte sowie ihre algebraischen und geometrischen Vielfachheiten (siehe unten), kann man die Jordansche Normalform der Matrix erstellen.

Beispiel

Es sei die quadratische Matrix

gegeben. Subtraktion der mit multiplizierten Einheitsmatrix von ergibt:

Ausrechnen der Determinante dieser Matrix (mit Hilfe der Regel von Sarrus) liefert:

Die Eigenwerte sind die Nullstellen dieses Polynoms, man erhält:

Der Eigenwert 2 hat algebraische Vielfachheit 2, weil er doppelte Nullstelle des charakteristischen Polynoms ist.

Numerische Berechnung

Während die exakte Berechnung der Nullstellen des charakteristischen Polynoms schon für dreireihige Matrizen nicht so einfach ist, wird sie für große Matrizen meist unmöglich, sodass man sich dann auf das Bestimmen von Näherungswerten beschränkt. Hierzu werden Verfahren bevorzugt, die sich durch numerische Stabilität und geringen Rechenaufwand auszeichnen. Dazu gehören Methoden für dichtbesetzte kleine bis mittlere Matrizen, wie

- der QR-Algorithmus,

- der QZ-Algorithmus,

- der QS-Algorithmus und

- die Deflation

sowie spezielle Methoden für symmetrische Matrizen als auch Methoden für dünnbesetzte große Matrizen wie

- die Potenzmethode,

- die inverse Iteration,

- das Lanczos-Verfahren,

- die Unterraumiteration,

- das Arnoldi-Verfahren,

- das Jacobi-Verfahren und

- das Jacobi-Davidson-Verfahren.

Des Weiteren gibt es noch Methoden zur Abschätzung, z. B. mithilfe

- der Matrixnorm und

- der Gerschgorin-Kreise,

die immer eine grobe Abschätzung (unter gewissen Bedingungen sogar genaue Bestimmung) zulassen.

- Die Folded Spectrum Method liefert mit jedem Durchlauf einen Eigenvektor, der jedoch auch aus der Mitte des Spektrums stammen kann.

Berechnung der Eigenvektoren

Algorithmus

Für einen Eigenwert lassen sich die Eigenvektoren aus der Gleichung

bestimmen. Die Eigenvektoren spannen den Eigenraum auf, dessen Dimension als geometrische Vielfachheit des Eigenwertes bezeichnet wird. Für einen Eigenwert der geometrischen Vielfachheit lassen sich also linear unabhängige Eigenvektoren finden, sodass die Menge aller Eigenvektoren zu gleich der Menge der Linearkombinationen von ist. Die Menge heißt dann eine Basis aus Eigenvektoren des zum Eigenwert gehörenden Eigenraumes.

Die geometrische Vielfachheit eines Eigenwertes kann man also auch als die maximale Anzahl linear unabhängiger Eigenvektoren zu diesem Eigenwert definieren.

Die geometrische Vielfachheit ist höchstens gleich der algebraischen Vielfachheit.

Beispiel

Gegeben ist wie in obigem Beispiel die quadratische Matrix

Die Eigenwerte wurden oben schon berechnet. Zunächst werden hier die Eigenvektoren (und der durch die Eigenvektoren aufgespannte Eigenraum) zum Eigenwert berechnet:

Man muss also das folgende lineare Gleichungssystem lösen:

Bringt man die Matrix auf obere Dreiecksform, so erhält man:

Die gesuchten Eigenvektoren sind alle Vielfachen des Vektors (jedoch nicht das Nullfache des Vektors, da der Nullvektor niemals ein Eigenvektor ist).

Obwohl der Eigenwert eine algebraische Vielfachheit von 2 hat, existiert nur ein linear unabhängiger Eigenvektor (der Eigenraum zu dem Eigenwert ist eindimensional); also hat dieser Eigenwert eine geometrische Vielfachheit von 1. Das hat eine wichtige Konsequenz: Die Matrix ist nicht diagonalisierbar. Man kann nun versuchen, die Matrix stattdessen in die Jordansche Normalform überzuführen. Dazu muss ein weiterer Eigenvektor zu diesem Eigenwert „erzwungen“ werden. Solche Eigenvektoren nennt man generalisierte Eigenvektoren oder Hauptvektoren.

Für den Eigenwert geht man genauso vor:

Wieder bringt man die Matrix auf Dreiecksform:

Hier ist die Lösung der Vektor wieder mit allen seinen vom Nullvektor verschiedenen Vielfachen.

Eigenschaften

- Die Eigenvektoren sind nur bis auf einen Faktor bestimmt. Wenn ein Eigenvektor ist, dann ist auch mit beliebigem Eigenvektor.

- Ist ein Eigenwert der invertierbaren Matrix zum Eigenvektor so ist Eigenwert der inversen Matrix von zum Eigenvektor

- Sind die Eigenwerte der Matrix so gilt

- wobei bei mehrfachen Eigenwerten die Vielfachheit zu beachten ist. Hier bezeichnet die Spur der Matrix .

- Das Spektrum einer Matrix ist gleich dem Spektrum der transponierten Matrix, also:

- Analog gilt

- Jede quadratische Matrix über dem Körper der komplexen Zahlen ist ähnlich zu einer oberen Dreiecksmatrix Die Eigenwerte von sind genau die Diagonaleinträge der Matrix

- Eigenvektoren zum Eigenwert sind Fixpunkte in der Abbildungsgeometrie. Nach dem Satz vom Fußball gibt es beispielsweise zwei Punkte auf einem Fußball, die sich vor dem Anstoß zur ersten und zur zweiten Halbzeit am jeweils gleichen Punkt des Raumes befinden.

Speziell für reelle symmetrische oder komplexe hermitesche Matrizen gilt:

- Alle Eigenwerte sind stets reell. Im Rahmen der Hauptachsentransformation werden die Eigenwerte auch Hauptwerte genannt.[4] Ist die Matrix zudem positiv definit, so sind auch ihre Eigenwerte echt positiv.

- Es lässt sich immer eine Orthonormalbasis aus Eigenvektoren angeben.[5] Dies ist eine direkte Folgerung aus dem Spektralsatz. Insbesondere sind Eigenvektoren zu verschiedenen Eigenwerten zueinander orthogonal.

- Die aus den Vorzeichen der Eigenwerte ermittelte Signatur der Matrix bleibt nach dem Trägheitssatz von Sylvester unter Kongruenztransformationen erhalten.

- Über den Rayleigh-Quotient lässt sich zu jedem Eigenvektor der zugehörige Eigenwert ermitteln. Mit dem Satz von Courant-Fischer lässt sich jeder Eigenwert als minimaler beziehungsweise maximaler Rayleigh-Quotient darstellen.

- Für das Betragsquadrat der Komponenten der auf Betrag 1 normierten Eigenvektoren der Matrix gilt mit deren Eigenwerten und den Eigenwerten der Hauptuntermatrizen von :[6]

Eigenvektoren kommutierender Matrizen

Für kommutierende diagonalisierbare (insbesondere symmetrische) Matrizen ist es möglich, ein System gemeinsamer Eigenvektoren zu finden:

Kommutieren zwei Matrizen und (gilt also ) und ist ein nichtentarteter Eigenwert (d. h., der zugehörige Eigenraum ist eindimensional) von mit Eigenvektor so gilt

Auch ist also ein Eigenvektor von zum Eigenwert Da dieser Eigenwert nicht entartet ist, muss ein Vielfaches von sein. Das bedeutet, dass auch ein Eigenvektor der Matrix ist.

Aus diesem einfachen Beweis geht hervor, dass die Eigenvektoren zu nichtentarteten Eigenwerten mehrerer paarweise kommutierender Matrizen Eigenvektoren aller dieser Matrizen sind.

Allgemein können auch für kommutierende diagonalisierbare Matrizen mit entarteten Eigenwerten gemeinsame Eigenvektoren gefunden werden.[7] Aus diesem Grund können mehrere paarweise kommutierende diagonalisierbare Matrizen auch simultan (d. h. mit einer Basistransformation für alle Matrizen) diagonalisiert werden.

Linkseigenvektoren und verallgemeinertes Eigenwertproblem

Manchmal bezeichnet man einen so definierten Eigenvektor auch als Rechtseigenvektor und definiert dann entsprechend den Begriff des Linkseigenvektors durch die Gleichung

Linkseigenvektoren finden sich z. B. in der Stochastik bei der Berechnung von stationären Verteilungen von Markow-Ketten mittels einer Übergangsmatrix.

Wegen sind die Linkseigenvektoren von gerade die Rechtseigenvektoren der transponierten Matrix Bei normalen Matrizen fallen Links- und Rechtseigenvektoren zusammen.

Allgemeiner kann man auch quadratische Matrizen und und die Gleichung

untersuchen. Dieses verallgemeinerte Eigenwertproblem wird hier jedoch nicht weiter betrachtet.

Spektraltheorie in der Funktionalanalysis

Eigenwerte und Eigenfunktionen

In der Funktionalanalysis betrachtet man lineare Abbildungen zwischen linearen Funktionenräumen (also lineare Abbildungen zwischen unendlichdimensionalen Vektorräumen). Meistens spricht man von linearen Operatoren anstatt von linearen Abbildungen. Sei ein Vektorraum über einem Körper mit und ein linearer Operator. In der Funktionalanalysis ordnet man ein Spektrum zu. Dieses besteht aus allen für die der Operator nicht invertierbar ist. Dieses Spektrum muss jedoch nicht – wie bei Abbildungen zwischen endlichdimensionalen Vektorräumen – diskret sein. Denn im Gegensatz zu den linearen Abbildungen zwischen endlichdimensionalen Vektorräumen, die nur verschiedene Eigenwerte haben, haben lineare Operatoren im Allgemeinen unendlich viele Elemente im Spektrum. Daher ist es zum Beispiel möglich, dass das Spektrum von linearen Operatoren Häufungspunkte besitzt. Um die Untersuchung des Operators und des Spektrums zu vereinfachen, unterteilt man das Spektrum in unterschiedliche Teilspektren. Elemente, die die Gleichung für ein lösen, nennt man wie in der linearen Algebra Eigenwerte. Die Gesamtheit der Eigenwerte nennt man das Punktspektrum von Wie in der linearen Algebra wird jedem Eigenwert ein Raum von Eigenvektoren zugeordnet. Da die Eigenvektoren meist als Funktionen aufgefasst werden, spricht man auch von Eigenfunktionen.

Beispiel

Sei offen. Dann besitzt der Ableitungsoperator ein nichtleeres Punktspektrum. Betrachtet man nämlich für alle die Gleichung

und wählt dann sieht man, dass die Gleichung für alle erfüllt ist. Also ist jedes ein Eigenwert mit zugehöriger Eigenfunktion

Praktische Beispiele

Durch Lösung eines Eigenwertproblems berechnet man

- Eigenfrequenzen, Eigenformen und gegebenenfalls auch die Dämpfungscharakteristik eines schwingungsfähigen Systems,

- die Knicklast eines Knickstabs (siehe Balkentheorie),

- das Beulversagen (eine Art des Materialversagens durch unzureichende Steifigkeit) eines leeren Rohres unter Außendruck,

- die Hauptkomponenten einer Punktmenge (z. B. zur Kompression von Bildern oder zur Bestimmung von Faktoren in der Psychologie: Hauptkomponentenanalyse),

- die Hauptspannungen in der Festigkeitslehre (Umrechnung der Spannungen in ein Koordinatensystem, in dem es keine Schubspannungen gibt),

- die Hauptstreckungen in der Festigkeitslehre als Eigenwerte der Deformationstensoren,

- die Hauptträgheitsachsen eines asymmetrischen Querschnitts (um einen Balken – Träger oder Ähnliches – in diesen beiden Richtungen unabhängig voneinander zu berechnen),

- vielfältige andere technische Problemstellungen, die mit der jeweils spezifisch definierten Stabilität eines Systems zu tun haben,

- den PageRank einer Homepage als Eigenvektor der Google-Matrix, dort gewertet als ein Maß für die relative Wichtigkeit einer Homepage im Internet,

- die Grenzverteilungen von Markow-Ketten mit diskretem Zustandsraum und diskreten Zeitschritten, die durch eine stochastische Matrix beschrieben werden (die Linkseigenvektoren zum Eigenwert 1 sind die stationären Verteilungen, die Rechtseigenvektoren zum Eigenwert 1 sind die Absorptionswahrscheinlichkeiten),

- die Drehachse und damit die Fixpunkte, von denen der Satz vom Fußball spricht.

Eigenwerte spielen in der Quantenmechanik eine besondere Rolle. Physikalische Größen wie z. B. der Drehimpuls werden hier durch Operatoren repräsentiert. Messbar sind nur die Eigenwerte der Operatoren. Hat z. B. der Hamiltonoperator, der die Energie eines quantenmechanischen Systems repräsentiert, ein diskretes Spektrum, so kann die Energie nur diskrete Werte annehmen, was z. B. für die Energieniveaus in einem Atom typisch ist. So stellen bei den Lösungen der bekannten Schrödingergleichung (im Jahr 1926 durch den Physiker Erwin Schrödinger aufgestellt) die Eigenwerte die erlaubten Energiewerte der Elektronen und die Eigenfunktionen die zugehörigen Wellenfunktionen der Elektronen dar.

Auch die Unmöglichkeit der gleichzeitigen präzisen Messung gewisser Größen (z. B. von Ort und Impuls), wie von der Heisenbergschen Unschärferelation ausgedrückt, ist letztlich darauf zurückzuführen, dass für die jeweiligen Operatoren kein gemeinsames System von Eigenvektoren existiert.

Literatur

- Gerd Fischer: Lineare Algebra. Vieweg-Verlag, ISBN 3-528-03217-0.

- Hans-Joachim Kowalsky, Gerhard O. Michler: Lineare Algebra. Gruyter, ISBN 3-11-017963-6.

- Dietlinde Lau: Algebra und Diskrete Mathematik 1. Springer, ISBN 3-540-72364-1.

- Gilbert Strang: Introduction to Linear Algebra. Cambridge University Press, ISBN 0-9802327-1-6.

- Günter Gramlich: Lineare Algebra. Fachbuchverlag Leipzig im Carl Hanser Verlag, ISBN 3-446-22122-0.

Weblinks

- Kapitel: Eigenwerte und Eigenvektoren. Archiviert vom Original am 19. November 2012; abgerufen am 30. Oktober 2014. Von Joachim Weickert (Universität des Saarlandes): Mathematical Image Analysis Group. (PDF; 66 kB).

- MIT OpenCourseWare: Eigenvectors and Eigenvalues. Video der Vorlesung „Lineare Algebra“ von Gilbert Strang, MIT, 2000.

- Z. Bai, J. Demmel, J. Dongarra, A. Ruhe, H. van der Vorst: Templates for the Solution of Algebraic Eigenvalue Problems: a Practical Guide. SIAM, Philadelphia, 2000. Sehr umfangreiches englisches Werk.

- Interaktive Applets – von der Uni Stuttgart. Spiegelung, Projektion, Scherung, Drehung.

Einzelnachweise

- FAQL.de, abgerufen am 10. Juni 2013, zitiert David Hilberts Artikel Grundzüge einer allgemeinen Theorie der linearen Integralgleichungen, veröffentlicht 1904 in den Nachrichten von der Königlichen Gesellschaft der Wissenschaften zu Göttingen, mathematisch-physikalische Klasse.

- Hans-Joachim Kowalsky, Gerhard O. Michler: Lineare Algebra. 12. Auflage. Walter de Gruyter, Berlin 2003, ISBN 3-11-017963-6, S. 121.

- Karl-Heinz Goldhorn, Hans-Peter Heinz, Margarita Kraus: Moderne mathematische Methoden der Physik. Springer, 9. September 2010, ISBN 978-3-642-05184-5, S. 87 (Abgerufen am 29. Februar 2012).

- Reiner Kreissig, Ulrich Benedix: Höhere technische Mechanik: Lehr- und Übungsbuch. Springer DE, 2002, ISBN 978-3-7091-6135-7, S. 12 (eingeschränkte Vorschau in der Google-Buchsuche).

- Symmetrische Abbildungen und Matrizen. Theorem 10.75

- P. B. Denton, S. J. Parke, T. Tao, X. Zhang: Eigenvectors from Eigenvalues. (pdf) 10. August 2019, S. 1–3, abgerufen am 29. November 2019 (englisch).

- A. W. Joshi: Matrices and tensors in physics. New Age International, 1995, ISBN 978-81-224-0563-7, S. 117 (Abgerufen am 29. Februar 2012).