Übergangsmatrix

In der Mathematik, besonders der Wahrscheinlichkeitstheorie und Statistik, dient eine Übergangsmatrix (auch Prozessmatrix oder stochastische Matrix) dazu, die Übergangswahrscheinlichkeiten von (diskreten und kontinuierlichen) Markow-Ketten auszudrücken. Dadurch lassen sich künftige Entwicklungen vorausberechnen. In der Theorie der Markow-Ketten werden auch unendlichdimensionale Übergangsmatrizen definiert. In diesem Artikel werden jedoch nur Matrizen im Sinne der Linearen Algebra behandelt.

Eine Übergangsmatrix ist eine quadratische Matrix, deren Zeilen- oder Spaltensummen Eins betragen und deren Elemente zwischen Null und Eins liegen.[1]

Prozessmatrizen dienen ebenfalls zur künftigen Berechnung dynamischer Entwicklungen. Im Gegensatz zu stochastischen Matrizen müssen sie jedoch keine Zeilen- bzw. Spaltensummen von 1 haben. Sie sind jedoch wie die stochastische Matrix quadratisch.

Weitere Unterscheidung

- Eine Übergangsmatrix heißt zeilenstochastisch, wenn alle Einträge der Matrix zwischen 0 und 1 liegen und die Zeilensummen 1 ergeben.

- Eine Übergangsmatrix heißt spaltenstochastisch, wenn alle Einträge der Matrix zwischen 0 und 1 liegen und die Spaltensummen 1 ergeben.

- Eine Übergangsmatrix heißt doppelt-stochastisch, wenn sie sowohl zeilen- als auch spaltenstochastisch ist.

Äquivalent ist die folgende Definition: Eine Matrix heißt zeilen-(spalten-)stochastisch, wenn sie zeilen-(spalten-)weise aus Wahrscheinlichkeitsvektoren besteht.

Teilweise werden Matrizen mit Einträgen zwischen 0 und 1, deren Zeilensummen (bzw. Spaltensummen) kleiner als 1 sind, auch als substochastisch bezeichnet. In der Stochastik sind fast ausschließlich zeilenstochastische Matrizen gebräuchlich. Die Unterscheidung ist aber i. A. wenig gebräuchlich, da die Matrizen durch Transponierung ineinander übergehen.

Eigenschaften

Eigenwerte und Eigenvektoren

Den Eigenwerten und Eigenvektoren einer stochastischen Matrix kommt in der Stochastik eine besondere Rolle zu. Ist Eigenvektor zum Eigenwert , entspricht er einer stationären Verteilung der Markow-Kette (vgl. unten). Generell besitzt jede stochastische Matrix den Eigenwert 1. Ist z. B. zeilenstochastisch, so folgt mit der Zeilensummennorm, dass . Da der Spektralradius einer Matrix immer höchstens so groß wie ihre Norm ist, müssen alle Eigenwerte betragsmäßig kleiner oder gleich 1 sein. Ist nun ein Einsvektor (d. h. ein Vektor mit nur 1 als Einträgen), so gilt und 1 ist Eigenwert von . Der Beweis für spaltenstochastische Matrizen läuft analog, aber mit der Spaltensummennorm anstelle der Zeilensummennorm. Daraus folgt direkt, dass 1 auch immer betragsgrößter Eigenwert ist. Des Weiteren ist 1 auch immer ein halbeinfacher Eigenwert. Die Dimension des Eigenraumes lässt sich etwas schwerer berechnen. Mit dem Satz von Perron-Frobenius folgt:

- Ist die stochastische Matrix irreduzibel, so ist die Dimension des zum Eigenwert 1 gehörenden Eigenraumes gleich 1.

Dies ist insbesondere der Fall, wenn die Einträge einer stochastischen Matrix echt größer als 0 sind.

Konvexität, Normen und Abgeschlossenheit

Die Menge der Übergangsmatrizen ist konvex. Sind also und zeilen- bzw. spaltenstochastische Matrizen, so ist wieder eine zeilen- bzw. spaltenstochastische Matrix für alle .

Direkt aus der Definition folgt, dass die Zeilensummennorm einer zeilenstochastischen Matrix 1 ist, genauso wie die Spaltensummennorm einer spaltenstochastischen Matrix.

Außerdem sind Übergangsmatrizen abgeschlossen bezüglich der Matrixmultiplikation: Sind spalten- bzw. zeilenstochastische Matrizen, so ist ebenfalls eine spalten- bzw. zeilenstochastische Matrix.

Beispiel für eine Übergangsmatrix P

Das charakteristische Polynom einer -Übergangsmatrix lässt sich sehr leicht berechnen.

Mit der Spur und der Determinante gilt:

Aus der letzten Zeile ergibt sich, dass stets Eigenwert der Matrix P ist, unabhängig von der Wahl der Koeffizienten von P. Die anderen beiden Eigenwerte lassen sich dann über die p-q-Formel errechnen.

Anwendung zur Charakterisierung diskreter Markow-Ketten

Ist eine zeilenstochastische Matrix, so lässt sich damit auf folgende Weise eine zeitinvariante Markow-Kette mit endlichem Zustandsraum charakterisieren:

Die Einträge der Matrix sind genau die Übergangswahrscheinlichkeiten vom Zustand in den Zustand : . Ist nun ein Wahrscheinlichkeitsvektor (welcher in der Stochastik oftmals als Zeilenvektor definiert wird und mit bezeichnet wird), dann beschreibt den Zustand des Systems zum Zeitpunkt 0 (dabei ist der -te Eintrag von die Aufenthaltswahrscheinlichkeit zum Zeitpunkt 0 im Zustand ). Die Aufenthaltswahrscheinlichkeiten zum Zeitpunkt 1 ergeben sich durch Linksmultiplikation von mit :

Die Aufenthaltswahrscheinlichkeiten zu einem beliebigen Zeitpunkt in Abhängigkeit vom Startzustand sind dann

Für spaltenstochastische Matrizen kann man analog vorgehen, bloß dass die Vektormultiplikation von rechts durchgeführt wird und der gewöhnliche Eigenvektor zum Eigenwert 1 berechnet wird. Alternativ kann man auch die Matrix transponieren und das oben skizzierte Vorgehen nutzen.

Eine besondere Rolle kommt den Linkseigenvektoren der Matrix zum Eigenwert zu, denn diese stellen die stationären Verteilungen der Markow-Kette dar.

Ein anwendungsorientiertes Beispiel für diese Verwendung von Übergangsmatrizen ist die Berechnung des PageRank mittels der Google-Matrix. Jeder Zustand entspricht dort einer Webseite im World Wide Web, die Übergangswahrscheinlichkeiten geben an, mit welcher Wahrscheinlichkeit ein Nutzer auf einen Link klickt. Die Grenzverteilung ist dann die relative Häufigkeit, mit welcher der Nutzer auf eine Webseite stößt, und damit ein Maß für die Wichtigkeit dieser Seite.

Auch die Rechtseigenvektoren einer Übergangsmatrix zum Eigenwert 1 spielen eine Rolle bei der Untersuchung von Markow-Ketten. Bei passender Normierung sind diese genau die Absorptionswahrscheinlichkeiten in einem absorbierenden Zustand.

Des Weiteren finden sich auch viele Eigenschaften einer Markow-Kette in der Übergangsmatrix wieder:

- Existiert eine Zahl , so dass ist, dann ist der Zustand j vom Zustand i aus erreichbar.

- Gilt außerdem auch für ein , so kommunizieren die Zustände i und j.

- Im Fall einer homogenen Markow-Kette mit endlichem Zustandsraum ist der Begriff der irreduziblen Markow-Kette äquivalent zur Irreduzibilität der Übergangsmatrix.

- Ist für ein , so ist die Markow-Kette irreduzibel und aperiodisch und konvergiert demnach gegen eine Grenzverteilung. Dieses Kriterium ist oft leichter zu überprüfen als die Irreduzibilität und Aperiodizität separat zu zeigen.

- Die Chapman-Kolmogorow-Gleichung lässt sich im Falle einer Übergangsmatrix als komponentenweise ausgeschriebene Matrixmultiplikation interpretieren.

Beispiele

Die Ratte im Zimmer

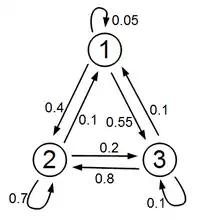

Peter besitzt eine Ratte. Ist die Ratte nicht im Käfig eingesperrt, so befindet sie sich entweder unter dem Schreibtisch (Zustand 3), hinter dem Schrank (Zustand 2) oder ist im Käfig, um zu fressen (Zustand 1). Die Ratte wechselt alle 5 Minuten ihren Ort. Ist sie gerade im Käfig, so bleibt sie mit Wahrscheinlichkeit 0,05 dort, mit Wahrscheinlichkeit 0,4 geht sie hinter den Schrank und mit Wahrscheinlichkeit 0,55 unter den Schreibtisch. Ist sie hinter dem Schrank, so bleibt sie mit Wahrscheinlichkeit 0,7 dort, mit Wahrscheinlichkeit 0,2 geht sie unter den Schreibtisch und mit Wahrscheinlichkeit 0,1 geht sie in den Käfig. Ist sie unter dem Schreibtisch, so bleibt sie mit Wahrscheinlichkeit 0,1 dort, mit Wahrscheinlichkeit 0,1 geht sie in den Käfig und mit Wahrscheinlichkeit 0,8 flüchtet sie hinter den Schrank. Das Verhalten der Ratte wird durch die zeilenstochastische Matrix beschrieben:

Peter lässt nun seine Ratte frei und will wissen, mit welcher Wahrscheinlichkeit sich die Ratte nach 20 Minuten im Käfig befindet. Der Startzustand des Systems ist

(die Ratte befindet sich mit Wahrscheinlichkeit 1 im Käfig). Der Zustand nach 20 Minuten (nach 4 Zeitschritten) ist dann (gerundet)

Die Ratte befindet sich also mit Wahrscheinlichkeit 0,0952 im Käfig.

Peter fährt über das Wochenende in den Urlaub und will danach seine Ratte wieder einfangen. Nun stellt sich die Frage, wo er am besten suchen soll. Da viel Zeit vergangen ist, seit die Ratte freigelassen wurde, ist die Annahme gerechtfertigt, dass sich das System im Gleichgewicht befindet. Gesucht ist daher ein Linkseigenvektor von bzw. ein Rechtseigenvektor von zum Eigenwert 1. Durch Nachrechnen ergibt sich für den Eigenvektor (gerundet)

Peter sollte also zuerst hinter dem Schrank suchen.

Die Katze und die Maus

Gegeben seien fünf nebeneinander liegende Boxen, durchnummeriert von eins bis fünf, und in der ersten Box möge sich eine Katze und in der letzten eine Maus befinden. Nach einer festen Zeit wechseln die Tiere zufällig in eine Nachbarbox. Das makabre Spiel hat ein Ende, wenn die Katze in einer Box auf die Maus trifft. Wir bezeichnen die möglichen Zustände mit (i,j), d. h., die Katze ist in der i-ten und die Maus in der j-ten Box. Wir sehen sofort, dass wenn i gerade (ungerade) ist, j ebenfalls gerade (ungerade) sein muss. Sofort ist auch klar, dass gelten muss. Die Markow-Kette, die dieses Spiel beschreibt, hat also die folgenden fünf Zustände:

- (1,3)

- (1,5)

- (2,4)

- (3,5)

- Spielende (2,2), (3,3) und (4,4).

Der Vektor gebe an, welcher dieser fünf Zustände vorliegt. Beispielsweise steht für den ersten Zustand unserer Auflistung, also , und für den letzten, also das Spielende (egal, in welcher Box).

Die Übergangsmatrix A dazu ist nun

Wenn wir beispielsweise wie zu Beginn im 2. Zustand sind, dann wechseln wir mit Sicherheit in den 3. Zustand , also Katze in der zweiten und Maus in der vierten Box. Daher ist in der Übergangsmatrix die Position in der 2. Spalte und 3. Zeile gleich eins.

Von diesem Zustand ausgehend kommen wir nun aber mit 25 % Wahrscheinlichkeit in einen der anderen vier Zustände, daher sind alle Zeilen in der 3. Spalte gleich 1/4 (außer die 3. Zeile – der Zustand kann nicht derselbe bleiben).

Siehe auch

Literatur

- Hans-Otto Georgii: Stochastik: Einführung in die Wahrscheinlichkeitstheorie und Statistik. 4. Auflage. de Gruyter Lehrbuch, Berlin 2009, ISBN 978-3-11-021526-7, Kap. 6.

- Peter Knabner, Wolf Barth: Lineare Algebra. Grundlagen und Anwendungen (= Springer-Lehrbuch). Springer, Berlin 2012, ISBN 978-3-642-32185-6.

Einzelnachweise

- Gerhard Hübner: Stochastik. 2009, S. 162.