Statistische Physik

Die statistische Physik ist ein Zweig der Physik, der Methoden der Wahrscheinlichkeitstheorie für die Beschreibung physikalischer Systeme verwendet. Damit kann die statistische Physik Aussagen über die Eigenschaften und das Verhalten eines großen zusammengesetzten Systems machen, ohne das Verhalten jedes seiner Teile im Einzelnen zu verfolgen. Typische Aussagen der statistischen Physik haben den Charakter von Wahrscheinlichkeiten, die aber mit steigender Anzahl der Teile des Systems immer mehr zu Gewissheiten werden.

Die statistische Physik beschäftigt sich hauptsächlich damit, das physikalische Verhalten von Vielteilchensystemen wie Festkörper, Flüssigkeiten und Gase aus den Eigenschaften der Atome und Moleküle heraus zu erklären. Anwendung finden ihre Methoden auch bei vielen Fragen anderer Natur- und Ingenieurwissenschaften wie Biologie, Chemie, Neurowissenschaft, Verfahrenstechnik, sowie in den Sozial-, Wirtschafts- und Sprachwissenschaften (siehe Soziophysik, Ökonophysik, Statistische Linguistik).

Die statistische Physik ist eine fundamentale physikalische Theorie. Sie geht für die Bewegung der einzelnen Teilchen von den einfachsten Gesetzen aus und kann mithilfe von wenigen zusätzlichen physikalischen Hypothesen u. a. die Gesetze der Thermodynamik ableiten und begründen, aber auch die statistischen Schwankungen um einen stationären Gleichgewichtszustand. Derzeit noch offene Fragen betreffen vor allem die irreversiblen Prozesse, etwa die Berechnung von Transportkoeffizienten aus mikroskopischen Eigenschaften.

Die statistische Mechanik und die statistische Quantenmechanik sind Teilgebiete der statistischen Physik.

Grundlagen

Allgemeines

Statistische Zusammenhänge können in der Physik überall dort formuliert werden, wo bei einem Gesamtsystem eine beobachtbare physikalische Größe von den momentanen Zuständen vieler seiner Teilsysteme abhängig ist, diese aber nicht genauer bekannt sind. Beispielsweise sind in 1 Liter Wasser etwa Wassermoleküle enthalten. Um das Fließen von 1 Liter Wasser in einem Rohr zu beschreiben, wäre es unpraktikabel, die Wege aller 33 000 000 000 000 000 000 000 000 Wassermoleküle einzeln auf atomarer Ebene verfolgen zu wollen. Es reicht aus, das Verhalten des Systems im Großen nachzuvollziehen.

Grundlegend ist der Ansatz, dass die Teilsysteme sich im Rahmen ihrer individuellen Möglichkeiten in beliebiger Weise verhalten können. Dabei könnte das Gesamtsystem im Prinzip auch eine bestimmte Kombination von makroskopischen Werten erhalten, die allen bisherigen Beobachtungen widerspricht; dies erweist sich aber als derartig unwahrscheinlich, dass man es vernünftigerweise ausschließen muss. Ein Beispiel wäre, dass sich in einem Liter Luft alle Moleküle spontan in einer Hälfte des Volumens versammeln, was sich im Durchschnitt einmal zeigen würde, wenn man nacheinander 10(1022) mal nachschaut.

Es ist bei solchen Systemen praktisch unmöglich, die momentanen Zustände aller Teilsysteme im Detail zu ermitteln, um daraus auf die Werte der beobachtbaren Größen oder das weitere Verhalten des Gesamtsystems zu schließen, zumal sich diese Zustände auch viel schneller verändern als die am Gesamtsystem beobachtbaren Größen. Es stellt sich heraus, dass Kenntnisse der Details aller Teilsysteme oft auch gar nicht benötigt werden, will man praktikable Aussagen über das Verhalten des Gesamtsystems gewinnen.

Auf der Grundlage weniger, allerdings nicht weiter beweisbarer Grundannahmen stellt die statistische Physik Begriffe und Methoden zur Verfügung, mit denen aus den bekannten Gesetzen für das Verhalten der Teilsysteme, bis hinab zu den einzelnen Teilchen oder Quanten, Aussagen über das System im Ganzen getroffen werden können.

Statistische Begründung der Thermodynamik

Die Begriffe und Gesetze der klassischen Thermodynamik wurden im 18. und 19. Jahrhundert zunächst auf phänomenologischem Weg an makroskopischen Systemen gewonnen, vornehmlich an solchen im Zustand des Gleichgewichts oder nicht weit davon entfernt. Sie lassen sich mit der statistischen Physik heutzutage auf die Eigenschaften und das Verhalten ihrer kleinsten Teilchen (meist Atome oder Moleküle) zurückführen. Für jeden durch makroskopische Werte definierten Zustand des Systems — als Makrozustand bezeichnet — gibt es dabei immer sehr viele Möglichkeiten, den einzelnen Teilchen gerade solche Zustände zu geben, dass sie zusammen genommen die vorgegebenen makroskopischen Werte des Systems hervorbringen.[Anm. 1] Die genaue Verteilung der Teilchen auf ihre einzelnen Zustände heißt Mikrozustand, und zu jedem Makrozustand gehört eine bestimmte Menge von Mikrozuständen. Da die Teilchen in Bewegung sind und systeminterne Wechselwirkungsprozesse durchmachen, bleibt im Allgemeinen kein Mikrozustand zeitlich erhalten. Er verändert sich mikroskopisch gesehen zwar deterministisch, das Ergebnis kann aber nur mit Wahrscheinlichkeit vorhergesagt werden. Wenn nun der Makrozustand ein zeitlich stabiler Gleichgewichtszustand des makroskopischen Systems sein soll, heißt das, dass der Mikrozustand nicht aus der Menge der zu diesem Makrozustand gehörigen Mikrozustände hinauswandert. Die thermodynamischen Zustandsgleichungen, also die Gesetze über den stabilen Gleichgewichtszustand eines makroskopischen Systems, können nun so hergeleitet werden: Man ermittelt zu einem fiktiv angenommenen Makrozuständen des Systems die jeweiligen Mengen der zugehörigen Mikrozustände. Um den Gleichgewichtszustand zu erhalten, bestimmt diese Menge für verschiedene Makrozustände und wählt darunter diejenige Menge aus, die sich als ganzes im Laufe der Zeit durch die systeminternen Prozesse nicht oder nur mit der minimal möglichen Wahrscheinlichkeit ändert. Das Auswahlkriterium ist dabei denkbar einfach: Man wählt aus den Mengen die größte aus.

Bei einem beliebigen anderen Makrozustand, der kein Gleichgewichtszustand ist, führen die Veränderungen des Mikrozustands durch systeminterne Prozesse zu allmählichen Veränderungen von makroskopischen Größen, also auch zu anderen Makrozuständen. In solchem Fall kann die statistische Physik für viele physikalische Systeme erklären, warum diese makroskopische Veränderung als Relaxation in Richtung des Gleichgewichts verläuft und wie schnell sie vor sich geht.

Zusätzlich zeigt diese statistische Betrachtung, dass der Zustand des thermodynamischen Gleichgewichts nur bei makroskopischer Betrachtung stabil ist, bei mikroskopischer Betrachtung aber im zeitlichen Ablauf Fluktuationen aufweisen muss. Diese Fluktuationen sind real, werden aber relativ gesehen immer unbedeutender, je größer das betrachtete System ist. Bei typischen makroskopischen Systemen sind sie um viele Größenordnungen geringer als die erreichbare Messgenauigkeit und daher für die meisten Anwendungsfälle der Thermodynamik irrelevant. Mit solchen Aussagen geht die statistische Physik über die klassische Thermodynamik hinaus und erlaubt, deren Geltungsbereich quantitativ einzugrenzen. Die Fluktuationen erklären etwa Erscheinungen wie die Kritische Opaleszenz und die schon seit Anfang des 19. Jahrhunderts bekannte Brownsche Bewegung. Genauere Messungen an solchen Fluktuationen wurden Anfang des 20. Jahrhunderts an mesoskopischen Systemen durchgeführt. Dass diese Messergebnisse auch quantitativ den Vorhersagen der statistischen Physik entsprachen, trug erheblich zu ihrem Durchbruch und damit der Akzeptanz der Atomhypothese bei. Es war auch die Betrachtung solcher Fluktuationen, durch die Max Planck zu seiner Strahlungsformel und Albert Einstein zur Lichtquantenhypothese geführt wurden, wodurch die Quantenphysik begründet wurde.

Grundannahmen der statistischen Behandlung

Ausgangspunkt ist der Mikrozustand eines großen physikalischen Systems. Im Bereich der klassischen Physik ist er durch die Angabe der momentanen Orte und Impulse aller seiner Teilchen — also mikroskopisch — gegeben; im vieldimensionalen Phasenraum des Systems besetzt er einen einzigen Punkt. Gemäß der allgemeinen Darstellung im vorigen Abschnitt wird ein Maß für die Größe einer Teilmenge des Phasenraums benötigt. In der klassischen Physik bilden die Punkte der einzelnen Mikrozustände im Phasenraum ein Kontinuum. Da man die Punkte darin nicht abzählen kann, ist das nächstliegende Maß durch das Volumen der Teilmenge gegeben. Dazu kann man sich den Phasenraum in kleine Volumenelemente aufgeteilt denken, die jeweils gleiche Mengen einander sehr ähnlicher Zustände enthalten. Falls das Volumenelement nur einen Zustand enthalten soll, spricht man von Phasenraumzelle.

Im Bereich der Quantenphysik ist der Mikrozustand durch einen reinen quantenmechanischen Zustand des Vielteilchensystems gegeben, wie er z. B. durch einen Projektionsoperator auf einen 1-dimensionalen Unterraum des Hilbertraums des gesamten Systems definiert ist oder durch einen normierten Vektor daraus repräsentiert wird. Der Hilbertraum ist hier auch der Phasenraum. Als Maß für eine Teilmenge von Zuständen dient (falls die Basis abzählbar ist) die Dimension des betreffenden Unterraums des Hilbertraums.

Im Laufe der Zeit wandert der Punkt bzw. der Zustandsvektor, der den momentanen Mikrozustand des Systems angibt, in dem Phasenraum umher, etwa weil Orte und Geschwindigkeiten der Teilchen ständig variieren bzw. einzelne Teilchen von einem Energieniveau in ein anderes wechseln. Alle makroskopischen Variablen des Systems (wie Volumen, Energie, aber auch solche wie Massenmittelpunkt, dessen Geschwindigkeit etc.) sind aus den Daten des gerade vorliegenden Mikrozustands berechenbar (wenn diese denn vollständig bekannt wären). In einem Makrozustand des Systems, dem Ausgangspunkt der makroskopischen Thermodynamik, sind nur diese makroskopischen Werte gegeben. Ein Makrozustand — ob im Gleichgewicht oder nicht — wird durch eine bestimmte Menge vieler verschiedener Mikrozustände realisiert. Welcher von ihnen zu einem bestimmten Zeitpunkt vorliegt, wird als Zufall behandelt, denn es ist praktisch unmöglich, diesen vorher zu bestimmen. Um die Wahrscheinlichkeit für diese ganze Menge von Mikrozuständen berechnen zu können, ist nach den Regeln der Wahrscheinlichkeitstheorie eine Grundannahme zur a-priori-Wahrscheinlichkeit nötig, mit der ein bestimmter einzelner Mikrozustand vorliegt. Diese lautet:

- Grundannahme zur a-priori-Wahrscheinlichkeit: In einem abgeschlossenen System haben alle erreichbaren Mikrozustände die gleiche a-priori-Wahrscheinlichkeit.

Bilden die Mikrozustände ein Kontinuum, wird diese Annahme nicht auf einen einzelnen Punkt des Phasenraums bezogen, sondern auf ein Volumenelement mit Mikrozuständen, die hinreichend genau zum selben Makrozustand gehören: Die a-priori-Wahrscheinlichkeit ist proportional zur Größe des Volumenelements. Beweisen lässt sich diese Grundannahme nicht, aber mittels der von Boltzmann aufgestellten Ergodenhypothese verständlich machen: Es wird angenommen, dass für ein abgeschlossenes System der Punkt des jeweiligen Mikrozustands im Phasenraum des Systems in der Weise umherwandert, dass er jeden einzelnen Mikrozustand mit gleicher Häufigkeit erreicht (bzw. ihm beliebig nahe kommt). Die Wahl des Volumenelements als Maß für die Wahrscheinlichkeit bedeutet anschaulich, dass nicht nur die Mikrozustände, sondern auch ihre Trajektorien den Phasenraum mit konstanter Dichte füllen.

Da der Phasenraum alle überhaupt möglichen Mikrozustände des Systems umfasst, bilden diejenigen Mikrozustände, die zu einem gegebenen Makrozustand gehören, darin eine Teilmenge. Das Volumen dieser Teilmenge ist das gesuchte Maß für die Wahrscheinlichkeit, dass das System sich gerade in diesem gegebenen Makrozustand befindet. Oft wird dieses Volumen als die zum vorgegebenen Makrozustand gehörige „Anzahl der möglichen Zustände“ bezeichnet, obwohl es sich in der klassischen Physik nicht um eine reine Zahl handelt, sondern um eine Größe mit einer Dimension, die durch eine mit der Teilchenzahl zunehmende Potenz der Wirkung gegeben ist. Weil von diesem Phasenraumvolumen in den statistischen Formeln für thermodynamische Größen der Logarithmus benötigt wird, muss man es noch zu einer reinen Zahl umwandeln, indem man es auf die Phasenraumzelle bezieht. Berechnet man auf diese Weise die Entropie eines idealen Gases, zeigt sich durch Anpassung an die Messwerte, dass die Phasenraumzelle (pro Teilchen und pro Freiheitsgrad seiner Bewegung) gerade so groß ist wie das Plancksche Wirkungsquantum . Damit erhält man für die Zahl, die die Wahrscheinlichkeit angibt, typischerweise sehr große Werte, weshalb sie im Unterschied zur mathematischen Wahrscheinlichkeit auch als thermodynamische Wahrscheinlichkeit bezeichnet wird. In der Quantenstatistik tritt an die Stelle des Volumens die Dimension des betreffenden Unterraums des Hilbertraums. Auch außerhalb der statistischen Physik benutzt man in manchen quantenmechanischen Berechnungen des Phasenraumvolumens die Näherung, die Größe erst auf klassische Weise durch Integration zu ermitteln und das Ergebnis durch eine entsprechende Potenz des Wirkungsquantums zu dividieren.

Alle interessierenden makroskopischen Werte kann man als Mittelwert der Dichteverteilung der Mikrozustände im Phasenraum berechnen.

Stabiler Gleichgewichtszustand

Einen in mikroskopischer Hinsicht stabilen Gleichgewichtszustand kann es nicht geben.[Anm. 1] Die beste Annäherung wird bei vorgegebenen makroskopischen Werten der Systemvariablen durch denjenigen Makrozustand erreicht, der die größtmögliche Wahrscheinlichkeit besitzt. Der Erfolg der statistischen Physik beruht ganz wesentlich darauf, dass dieses Kriterium den Makrozustand mit außerordentlicher Schärfe festlegt, wenn das System aus hinreichend vielen Teilsystemen besteht (vgl. das Gesetz der großen Zahl). Alle anderen Zustände verlieren schon bei geringen Abweichungen so extrem an Wahrscheinlichkeit, dass ihr Vorkommen vernachlässigt werden kann.

Ein Beispiel, das diesen Umstand verdeutlicht: Welche räumliche Dichteverteilung ist bei den Molekülen eines klassischen Gases die wahrscheinlichste? Wenn sich Moleküle im Volumen befinden, von dem ein kleiner Teil () betrachtet wird, gibt es Möglichkeiten, die Moleküle so zu verteilen, dass sich Moleküle im Volumenteil befinden und im Volumentail (Binomialverteilung). Wenn die Moleküle hinsichtlich aller anderen Merkmale ihrer Zustände die gleiche Verteilung wie die übrigen haben, ist diese Formel schon ein Maß für die Anzahl der Zustände. Diese Binomialverteilung hat den Erwartungswert und dort ein Maximum mit der relativen Breite . Bei z. B. normaler Luft, und folgt und . Beim wahrscheinlichsten Makrozustand entspricht also in etwa 2/3 der Zeit die räumliche Dichte im mm-Maßstab dem Durchschnittswert besser als mit 8-stelliger Genauigkeit. Größere relative Abweichungen treten auch auf, aber bspw. mehr als nur in etwa 10−6 der Zeit (siehe Normalverteilung).

Quantenstatistik ununterscheidbarer Teilchen

Das statistische Gewicht eines Makrozustands hängt stark davon ab, ob bei den zugehörigen Mikrozuständen alle diejenigen einzeln mitzählen, die sich nur durch die Vertauschung von zwei Teilchen der physikalisch gleichen Art unterscheiden. Wenn dem so wäre, enthielte die Formel für die Entropie in der statistischen Mechanik einen Summanden, der nicht additiv in der Teilchenzahl (und deshalb falsch) ist. Dieses Problem wurde als Gibbssches Paradoxon bekannt. Dies Paradoxon lässt sich hilfsweise durch eine Zusatzregel zur Zählweise nach Boltzmann beseitigen: Vertauschungen gleicher Teilchen sind nicht mitzuzählen. Die nähere Begründung hierfür konnte erst durch die Quantenmechanik identischer Teilchen erfolgen. Danach ist außerdem bei ununterscheidbaren Teilchen grundlegend zu unterscheiden, ob ihr Spin ganzzahlig ist (Teilchentyp Boson) oder halbzahlig (Teilchentyp Fermion). Bei Fermionen tritt nämlich zusätzlich die weitere Gesetzmäßigkeit auf, dass derselbe Einteilchen-Zustand nicht von mehr als einem Teilchen besetzt werden kann, während bei Bosonen diese Zahl beliebig groß sein kann. Bei Beachtung dieser Regeln entstehen aus der einheitlichen klassischen (oder Boltzmannschen) Statistik die Fermi-Dirac-Statistik für gleichartige Fermionen und die Bose-Einstein-Statistik für gleichartige Bosonen. Beide Statistiken zeigen bei tiefen Temperaturen (die Wärmestrahlung bei jeder Temperatur, die Leitungselektronen im Metall auch schon bei Raumtemperatur) gravierende Unterschiede, sowohl untereinander als auch gegenüber der klassischen Statistik, im Verhalten von Systemen mit mehreren identischen Teilchen, und das bei jeder Teilchenzahl.

Verbundene Systeme, Gleichgewichte, Ensembles

Allgemeines

Wichtig sind weiterhin Aussagen für ein nicht abgeschlossenes System, das mit seiner Umgebung Energie, Teilchen, Volumen oder auch eine andere physikalische Größe austauschen kann. Um die oben beschriebenen Methoden einsetzen zu können, wird auch die Umgebung als ein System betrachtet (B), das mit dem interessierenden System (A) zusammen ein Gesamtsystem (A*B) bildet, welches nun als abgeschlossen vorausgesetzt wird. Das Umgebungssystem B wird dabei häufig als Reservoir bezeichnet (bei Energieaustausch auch als Wärmebad). Die ausgetauschten Größen sollen Erhaltungsgrößen sein, ihre Gesamtmenge bleibt also konstant. Zu einem Makrozustand des Gesamtsystems gehört dann eine bestimmte Menge von Mikrozuständen, die jeweils Paare von Mikrozuständen von System A und Reservoir B sind. In jedem Paar können die dem Austausch unterliegenden Erhaltungsgrößen anders aufgeteilt sein, aber immer so, dass die für das Gesamtsystem vorgegebenen Werte gewährleistet sind. Diejenige Aufteilung, bei der die Anzahl der Paare am größten ist, bestimmt den thermodynamischen Gleichgewichtszustand des Gesamtsystems A*B. Dieser ist ein wohldefinierter Makrozustand des Gesamtsystems. Nicht so die Menge der Mikrozustände des betrachteten Systems A, die in den zum Gleichgewicht von A*B gehörigen Paaren vorkommen. Sie repräsentieren verschiedene Makrozustände des Systems A, denn sie können sich in makroskopischen Größen des Systems A unterscheiden, nämlich in Energie, Teilchenzahl etc., je nach Art des betrachteten Austauschs. Für das Reservoir B wird angenommen, dass aus so vielen Teilchen besteht und in einem solchen Zustand ist, dass seine Eigenschaften durch den Austausch mit dem System A nicht merklich verändert werden.

Die Menge derjenigen Mikrozustände des Systems A, die im stationären Gleichgewichtszustand des Gesamtsystems vorkommen, wird als Ensemble oder Gesamtheit bezeichnet. Speziell wird die Gesamtheit der Mikrozustände eines abgeschlossenen Systems im Gleichgewichtszustand als mikrokanonisches Ensemble bezeichnet[Anm. 2], bei einem System mit Energieaustausch mit der Umgebung als kanonisches Ensemble, und bei einem System mit Energie- und Teilchenaustausch als makrokanonisches oder großkanonisches Ensemble.

Für jeden einzelnen Mikrozustand des Systems A gibt eine Funktion (bzw. bei quantenmechanischer Berechnung der Erwartungswert eines Dichteoperators ) die Häufigkeit an, mit der der Mikrozustand im Ensemble vorkommt. (Bei einem System aus klassischen Teilchen bedeutet Argument eine komplette Liste der kanonischen Koordinaten und konjugierten Impulse . In quantenmechanischer Berechnung ist durch eine Matrix gegeben, deren Zeilen- und Spaltenindizes alle Mikrozustände das Systems A durchlaufen.) Diese Funktion wird als Dichtefunktion (oder Dichteverteilung, Verteilungsfunktion) des Ensembles bezeichnet, die Matrix als seine Dichtematrix. Die Bestimmung solcher Dichtefunktionen oder Dichtematrizen für konkrete thermodynamische Ensembles ist eine zentrale Aufgabe der statistischen Physik. Die allgemeine Lösung ist: Die gesuchte Häufigkeit des Gleichgewichtszustands von A ist gerade gleich der Wahrscheinlichkeit, das Reservoir B in einem passenden Makrozustand zu finden, so dass System und Reservoir zusammen die festen Werten der makroskopischen Variablen des Gesamtsystems A*B ergeben. Diese Wahrscheinlichkeit ist also gleich der Anzahl der möglichen Mikrozustände, die das Reservoir in seinem Phasenraum dabei haben kann.

Bei einer etwas anderen Darstellung dieser Zusammenhänge, die auch häufig in Lehrbüchern anzutreffen ist, wird das Ensemble als eine große Menge von Kopien des Systems A beschrieben, deren jede mit der Umgebung B denselben Gleichgewichtszustand des Gesamtsystems A*B bildet, und wobei unter den Kopien jeder der betreffenden Mikrozustände von A mit einer der Wahrscheinlichkeit entsprechenden Häufigkeit vertreten ist. Wenn man das Ensemble auf diese Weise interpretiert, ergeben sich die gesuchten zeitliche Mittelwerte eines Systems A nicht aus der zeitlichen Mittelung der Entwicklung dieses Systems, sondern aus den Scharmittelwerten über alle im Ensemble vorkommenden Kopien von A. Denn nach der Ergodenhypothese muss das System im Laufe der Zeit alle Mikrozustände des Ensembles mit einer durch die Dichtefunktion gegebenen Wahrscheinlichkeit, also in einem entsprechenden Bruchteil der Zeit, einnehmen. Das wird als Scharmittelwert = Zeitmittelwert zusammengefasst und auch des Öfteren als Ergodenhypothese bezeichnet.

System mit vielen Teilchen

Besteht auch das System A aus einer genügend großen Anzahl Teilchen, stellt sich für den Gleichgewichtszustand des Gesamtsystems A*B heraus, dass nur ein extrem kleiner Bereich eng benachbarter Makrozustände von A die Mikrozustände beisteuert, die zum Gleichgewichtszustand den weitaus größten Anteil aller Paare bilden. Der einzelne Makrozustand des Systems A, der mit seinen Mikrozuständen den größten Einzelbeitrag dazu leistet, wird als derjenige Makrozustand bezeichnet, in dem das System A mit seiner Umgebung B im Gleichgewicht steht. Der erwähnte Bereich eng benachbarter Makrozustände ist der Bereich der häufigen Fluktuationen des Systems A um den Zustand des Gleichgewichts mit der Umgebung B.

Auf diese Weise gelangt die statistische Physik zu unabhängigen grundlegenden Deutungen der Größen wie Temperatur, chemisches Potential etc., mit denen in der makroskopischen Thermodynamik die Gleichgewichtszustände gekoppelter Systeme charakterisiert werden. Sie sind Beispiele für Zustandsgrößen:

- Die Temperatur ist derjenige Parameter, der zwischen zwei Systemen übereinstimmen muss, damit Gleichgewicht hinsichtlich des Austauschs von Energie herrscht.

- Das chemische Potential hat die gleiche Bedeutung für den Teilchenaustausch.

- Der Druck hat die gleiche Bedeutung für die Ausdehnung des einen Systems auf Kosten des anderen.

System mit wenigen Teilchen

Die vorstehend dargestellten Zusammenhänge gelten – mit einer Ausnahme – auch für kleine Systeme bis hinab zu einzelnen Teilchen, die mit ihrer Umgebung einen Zustand des thermodynamischen Gleichgewichts bilden, also z. B. für jedes der einzelnen Teilchen eines großen Systems. Das Teilchen ist dann das System A, der Rest die Umgebung B. Das System kann sogar auch durch nur einen einzelnen Freiheitsgrad der Teilchen gegeben sein. Die erwähnte Ausnahme bezieht sich auf die Aussage, dass die zum Gleichgewicht des Gesamtsystems gehörigen Mikrozustände des Systems A eng benachbart zu einem bestimmten Makrozustand von A liegen, und dass die Wahrscheinlichkeit für größere Abweichungen schnell vernachlässigbar klein wird. Die Verteilung ist für große wie kleine Systeme A durch den universell gültigen Boltzmann-Faktor gegeben. ( ist die Boltzmannkonstante, die absolute Temperatur des Gleichgewichtszustands, und die Energie des betreffenden Mikrozustands von A.) Bei großen Systemen nun ist der Energiemaßstab des Boltzmann-Faktors meist vernachlässigbar klein gegen die Anregungsenergien des Systems im interessierenden Bereich, er charakterisiert die Größe der thermischen Fluktuationen. Bei einem genügend kleinen System hingegen haben solche Änderungen der Energie erhebliche Auswirkungen auf das Verhalten. Daher verteilen sich die Mikrozustände eines kleinen Systems A (z. B. mit nur einem oder wenigen Teilchen) stärker über den ganzen interessierenden (und zugänglichen) Teil des Phasenraums, wenn es Teil eines großen, im Gleichgewichtszustand befindlichen Systems A*B ist.

Ein augenfälliges Beispiel hierfür ist die Dichteverteilung der Luft. Das System A wird hierbei durch die Höhenkoordinate eines beliebig herausgegriffenen Moleküls gebildet, und der Boltzmann-Faktor mit dessen potentieller Energie im Schwerefeld liefert die Barometrische Höhenformel. Betrachtet man statt einzelner Moleküle größere Teilchen, ist deren potentielle Energie maßgeblich, und die Höhenverteilung schrumpft umgekehrt proportional zur Masse, im Fall makroskopischer Körper so weit, dass man überhaupt nicht mehr von einer Höhenverteilung sprechen muss.

Dieses Ergebnis wird häufig bei großen Vielteilchensystemen angewandt, um die tatsächliche Verteilung der einzelnen Teilchen auf ihre möglichen Einzelteilchenzustände oder Energieniveaus zu bestimmen. Auf Feinheiten und verschiedene Verwendungen des Ensemble-Begriffs braucht dabei keine Rücksicht genommen zu werden, denn schon ein einzelnes System mit einer großen Anzahl (gleicher) Teilchen verkörpert bereits ein ganzes Ensemble physikalisch gleicher Systeme A*B, wo System A ein beliebiges herausgegriffenes Teilchen darstellt und System B der jeweils physikalisch gleiche Rest ist.

Geschichte

Die statistische Physik hat sich aus der mechanischen Theorie der Wärme entwickelt, die im 17. und 18. Jahrhundert von Francis Bacon und Robert Boyle vorgeschlagen wurde. Als erste einschlägige Anwendung der mechanischen Gesetze veröffentlichte Daniel Bernoulli 1738 eine rein mechanische Erklärung für das Gesetz von Boyle und Mariotte. Er interpretierte darin den Druck eines Gases als zeitlich gemittelten Impulsübertrag an die Wand pro Fläche und Zeit, und berechnete, wie hoch dieser Wert aufgrund von elastischen Stöße der Gasmoleküle durchschnittlich ist. Der so berechnete Druck erweist sich als proportional zur Masse , zum Quadrat der Geschwindigkeit und zur Anzahldichte der Teilchen. Daraus folgt . Über die allgemeine Gasgleichung ergibt sich sofort eine mechanische Deutung für die (absolute) Temperatur: Sie gibt in einem eigenen Maßstab einfach die (durchschnittliche) kinetische Energie der Teilchen an. Diese Deutung der Temperatur gilt in Strenge nur für das ideale Gas. Sie hat sich aber weit verbreitet und ist auch Grundlage der seit 2019 geltenden Definition der Temperatureinheit K (Kelvin) durch Bezug zur Energieeinheit J (Joule).

Im weiteren Verlauf entwickelten Michail Wassiljewitsch Lomonossow, Georges-Louis Le Sage, John Herapath und John James Waterston aus Bernoullis Ansatz heraus die Anfänge der Kinetischen Gastheorie, die jedoch weitgehend ignoriert wurden. Erst ab 1860 fand die kinetische Gastheorie durch die Arbeiten von Rudolf Clausius, James Clerk Maxwell und Ludwig Boltzmann breitere Anerkennung. Maxwell berechnete 1860 die Geschwindigkeitsverteilung der Moleküle im Gas und führte damit den Begriff der Verteilungsfunktion ein. Boltzmann konnte 1872 durch sein H-Theorem zeigen, dass sich alle anderen Verteilungen durch statistisch unkorrelierte Stöße der Teilchen allmählich der Maxwell-Verteilung annähern. Daraus ergab sich eine rein mechanische Deutung des Gesetzes vom irreversiblen Anwachsen der Entropie, also des 2. Hauptsatzes der Thermodynamik. Boltzmann publizierte 1884 auch die für das statistische Gleichgewicht grundlegende Vorstellung, ein Gleichgewichtszustand sei durch eine bestimmte Eigenschaft der Verteilungsfunktion ausgezeichnet.[1] Daraus entwickelte Josiah Willard Gibbs um 1900 die Begriffe der thermodynamischen Ensembles. Zugleich wurde die Häufigkeitsverteilung von Fluktuationen intensiver untersucht, was Max Planck zu seiner Strahlungsformel führte, und Albert Einstein zur Erklärung der Brownschen Bewegung sowie zur Quantenstruktur des Lichts. Alle drei Entdeckungen sind Meilensteine auf dem Weg in die Moderne Physik.

Gleichzeitig wurde die statistische Mechanik aber auch heftig bestritten, sogar noch bis ins 20. Jahrhundert hinein u. a. durch die bedeutenden Naturwissenschaftler Ernst Mach und Wilhelm Ostwald, da diese Theorie vollständig von der damals noch als Hypothese betrachteten Existenz der Atome oder Moleküle abhängt.

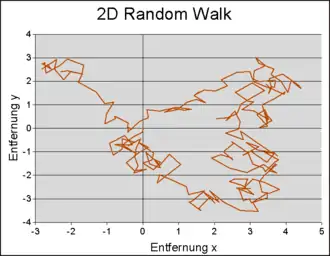

In den 1920er Jahren wurden, u. a. von Enrico Fermi und wiederum Einstein, die beiden Typen der Quantenstatistik ununterscheidbarer Teilchen entdeckt, die durch ihre Unterschiede zur klassischen Boltzmannschen Statistik wesentliche Eigenschaften der Materie erklären. Seit der Verfügbarkeit von Computern werden Transportprobleme und andere Fragen der statistischen Physik auch zunehmend durch direkte Berechnung mittels Monte-Carlo-Methoden oder Molekulardynamiksimulationen gelöst, siehe nebenstehende Grafik.

Anmerkungen

- Ausnahme: der Makrozustand am absoluten Minimum der Energie. Hier kann es sein, dass nur ein einziger Mikrozustand möglich ist.

- Manche Darstellungen lassen ein infinitesimales Energieintervall zu.

Literatur

- L.D. Landau, E.M. Lifschitz: Statistische Physk (Bd. 6 des Lehrbuchs der Theoretischen Physik), Akademie-Verlag Berlin, 1966

- Klaus Stierstadt: Thermodynamik — Von der Mikrophysik zur Makrophysik, Springer Verlag, 2010, ISBN 978-3-642-05097-8, e-ISBN 978-3-642-05098-5, DOI 10.1007/978-3-642-05098-5

- Wolfgang Nolting: Statistische Physik (Grundkurs Theoretische Physik Bd. 6), 5. Auflage, Springer Verlag, 2007

- Friedrich Hund: Geschichte der physikalischen Begriffe, Teil 2, B.I.-Hochschultaschenbücher 544, 2.

- Richard Becker: Theorie der Wärme. Heidelberger Taschenbücher, photomechanischer Nachdruck der ber. Auflage. Springer-Verlag, Berlin, Heidelberg, New York 1966.

- Gerd Wedler, Hans-Joachim Freund: Lehrbuch der Physikalischen Chemie. 6. Auflage. Wiley-VCH, Weinheim 2012, ISBN 978-3-527-32909-0, 4. Die statistische Theorie der Materie, 5. Transporterscheinungen, 6. Kinetik - vor allem Anwendungen in der Chemie.

- Hermann Haken: Synergetik Eine Einführung – Nichtsgleichgewichts-Phasenübergänge und Selbstorganisation in Physik, Chemie und Biologie. 2. Auflage. Springer, Berlin 1983, ISBN 3-540-12597-3 (besonders Nicht-Gleichgewichts-Prozesse, auch Beispiele aus Chemie, Biologie und stochastische Prozesse in Soziologie und Wirtschaftswissenschaften).

Einzelnachweise

- Carlo Cercignani: Boltzmanns Vermächtnis. In: Physik Journal. Band 5, 2006, S. 47—51 (online [abgerufen am 15. April 2020]).