Phonetik

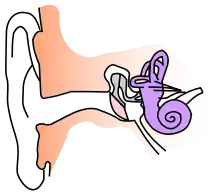

Die Phonetik (altgriechisch φωνητικός phōnētikós, deutsch ‚zum Tönen, Sprechen gehörig‘, von φωνή phōnḗ, deutsch ‚Stimme‘),[1] auch Lautlehre, ist eine wissenschaftliche Disziplin, die Sprachlaute unter den folgenden Aspekten untersucht: Lautproduktion in Kehlkopf, Rachen-, Mund- und Nasenbereich, die akustischen Eigenschaften der Laute und die Lautwahrnehmung und -verarbeitung durch Ohr und menschliches Gehirn. Die Phonetik ist ein eigenständiges interdisziplinäres Fachgebiet zwischen Linguistik, Anatomie, Physiologie, Neurologie, Physik und Mathematik. Der Gegenstandsbereich der Phonetik ist die gesprochene Sprache in all ihren Realisierungen.

Die Phonetik ist abzugrenzen von der Phonologie (als einem Teilgebiet der Sprachwissenschaft), die Sprachlaute unter einem anderen Aspekt untersucht. Die Phonologie ist Teil der Grammatik und behandelt Laute hinsichtlich der Funktion, die sie im System verschiedener Sprachen haben. Die Phonetik dagegen befasst sich mit den physikalischen, neurologischen und physiologischen Aspekten, die bei der Lautproduktion, -übertragung und -wahrnehmung relevant sind, und bedient sich dabei naturwissenschaftlicher Methoden.

Angrenzende Fächer und verwandte Fachdisziplinen

Abgrenzung zur Phonologie

Die sprachwissenschaftliche Disziplin der Phonologie ist mit der Phonetik eng verwandt. Die Phonologie klassifiziert Laute aufgrund ihrer Verteilung und Funktion in einer spezifischen Sprache. Aufgrund von Minimalpaaren wie z. B. rot und tot identifiziert die Phonologie die kleinsten bedeutungsunterscheidenden Laute einer Sprache, die Phoneme (hier: /ʀ/ und /t/). Im Gegensatz zur Phonologie untersucht die Phonetik die konkreten artikulatorischen und akustischen Merkmale der Laute aller Sprachen, d. h. sie beschäftigt sich damit, wie sprachliche Laute gebildet werden, wie sie durch das menschliche Ohr aufgenommen und im Gehirn weiterverarbeitet wird und wie man sprachliche Laute akustisch messen und beschreiben kann. Kleinste Einheit in der Phonetik ist der Laut oder das Phon, die kleinste Lauteinheit in dem Lautkontinuum der gesprochenen Sprache. Diese kleinsten Einheiten werden durch Analyse und Zerlegung von sprachlichen Äußerungen identifiziert. In der Phonetik kann dann z. B. beschrieben werden, durch welche Artikulation diese Laute erzeugt werden.[2] Einem Phonem, der abstrakten Einheit aus der Phonologie, entsprechen in einer Lautäußerung ein oder mehrere Phone. Phone, die in einer bestimmten Sprache als Varianten desselben Phonems zählen, also in der jeweiligen Sprache funktionsgleich sind, nennt man auch Allophone dieses Phonems.

Interdisziplinäres Fachgebiet

Die Phonetik ist ein interdisziplinäres Fachgebiet, das Ergebnisse und Methoden aus den Fächern Anatomie, Physiologie, Neurologie, Physik und Mathematik nutzt.[3] Für die Beschreibung der Lautbildung mit Lunge, Kehlkopf sowie Mund- und Nasenraum nutzt die Phonetik Erkenntnisse aus der Anatomie und der Physiologie, für die Beschreibung der Lautverarbeitung durch das menschliche Gehirn Ergebnisse der Neurologie. Die Physik, speziell das Teilgebiet der Akustik, ist relevant für die Beschreibung der Schallübertragung der sprachlichen Laute, ebenso wie einige Erkenntnisse aus der Mathematik, die das mathematische Gerüst zur Beschreibung von Schallwellen bietet (z. B. Fourier-Analysis).

Die Phonetik wird in vielen Publikationen als interdisziplinäres naturwissenschaftliches Fachgebiet gesehen;[3] viele Einführungen in die Sprachwissenschaft führen sie aber auch als Teilbereich der Sprachwissenschaft und behandeln sie gemeinsam mit den sprachwissenschaftlichen Disziplinen Phonologie, Morphologie und Syntax.[4]

Neben der Phonetik und Phonologie haben u. a. auch die Fächer Sprechwissenschaft, Sprecherziehung, Rhetorik, Sprechkunst, Klinische Linguistik, Logopädie und Sprachheilpädagogik gesprochene Sprache zum Inhalt.

Geschichte der Phonetik

Die Ursprünge der Phonetik gehen zurück bis in eine Periode zwischen 800 und 150 v. Chr. auf dem indischen Subkontinent, wo indische Linguisten die Phonetik des Sanskrit beschreiben.[5]

In der europäischen Antike und in der Renaissance wurden die Grundlagen für eine systematische Beschreibung der Artikulationsorgane gelegt. So hat sich bereits in der Antike der Arzt Galenus mit dem Aufbau des Kehlkopfs beschäftigt, und auch der Arzt und Naturwissenschaftler Avicenna befasste sich im 11. Jahrhundert wissenschaftlich mit der Phonetik.[6][7] Insgesamt sind im Mittelalter jedoch eher Rückschritte bezüglich der Erkenntnisse und Vorstellungen zur sprachlichen Lautproduktion und -rezeption zu verzeichnen, was sich erst in der Renaissance wieder änderte. Sogar Leonardo da Vinci kann als Vorläufer der Phonetiker genannt werden, denn seine Studien an sezierten Leichen trugen zum Wissen über den Aufbau des Kehlkopfes bei.[8][9]

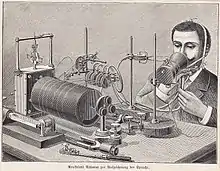

Mit dem Aufstieg der Naturwissenschaften in der Neuzeit entstanden erst die Voraussetzungen für die Phonetik als naturwissenschaftliche Disziplin, z. B. die akustische Schwingungslehre, mit der der Mathematiker Leonhard Euler gegen Ende des 18. Jahrhunderts die akustischen Eigenschaften von Vokalen genauer zu beschreiben versuchte. Im 18. Jahrhundert findet man auch die ersten Versuche, Sprache künstlich zu erzeugen. Beispielhaft sei hier Wolfgang von Kempelen genannt, der ab 1769 an einer sprechenden Maschine arbeitete.[9]

Einen Aufbruch erlebte die Phonetik im 19. Jahrhundert, als technische Apparate wie der Phonograph zur Verfügung standen, mit denen erstmals sprachliche Laute aufgezeichnet und analysiert werden konnten. Jean-Pierre Rousselot gehörte zu den Pionieren der Sprachaufzeichnung für wissenschaftliche Zwecke und kann als einer der Gründerväter der Phonetik als Wissenschaftsdisziplin genannt werden. Ludimar Hermann gelang es ferner 1889 und 1890 mit Hilfe mathematischer Prinzipien Stimm- und Lautkurven zu analysieren; er prägte auch den Begriff Formant.[10]

Gleichzeitig entwickelte sich Ende des 19. Jahrhunderts auch die Erkenntnis unter den artikulatorischen Phonetikern, dass „Sprachlaute“ ein eigenes Beschreibungssystem benötigen, weil in den meisten Sprachen keine eindeutige Beziehung zwischen Buchstaben und Lauten mehr besteht und damit die gängigen Alphabete zur Beschreibung der Laute einer Sprache nicht ausreichen. So veröffentlichte Alexander Melville Bell mit seiner Schrift Visible Speech 1867 eine phonetische Schrift, mit der er versucht, Vokale präzise zu beschreiben.[11] Diese Aktivitäten kulminierten in der Gründung der International Phonetic Association 1884 und der Veröffentlichung des ersten Internationalen Phonetischen Alphabets (IPA) 1888.[12][13]

Im deutschsprachigen Raum wurde die Phonetik erstmals 1919 als eigenständige Disziplin anerkannt, als sie als Haupt- und Nebenfach bei Promotionen an der Philosophischen Fakultät der Universität Hamburg zugelassen wurde. Eine erste planmäßige außerordentliche Professur für Phonetik in Deutschland wurde 1922 an der Hansischen Universität Hamburg eingerichtet.[14]

Weitere wichtige technische Entwicklungen für die Phonetik waren z. B. die Röntgenbildgebung und die Sonografie Anfang des 20. Jahrhunderts. Weitere Fortschritte in der Phonetik sind durch technische Entwicklungen zu erwarten. So sind in den letzten Jahren z. B. große Fortschritte in Echtzeit-MRTs gemacht worden. Damit ist es für die Phonetik einfacher möglich, akustische Signale und physiologische Vorgänge bei der Lauterzeugung zu analysieren.

Teilbereiche der Phonetik

Hauptarbeitsgebiete

Die allgemeine Phonetik beschäftigt sich mit den bei konkreten Sprechakten physikalisch ablaufenden Prozessen sowie deren messtechnischer Erfassung. Sie hat die folgenden Teilgebiete:

- Die artikulatorische Phonetik ist die Lehre des Aufbaus und der Funktion des Sprechapparats sowie dessen Einsatz bei der Produktion von Sprache.

- Die akustische Phonetik untersucht die physikalische Struktur der Schallwellen als Träger der sprachlichen Laute.

- Die auditive oder perzeptive Phonetik befasst sich mit der Wahrnehmung der sprachlichen Laute durch den Hörer und der jeweiligen Rolle des Gehörs und des Gehirns

Ferner gibt es das Arbeitsgebiet der systematischen Phonetik, die sich um die systematische Beschreibung der Laute (Phone) der Sprachen der Welt bemüht, einschließlich der Beschreibung der Konsonanten und Vokale aller menschlichen Sprachen und deren Transkription in eine Lautschrift. Zur systematischen Phonetik zählt auch die Beschreibung der suprasegmentalen Phonetik (Prosodie), d. h. die Beschreibung einzelner Laute und deren Verwendung in der Silbe bzw. im Wort.

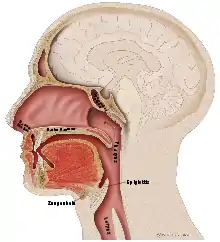

Artikulatorische Phonetik

Die artikulatorische Phonetik befasst sich mit dem Zusammenspiel von Atmung (Erzeugung des notwendigen Luftdrucks in der Lunge), der Phonation im Kehlkopf und der Artikulation im Rachen-, Mund- und Nasenraum (dem Vokaltrakt). Durch die Atmung wird in der Lunge der für den Schall notwendige Luftdruck erzeugt. Im Kehlkopf sitzen die Stimmlippen, die die Schwingungen in der Luft erzeugen, die für den Klang verantwortlich sind. Schließlich wirkt der Rachen-, Mund- und Nasenraum je nach Stellung von z. B. Gaumen oder Zunge als Filter, der den Klang weiter modifiziert.[15]

Die artikulatorische Phonetik interessiert sich insbesondere für die Rolle und Position der beweglichen Teile in Kehlkopf und Mundraum, also Zunge, Lippen, Unterkiefer, Gaumensegel (Velum) mit dem Zäpfchen (Uvula), Rachen und Glottis. Je nach Position dieser Artikulationsorgane werden unterschiedliche sprachliche Laute erzeugt. Die Phonetik spricht von verschiedenen Artikulationsstellen oder -orten, wenn sie die Orte beschreibt, an denen (Teile der) Zunge und/oder die Lippen sich befinden, wenn Konsonanten erzeugt werden. So spricht man z. B. bei den Lauten [b] oder [m] von bilabialen Lauten, weil hier die Ober- und Unterlippe bei der Lautbildung hauptsächlich beteiligt sind. Bei anderen Konsonanten wie z. B. [d] oder [g] spielt die Position der Zunge eine Rolle (dental, hinter den Oberkieferzähnen, oder velar, beim Gaumensegel).

Die artikulatorische Phonetik verfügt über verschiedene experimentelle Untersuchungstechniken, um das Kehlkopfverhalten und das Verhalten der Artikulatoren zu erfassen. Für den Kehlkopf verwendet man Kehlkopfspiegel (Laryngoskop), Laryngographen und Photoelektroglottographie. Zur Erfassung der artikulatorischen Geometrie verwendet man die Palatographie, Röntgenbilder, elektromagnetische Artikulographie, Ultraschallvermessung (Sonografie) und Magnetresonanztomographie bzw. Echtzeit-Magnetresonanztomographie.[16]

Akustische Phonetik

Die akustische Phonetik befasst sich mit der Beschreibung der sprachlichen Laute als Schallschwingungen, wie sie von Sprecher zum Hörer übertragen werden. Der Untersuchungsbereich der akustischen Phonetik befindet sich damit in dem Bereich nach der Artikulation durch den Sprecher und vor der Signalaufnahme durch das Ohr des Hörers.[17] Die Grundlagen der akustischen Phonetik stammen aus einem Teilbereich der Physik, der Akustik. Die akustische Phonetik beschreibt die Erzeugung und Übertragung der Schallschwingungen, die durch sprachliche Laute erzeugt werden. Unter Schall versteht man minimale Luftdruckschwankungen, die hörbar sind. Sprachliche Laute gehören zu einem speziellen Typ von Schallschwingungen, nämlich den Klängen. Im Gegensatz zu reinen Tönen (z. B. aus der Musik) sind Klänge zusammengesetzte Schallschwingungen. Im Gegensatz zu Geräuschen sind Klänge periodische Schallschwingungen. In der Akustik werden Klänge (also auch sprachliche Laute) als Sinoidalschwingungen beschrieben.[18]

Genauer gesagt sind sprachliche Laute zusammengesetzte Schwingungen, die in einzelne Sinoidalschwingungen zerlegbar sind. Bei einer solchen Zerlegung werden die Amplituden der einzelnen Teilschwingungen ermittelt. So erhält man ein Schallspektrum, und das Verfahren, das hierfür verwendet wird, nennt man Frequenzanalyse oder Fourier-Analyse (nach dem französischen Mathematiker Jean Baptiste Joseph Fourier).[19] Die Ergebnisse der Akustik sind für die Phonetik relevant, weil während der Sprachlautproduktion Schallwellen erzeugt werden, die vom Kehlkopf über den Rachen-, Mund- und Nasenraum wandern. Diese Schallwellen lassen sich mit den Mitteln der Akustik messen und beschreiben.

Die akustische Phonetik verwendet verschiedene Darstellungsformen, um die Akustik der sprachlichen Äußerungen sichtbar zu machen. Eine wichtige Darstellungsform ist das Oszillogramm, das die Schallschwingungen als Graph entlang einer Zeitachse darstellt. Das Oszillogramm gibt den tatsächlichen Schwingungsvorgang des Schalls wieder, misst also die Schwingung der Luftteilchen während der Schallwellenübertragung.[20]

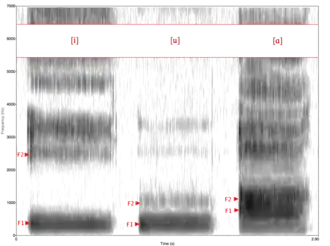

Häufig will man nicht nur die reinen Schallschwingungen darstellen, sondern man will gleichzeitig zeigen, welche Frequenzen und Amplituden die Schallwellen einer sprachlichen Äußerung haben und wie sie sich über die Zeit verändern. Dies gelingt, wenn man die akustische Information der Schallschwingungen mittels mathematischer Methoden in ein Spektrogramm oder Sonagramm umwandelt, eine bildliche Darstellung des Frequenzspektrums eines Signals. Im Sonagramm ist der Zeitverlauf auf der x-Achse (von links nach rechts), während die Frequenz auf der y-Achse (von unten nach oben) dargestellt wird. Die Amplitude der Schallwellen wird durch verschiedene Grauschattierungen dargestellt: je dunkler ein Bereich, desto größer die Amplitude.[21] Die Balken in eine Sonagramm, die einen stärkeren Schwärzungsgrad aufweisen, stellen die Frequenzbänder mit einer höheren Energie dar, die sogenannten Formanten. Im Sonagramm sind die Formanten die grafische Repräsentation des Vokalschalls.[22]

Ein wichtiger Schwerpunkt der akustischen Phonetik ist die Beschreibung und Analyse von Lautäußerungen mittels Spektrogrammen und Sonagrammen. Weitere Themen im Bereich der akustischen Phonetik, die vor allem durch den zunehmenden Einsatz von Computern möglich sind, sind automatische Spracherkennung und Sprachsynthese.[23]

Auditive oder perzeptive Phonetik

Die auditive oder perzeptive Phonetik befasst sich mit der Aufnahme und Verarbeitung sprachlicher Laute im Gehörorgan und im auditiven Nervensystem.

Die Schallwellen sprachlicher Laute werden über das äußere Ohr und das Mittelohr in das Innenohr geleitet, wo das eigentliche Hörorgan, das Corti-Organ sitzt. Die Frage, wie die Sprache im Ohr und im menschlichen Gehirn verarbeitet wird, ist Teil verschiedener Hörtheorien, darunter die Resonanzhypothese und die Wanderwellentheorie von Georg von Békésy.

Ein wichtiges Untersuchungsgebiet der auditiven Phonetik ist der Zusammenhang zwischen der subjektiven Wahrnehmung der sprachlichen Laute und der physikalisch messbaren Parameter des akustischen Signals, etwa der Lautstärke und des messbaren Schalldruckpegels (in Dezibel, dB) sowie der Tonhöhe. Bahnbrechend für die perzeptive Phonetik waren die Forschungen zur auditiven Sprachwahrnehmung z. B. durch die Bell Laboratories Mitte des 20. Jahrhunderts, die feststellen wollten, wie stark das Sprachsignal reduziert werden kann, ohne dass es unverständlich wird, um damit die Kapazität der Telefonleitungen besser ausschöpfen zu können.[24]

Ein wichtiges Ergebnis zur auditiven Sprachwahrnehmung aus der Phonetik ist neben anderen die Erkenntnis, dass eine sprachliche Äußerung aus einem kontinuierlichen akustischen Signal besteht. In den Anfängen der Phonetik hatte man die Erwartung, dass sich in den Messungen sprachlicher Äußerungen eindeutig abgrenzbare Segmente (Vokale, Konsonanten) identifizieren und auch synthetisch erzeugen lassen. Wie sich aber mit den Experimenten des Pattern-Playback-Synthetisator der Haskins-Laboratorien herausstellte, war dies zwar für Vokale möglich, aber nicht für Konsonanten. Aus Experimenten zur Sprachwahrnehmung stammt die Erkenntnis, dass Menschen sprachlichen Input in klar abgegrenzte Kategorien unterteilen: Variiert man den sprachlichen Input leicht (z. B. von [bæ] über [dæ] nach [gæ]), so nehmen Probanden vor allem drei Kategorien wahr (kategoriale Wahrnehmung). Nimmt man musikalische Töne oder Geräusche als Input, so können Probanden wesentlich mehr feine Unterschiede benennen (kontinuierliche Wahrnehmung). Aus diesem und anderen Experimenten entwickelten die Forscher der Haskins-Laboratorien ihre Motor-Theorie der Sprachwahrnehmung.[25][26]

Weitere mögliche Klassifikationen der Teilbereiche der Phonetik

Wenn man phonetische Teilbereiche nach ihrem methodischen Zugang klassifiziert, kann man sie wie folgt unterscheiden:[27]

- Deskriptive Phonetik: Beschreibung und Analyse von Lauten durch Verwendung des Gehörs („Ohrenphonetik“)

- Symbolphonetik: Darstellung des Gehörten mit dem Internationalen Phonetischen Alphabet (IPA)

- Instrumental- oder Signalphonetik: Erforschung sprachlicher Laute mittels mechanischer und elektronischer Geräte

- Experimentalphonetik: Erforschung des Zusammenhangs zwischen einer lautlichen Äußerung und der Wahrnehmung von Versuchspersonen im Experiment

Phonetik der Einzelsprachen

Neben der Beschreibung und Messung der Vorgänge bei der Spracherzeugung und Sprachwahrnehmung trägt die Phonetik dazu bei, das Lautinventar von Einzelsprachen zu erfassen. Die Laute oder Phone einer Sprache werden zunächst durch Beobachtungen des Phonetikers identifiziert und anschließend systematisch beschrieben: Konsonanten werden auf der Basis ihrer Artikulationsart und der Artikulationsstelle beschrieben und klassifiziert, Vokale aufgrund der Zungenposition und der Mundrundung.[28] Beispielsweise findet man unter den Konsonanten des Deutschen die Nasallaute [m], [n] und [ŋ] (wie in den Wörtern Damm, dann und Drang). Diese werden bilabial (mit beiden Lippen), alveolar (mit der Zunge am oberen Zahndamm hinter den oberen Schneidezähnen) bzw. velar (am Gaumensegel) artikuliert. Im Französischen dagegen findet man neben [m] und [n] (wie in pomme, panne) auch noch den palatalen Nasal [ɲ] (wie in pagne).[29]

Die Sprachen der Welt machen von den potentiell möglichen Phonen unterschiedlich Gebrauch. So findet man Sprachen, deren Lautinventar eine geringe Zahl von Vokalen oder Konsonanten umfasst, wie die Papuasprache Rotokas mit ihren lediglich sechs Konsonanten und fünf Vokalen. Ein anderes Extrem ist die südafrikanische Khoisansprache !Xũ, die insgesamt 141 Phoneme hat, darunter eine große Zahl von Konsonanten, Klicks und Diphthongen.[30]

Phone werden durch eine Lautschrift schriftlich dargestellt, wobei das Internationale Phonetische Alphabet (IPA) als der Standard hierfür gilt.

Die Phonetik vieler Einzelsprachen ist gut erforscht; einen Überblick über die Lautsysteme der Sprachen der Welt geben die Linguisten Peter Ladefoged und Ian Maddieson mit ihrem Buch The Sounds of the World’s Languages.[31] Für viele europäische Sprachen sind Einführungen in ihre Phonetik verfügbar, so z. B. für das Deutsche, Englische oder Französische.[32][33][34] Ein Meilenstein für die Beschreibung der englischen Sprache ist das Buch An Outline of English Phonetics des Phonetikers Daniel Jones von 1922.[35]

Angewandte Phonetik

Die Ergebnisse der allgemeinen und systematischen Phonetik fließen in Teilbereiche der angewandten Phonetik ein, z. B. in die forensische Phonetik oder die klinische Phonetik, und auch in die Spracherwerbsforschung.

In der forensischen Phonetik kommt phonetisches Wissen für die Untersuchung von sprechertypischen Stimm- und Sprecheigenschaften zum Einsatz, z. B. mit forensischen Fragestellungen im Bereich der Kriminalistik bzw. Kriminaltechnik oder beim Verfassen von forensischen Gerichtsgutachten. So sind Erkenntnisse aus der Phonetik das Fundament für forensische Gutachter, die vor Gericht etwa darüber entscheiden sollen, ob ein Angeklagter der Sprecher auf einer Audioaufzeichnung ist. Dabei kommen Methoden wie das einfache Anhören der Aufnahme durch den Gutachter bis hin zu technischen Analysen etwa mittels eines Spektrographen zum Einsatz.[36]

Die klinische Phonetik ist ein anwendungsorientiertes Teilgebiet der sprachwissenschaftlichen Disziplin Phonetik. Sie beschäftigt sich mit der Symptombeschreibung und Diagnostik von Sprech-, Sprach- und Stimmstörungen bei Erwachsenen und Störungen des Spracherwerbs bzw. der Sprachentwicklung bei Kindern. Die klinische Phonetik begann sich Ende der 1970er Jahre als eigenständige Disziplin zu etablieren; grundlegend für die Disziplin war die Publikation von David Crystals Buch Clinical Linguistics 1981.[37] Ziele der klinischen Phonetik sind unter anderem die Anwendung von Erkenntnissen aus der Phonetik, um Sprach- und Sprechstörungen bei Patienten zu behandeln, und die Integration klinischer Ergebnisse in linguistische Theorie. Auch befasst sie sich mit der Erweiterung des Internationalen Phonetischen Alphabets (IPA) um Transkriptionsmethoden, die die Sprache sprachgestörter Individuen angemessener wiedergibt.[38]

Phonetische Grundlagen sind auch relevant für die Spracherwerbsforschung, die den Erwerb der Sprechfertigkeit und individuelle Lautentwicklung beim (vor allem gesunden) Kind untersucht. Phonetisches Grundwissen fließt ferner in die Orthoepie ein, die Lehre von bzw. die Regelung der normierten Standardlautung einer Sprache, die frei von regionalen Einflüssen sein soll (Standardaussprache).

Das Deseret-Alphabet, das Shaw-Alphabet und das Simpel-Fonetik-Alphabet sind Beispiele für Schreibsysteme, mit denen die englischen Sprache rein phonemisch nach der Aussprache geschrieben werden kann. Entsprechend wurden für das Standardchinesische unter anderen Pinyin, Bopomofo und Gwoyeu Romatzyh entwickelt, und auch für weitere Sprachen existieren ähnliche Systeme.

Literatur

Einführungen und Nachschlagewerke

- J. C. Catford: A Practical Introduction to Phonetics. Oxford University Press, Oxford 1988, ISBN 0-19-824217-4.

- John Laver: Principles of Phonetics. Cambridge University Press, Cambridge 1994, ISBN 0-521-45655-X.

- Bernd Pompino-Marschall: Einführung in die Phonetik. 3. Auflage. Walter de Gruyter, Berlin 2009, ISBN 3-11-022480-1.

- Henning Reetz, Allard Jongman: Phonetics. Transcription, Production, Acoustics, and Perception.Wiley-Blackwell, Oxford 2008, ISBN 978-0-631-23226-1.

- R. L. Trask: A Dictionary of Phonetics and Phonology. Routledge, London/ New York 1996, ISBN 0-415-11261-3.

- Richard Wiese: Phonetik und Phonologie. UTB, Tübingen 2010, ISBN 978-3-8252-3354-9.

Artikulatorische, akustische und auditive Phonetik

- Fabian Bross: Grundzüge der Akustischen Phonetik. In: Helikon. A Multidisciplinary Online Journal. Nr. 1, 2010, S. 89–104 (Online; PDF; 1,3 MB).

- Bryan Gick, Ian Wilson, Donald Derrick: Articulatory Phonetics. Wiley-Blackwell, Oxford 2013, ISBN 978-1-4051-9321-4.

- Keith Johnson: Acoustic and Auditory Phonetics. 3. Auflage. Wiley-Blackwell, Oxford 2012, ISBN 978-1-4051-9466-2.

- Peter Ladefoged: Elements of Acoustic Phonetics. Chicago 1996, ISBN 0-226-46764-3.

- Peter Ladefoged, Ian Maddieson: The Sounds of the World’s Languages. Wiley-Blackwell, Oxford 1996, ISBN 0-631-19814-8.

- Joachim M.H. Neppert: Elemente einer Akustischen Phonetik. 4. Auflage. Hamburg 1999, ISBN 3-87548-154-2.

- Henning Reetz: Artikulatorische und Akustische Phonetik. Trier 2003, ISBN 3-88476-617-1.

Phonetik von Einzelsprachen

- Thomas Becker: Einführung in die Phonetik und Phonologie des Deutschen. Wissenschaftliche Buchgesellschaft, Darmstadt 2012, ISBN 978-3-534-24949-7.

- Paul Carley, Inger Margrethe Mees, Beverley Collins: English phonetics and pronunciation practice. Routledge, London 2018, ISBN 978-1-138-88634-6.

- Elissa Pustka: Einführung in die Phonetik und Phonologie des Französischen. 2. Auflage. Erich Schmidt Verlag, Berlin 2016, ISBN 978-3-503-16631-2.

Weblinks

- Website der International Phonetic Association (IPA), letzter Zugriff am 23. Mai 2018.

- Interaktiver Phonetik-Kurs, letzter Zugriff am 23. Mai 2018.

- Online-Phonetik-Kurs Französisch und Englisch, letzter Zugriff am 23. Mai 2018.

- Phonetics resources, umfangreiche Sammlung weiterführender Links (englisch), letzter Zugriff am 23. Mai 2018.

- Christian Lehmann: Auditive Phonetik, letzter Zugriff am 23. Mai 2018.

Einzelnachweise

- Etymologie nach Wahrig, Deutsches Wörterbuch, Stichwort: Phonetik

- Bernd Pompino-Marschall: Einführung in die Phonetik. 3. Auflage. Walter de Gruyter, Berlin 2009, ISBN 3-11-022480-1, S. 178.

- Hadumod Bußmann: Lexikon der Sprachwissenschaft (= Kröners Taschenausgabe. Band 452). Kröner, Stuttgart 1983, ISBN 3-520-45201-4, S. 385.

- William O’Grady, Michael Dobrovolsky, Francis Katamba: Contemporary Linguistics. An Introduction. 4. Auflage. Longman, London/New York 1997, ISBN 0-582-24691-1, S. 18 (englisch).

- R. H. Robins: A Short History of Linguistics. 4. Auflage. Longman, London/New York 1997, ISBN 0-582-24994-5, S. 175 (englisch).

- I. Ormos: Observations on Avicenna’s Treatise on Phonetics. In: Acta Orientalia Academiae Scientiarum Hungaricae. Band 39, 1985, S. 45–84.

- I. Ormos: A key factor in Avicenna’s theory of phonation. In: Acta Orientalia Academiae Scientiarum Hungaricae. Band 40, 1986, S. 283–292.

- Giulio Panconcelli-Calzia: Geschichtszahlen der Phonetik. Quellenatlas der Phonetik. Benjamins, Amsterdam/Philadelphia 1994, ISBN 90-272-0957-X, S. 18.

- Bernd Pompino-Marschall: Einführung in die Phonetik. 3. Auflage. Walter de Gruyter, Berlin/New York 2009, ISBN 978-3-11-022480-1, S. 5–6.

- Giulio Panconcelli-Calzia: Geschichtszahlen der Phonetik. Quellenatlas der Phonetik. Benjamins, Amsterdam/Philadelphia 1994, ISBN 90-272-0957-X, S. 60.

- Giulio Panconcelli-Calzia: Geschichtszahlen der Phonetik. Quellenatlas der Phonetik. Benjamins, Amsterdam/Philadelphia 1994, ISBN 90-272-0957-X, S. 54.

- David Crystal: The Cambridge Encyclopedia of Language. 2. Auflage. Cambridge University Press, Cambridge 1997, ISBN 0-521-55967-7, S. 160–161 (englisch).

- Bernd Pompino-Marschall: Einführung in die Phonetik. 3. Auflage. Walter de Gruyter, Berlin/New York 2009, ISBN 978-3-11-022480-1, S. 6–7.

- Giulio Panconcelli-Calzia: Geschichtszahlen der Phonetik. Quellenatlas der Phonetik. Benjamins, Amsterdam/Philadelphia 1994, ISBN 90-272-0957-X, S. 77–78.

- Bernd Pompino-Marschall: Einführung in die Phonetik. 3. Auflage. Walter de Gruyter, Berlin/New York 2009, ISBN 978-3-11-022480-1, S. 18.

- Bernd Pompino-Marschall: Einführung in die Phonetik. 3. Auflage. Walter de Gruyter, Berlin/New York 2009, ISBN 978-3-11-022480-1, S. 78–85.

- Fabian Bross: Grundzüge der Akustischen Phonetik. In: Helikon. A Multidisciplinary Online Journal. Nr. 1, 2010, S. 89. (Online; PDF; 1,3 MB)

- Bernd Pompino-Marschall: Einführung in die Phonetik. 3. Auflage. Walter de Gruyter, Berlin/New York 2009, ISBN 978-3-11-022480-1, S. 87–91.

- Fabian Bross: Grundzüge der Akustischen Phonetik. In: Helikon. A Multidisciplinary Online Journal. Nr. 1, 2010, S. 94–95. (Online; PDF; 1,3 MB)

- Joachim M.H. Neppert: Elemente einer Akustischen Phonetik. 4. Auflage. Hamburg 1999, ISBN 3-87548-154-2, S. 98.

- Henning Reetz, Allard Jongman: Phonetics. Transcription, Production, Acoustics, and Perception. Wiley-Blackwell, Oxford 2009, ISBN 978-0-631-23226-1, S. 155–156 (englisch).

- Bernd Pompino-Marschall: Einführung in die Phonetik. 3. Auflage. Walter de Gruyter, Berlin/New York 2009, ISBN 978-3-11-022480-1, S. 108.

- Bernd Pompino-Marschall: Einführung in die Phonetik. 3. Auflage. Walter de Gruyter, Berlin/New York 2009, ISBN 978-3-11-022480-1, S. 108–109, 132.

- Bernd Pompino-Marschall: Einführung in die Phonetik. 3. Auflage. Walter de Gruyter, Berlin/New York 2009, ISBN 978-3-11-022480-1, S. 145–147, 153–158.

- Bernd Pompino-Marschall: Einführung in die Phonetik. 3. Auflage. Walter de Gruyter, Berlin/New York 2009, ISBN 978-3-11-022480-1, S. 160–171.

- Henning Reetz, Allard Jongman: Phonetics. Transcription, Production, Acoustics, and Perception. Wiley-Blackwell, Oxford 2009, ISBN 978-0-631-23226-1, S. 263–273 (englisch).

- Bernd Pompino-Marschall: Einführung in die Phonetik. 3. Auflage. Walter de Gruyter, Berlin/New York 2009, ISBN 978-3-11-022480-1, S. 2–3.

- Bernd Pompino-Marschall: Einführung in die Phonetik. 3. Auflage. Walter de Gruyter, Berlin 2009, ISBN 3-11-022480-1, S. 177–183, 221.

- Bernd Pompino-Marschall: Einführung in die Phonetik. 3. Auflage. Walter de Gruyter, Berlin 2009, ISBN 3-11-022480-1, S. 193.

- Bernd Pompino-Marschall: Einführung in die Phonetik. 3. Auflage. Walter de Gruyter, Berlin 2009, ISBN 3-11-022480-1, S. 257–260.

- Peter Ladefoged, Ian Maddieson: The Sounds of the World’s Languages. Wiley-Blackwell, Oxford 1996, ISBN 0-631-19814-8.

- Thomas Becker: Einführung in die Phonetik und Phonologie des Deutschen. Wissenschaftliche Buchgesellschaft, Darmstadt 2012, ISBN 978-3-534-24949-7.

- Paul Carley, Inger Margrethe Mees, Beverley Collins: English phonetics and pronunciation practice. Routledge, London 2018, ISBN 978-1-138-88634-6.

- Elissa Pustka: Einführung in die Phonetik und Phonologie des Französischen. 2. Auflage. Erich Schmidt Verlag, Berlin 2016, ISBN 978-3-503-16631-2.

- Daniel Jones: An Outline of English Phonetics. Teubner, Leipzig/Berlin 1922.

- Geoffrey Stewart Morrison, Ewald Enzinger: Introduction to forensic voice comparison. In: William F. Katz, Peter F. Assmann (Hrsg.): The Routledge Handbook of Phonetics. Routledge, London/New York 2019, ISBN 978-1-138-64833-3, S. 599–634.

- David Crystal: Clinical Linguistics (= Disorders of Human Communication, Bd. 3). Springer, Wien u. a. 1981, ISBN 3-211-81622-4.

- William F. Katz: New horizons in clinical phonetics. In: William F. Katz, Peter F. Assmann (Hrsg.): The Routledge Handbook of Phonetics. Routledge, London/New York 2019, ISBN 978-1-138-64833-3, S. 527.