Abhängige und unabhängige Variable

In der Mathematik ist eine abhängige Variable eine Variable, deren Wert vom Effekt (einer) anderer(en) Variable(n) abhängt. Die Variable(n), mit deren Hilfe versucht wird, die abhängige Variable zu modellieren, wird/werden als unabhängige Variable(n) im untersuchten Zusammenhang bezeichnet. Die abhängige Variable ist eine Art „Antwortvariable“, deren Variation man durch den Einfluss unabhängiger Variablen versucht zu erklären.[1]

In der Statistik, und dort insbesondere in der Regressionsanalyse, ist die abhängige Variable diejenige Variable, die durch eine Regressionsgleichung vorhergesagt wird. In der Statistik wird die abhängige Variable auch Regressand und die unabhängige Variable auch Regressor genannt.

Mathematik

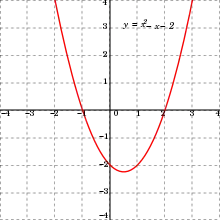

In der Mathematik ist eine Funktion eine Beziehung zwischen zwei Mengen, die jedem Element der einen Menge (Funktionsargument, unabhängige Variable, -Wert) genau ein Element der anderen Menge (Funktionswert, abhängige Variable, -Wert) zuordnet. Ein Symbol, das für eine beliebige Eingangsvariable steht, wird als unabhängige Variable bezeichnet, während ein Symbol, das für eine beliebige Ausgabevariable steht, als abhängige Variable bezeichnet wird.[2] Das häufigste Symbol für die Eingangsvariable ist , und das häufigste Symbol für die Ausgabevariable ist ; Die Funktion selbst wird üblicherweise geschrieben als .

Es ist möglich mehrfache unabhängige Variablen und mehrfache abhängige Variable zu modellieren. Beispielsweise trifft man in der mehrdimensionalen Differential- und Integralrechnung oft auf Funktionen der Art , wobei die abhängige Variable und und die unabhängigen Variablen darstellen.[3] Funktionen mit mehreren Ausgangsvariablen werden oft vektorwertige Funktionen genannt.

Statistik

In der Regressionsanalyse geht man oft von einer zweidimensionalen Stichprobe mit den Wertepaaren aus. Diese werden die durch Beobachtung der Variablen und an Untersuchungseinheiten gewonnen. Um zu verdeutlichen, dass die beobachtete Streuung der Werte von (zumindest teilweise) durch die Streuung von erklärt werden soll, wird für in der Statistik statt der Bezeichnung „unabhängige Variable“ die Bezeichnung Einflussgröße oder Regressor und für statt der Bezeichnung „abhängige Variable“ die Bezeichnung Zielgröße oder Regressand verwendet.[4] Im statistischen Sinne sind Zielgrößen Merkmale über deren Verteilung in einer Grundgesamtheit Aussagen zu treffen sind, die also das Ziel der Untersuchung sind. Einflussgrößen sind andere Merkmale, die an den Merkmalsträgern auftreten, die die Ausprägungen der Zielgrößen beeinflussen und die in einem funktionalen Zusammenhang zu ihr stehen.[5]

In der linearen Einfachregression geht man davon aus, dass sich die Zielgröße lediglich durch eine einzige Einflussgröße erklären lässt. Dieser Zusammenhang wird durch eine unbekannte additive Störgröße überlagert. Dies führt zur folgenden Regressionsgleichung:

- .

In der linearen Einfachregression gilt es den Achsenabschnitt , die Steigung und die Varianz der Störgrößen zu schätzen. Wird der Regressand durch mehrere Regressoren erklärt spricht man von einer multiplen linearen Regression. Abhängigkeiten zwischen den Regressoren (Multikollinearität) oder den Störgrößen (Autokorrelation) führen zu Ineffizienzen von Methoden, die zur Bestimmung des Einflusses von Regressoren herangezogen werden. Die Vollständigkeitsannahme fordert, dass alle relevanten erklärenden Variablen (siehe #Statistische Bezeichnungen und Konzepte) im Modell enthalten sind.

Für gewöhnlich werden die Regressoren innerhalb der Regressionsfunktion als nichtstochastisch angenommen, d. h. ihre Werte liegen als bereits realisierte, feste Zahlenwerte vor. Liegen stochastische Regressoren vor, dann spricht man von einer Regression mit stochastischen Regressoren.

Statistische Bezeichnungen und Konzepte

Je nach Kontext gibt es in der Statistik eine Vielzahl von unterschiedlichen Bezeichnungen für „abhängige und unabhängige Variable“, die jedoch nicht immer Synonym zueinander verwendet werden können. Beispielsweise werden oft die Bezeichnungen erklärte Variable und erklärende Variable synonym zu abhängige Variable und unabhängige Variable verwendet. In anderen Kontexten wird die Bezeichnung erklärende Variable genauer nur für diejenigen Variablen verwendet, die den Zusammenhang oder das untersuchte Ergebnis kausal erklären (die also nicht lediglich korreliert sind).[6] Von manchen Autoren wird erklärte Variable gegenüber abhängiger Variable bevorzugt, da sich das „abhängig“ in der Bezeichnung „abhängige Variable“ nicht auf den statistischen Begriff der Unabhängigkeit zwischen Zufallsvariablen bezieht.[7]

In ökonometrischen Modellen bezeichnet analog zur unabhängigen Variablen eine exogene Variable eine Variable, die außerhalb des Modells bestimmt wird und den Eingang in ein Modell darstellt. Dagen werden endogene Variablen innerhalb des Modells determiniert und stellen somit den Ausstoß eines Modells dar.[8] Im engeren Sinne werden auch erklärende Variablen, die nicht mit der Störgröße einer Regressionsfunktion korreliert sind, als exogene Variablen bezeichnet.[9] Weiterhin kann man unterscheiden in exogene und endogene erklärende Variablen und verzögerte exogene und endogene Variablen.

Weitgehend synonym zu unabhängige Variable wird auch die Bezeichnung Kovariable (gelegentlich auch Kovariate genannt) verwendet, obwohl Kovariable eine zusätzliche Bedeutungsebene hat. Eine Kovariable ist eine Variable, die möglicherweise das untersuchte Ergebnis vorhersagt. Sie kann für die Untersuchung von direktem Interesse sein, oder aber ein Störfaktor oder ein Effektmodifikator.[10] Andere Kovariablen können für jeden der unterschiedlichen Antwortvariablenwerte unterschiedliche Werte annehmen – ein Beispiel wäre das Alter; diese Kovariablen werden manchmal als zeitabhängige Kovariablen (englisch time-varying covariates) bezeichnet.[11]

Auch synonym zu abhängige Variable und unabhängige Variable werden die Bezeichnungen Antwortvariable und Kontrollvariable verwendet.[12] Diese Bezeichnungen findet man hauptsächlich in den experimentellen Wissenschaften verwendet, bei denen die x-Variable unter der Kontrolle des Experimentators steht.[13] Je nach möglichen Ausprägungen der Antwortvariablen spricht man auch von einer binären oder multinomialen Antwortvariablen. Diese Arten von Variablen finden Verwendung in binären Regressionsmodellen oder beispielsweise bei der multinomialen logistischen Regression. Je nach Skalenniveau spricht man auch von einer nominalen Antwortvariablen oder ordinalen Antwortvariablen.

Die Begriffe vorhergesagte Variable und Prädiktorvariable (Plural: Prädiktorvariablen oder Prädiktoren) oder kurz Prädiktor sind meist auf Anwendungen beschränkt, bei denen es ausschließlich um Vorhersage und nicht um Kausalität geht.[14] Eine Linearkombination einer Reihe von Prädiktoren wird auch linearer Prädiktor genannt.

Weiterhin unterschieden werden relevante Variablen oder irrelevante Variablen. Hierbei ist eine relevante Variable eine Variable, die einen von null verschiedenen partiellen (wahren) Effekt auf die Antwortvariable aufweist, also eine Variable die im wahren Modell Einfluss auf die Antwortvariable hat. Eine irrelevante Variable bzw. irrelevanter Regressor hat keinen von null verschiedenen partiellen (wahren) Effekt auf die Antwortvariable. Wenn eine oder mehrere relevante Variable(n) nicht berücksichtigt wird (werden) besteht die Gefahr der Verzerrung durch ausgelassene Variablen. Die Variablen für die man eigentlich kontrollieren will, die aber bei der Schätzung eines Regressionsmodells ausgelassen wurden, werden ausgelasssene Variablen genannt.

Beispiele

- Wirkung von Dünger auf das Pflanzenwachstum:

- In agrarwissenschaftlichen Feldversuchen wird der Einfluss verschiedener Düngemittel auf das Wachstum von Nutzpflanzen gemessen. In diesem Fall wäre die unabhängige Variable das verwendete Düngemittel und die abhängige Variable wäre das Wachstum oder der Ertrag der Nutzpflanze.

- Einfluss der Medikamentendosis auf die Schwere der Symptome:

- In einer Studie darüber, wie unterschiedliche Dosen eines Arzneimittels die Schwere der Symptome beeinflussen, könnte ein Forscher die Häufigkeit und Intensität von Symptomen vergleichen, wenn unterschiedliche Dosen verabreicht werden. Hier ist die unabhängige Variable die Dosis und die abhängige Variable ist die Häufigkeit/ Intensität der Symptome.

- Wirkung von Zucker in einem Kaffee:

- Der Geschmack variiert mit der Zuckermenge, die dem Kaffee zugesetzt wird. Hier ist der Zucker die unabhängige Variable, während der Geschmack die abhängige Variable ist.

Siehe auch

Einzelnachweise

- John M. Last: A Dictionary of Epidemiology., 4. Auflage, 2001 International Epidemiological Association, Oxford UP 2001, S. 50.

- Stewart, James. Calculus. Cengage Learning, 2011. Section 1.1

- Ron Larson, Bruce Edwards: Calculus. Cengage Learning, 2009. Section 13.1

- Werner Timischl: Angewandte Statistik. Eine Einführung für Biologen und Mediziner. 3. Auflage. 2013, S. 310.

- Jürgen Hedderich: Angewandte Statistik: Methodensammlung mit R. 8., überarb. und erg. Auflage. Springer Spektrum, Berlin/ Heidelberg 2018, ISBN 978-3-662-56657-2, S. 23.

- John M. Last: A Dictionary of Epidemiology., 4. Auflage, 2001 International Epidemiological Association, Oxford UP 2001, S. 66.

- Jeffrey Marc Wooldridge: Introductory econometrics: A modern approach. 4. Auflage. Nelson Education, 2015, S. 23.

- Jeffrey Marc Wooldridge: Introductory econometrics: A modern approach. 5. Auflage. Nelson Education, 2013, S. 848.

- Jeffrey Marc Wooldridge: Introductory econometrics: A modern approach. 5. Auflage. Nelson Education, 2013, S. 848.

- John M. Last: A Dictionary of Epidemiology., 4. Auflage, 2001 International Epidemiological Association, Oxford UP 2001, S. 42.

- Brian Everitt, Torsten Hothorn: An introduction to applied multivariate analysis with R Springer Science & Business Media, 2011, S. 232.

- Jeffrey Marc Wooldridge: Introductory econometrics: A modern approach. 4. Auflage. Nelson Education, 2015, S. 23.

- Jeffrey Marc Wooldridge: Introductory econometrics: A modern approach. 4. Auflage. Nelson Education, 2015, S. 23.

- Jeffrey Marc Wooldridge: Introductory econometrics: A modern approach. 4. Auflage. Nelson Education, 2015, S. 23.