Störgröße und Residuum

In der Statistik sind Störgröße und Residuum zwei eng verwandte Konzepte. Die Störgrößen (nicht zu verwechseln mit Störparametern oder Störfaktoren), auch Störvariablen, Störterme, Fehlerterme oder kurz Fehler genannt, sind in einer einfachen oder multiplen Regressionsgleichung unbeobachtbare Zufallsvariablen, die den vertikalen Abstand zwischen Beobachtungspunkt und wahrer Gerade (Regressionsfunktion der Grundgesamtheit) messen. Für sie nimmt man für gewöhnlich an, dass sie unkorreliert sind, einen Erwartungswert von Null und eine homogene Varianz aufweisen (Gauß-Markow-Annahmen). Sie beinhalten unbeobachtete Faktoren, die sich auf die abhängige Variable auswirken. Die Störgröße kann auch Messfehler in den beobachteten abhängigen oder unabhängigen Variablen enthalten.

Im Gegensatz zu den Störgrößen sind Residuen (lateinisch residuum = „das Zurückgebliebene“) berechnete Größen und messen den vertikalen Abstand zwischen Beobachtungspunkt und der geschätzten Regressionsgerade. Mitunter wird das Residuum auch als „geschätztes Residuum“ bezeichnet. Diese Benennung ist problematisch, da die Störgröße eine Zufallsvariable und kein Parameter ist. Von einer Schätzung der Störgröße kann daher nicht die Rede sein.[1]

Die Problematik bei der sogenannten Regressionsdiagnostik ist, dass sich die Gauß-Markow-Annahmen nur auf die Störgrößen, nicht aber auf die Residuen beziehen. Die Residuen haben zwar ebenfalls einen Erwartungswert von Null, sind aber nicht unkorreliert und weisen auch keine homogene Varianz auf. Um diesem Missstand Rechnung zu tragen, werden die Residuen meist modifiziert, um die geforderten Annahmen zu erfüllen, z. B. studentisierte Residuen. Die Quadratsumme der Residuen spielt in der Statistik in vielen Anwendungen eine große Rolle, z. B. bei der Methode der kleinsten Quadrate. Die Notation der Störgrößen als bzw. ist an das lateinische Wort erratum (Irrtum) angelehnt. Die Residuen können mit Hilfe der Residualmatrix generiert werden.

Störgröße und Residuum

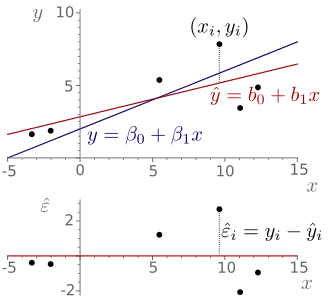

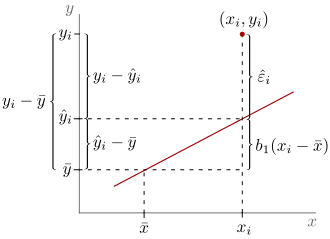

Störgrößen sind nicht mit den Residuen zu verwechseln. Man unterscheidet die beiden Konzepte wie folgt:

- Unbeobachtbare zufällige Störgrößen : Messen den vertikalen Abstand zwischen Beobachtungspunkt und theoretischer (wahrer Gerade)

- Residuum : Messen den vertikalen Abstand zwischen empirischer Beobachtung und der geschätzten Regressionsgerade

Einfache lineare Regression

In der einfachen linearen Regression mit dem Modell der linearen Einfachregression sind die gewöhnlichen Residuen gegeben durch

- .

Hierbei handelt es sich um Residuen, da vom wahren Wert ein geschätzter Wert abgezogen wird. Genauer gesagt werden von den Beobachtungswerten die angepassten Werte (englisch fitted values) abgezogen. In der einfachen linearen Regression werden an die Störgrößen für gewöhnlich zahlreiche Annahmen getroffen (siehe Annahmen über die Störgrößen).

Residualvarianz

Die Residualvarianz (auch Restvarianz genannt) ist eine Schätzung der Varianz der Regressionsfunktion in der Grundgesamtheit . In der einfachen linearen Regression ist eine durch die Maximum-Likelihood-Schätzung gefundene Schätzung gegeben durch

- .

Allerdings erfüllt der Schätzer nicht gängige Qualitätskriterien für Punktschätzer und wird daher nicht oft genutzt.[2] Beispielsweise ist der Schätzer nicht erwartungstreu für . In der einfachen linearen Regression lässt sich unter den Voraussetzungen des klassischen Modells der linearen Einfachregression zeigen, dass eine erwartungstreue Schätzung der Varianz der Störgrößen , d. h. eine Schätzung, die erfüllt, gegeben ist durch die um die Anzahl der Freiheitsgrade adjustierte Variante:

- .

Die positive Quadratwurzel dieser erwartungstreuen Schätzfunktion wird auch als Standardfehler der Regression bezeichnet.

Residuen als Funktion der Störgrößen

In der einfachen linearen Regression lassen sich die Residuen als Funktion der Störgrößen für jede einzelne Beobachtung schreiben als[3]

- .

Summe der Residuen

Die KQ-Regressionsgleichung wird so bestimmt, dass die Residuenquadratsumme zu einem Minimum wird. Äquivalent dazu bedeutet das, dass sich positive und negative Abweichungen von der Regressionsgeraden ausgleichen. Wenn das Modell der linearen Einfachregression einen – von Null verschiedenen – Achsenabschnitt enthält, dann muss also gelten, dass die Summe der Residuen Null ist[4]

Multiple lineare Regression

Da die Residuen im Gegensatz zu den Störgrößen beobachtbar und berechnete Größen sind, können sie graphisch dargestellt oder auf andere Weise untersucht werden. Im Gegensatz zur einfachen linearen Regression, bei der eine Gerade bestimmt wird, bestimmt man bei der multiplen linearen Regression (Erweiterung der einfachen linearen Regression auf Regressoren) eine Hyperebene, die durch die Punktwolke verläuft. Falls zwei Regressoren vorliegen, liegen die Beobachtungen bildlich gesprochen über beziehungsweise unter der Regressionsebene. Die Differenzen der beobachteten und der vorhergesagten, auf der Hyperebene liegenden -Werte, stellen die Residuen dar.[5] Für sie gilt:

- .

Die Residuen, die durch die Kleinste-Quadrate-Schätzung gewonnen werden, werden gewöhnliche Residuen genannt. Wenn zusätzlich Beobachtungen vorliegen, dann sind die gewöhnlichen KQ-Residuen in der multiplen linearen Regression gegeben durch[6][7]

- ,

wobei eine Projektionsmatrix, oder genauer gesagt die idempotente und symmetrische Residualmatrix darstellt und den KQ-Schätzer im multiplen Fall darstellt.

Eigenschaften

Die gewöhnlichen Residuen sind im Mittel , d. h.

Die Kovarianzmatrix der gewöhnlichen Residuen ist gegeben durch

- .

Die gewöhnlichen Residuen sind also heteroskedastisch, da

- .

Dies bedeutet, dass für die gewöhnlichen Residuen die Gauß-Markow-Annahmen nicht erfüllt sind, da die Homoskedastizitätsannahme nicht zutrifft.

Mithilfe der Prädiktions- und der Residualmatrix lässt sich zeigen, dass die Residuen mit den vorhergesagten Werten unkorreliert sind[8]

- .

Partielle Residuen

Partielle Residuen-Streudiagramme werden mithilfe von partiellen Residuen erstellt, die definiert sind durch

- .

Studentisierte Residuen

Für dieses einfache Modell sei die Versuchsplanmatrix

gegeben. Die Prädiktionsmatrix ist die Matrix der Orthogonalprojektion auf den Spaltenraum der Versuchsplanmatrix. ist gegeben durch

- .

Die statistischen Hebelwerte sind die -ten Diagonalelemente der Prädiktionsmatrix. Die Varianz des -ten Residuums ist gegeben durch

- .

In diesem Fall hat die Versuchsplanmatrix nur zwei Spalten, was zu folgender Varianz führt

- .

Die dazugehörigen studentisierten Residuen lauten

- .

Die studentisierten Residuen sind identisch (aber nicht unabhängig) verteilt und damit insbesondere homoskedastisch. Sie könnten somit eine Lösung für die Verletzung der Homoskedastizitätsannahme darstellen.

Aufbauende Maße

Residuenquadratsumme

Bildet man die Summe der quadrierten Residuen für alle Beobachtungen, so erhält man die Residuenquadratsumme:

- .

Diese spezielle Abweichungsquadratsumme taucht in vielen statistischen Maßen, wie z. B. dem Bestimmtheitsmaß, der F-Statistik und diversen Standardfehlern, wie dem Standardfehler der Regression auf. Die Minimierung der Residuenquadratsumme führt zum Kleinste-Quadrate-Schätzer.

Siehe auch

- Mittlerer absoluter Fehler

- Spezielle Residuen in der Überlebenszeitanalyse:

- Schoenfeld-Residuen

- Cox-Snell-Residuen

- Score-Residuen

- Devianz-Residuen

- Exzess-Residuen

- Martingal-Residuen

Einzelnachweise

- Ulrich Kockelkorn: Lineare statistische Methoden. De Gruyter 2018, ISBN 978-3-486-78782-5, S. 281 (abgerufen über De Gruyter Online).

- Ludwig Fahrmeir, Thomas Kneib, Stefan Lang, Brian Marx: Regression: models, methods and applications. Springer Science & Business Media, 2013, ISBN 978-3-642-34332-2, S. 109.

- Jeffrey Marc Wooldridge: Introductory econometrics: A modern approach. 4. Auflage. Nelson Education, 2015, S. 55.

- Manfred Precht und Roland Kraft: Bio-Statistik 2: Hypothesentests–Varianzanalyse–Nichtparametrische Statistik–Analyse von Kontingenztafeln–Korrelationsanalyse–Regressionsanalyse–Zeitreihenanalyse–Programmbeispiele in MINITAB, STATA, N, StatXact und TESTIMATE: 5., völlig überarb. Aufl. Reprint 2015, De Gruyter, Berlin Juni 2015, ISBN 978-3-486-78352-0 (abgerufen über De Gruyter Online), S. 299.

- Rainer Schlittgen: Regressionsanalysen mit R., ISBN 978-3-486-73967-1, S. 25 (abgerufen über De Gruyter Online).

- Ludwig Fahrmeir, Thomas Kneib, Stefan Lang, Brian Marx: Regression: models, methods and applications. Springer Science & Business Media, 2013, ISBN 978-3-642-34332-2, S. 77.

- Rainer Schlittgen: Regressionsanalysen mit R., ISBN 978-3-486-73967-1, S. 27 (abgerufen über De Gruyter Online).

- Rainer Schlittgen: Regressionsanalysen mit R., ISBN 978-3-486-73967-1, S. 27 (abgerufen über De Gruyter Online).