Schweizer-Käse-Modell

Das Schweizer-Käse-Modell (englisch Swiss cheese model) ist eine bildhafte Darstellung von latenten und aktiven menschlichen Fehlern als Beitrag zum Zusammenbruch von komplexen Systemen und beschreibt die Verkettung von Unfallursachen.[1] Das Modell wurde ursprünglich vom britischen Psychologen James Reason von der Universität Manchester dargelegt[2] und hat seitdem eine breite Akzeptanz gefunden.

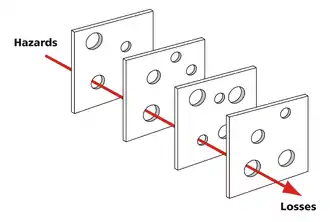

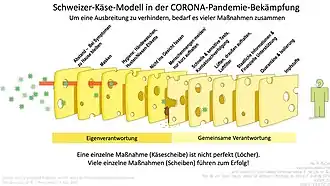

Das Schweizer-Käse-Modell vergleicht Sicherheitsebenen mit hintereinanderliegenden Käsescheiben. Die Löcher im Käse wie etwa beim Emmentaler sind ein Bild für die Unvollkommenheit von Sicherheits- oder Schutzmaßnahmen in einem Sicherheitssystem. Die Käselöcher als Schwachstellen können unerwartet ihre Größe und Lage verändern. Bei einer ungünstigen Kombination vieler ursächlicher Faktoren entwickeln sich einzelne Fehler zu Schäden, Unfällen oder katastrophalen Folgen. Im Modell liegen dann die Käselöcher auf einer Linie und es entsteht die „Gelegenheit zu einer Flugbahn“, so Reason, die alle Sicherheitsbarrieren überwindet.[1][2] Anstelle eines Modells kann der Schweizer Käse auch als nützliche Metapher aufgefasst werden.[3]

Latente und aktive Fehler

Reason untersuchte die Unfallberichte von Katastrophen wie Three Mile Island, Bhopal, Challenger, King’s Cross, Tschernobyl und Zeebrugge und schlug eine Unterscheidung zwischen aktivem und latentem Versagen vor;[1] später spricht er von Personen- und Systemfehlern.[2] Reason vertritt die Hypothese, dass die meisten Unfälle auf einen oder mehrere von vier Fehlerbereichen zurückgeführt werden können: organisatorische Einflüsse, Aufsicht, Vorbedingungen und konkrete Handlungen. Latente Fehler des Systems seien lange vor einem widrigen Ereignis auf der Führungs- und Organisationsebene angelegt worden, bevor sie zusammen mit ungünstigen Umständen und durch unsichere Handlungen einzelner Personen (aktives Versagen) zum Unfall führten.

Anwendung

Das Schweizer-Käse-Modell für Unfallursachen wird bei der Risikoanalyse und dem Risikomanagement eingesetzt. Es ist Ausgangspunkt zur Planung von Sicherheit u. a. im Ingenieur-[3] und Gesundheitswesen,[4][5] Schienenverkehr[6] und Luftfahrt.[7] Für Systemsicherheit wird es in der Arbeits- und Organisationspsychologie angewandt.[8]

Im täglichen Leben ereignen sich Fehler, die im Modell ein Käseloch passieren, aber bei einem funktionierenden System von der nächsten Käsescheibe als Sicherheitsbarriere gestoppt werden.

Auf der Grundlage des Schweizer-Käse-Modells entstanden Critical Incident Reporting Systeme (deutsch Berichtssysteme über kritische Vorkommnisse) zur Meldung von kritischen Ereignissen (englisch critical incident) und Beinahvorfällen (englisch near miss).

Frosch[9] beschrieb Reasons Modell mit mathematischen Begriffen als ein Modell in der Perkolationstheorie, die er als Bethe-Gitter analysierte.

Fehler: Person oder System

Bei einem widrigen Ereignis werden Beschuldigungen zumeist gegen die Akteure an „vorderster Front“ (englisch front line) erhoben.[1] Die Betrachtung eines Schadens oder Unglücks kann jedoch nach Reason auf zweierlei Weise erfolgen: Personen- oder Systemfehler.[2]

Unsicherheit keimt aus den Reihen der Leitung oder Aufsicht, wenn zum Beispiel unerfahrene Piloten für einen Nachtflug in bekanntermaßen schlechten Wetterbedingungen als Besatzung zusammengestellt werden. Organisatorische Einflüsse äußern sich in solchen Fällen durch Ausgabenkürzungen bei der Pilotenausbildung in Zeiten knapper Kassen.[10]

Dasselbe Grundgerüst wird auch im Gesundheitswesen angewandt. Durch einen Tippfehler auf dem Rezept verordnet ein Arzt eine gesundheitsschädliche Dosis.[4] Das kann als Flüchtigkeitsfehler des Arztes angesehen werden, wie er etwa unter Zeitmangel entsteht. Mehr als ein Viertel ihrer Arbeitszeit verwenden deutsche Ärzte für die Bürokratie im Gesundheitswesen[11] (Bürokratiekosten: 4,3 Milliarden Euro pro Jahr in den Arztpraxen der niedergelassenen deutschen Ärzte).[12]

Einzelheiten des aktiven Versagens sind oft nur schwer vorherzusehen. Es können jedoch latente Vorbedingungen identifiziert werden, bevor ein widriges Ereignis eintritt (vergl. Emergenz), um so „angesichts grundsätzlich bestehender personeller und operativer Risiken Systeme robust zu gestalten“ – also nicht vorrangig Fehlervermeidung, sondern Folgenabwehr als Ansatz des Sicherheitssystems.[2]

Theorien und Modelle der Unfallursachen

Im Verständnis von Unfallursachen grenzt sich Reason vom jahrelang angewandten Personenansatz ab. Bei Theorien mit einem Personenansatz[13] werden vorwiegend die unsicheren Handlungen oder Unterlassungen von Personen betrachtet – etwa bedingt durch „Vergesslichkeit, Unaufmerksamkeit, schlechte Motivation, Nachlässigkeit, Fahrlässigkeit und Leichtsinn“. Menschliche Fehler werden als moralisches Problem eingestuft: „Schlechten Menschen passieren schlechte Dinge“,[2] von Psychologen als just-world fallacy (deutsch Trugschluss einer gerechten Welt) bezeichnet.[14]

Die Theorie über „Symptome versus Ursachen“ schlägt vor, statt das Augenmerk besonders auf die offensichtlichen, zum Unfall führenden Fehler zu richten, müssten seine Gründe an der Wurzel untersucht werden; denn unsichere Handlungen und unsichere Bedingungen seien lediglich Symptome. „Symptome versus Ursachen“ wird eher als eine Ermahnung statt als Theorie bei der Untersuchung von Unfallursachen betrachtet.[13]

Als erstes Modell der Unfallverursachung wurde das Domino-Modell von Herbert William Heinrich (1931) beschrieben.[15] Dabei wird der Unfall mit einer Reihe von Dominosteinen verglichen. Sobald ein Stein fällt, wird er alle anderen umwerfen. Es stellt eine vollständige Abfolge von Faktoren dar, wobei der letzte Stein dem Unfall selbst entspricht. Damit wird ein einfaches Ursache-/Wirkungsprinzip beschrieben. Das Modell sollte nicht mit dem Dominoeffekt verwechselt werden.[16]

Neben dem Domino- und Schweizer-Käse-Modell fanden andere Modelle wenig Beachtung.[17]

Limitierung und Kritik

In mehreren Publikationen wurde die Limitation des Schweizer-Käse-Modells wie folgt zusammengefasst: es nenne keine Details, wie die Löcher der verschiedenen Käsescheiben wechselwirken. Dadurch eigne es sich auch nicht für die nachträgliche Untersuchung.[18][19][20]

Dekker führte 2002 dazu aus,[21] dass die Schichten einander verstärken oder behindern können. Außerdem sage das Modell nicht, wo die Schlupflöcher liegen, warum sie sich dort befinden, welche Gestalt sie haben und wie sie sich über die Zeit verändern.[20]

James Reason äußerte selbst:[20]

„The pendulum may have swung too far in our present attempts to track down possible errors and accident contributions that are widely separated in both time and place from the events themselves.“

Steve Shorrock et al. griffen Reason's Befürchtung wieder auf, indem sie darauf hinwiesen, dass die Suche nach vorausgehenden, organisatorischen oder systemischen Fehlern z. B. auf Design-, Management- oder Planungsebene, die eigentlichen menschlichen Fehler am Ende des Ereignisses überdecken könne.[22][20]

Einzelnachweise

- James Reason: The Contribution of Latent Human Failures to the Breakdown of Complex Systems. In: Philosophical Transactions of the Royal Society of London. Series B, Biological Sciences. Band 327, Nr. 1241, 12. April 1990, S. 475–484, doi:10.1098/rstb.1990.0090, JSTOR:55319.

- James Reason: Human error: models and management. In: British Medical Journal. Band 320, Nr. 7237, 18. März 2000, S. 768–770, doi:10.1136/bmj.320.7237.768, PMID 10720363, PMC 1117770 (freier Volltext).

- Erik Hollnagel, David D. Woods, Nancy Leveson (Hrsg.): Resilience Engineering: Concepts and Precepts. Ashgate Publishing, Burlington 2006, ISBN 978-0-7546-4641-9.

- Ein Tippfehler und die Folgen. (PDF; 72 kB) In: Rheinisches Ärzteblatt. Ärztekammer Nordrhein, September 2013, S. 16, abgerufen am 18. November 2013: „Zitat: Am Anfang steht der Tippfehler: Statt „5 x 1 Tbl.“ eines Arzneimittels täglich werden fälschlich „3 x 5 Tbl.“ auf dem Rezept vermerkt.“

- https://www.tagesspiegel.de/wissen/kaesestrategie-statt-salamitaktik-wie-man-auch-mit-loechrigen-massnahmen-corona-bekaempfen-kann/26914782.html

- Hannes Meuli: Sicherheit ist Chefsache. (PDF; 1419 kB) (Nicht mehr online verfügbar.) In: Swiss Traffic 42. Bundesamt für Verkehr (BAV), CH-Bern, April 2007, S. 7, archiviert vom Original am 18. Januar 2015; abgerufen am 20. Mai 2016.

- Guidelines for Aviation English Training Programmes. (PDF; 638 kB) Cir 323. ICAO, 2009, S. 35, abgerufen am 7. Dezember 2013 (englisch).

- Friedemann W. Nerdinger, Gerhard Blickle, Niclas Schaper: Arbeits- und Organisationspsychologie. Springer, Berlin/ Heidelberg 2008, Kap. 27: Psychologie der Arbeitssicherheit, S. 501 f. (springer.com [abgerufen am 6. Dezember 2013]).

- Robert A. Frosch: Seeds of Disaster, Roots of Response: How Private Action Can Reduce Public Vulnerability. Hrsg.: Philip E Auerswald, Lewis M Branscomb, Todd M La Porte, Erwann Michel-Kerjan. Cambridge University Press, 2006, ISBN 0-521-85796-1, Notes toward a theory of the management of vulnerability, S. 88.

- Douglas A. Wiegmann, Scott A. Shappell: A Human Error Approach to Aviation Accident Analysis: The Human Factors Analysis and Classification System. Ashgate Publishing, 2003, ISBN 0-7546-1873-0, S. 48–49 (englisch).

- Jens Flintrop, Heike Korzilius: Bürokratie in Praxen und Krankenhäusern: Vom Versuch, den Alltag in Ziffern zu pressen. In: BÄK und KBV (Hrsg.): Deutsches Ärzteblatt. Band 109, Heft 13, 30. März 2012, S. A-634 / B-550 / C-546 (aerzteblatt.de [PDF; 371 kB; abgerufen am 18. November 2013]): „Nach einer aktuellen Erhebung der KBV verbringt ein niedergelassener Arzt durchschnittlich 26 Prozent seiner Arbeitszeit mit Bürokratie.“

- Rebecca Beerheide, Heike Korzilius: Man braucht einen langen Atem. (PDF; 189 kB) Bürokratieabbau in der Arztpraxis. In: Deutsches Ärzteblatt. Bundesärztekammer und Kassenärztliche Bundesvereinigung (KBV), 11. Dezember 2015, S. 2120–2022, abgerufen am 15. Dezember 2015 (Zahlen des Statistischen Bundesamtes im Auftrag des Nationalen Normenkontrollrats).

- Abdul Raouf: Theory of accident causes. In: Jeanne Mager Stellman (Hrsg.): Encyclopaedia of occupational health and safety. 4. Auflage. International Labour Office, Genf 1998, ISBN 92-2-109203-8, Part VIII. Accident prevention, S. 56.6.

- M. J. Lerner: The desire for justice and reactions to victims. In: J. McCauley, L. Berkowitz (Hrsg.): Altruism and helping behavior. Academic Press, New York 1970; zitiert nach James Reason: Human error: models and management. In: British Medical Journal. 320, Nr. 7237, 18. März 2000, S. 768–770.

- Herbert William Heinrich: Industrial accident prevention: a scientific approach. McGraw-Hill, New York 1931 (H. W. Heinrich, D. Petersen, N. Roos: Industrial accident prevention. 5. Auflage. McGraw-Hill, New York 1980).

- Thierry Meyer, Genserik L. L. Reniers: Engineering Risk Management. Walter de Gruyter & Co, Berlin 2013, ISBN 978-3-11-028515-4.

- Jop Groeneweg: Hazard analysis: the accident causation model. In: Jeanne Mager Stellman (Hrsg.): Encyclopaedia of occupational health and safety. 4. Auflage. International Labour Office, Genf 1998, ISBN 92-2-109203-8, Part VIII: Accidents and safety management. S. 57.6–57.12.

- Shappell, Wiegmann: „The Human Factors Analysis and Classification System“, 2000

- Luxhoj & Kauffeld in: „The Rutgers Scholar“, Band 5 von 2003

- Revisiting the « SWISS CHEESE » Model of Accidents. (PDF; 533 kB) In: EEC Note No. 13/06. European Organisation for the Safety of Air Navigation (Eurocontrol), Oktober 2006, abgerufen am 21. November 2013 (englisch).

- Sidney Dekker: „The Field Guide to Human Error Investigations“, 1. Auflage von 2002, Seite 119–120

- S. Shorrock, M. Young, J. Faulkner: „Who moved my (Swiss) cheese?“ in: Aircraft & Aerospace, January/February 2005, Seite 31–33