Schiefe (Statistik)

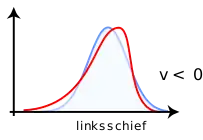

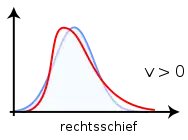

Die Schiefe (englisch skewness bzw. skew) ist eine statistische Kennzahl, die die Art und Stärke der Asymmetrie einer Wahrscheinlichkeitsverteilung beschreibt. Sie zeigt an, ob und wie stark die Verteilung nach rechts (rechtssteil, linksschief, negative Schiefe) oder nach links (linkssteil, rechtsschief, positive Schiefe) geneigt ist. Jede nicht symmetrische Verteilung heißt schief.[1][2]

Definition

Die Schiefe einer Zufallsvariablen ist das zentrale Moment 3. Ordnung (falls das Moment 3. Ordnung existiert), normiert auf die Standardabweichung :

- .

mit dem Erwartungswert und der Varianz . Diese Darstellung wird auch Momentenkoeffizient der Schiefe genannt. Mit den Kumulanten ergibt sich die Darstellung

- .

Die Schiefe kann jeden reellen Wert annehmen.

|

|

- Bei negativer Schiefe, , spricht man von einer linksschiefen oder rechtssteilen Verteilung; sie fällt in typischen Fällen auf der linken Seite flacher ab als auf der rechten.

- Bei positiver Schiefe, , spricht man von einer rechtsschiefen oder linkssteilen Verteilung; sie fällt typischerweise umgekehrt auf der rechten Seite flacher ab als auf der linken.

Typische Vertreter rechtsschiefer Verteilungen sind die Bernoulli-Verteilung für , die Exponentialverteilung und die Pareto-Verteilung für .

Die Schiefe ist invariant unter linearer Transformation mit :

Für die Summe unabhängiger normierter Zufallsgrößen gilt:

- ,

d. h. die Schiefe der Summe unabhängiger und identisch verteilter Zufallsgrößen ist die ursprüngliche Schiefe, dividiert durch .

Empirische Schiefe

Zur Berechnung der Schiefe einer empirischen Häufigkeitsverteilung wird die folgende Formel benutzt:

Damit die Schiefe unabhängig von der Maßeinheit der Variablen ist, werden die Messwerte mit Hilfe des arithmetischen Mittelwertes und der empirischen Standardabweichung der Beobachtungswerte

standardisiert. Durch die Standardisierung gilt

- und .

Schätzung der Schiefe einer Grundgesamtheit

Zur Schätzung der unbekannten Schiefe einer Grundgesamtheit mittels Stichprobendaten ( der Stichprobenumfang) müssen der Erwartungswert und die Varianz aus der Stichprobe geschätzt werden, d. h. die theoretischen durch die empirischen Momente ersetzt werden:

mit der Stichprobenmittelwert und die Stichprobenstandardabweichung. Dieser Schätzer ist jedoch nicht erwartungstreu für im Gegensatz zu

- .

Weitere Schiefemaße

Lage von Mittelwert und Median

Auf Karl Pearson geht die Definition

mit dem Erwartungswert , dem Median und der Standardabweichung zurück. Der Wertebereich von S ist das Intervall . Für symmetrische Verteilungen ist . Rechtsschiefe Verteilungen besitzen häufig ein positives , es gibt jedoch Ausnahmen von dieser Faustregel.[3]

Wenn die Standardabweichung divergiert, kann die Pearsonsche Definition verallgemeinert werden, indem eine Verteilung rechtsschief bezeichnet wird, wenn der Median kleiner als der Erwartungswert ist. In diesem Sinn ist die Pareto-Verteilung für beliebigen Parameter rechtsschief.

Quantilskoeffizient der Schiefe

Der Quantilskoeffizient der Schiefe beschreibt die normierte Differenz zwischen der Entfernung des - und des -Quantils zum Median. Er wird also wie folgt berechnet:

Dabei kann der Quantilskoeffizient Werte zwischen und annehmen. Der Quantilskoeffizient existiert für beliebige Verteilungen, auch wenn Erwartungswert oder die Standardabweichung nicht definiert sein sollten.

Eine symmetrische Verteilung besitzt den Quantilskoeffizienten ; eine rechtsschiefe (linksschiefe) Verteilung besitzt in der Regel einen positiven (negativen) Quantilskoeffizienten. Für ergibt sich der Quartilskoeffizient. Die Pareto-Verteilung besitzt für beliebige Parameter positive Quantilskoeffizienten.

Deutung

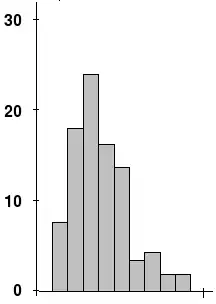

Ist , so ist die Verteilung rechtsschief, ist , ist die Verteilung linksschief. Für gutartige Verteilungen gilt: Bei rechtsschiefen Verteilungen sind Werte, die kleiner sind als der Mittelwert, häufiger zu beobachten, so dass sich der Gipfel (Modus) links vom Mittelwert befindet; der rechte Teil des Graphs ist flacher als der linke. Gilt , so ist die Verteilung auf beiden Seiten ausgeglichen. Bei symmetrischen Verteilungen ist immer . Umgekehrt müssen Verteilungen mit nicht symmetrisch sein.

Als Faustregeln kann man für gutartige Verteilungen also festhalten:

- rechtsschief:

- symmetrisch:

- linksschief:

Die Schiefe ist ein Maß für die Asymmetrie einer Wahrscheinlichkeitsverteilung. Da die Gaußsche Normalverteilung symmetrisch ist, d. h. eine Schiefe von null besitzt, ist die Schiefe eine mögliche Maßzahl, um eine Verteilung mit der Normalverteilung zu vergleichen. (Für einen Test dieser Eigenschaft siehe z. B. den Kolmogorow-Smirnow-Test.)

Interpretation der Schiefe

Rechtsschiefe Verteilungen findet man z. B. häufig beim Pro-Kopf-Einkommen. Hier gibt es einige wenige Personen mit extrem hohem Einkommen und sehr viele Personen mit eher niedrigem Einkommen. Durch die 3. Potenz erhalten die wenigen sehr extremen Werte ein hohes Gewicht und es entsteht ein Schiefemaß mit positivem Vorzeichen. Es gibt verschiedene Formeln, um die Schiefe zu berechnen. Die gängigen Statistikpakete wie SPSS, SYSTAT, Stata etc. nutzen besonders im Falle einer kleinen Fallzahl von obiger, momentbasierter Berechnungsvorschrift abweichende Formeln.

Siehe auch

Literatur

- W. H. Press et al.: Numerical Recipes in C. 2. Auflage. Cambridge University Press, 1992, Kapitel 14.1.

Einzelnachweise

- Universität Bielefeld: Andreas Handl - Symmetrie und Schiefe, S. 4 (Memento vom 13. April 2014 im Internet Archive) (PDF; 248 kB)

- "SPSS 16" von Felix Brosius, Seite 361

- Paul T. von Hippel: Mean, Median, and Skew: Correcting a Textbook Rule. In: Journal of Statistics Education. 13, Nr. 2, 2005.