Kamerakalibrierung

Als Kamerakalibrierung wird die Bestimmung der geometrischen Modellparameter einer Kamera oder ihrer radiometrischen (farblichen) Eigenschaften für technische und wissenschaftliche Anwendungen bezeichnet. Eine geometrisch kalibrierte Kamera eignet sich für die Messung geometrischer Informationen wie zum Beispiel der Bestimmung eines Geländemodells. Eine radiometrisch kalibrierte Kamera eignet sich für die Ableitung physikalischer Parameter des aufgenommenen Objekts wie zum Beispiel zur Klassifizierung landwirtschaftlicher Flächen aus einem Satellitenfoto. Damit unterscheidet sich die Kamerakalibrierung gegenüber dem eigentlichen Begriff der Kalibrierung, wo eine Abweichung im Bezug auf ein Normal bestimmt wird.

Radiometrische Kalibrierung

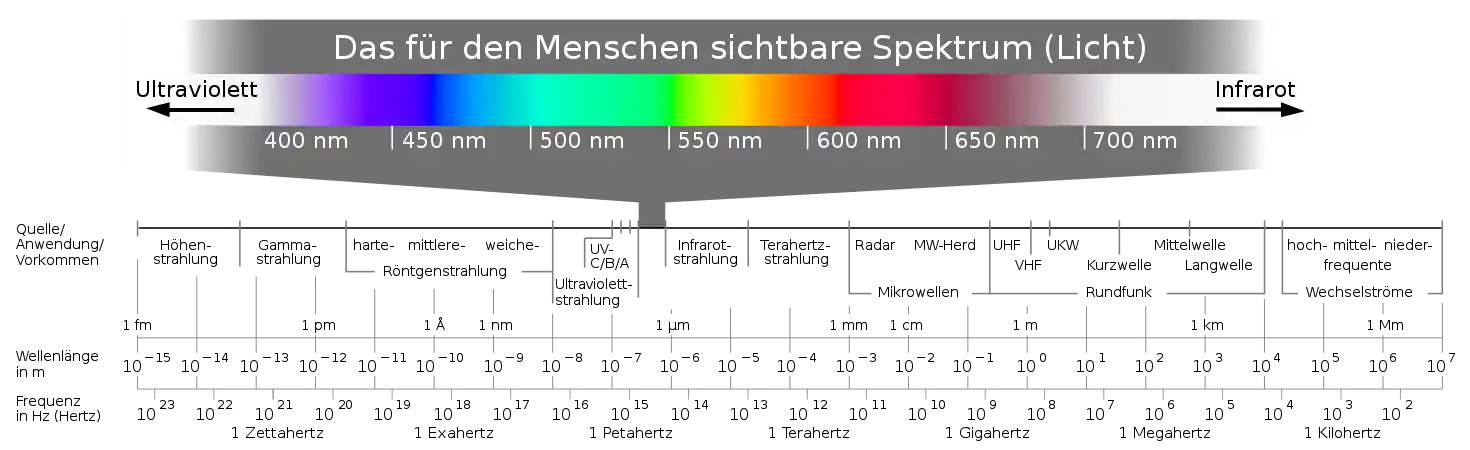

CCD-Sensoren sind weit über das Spektrum des (menschlich) sichtbaren Lichtes hinaus empfindlich im ultravioletten (zirka 100 bis 400 Nanometer) und im infraroten Bereich (ab 780 Nanometer). Die Photometrie untersucht die physikalischen Eigenschaften des sichtbaren Lichtes und in der Radiometrie wird dies auf die angrenzenden Bereiche erweitert. Bei der radiometrischen Kalibrierung geht es vor allem darum verschiedene Fehlereinflüsse einzelner Sensorelemente zu erkennen, um sie anschließend korrigieren zu können. Zusammenfassend kann man also sagen: die radiometrische Kamerakalibrierung dient der Bestimmung der radiometrischen (farblichen) Eigenschaften des Lichtsensors einer Kamera.

Bei einem CCD-Sensor können folgende Fehler auftreten: defekte Pixel (tote oder heiße Pixel), Dunkelstrom, ungleichmäßige Empfindlichkeit der Pixel, Randlichtabfall und Vignettierung. Diese Fehler lassen sich mit zwei einfachen Methoden bestimmen: Weißbild und Dunkelbild.

Weißbild

Ein Weißbild (englisch: „flat field“) ist eine formatfüllende Aufnahme eines gleichmäßig ausgeleuchteten Objekts. In der Regel wird dafür eine Ulbricht-Kugel verwendet. Damit lassen sich die überlagerten Fehler aus toten Pixeln (englisch: „dead pixel“), ungleichmäßiger Empfindlichkeit der Pixel, Randlichtabfall und Vignettierung bestimmen.

Dunkelbild

Ein Dunkelbild oder Dunkelstrombild (englisch: „dark current“) ist eine Aufnahme mit geschlossenem Objektiv oder in einem völlig dunklen Raum. Damit lassen sich die überlagerten Fehler aus heißen Pixeln (englisch: „hot pixel“) und Dunkelstrom bestimmen.

Korrektur

Defekte Pixel können im Grunde ignoriert werden. Dies geschieht meist dadurch, dass im Dunkelbild der entsprechende Pixel mit einem festen Wert überschrieben wird. Dabei ist zu beachten, dass der Wert außerhalb des Grauwertintervalls liegt, jedoch innerhalb des Wertebereiches des Datentyps der Variable. Zum Beispiel hat ein 8-Bit-Bild 2 hoch 8 (also 256) Farbwerte im Intervall [0; 255]. Gespeichert wird dies meistens als 16-Bit integer-Variable im Wertebereich [−32.768; 32.767]. Defekte Pixel können so zum Beispiel im Dunkelbild mit dem Wert −32.768 überschrieben werden. Und weil der kleinste Farbwert bei einer Farbtiefe von 8-Bit nur 0 sein kann, sticht der defekt markierte Pixel deutlich hervor. Gegebenenfalls muss der Wertebereich erweitert werden. Alternativ können defekte Pixel in einem extra Bild gespeichert werden.

Danach wird vom Rohbild das Dunkelbild subtrahiert und anschließend durch das Weißbild dividiert (Weißbild- oder Flat-Field-Korrektur) und mit dem Mittelwert des Weißbilds multipliziert.

Geometrische Kalibrierung

Um aus Bildern zuverlässige und genaue geometrische Informationen ableiten zu können, ist es notwendig eine Kamera genau zu kalibrieren und damit die innere und äußere Orientierung zu bestimmen. Eine Kamera gilt dann als kalibriert, wenn die Kamerakonstante, die Lage des Hauptpunkts und die Verzeichnung bekannt sind. Je nach Genauigkeitsanforderungen und Art der Kamera (Messkamera beziehungsweise (Messbildkamera) oder nicht) sind entweder alle oder nur einige Parameter relevant.[1]

Aufgrund der unterschiedlichen Historie unterscheiden sich die Art und Weise, wie Kameras normalerweise kalibriert werden – und teilweise auch die Bedeutung der Begriffe – zwischen den Fachgebieten Computer Vision und Photogrammetrie deutlich. So wird im Computer Vision mit Kamerakalibrierung auch die Bestimmung der äußeren Orientierung (der extrinsischen Parameter) gemeint. Außerdem wird in Computer Vision oftmals (fälschlicherweise) die Brennweite mit der Kamerakonstanten (entspricht der Bildweite) gleichgesetzt, was selbst in den besten Fachbüchern (zum Beispiel "Multiple View Geometry" von Hartley und Zisserman) so gemacht wird.[Anmerkung 1]

Darüber hinaus wird in der Photogrammetrie meist mittels Bündelausgleichung gearbeitet. Diese universelle Methode verwendet als Abbildungsgleichung die Kollinearitätsgleichung und benutzt eine kleinste Quadrate Ausgleichung. Zur Lösung benötigt man Startwerte und findet die Lösung schließlich mittels geeignetem Iterationsverfahren. Daher ist es sehr rechenintensiv, was oft als Nachteil gesehen wird. Der Vorteil der Ausgleichung nach der Methode der kleinsten Quadrate ist, dass neben dem funktionalen Modell gleichzeitig ein stochastisches Modell mitgeschätzt wird und man aufgrund des Fehlerfortpflanzungsgesetz folgern kann, dass dabei die beste Präzision erzielt wird. Das heißt, das Ergebnis ist optimal in dem Sinne, dass die genauesten Ergebnisse geschätzt werden (bester erwartungstreuer Schätzer).

Im Gegensatz dazu verwendet man im Computer Vision meist ein lineares projektives Abbildungsmodell (siehe Projektionsmatrix), welches mittels Singulärwertzerlegung direkt lösbar ist. Damit werden zunächst Näherungswerte ermittelt, die als Startwerte für eine anschließende nichtlineare Optimierung genutzt werden.[2] Als Optimierungsverfahren werden meistens die Gauß-Newton-Iteration oder die Levenberg-Marquardt-Iteration eingesetzt.

Obwohl beide Fachgebiete auf eine der genannten Optimierungsverfahren zurückgreifen, unterscheiden sie sich jedoch in den verwendeten Formeln zur Beschreibung der Abbildung. Alle aufgeführten Tatsachen machen es notwendig, die Kamerakalibrierung zwischen Computer Vision und Photogrammetrie zu trennen, obwohl sie im Grunde dem gleichen Zweck dienen.

Gemeinsamkeiten bei der Kalibrierung in Computer Vision und Photogrammetrie

Modell einer realen Kamera

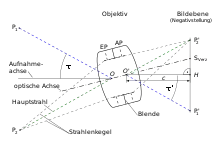

Eine reale Kamera weicht gegenüber dem Lochkameramodell in vielerlei Hinsicht ab. Das Objektiv besteht aus einer Anzahl an verschiedenen Linsen und einer Blende. Das objektseitige Bild der Blende ist die Eintrittspupille (EP) und das bildseitige Bild der Blende ist die Austrittspupille (AP). Ihre jeweiligen Mittelpunkte (auf der optischen Achse) sind das objektseitige Projektionszentrum und das bildseitige Projektionszentrum . Die optische Achse des Objektivs steht in der Regel nicht exakt senkrecht auf der Bildebene und ergibt als Schnittpunkt den Symmetriepunkt der Verzeichnung . Die senkrechte Projektion von in die Bildebene ergibt den Hauptpunkt und dieser Abstand ist die Kamerakonstante . Ein Objektpunkt hat mit der Aufnahmeachse den Winkel (tau) und dessen abgebildeter Punkt den Winkel . Die beiden Winkel und sind in der Regel nicht gleich, was durch Abbildungsverzerrungen vom Objektiv verursacht wird (Verzeichnung). Die Menge aller Strahlen, welche – von einem Objektpunkt kommend – durch die Blende des Objektivs durchgelassen werden, nennt man Strahlenkegel. Der representative Strahl, welcher durchs Projektionszentrum geht, wird als Hauptstrahl bezeichnet.[3][4]

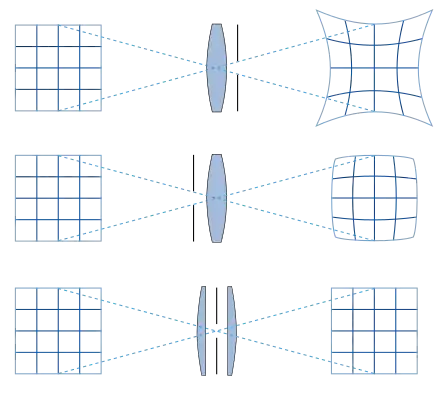

Man unterscheidet zunächst verschiedene Arten der Verzeichnung: radial-symmetrische Verzeichnung sowie radial-asymmetrische und tangentiale Verzeichnung. Diese Verzeichnungsarten lassen sich bestimmten physikalischen Ursachen zuordnen. Die radial-symmetrische Verzeichnung tritt am häufigsten auf. Sie ist abhängig von der Position der Blende und von der Bauweise des Objektivs. Weitwinkelobjektive haben – von der Seite betrachtet – einen unsymmetrischen Aufbau, da zum Objektraum große Sammellinsen benötigt werden, um viel Licht aus einem breiten Sichtfeld einzufangen. Dies führt in der Regel zur tonnenförmigen Verzeichnung und bei besonders ausgeprägter Verzeichnung spricht man auch von Fischaugenobjektiven.

Des Weiteren gibt es radial-asymmetrische Verzeichnung und tangentiale Verzeichnung. Deren Ursache ist meist eine Dezentrierung oder Schiefstellung einzelner Linsen. Dies wird manchmal auch als Prisma-Effekt bezeichnet, weil es zu einem Versatz des Bildinhaltes in eine Richtung führt. Beide Verzeichnungsarten werden oft zusammen korrigiert.

Darüber hinaus gibt es phänomenologische beziehungsweise deskriptive (beschreibende) Modelle, welche nicht die physikalischen Ursachen versuchen zu modellieren, sondern versuchen die im Bild sichtbaren Auswirkungen (Phänomene) mathematisch zu beschreiben. Dabei kommen unter anderem allgemeine ganzrationale Funktionen oder Brüche solcher Funktionen zum Einsatz (rationale Funktionen).

Kamerakalibrierung in Computer Vision

Eine der am häufigsten angewendeten Kalibrierverfahren ist die Kalibrierung nach Tsai. Dabei wird ein Schachbrettmuster aus unterschiedlichen Perspektiven fotografiert. Alternativ kann auch ein Kalibrierfeld aus drei Ebenen mit einem Schachbrettmuster verwendet werden.

Kamerakalibrierung nach Tsai

Tsai hat ursprünglich ein ebenes Kalibriermuster mit schwarzen Quadraten mit konstantem Abstand auf weißem Grund verwendet. Die Eckpunkte wurden im Bild mit einem Eckpunktdetektor automatisch bestimmt. Die Größe der Quadrate und deren Abstände auf dem Kalibriermuster waren genau bekannt. Um nun die innere Orientierung zu bestimmen, ist ein mehrstufiges Verfahren notwendig. Tsai hat damals eine zweistufige Gesamtstrategie vorgestellt, wobei die erste Stufe noch in eine vierstufige Transformation unterteilt war.[5] Aus einer heutigen Sichtweise lassen sich einige der Transformationen jedoch im modernen Standardmodell des Computer Vision zusammenfassen, so dass man es eigentlich nur mit zwei Stufen zu tun hat.[6]

In der ersten Stufe wird zunächst die äußere Orientierung im linearen Standardmodell bestimmt. Darauf folgt eine nicht-lineare Optimierung, bei der die Ergebnisse des vorherigen Schrittes als Startwerte bei der Iteration benutzt werden. Während bei der ersten Stufe kein geometrisches Fehlermaß minimiert wird, werden in Stufe zwei die gemessenen Bildpunkte mit den abgebildeten 3D-Passpunkten minimiert.[6] Dies geschieht implizit über das Ausgleichungsmodell, welches die 3D-Passpunkte vom Kalibrierfeld mit den Bildpunkten in eine mathematische Beziehung setzt, wodurch ein geometrischer Zwang entsteht, welcher nach der Ausgleichung minimal sein muss.

Stufe 1:

Tsai argumentiert, dass seiner Erfahrung nach die radial-symmetrische Verzeichnung dominiert und andere Verzeichnungsarten vernachlässigbar sind.[5] Weiterhin nimmt er an, dass der Symmetriepunkt der Verzeichnung mit dem Hauptpunkt übereinstimmt.[5] Dadurch vereinfachen sich die Beziehungen. Die radial-symmetrische Verzeichnung führt nun zu einer Änderung des Radius, der vom Hauptpunkt aus durch den Bildpunkt geht. Tsais Annahme ist nun, dass dies quasi einer maßstäblichen Verzerrung des abgebildeten Punktes bezüglich des Hauptpunktes (und damit zum Ursprung des Kamerakoordinatensystems = Projektionszentrum) entspricht, also entlang des Radius. Dies ist quasi identisch mit der Vorstellung dass der Projektionsstrahl in einer vor (oder hinter) der Bildebene liegenden Ebene abgebildet wird.[5] In der projektiven Geometrie ist dies eine bekannte Veranschaulichung eines homogenen Bildpunktvektors. Zur Erinnerung: ein homogener Bildpunktvektor ist beliebig skalierbar, wodurch der Abbildungsstrahl nicht geändert wird, sondern lediglich die Entfernung in welcher der Strahl die Bildebene durchstößt. Oder man stellt sich umgekehrt vor, dass der 3D-Punkt durch einen hinter dem eigentlichen Projektionszentrum liegenden Punkt durchläuft. Der so verzerrte Projektionsstrahl durchstößt die Bildebene nun an einer anderen Stelle, welche radial nach außen versetzt liegt. Bei der Veranschaulichung muss man sich bewusst sein, dass die radial-symmetrische Verzeichnung zu einer systematisch verzerrten Abbildung gegenüber dem linearen Lochkameramodell führt. Dadurch erfährt der Abbildungsstrahl einer realen Kamera einen Knick (, siehe oben).

Stufe 2:

Als Ausgangspunkt für die weitere Recherche und Beschreibung siehe en:Camera resectioning oder besser noch hier: en:Chessboard_detection.

Kamerakalibrierung in der Photogrammetrie

Man unterscheidet grundsätzlich verschiedene Arten der Kalibrierung: Laborkalibrierung, Testfeldkalibrierung und Simultankalibrierung (auch On-the-Job-Kalibrierung genannt).[3]

Laborkalibrierung

Eine Laborkalibrierung wird normalerweise nur bei Messkameras durchgeführt, da sie ziemlich zeitaufwändig ist. Dabei kommen entweder ein Goniometer oder Kollimatoren zum Einsatz. Das besondere dabei ist, dass die Bildebene mittels Bildstrahlen durch das Objektiv der Kamera direkt gemessen wird.[3]

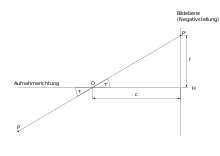

Bei analogen Filmkameras wird anstelle des Filmes eine Glasplatte mit einem Sollgitter direkt vor die Bildebene geschoben. Danach wird mittels Autokollimation die Position des Hauptpunktes ermittelt und von dieser Nullposition beginnt die Winkelmessung entlang den vier Hauptdiagonalen der Bildebene, um die Verzeichnungsparameter zu bestimmen. Es werden nun jeweils die Gitterpositionen mit dem Goniometer angefahren und dabei wird der Winkel von außen direkt gemessen. Der Winkel im Bildraum wird indirekt über die gemessene Bildposition mittels Tangensfunktion berechnet (siehe Abbildung "Definition der Bildfunktion"). Die Winkeländerung zwischen und entspricht der Verzeichnung an dieser Messposition. Diese Messung wird nun entlang einer Hauptdiagonale für verschiedene Radien durchgeführt und anschließend entlang der anderen Hauptdiagonalen wiederholt.[7]

Die Kamerakonstante wird mittels der Bildfunktion unter Berücksichtigung aller Messwerte mittels Ausgleichung bestimmt. Dies gelingt, weil die Verzeichnung radialsymmetrisch ist und entlang der vier Hauptdiagonalen – bei konstantem Radius – die Verzeichnung gleich sein muss. Dadurch erhält man für jeden Radius eine Redundanz. Alternativ kann auch eine gesamte Ausgleichung aller Messwerte zur gleichzeitigen Bestimmung der Verzeichnungsparameter und der Kamerakonstanten durchgeführt werden. Die Position des Hauptpunktes wird – wie bereits erwähnt – mittels Autokollimation direkt gemessen.

Testfeldkalibrierung

Hierbei werden bekannte 3D-Objektpunkte und die gemessenen Bildpunkte dazu verwendet, um die innere Orientierung numerisch mittels Bündelausgleichung zu bestimmen. Der funktionale Zusammenhang wird mittels den Kollinearitätsgleichungen beschrieben, welche nun um Verzeichnungsparameter erweitert werden. Die 3D-Objektpunkte und die homologen Bildpunkte sind bekannt, woraus man nun die innere und äußere Orientierung bestimmen kann. Von Interesse sind jedoch nur die Parameter der inneren Orientierung inklusive der Verzeichnung.

Als Testfeld kommen Kalibrierrahmen oder eine Fläche mit markierten Punkten (zum Beispiel an einer Hauswand) deren 3D-Koordinaten genau bekannt sind (Passpunkte) zum Einsatz. Aufgrund mathematischer Korrelationen zwischen einzelnen Parametern der inneren und der äußeren Orientierung ist es notwendig, eine aufwendige Aufnahmekonfiguration zu beachten.[8]

Quellenangaben

- Fabio Remondino, Clive Fraser: Digital camera calibration methods: Considerations and comparisons. In: ISPRS Commission V Symposium 'Image Engineering and Vision Metrology'. ISPRS, 25. September 2006, abgerufen am 23. Juli 2021 (englisch).

- Birgit Möller: Multi-Mosaikbilder: Ein Ansatz zur ikonischen Repräsentation von Bilddaten aktiver Kameras. In: Dissertation. Martin-Luther-Universität Halle-Wittenberg, 10. Mai 2005, abgerufen am 20. Juli 2021.

- Luhmann, Thomas: Nahbereichsphotogrammetrie Grundlagen, Methoden und Anwendungen. 3., völlig neu bearbeitete und erweiterte Auflage. Wichmann, Berlin 2010, ISBN 978-3-87907-479-2.

- DIN Deutsches Institut für Normung.: Photogrammetrie und Fernerkundung : Teil 1: Grundbegriffe und besondere Begriffe der photogrammetrischen Aufnahme : DIN 18716-1. (beuth.de [abgerufen am 15. Juni 2021]).

- Roger Y. Tsai, "A Versatile Camera Calibration for High-Accuracy 3D Machine Vision Metrology Using Off-the-Shelf TV Cameras and Lenses'", IEEE Journal of Robotics and Automation, Vol. RA-3, No.4, August, 1987 (englisch)

- Berthold K.P. Horn: Tsai’s camera calibration method revisited. 2000, abgerufen am 25. Juli 2020 (englisch).

- Eberhard Gülch, Michael Cramer: Kalibrierung von digitalen Luftbildkameras. In: ZfV - Zeitschrift für Geodäsie, Geoinformation und Landmanagement. zfv 5/2004, 1. Oktober 2004, ISSN 1618-8950 (geodaesie.info [abgerufen am 21. August 2021]).

- Wilfried Wester-Ebbinghaus: Einzelstandpunkt-Selbstkalibrierung - ein Beitrag zur Feldkalibrierung von Aufnahmekammern. Habilitation. Hrsg.: Deutsche Geodätische Kommission der Bayerischen Akademie der Wissenschaften. Reihe C, Dissertationen, Nr. 289. C.H. Beck, München 1983, ISBN 3-7696-9339-6 (worldcat.org [abgerufen am 23. Juli 2021]).

Anmerkungen

- Die mathematische Funktion bleibt von diesem Irrtum zum Glück unberührt, weil derselbe geometrische Abstand gemeint ist. Denn es ist nicht relevant, wie eine Variable benannt wird, sondern lediglich, dass der funktionale Zusammenhang mathematisch korrekt ausgedrückt wird.