Maximum-Likelihood-Methode

Die Maximum-Likelihood-Methode, kurz ML-Methode, auch Maximum-Likelihood-Schätzung (maximum likelihood englisch für größte Plausibilität, daher auch Methode der größten Plausibilität[1]), Methode der maximalen Mutmaßlichkeit,[2] Größte-Dichte-Methode oder Methode der größten Dichte bezeichnet in der Statistik ein parametrisches Schätzverfahren. Dabei wird – vereinfacht ausgedrückt – derjenige Parameter als Schätzung ausgewählt, gemäß dessen Verteilung die Realisierung der beobachteten Daten am plausibelsten erscheint.

Im Falle einer von einem Parameter abhängigen Wahrscheinlichkeitsfunktion

wird zu einem beobachteten Ausgang also die folgende Likelihood-Funktion für verschiedene Parameter betrachtet:

Dabei bezeichnet den Ergebnisraum und den Parameterraum (Raum aller möglichen Parameterwerte).

Für einen bestimmten Wert des Parameters entspricht die Likelihood-Funktion (Wahrscheinlichkeitsfunktion) der Wahrscheinlichkeit, das Ergebnis zu beobachten. Als Maximum-Likelihood-Schätzung wird entsprechend dasjenige bezeichnet, für das die Likelihood-Funktion maximal wird. Im Falle stetiger Verteilungen gilt eine analoge Definition, nur wird die Wahrscheinlichkeitsfunktion in dieser Situation durch die zugehörige Dichtefunktion ersetzt. Allgemein lassen sich Maximum-Likelihood-Methoden für beliebige statistische Modelle definieren, solange die entsprechende Verteilungsklasse eine dominierte Verteilungsklasse ist.

Motivation

Einfach gesprochen bedeutet die Maximum-Likelihood-Methode Folgendes: Wenn man statistische Untersuchungen durchführt, untersucht man in der Regel eine Stichprobe mit einer bestimmten Anzahl von Objekten einer Grundgesamtheit. Da die Untersuchung der gesamten Grundgesamtheit in den meisten Fällen hinsichtlich der Kosten und des Aufwandes unmöglich ist, sind die wichtigen Kennwerte der Grundgesamtheit unbekannt. Solche Kennwerte sind z. B. der Erwartungswert oder die Standardabweichung. Da man diese Kennwerte jedoch zu den statistischen Rechnungen, die man durchführen möchte, benötigt, muss man die unbekannten Kennwerte der Grundgesamtheit anhand der bekannten Stichprobe schätzen.

Die Maximum-Likelihood-Methode wird nun in Situationen benutzt, in denen die Elemente der Grundgesamtheit als Realisierung eines Zufallsexperiments interpretiert werden können, das von einem unbekannten Parameter abhängt, bis auf diesen aber eindeutig bestimmt und bekannt ist. Entsprechend hängen die interessanten Kennwerte ausschließlich von diesem unbekannten Parameter ab, lassen sich also als Funktion von ihm darstellen. Als Maximum-Likelihood-Schätzer wird nun derjenige Parameter bezeichnet, der die Wahrscheinlichkeit, die Stichprobe zu erhalten, maximiert.

Die Maximum-Likelihood-Methode ist aufgrund ihrer Vorteile gegenüber anderen Schätzverfahren (beispielsweise die Methode der kleinsten Quadrate und die Momentenmethode) das wichtigste Prinzip zur Gewinnung von Schätzfunktionen für die Parameter einer Verteilung.

Eine heuristische Herleitung

Es wird nun folgendes Beispiel betrachtet: Es gibt eine Urne mit einer großen Anzahl von Kugeln, die entweder schwarz oder rot sind. Da die Untersuchung aller Kugeln praktisch unmöglich erscheint, wird eine Stichprobe von zehn Kugeln (etwa mit Zurücklegen) gezogen. In dieser Stichprobe seien nun eine rote und neun schwarze Kugeln. Ausgehend von dieser einen Stichprobe soll nun die wahre Wahrscheinlichkeit, eine rote Kugel in der Gesamtpopulation (Urne) zu ziehen, geschätzt werden.

Die Maximum-Likelihood-Methode versucht diese Schätzung nun so zu erstellen, dass das Auftreten unserer Stichprobe damit am wahrscheinlichsten wird. Dazu könnte man ausprobieren, bei welchem Schätzwert die Wahrscheinlichkeit für unser Stichprobenergebnis maximal wird.

Probiert man beispielsweise als Schätzwert für die Wahrscheinlichkeit einer roten Kugel, so kann man mit Hilfe der Binomialverteilung die Wahrscheinlichkeit des beobachteten Ergebnisses (genau eine rote Kugel) berechnen: das Ergebnis ist .

Probiert man es mit als Schätzwert für , berechnet also für die Wahrscheinlichkeit, dass genau eine rote Kugel gezogen wird, ist das Ergebnis .

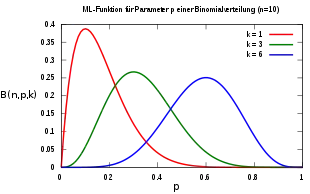

Mit für ist die Wahrscheinlichkeit, dass das beobachtete Ergebnis (genau eine rote Kugel) in der Stichprobe durch eine Populationswahrscheinlichkeit für rote Kugeln von verursacht wurde, somit größer als bei . Damit wäre nach der Maximum-Likelihood-Methode ein besserer Schätzwert für den Anteil roter Kugeln in der Grundgesamtheit. Es erweist sich, dass für (siehe rote Linie für in der Grafik) die Wahrscheinlichkeit des beobachteten Ergebnisses am größten ist. Deshalb ist die Maximum-Likelihood-Schätzung von . Man kann zeigen, dass sich allgemein bei roten Kugeln in der Stichprobe als Maximum-Likelihood-Schätzung von ergibt.

Definition

Bei der Maximum-Likelihood-Methode wird von einer Zufallsvariablen ausgegangen, deren Dichte- bzw. Wahrscheinlichkeitsfunktion von einem unbekannten Parameter abhängt. Liegt eine einfache Zufallsstichprobe mit Realisierungen von unabhängig und identisch verteilten Zufallsvariablen vor, so lässt sich die gemeinsame Dichtefunktion bzw. Wahrscheinlichkeitsfunktion wie folgt faktorisieren:

- .

Statt nun für einen festen Parameter die Dichte für beliebige Werte auszuwerten, kann umgekehrt für beobachtete und somit feste Realisierungen die gemeinsame Dichte als Funktion von interpretiert werden. Dies führt zur Likelihood-Funktion

- .

Die Likelihood-Funktion ist algebraisch identisch zur gemeinsamen Dichte .[3] Wird diese Funktion in Abhängigkeit von maximiert[4]

- ,

so erhält man die Maximum-Likelihood-Schätzung für den unbekannten Parameter . Es wird also der Wert von gesucht, bei dem die Stichprobenwerte die größte Dichte- bzw. Wahrscheinlichkeitsfunktion haben. Es ist naheliegend, einen Parameterwert als umso plausibler anzusehen je höher die Likelihood. Der Maximum-Likelihood-Schätzer ist in diesem Sinne der plausibelste Parameterwert für die Realisierungen der Zufallsvariablen . Ist differenzierbar, so kann das Maximum bestimmt werden, indem man die erste Ableitung nach bildet und diese dann Null setzt. Da dieses bei Dichtefunktionen mit komplizierten Exponentenausdrücken sehr aufwändig werden kann, wird häufig die logarithmierte Likelihood-Funktion bzw. logarithmische Likelihood-Funktion (kurz: Log-Likelihood-Funktion) verwendet, da sie auf Grund der Monotonie des Logarithmus ihr Maximum an derselben Stelle wie die nichtlogarithmierte Dichtefunktion besitzt, jedoch einfacher zu berechnen ist:

- ,

wobei die individuellen Beiträge zur Log-Likelihood-Funktion sind.

Beispiele

Diskrete Verteilung, kontinuierlicher Parameterraum

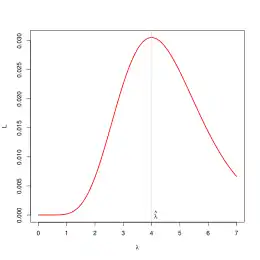

Die Anzahl der Anrufe bei zwei Telefonisten in einer Stunde in einem Call-Center kann mit einer Poisson-Verteilung

- und

modelliert werden. Beim ersten Telefonisten gehen drei und beim zweiten fünf Anrufe pro Stunde unabhängig voneinander ein. Die Likelihood-Funktion für den unbekannten Parameter ergibt sich als

Setzt man die Werte in die Wahrscheinlichkeitsfunktion

ein, so folgt

- .

Die erste Ableitung der Likelihood-Funktion ergibt sich zu

und die Nullstellen zu und . Nur für hat die Likelihood-Funktion ein Maximum und dies ist der Maximum-Likelihood-Schätzwert.

Im allgemeinen Fall, mit Telefonisten, die jeweils Anrufe pro Stunde erhalten, ergibt sich die Likelihood-Funktion als

und die Log-Likelihood-Funktion als

Die Ableitung nach ergibt

und nach Umformen ergibt sich der Maximum-Likelihood-Schätzer als

und die zugehörige Schätzfunktion als

Diskrete Verteilung, endlicher Parameterraum

Eine Urne enthält Kugeln, die entweder rot oder schwarz sind. Die genaue Anzahl der roten Kugeln ist nicht bekannt. Nacheinander werden Kugeln gezogen und jeweils wieder zurück in die Urne gelegt. Beobachtet werden (erste Kugel ist rot), (zweite Kugel ist rot), (dritte Kugel ist schwarz) und (vierte Kugel ist rot).

Gesucht ist nun die nach dem Maximum-Likelihood-Prinzip plausibelste Zusammensetzung der Kugeln in der Urne.

In jedem Zug ist die Wahrscheinlichkeit, eine rote Kugel zu ziehen, gleich . Wegen der Unabhängigkeit der Ziehungen ist die Wahrscheinlichkeit des beobachteten Ergebnisses und damit die zugehörige Likelihood-Funktion in Abhängigkeit vom unbekannten Parameter gegeben durch

Es ergeben sich folgende Funktionswerte:

| 0 | 0,002 | 0,012 | 0,033 | 0,063 | 0,092 | 0,105 | 0,084 | 0 |

Daraus ergibt sich dass die Likelihood-Funktion maximal ist für . Damit ist der plausibelste Parameterwert für die Realisierung drei roter Kugeln bei vier Ziehungen und somit der Schätzwert nach der Maximum-Likelihood-Methode.

Stetige Verteilung, kontinuierlicher Parameterraum

Seien Realisierungen einer Zufallsstichprobe einer Normalverteilung mit unbekanntem Erwartungswert und unbekannter Varianz . Die Dichtefunktion für jede einzelne Realisierung ist dann gegeben durch

- .

Dann ist

- .

die Likelihood-Funktion von . Als Log-Likelihood-Funktion (auch logarithmische Plausibilitätsfunktion genannt) ergibt sich

- .

Bildet man die partiellen Ableitungen von nach und (bildet man also die Score-Funktionen) und setzt man beide Ausdrücke gleich null, dann erhält man die beiden Likelihood-Gleichungen

und

- .

Löst man nun nach und dann erhält man die beiden Maximum-Likelihood-Schätzungen

und

- .

Geht man von den Zufallsvariablen und nicht von ihren Realisierungen aus, erhält man den Stichprobenmittelwert

und die Stichprobenvarianz

als Maximum-Likelihood-Schätzer.

Tatsächlich hat die Funktion an dieser Stelle ihr Maximum (siehe Schätzung der Varianz der Grundgesamtheit).

Für den Erwartungswert von ergibt sich

- ,

das heißt, der Maximum-Likelihood-Schätzer ist erwartungstreu für den unbekannten Parameter .

Man kann zeigen, dass für den Erwartungswert von

gilt (siehe unbekannter Erwartungswert). Der Maximum-Likelihood-Schätzer für die unbekannte skalare Störgrößenvarianz ist also nicht erwartungstreu. Allerdings kann man zeigen, dass der Maximum-Likelihood-Schätzer asymptotisch erwartungstreu für ist.

Historische Entwicklung

Die Maximum-Likelihood-Methode geht auf Ronald Aylmer Fisher zurück, der sie zunächst in relativer Unkenntnis von Vorarbeiten durch Gauß in Arbeiten von 1912, 1921 und schließlich 1922 unter dem später bekannten Namen entwickelte. Die Hauptergebnisse wurden auch bereits 1908 von Francis Ysidro Edgeworth hergeleitet.[5][6]

Maximum-Likelihood-Schätzung

Als Maximum-Likelihood-Schätzung, kurz MLS bezeichnet man in der Statistik eine Parameterschätzung, die nach der Maximum-Likelihood-Methode berechnet wurde. In der englischen Fachliteratur ist die Abkürzung MLE (für maximum likelihood estimation oder maximum likelihood estimator) dafür sehr verbreitet. Eine Schätzung, bei der Vorwissen in Form einer A-priori-Wahrscheinlichkeit einfließt, wird Maximum-a-posteriori-Schätzung (kurz MAP) genannt.

Eigenschaften von Maximum-Likelihood-Schätzern

Die besondere Qualität von Maximum-Likelihood-Schätzern äußert sich darin, dass sie in der Regel die effizienteste Methode zur Schätzung bestimmter Parameter darstellt.

Existenz

Unter bestimmten Regularitätsbedingungen lässt sich beweisen, dass Maximum-Likelihood-Schätzer existieren, was aufgrund ihrer impliziten Definition als eindeutiger Maximalstelle einer nicht näher bestimmten Wahrscheinlichkeitsfunktion nicht offensichtlich ist. Die für diesen Beweis benötigten Voraussetzungen bestehen im Prinzip ausschließlich aus Annahmen zur Vertauschbarkeit von Integration und Differentiation, was in den meisten betrachteten Modellen erfüllt ist.

Asymptotische Normalität

Wenn Maximum-Likelihood-Schätzer existieren, dann sind sie asymptotisch normalverteilt. Formal gesprochen sei der Maximum-Likelihood-Schätzer für einen Parameter und erwartete Fisher-Information. Dann gilt

bzw.

- .

Allgemeine Tests

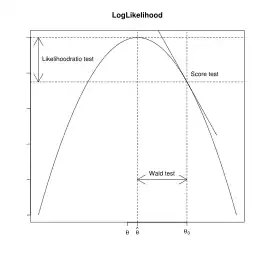

Die Konvergenz der Maximum-Likelihood-Schätzfunktion gegen eine Normalverteilung erlaubt die Ableitung allgemeiner Tests zur Prüfung von Modellen und Koeffizienten:

- Likelihood-Quotienten-Test,

- Wald-Test und

- Score-Test oder Lagrange-Multiplikator-Test (LM-Test).

Die Grafik rechts zeigt die Arbeitsweise der Tests auf: Der Likelihood-Quotienten-Test vergleicht die Werte der Likelihood-Funktionen miteinander, der Wald-Test prüft den Abstand zwischen dem geschätzten Parameter und dem vorgegebenen Parameter und der Score-Test, ob die Ableitung der Likelihood-Funktion Null ist.

Da diese Tests nur asymptotisch gültig sind, gibt es für „kleine“ Stichprobenumfänge oft Tests mit besseren Optimalitätseigenschaften.

Likelihood-Quotienten-Test

Im Likelihood-Quotienten-Test wird geprüft, ob sich zwei hierarchisch geschachtelte Modelle (englisch nested models) signifikant voneinander unterscheiden. Ist ein Parametervektor, sind zwei Parameterräume ( reduziertes Modell, volles Modell) sowie die Likelihood-Funktion, dann gilt unter der Nullhypothese ( vs. )

- .

Eine Ablehnung der Nullhypothese bedeutet, dass das „volle Modell“ (das Modell unter der Alternativhypothese) eine signifikant bessere Erklärung liefert als das „reduzierte Modell“ (das Modell unter der Nullhypothese bzw. Nullmodell) .

Wald-Test

Während der Likelihood-Quotienten-Test Modelle vergleicht, zielt der Wald-Test auf einzelne Koeffizienten (univariat) oder Koeffizientengruppen (multivariat). Asymptotisch und unter der Nullhypothese folgt

- .

D.h. die Wald-Teststatistik ist unter o. g. Voraussetzungen standardnormalverteilt. Hierbei bezeichnet die Fisher-Information.

Akaike-Informationskriterium

Die Maximum-Likelihood-Methode ist auch eng mit dem Akaike-Informationskriterium (AIC) verknüpft. Hirotsugu Akaike zeigte, dass das Maximum der Likelihood-Funktion ein verzerrter Schätzer für die Kullback-Leibler-Divergenz, der Abstand zwischen dem wahren Modell und dem Maximum-Likelihood-Modell, ist. Je größer der Wert der Likelihood-Funktion ist, desto näher liegt das Modell am wahren Modell, gewählt wird das Modell, das den geringsten AIC-Wert aufweist. Die asymptotische erwartungstreue ist gerade die Anzahl der zu schätzenden Parameter. Mit dem Akaike-Informationskriterium kann man, im Gegensatz zum Likelihood-Quotienten-, Wald- und Score-Test, auch nichtgeschachtelte ML-Modelle vergleichen.

Nachteile der Methode

Die wünschenswerten Eigenschaften des Maximum-Likelihood-Ansatzes beruhen auf der entscheidenden Annahme über den datenerzeugenden Prozess, das heißt auf der unterstellten Dichtefunktion der untersuchten Zufallsvariable. Der Nachteil der Maximum-Likelihood-Methode besteht darin, dass eine konkrete Annahme über die gesamte Verteilung der Zufallsvariable getroffen werden muss. Wenn diese jedoch verletzt ist, kann es sein, dass die Maximum-Likelihood-Schätzer inkonsistent sind.

Nur in einigen Fällen ist es unerheblich, ob die Zufallsvariable tatsächlich der unterstellten Verteilung gehorcht, allerdings gilt dies nicht im Allgemeinen. Per Maximum-Likelihood gewonnene Schätzer, die konsistent sind, auch wenn die zu Grunde gelegte Verteilungsannahme verletzt wird, sind sogenannte Pseudo-Maximum-Likelihood-Schätzer.

Maximum-Likelihood-Schätzer können Effizienzprobleme und systematische Fehler in kleinen Stichproben aufweisen.

Sind die Daten nicht zufällig, kann man mit anderen Methoden oft bessere Parameter ermitteln. Das kann beispielsweise bei Quasi-Monte-Carlo-Analysen eine Rolle spielen, oder wenn die Daten bereits gemittelt sind.

Anwendungsbeispiel: Maximum-Likelihood in der molekularen Phylogenie

Das Maximum-Likelihood-Kriterium gilt als eine der Standardmethoden zur Berechnung von phylogenetischen Bäumen, um Verwandtschaftsbeziehungen zwischen Organismen – meist anhand von DNA- oder Proteinsequenzen – zu erforschen. Als explizite Methode ermöglicht Maximum-Likelihood die Anwendung verschiedener Evolutionsmodelle, die in Form von Substitutionsmatrizen in die Stammbaumberechnungen einfließen. Entweder werden empirische Modelle verwendet (Proteinsequenzen) oder die Wahrscheinlichkeiten für Punktmutationen zwischen den verschiedenen Nukleotiden werden anhand des Datensatzes geschätzt und hinsichtlich des Likelihood-Wertes () optimiert (DNA-Sequenzen). Allgemein gilt ML als die zuverlässigste und am wenigsten Artefakt-anfällige Methode unter den phylogenetischen Baumkonstruktionsmethoden. Dies erfordert jedoch ein sorgfältiges Taxon-„Sampling“ und meist ein komplexes Evolutionsmodell.

Literatur

- Schwarze, Jochen: Grundlagen der Statistik – Band 2: Wahrscheinlichkeitsrechnung und induktive Statistik, 6. Auflage, Berlin; Herne: Verlag Neue Wirtschaftsbriefe, 1997

- Blobel, Volker und Lohrmann, Erich: Statistische und numerische Methoden der Datenanalyse. Teubner Studienbücher, Stuttgart; Leipzig 1998, ISBN 978-3-519-03243-4.

Einzelnachweise

- Alice Zheng, Amanda Casari: Merkmalskonstruktion für Machine Learning: Prinzipien und Techniken der Datenaufbereitung

- Der Deutsche Normenausschuß hat in einem Rundschreiben 1954 den schwerfälligen Begriff „Methode der maximalen Mutmaßlichkeit im Gauß-Fisherschen Sinne“ vorgeschlagen

- George G. Judge, R. Carter Hill, W. Griffiths, Helmut Lütkepohl, T. C. Lee. Introduction to the Theory and Practice of Econometrics. 2. Auflage. John Wiley & Sons, New York/ Chichester/ Brisbane/ Toronto/ Singapore 1988, ISBN 0-471-62414-4, S. 64.

- Leonhard Held und Daniel Sabanés Bové: Applied Statistical Inference: Likelihood and Bayes. Springer Heidelberg New York Dordrecht London (2014). ISBN 978-3-642-37886-7, S. 14.

- R. A. Fisher: An absolute criterion for fitting frequency curves. In: Messenger of Math. Nr. 41, S. 155, 1912. JSTOR 2246266 (online)

- John Aldrich: R. A. Fisher and the Making of Maximum Likelihood 1912–1922. In: Statistical Science. Band 12, Nr. 3, S. 162–176, 1997, doi:10.1214/ss/1030037906, JSTOR 2246367.