Kanalkapazität

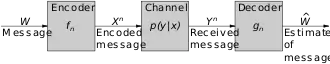

Die Kanalkapazität ist Teil der informationstheoretischen Beschreibung eines Übertragungskanals. Sie gibt die höchste Bitrate an, mit der Informationen über einen Kanal gerade noch fehlerfrei übertragen werden können.[1]

Claude Shannon und Ralph Hartley zeigten in Form des Shannon-Hartley-Gesetzes, dass sich die theoretische Kanalkapazität durch geeignete Kodierung näherungsweise erreichen lässt.

Definition

Die Kanalkapazität C für einen diskreten, gedächtnisfreien Kanal ist das Supremum aller fehlerfrei in einer Zeitspanne übertragbaren Symbole:

Dabei werden unterschieden:

- der Informationsgehalt X der gesendeten Symbole

- der Informationsgehalt Y der empfangenen Symbole.

Der Unterschied ergibt sich:

- durch Störungen, welche am Übertragungskanal auf die Symbole einwirken und diese verfälschen,

- durch den Umstand, dass eine gesendete Information am Übertragungskanal verloren gehen kann.

Mathematisch lässt sich das für diese beiden Fälle ausdrücken durch die Entropiefunktion I(·), welche die wechselseitige Information (Transinformation) beschreibt, :

mit

- der binären Entropiefunktion

- der Fehlerwahrscheinlichkeit p.

Arten von Übertragungskanälen

Die Kanalkapazität hängt von der Art des Übertragungskanals ab. Im Folgenden wird sie für wichtige Modelle von Übertragungskanälen dargestellt.

Binärer symmetrischer Kanal

Der binäre Übertragungskanal ist ein wertdiskreter Übertragungskanal, somit ist seine maximale Kanalkapazität auf ein Bit limitiert. Er kann nur die zwei Symbole (Zustände) annehmen, welche mit 0 oder 1 bezeichnet werden. Somit kann die Kanalkapazität bei diesem Kanalmodell nur im Intervall 0 bis 1 liegen.

Die Kanalkapazität dieses binären symmetrischen Kanals, im Englischen auch als Binary Symmetric Channel (BSC) bezeichnet, ist:

Für die Extremwerte der Fehlerwahrscheinlichkeit von p = 0 oder p = 1 ist die Kapazität eins und somit maximal; im ersten Fall stellt der Übertragskanal einen fehlerfreien binären Übertragungskanal dar, im zweiten Fall einen Inverter. Für p = 0,5 ist die Kanalkapazität C = 0, also minimal. In diesem Fall wird der BSC zu einer idealen Rauschquelle, und es kann keine Informationsübertragung erfolgen.

Binärer Auslöschungskanal

Auch der binäre Auslöschungskanal stellt einen wertdiskreten Übertragungskanal dar, dessen Kanalkapazität

mit der Fehlerwahrscheinlichkeit p ist. Die Kanalkapazität ist bei diesem Kanal maximal für p = 0, wo keinerlei Auslöschung erfolgt. Sie ist minimal für p = 1, wo jegliche Information ausgelöscht wird und keinerlei Informationsübertragung möglich ist.

AWGN-Kanal

Der AWGN-Kanal stellt einen wertkontinuierlichen Übertragungskanal dar, welcher als Störgröße additives weißes gaußsches Rauschen (AWGN) aufweist. Aufgrund der Wertkontinuität können im Prinzip unendlich viele Symbole vorkommen, welche sich allerdings aufgrund der Störgröße unter Umständen nicht mehr sicher voneinander unterscheiden lassen. Daraus ergibt sich nach dem Shannon-Hartley-Gesetz die Kanalkapazität C des AWGN-Kanals:

mit

- der Bandbreite B in Hz

- dem Signal-Rausch-Verhältnis S/N (SNR) zwischen der zu übertragenden Information und dem am Kanal auftretenden, additiven weißen gaußschen Rauschen.

Für eine maximale Kanalkapazität ist es notwendig, dass auch das SNR maximal wird (S/N → ∞). In diesem Grenzfall kann durch den Umstand einer unendlich großen Symbolmenge auch eine unendlich hohe Kanalkapazität erreicht werden – allerdings ist dieser Grenzfall praktisch wegen immer vorhandener Störquellen nicht erreichbar.

Abgrenzung

Um zur Übertragungsrate zu gelangen, die nicht nur die fehlerfrei übertragene Information berücksichtigt, sondern jede übertragene, werden in zeitlicher Abfolge unterschiedliche Symbole über den Kanal übertragen. Diese Abfolge ergibt eine Symbolrate, welche von der Frequenz abhängt und spektral eine bestimmte Bandbreite belegt.

Die Übertragungsrate R ergibt sich dann als:

mit

- der Symbolrate

- dem Wert, wie viele Bits an Information pro Symbol transportiert werden; dieser Wert hängt direkt von der Kanalkapazität ab und somit vom jeweiligen Kanal.

Die Kanalkapazität kann maximal so groß sein wie die Übertragungsrate.

Literaturquellen

- André Neubauer, Jürgen Freudenberger, Volker Kühn: Coding Theory. Algorithms, Architectures, and Applications. John Wiley & Son, Chichester 2007, ISBN 978-0-470-02861-2.

- Martin Werner: Information und Codierung. Grundlagen und Anwendungen, 2. Auflage, Vieweg + Teubner Verlag, Wiesbaden 2008, ISBN 978-3-8348-0232-3.

- Markus Hufschmid: Information und Kommunikation. Grundlagen der Informationsübertragung, Vieweg und Teubner, Wiesbaden 2006, ISBN 3-8351-0122-6.

- Martin Bossert: Kanalcodierung. 3. überarbeitete Auflage, Oldenbourg Verlag, München 2013, ISBN 978-3-486-72128-7.

- Martin Werner: Nachrichtentechnik. Eine Einführung für alle Studiengänge, 7. Auflage, Vieweg + Teubner Verlag, Wiesbaden 2010, ISBN 978-3-8348-0905-6.

Weblinks

- Kanalkapazität des AWGN-Kanals unter Berücksichtigung verschiedener Randbedingungen der Sendesymbole, Institut für Nachrichtenübertragung (engl.), Universität Stuttgart

- Zum Kanalkapazitäts-Theorem von Shannon (abgerufen am 16. Februar 2018)

Einzelnachweise

- Thomas Cover: Information Theory, S. 184, 2. Auflage, John Wiley & Sons, 2012, ISBN 978-0471241959.