Motion Capture

Unter Motion Capture, wörtlich Bewegungs-Erfassung, versteht man ein Tracking-Verfahren zur Erfassung und Aufzeichnung von Bewegungen, so dass Computer diese wiedergeben, analysieren, weiterverarbeiten und zur Steuerung von Anwendungen nutzen können.

Ein Beispiel für eine solche Anwendung ist die Übertragung menschlicher Bewegungen auf im Computer generierte 3D-Modelle. Beispiele für andere Arten sind das Head-Tracking und das Eye-Tracking, z. B. zur Steuerung von Bildschirmausgaben oder zu Analysezwecken und die Stereoskopische Bewegungsmessung. Ein weiteres spezielles Motion-Capture-Verfahren ist das Performance Capture (wörtlich: Darstellungs-Erfassung), das die Erfassung von menschlichen Gesichts- und Fingerbewegungen umfasst, also Mimik und Gestik.

Inzwischen ist die Bewegungserfassung auch bei Videospielen verbreitet, z. B. mit Kinect, PlayStation Move und der Wii-Fernbedienung.

Verfahren

Grundsätzlich kann zwischen mehreren Verfahren unterschieden werden, die auch kombiniert zum Einsatz kommen können.

Tracken mit Markern

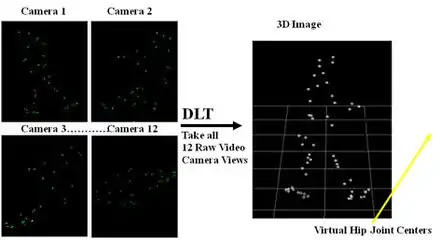

Beim optischen Tracking mit Markern wird mit Kameras gearbeitet, welche aktive (also ein Signal emittierende) oder passive Marker an den zu erfassenden Personen oder Gegenständen verfolgen. Anhand der Markerbewegungen in den einzelnen Kamerabildern kann mittels Triangulation die Position der Marker in 3D berechnet werden.

Mustererkennung

Unter anderem ist es über Mustererkennung in der Bildverarbeitung möglich, markerlos zu tracken. Dabei erleichtern stereoskopische Verfahren oft die Erkennung, da das Objekt aus der Triangulation der beiden (mehreren) Kamerapositionen erkannt werden kann.

Silhouettetracking

Seit Anfang des 21. Jahrhunderts wurden Systeme entwickelt, welche eine 3D-Bewegungserfassung auf Basis von Silhouetten generieren können. Nachdem über bildverarbeitende Algorithmen die Silhouette aus dem Raum extrahiert wurde, wird ein virtuelles Modell verwendet, um die Gelenkpositionen zu erfassen. Anhand derer werden die kinematischen Parameter berechnet. Diese Systeme bieten vor allem gegenüber der alten konventionellen Analyse mit Markern bedeutende Vorteile, da Fehlerpotentiale der Marker vermieden werden (Verschiebungen auf der Haut; Ungenaues Anbringen der Marker etc.) und eine Erfassung deutlich weniger Aufwand benötigt.

Vorläufer

Schon die ersten Reihenfotografien von Eadweard Muybridge sollten dazu dienen, menschliche oder tierische Bewegungen zu analysieren. Spätere Fotografen und Filmer brachten an ihren Modellen deutlich erkennbare Kennzeichen an, um die Analyse der Bewegungen zu vereinfachen. Diese Technik überlebte bis ins Video- und Computerzeitalter, wobei die Markierungen immer noch Bild für Bild per Hand in die Analysesoftware übertragen wurden. Anwendungsgebiete für diese Technik waren zumeist (Sport-)Medizin, Unfallforschung (Crashtests), und Rationalisierung von Bewegungsabläufen in der Arbeitswelt.

Zur Herstellung von Filmen konnte diese Technik noch wenig beitragen, obwohl Muybridges Fotos bis heute Vorbild für Animatoren in aller Welt sind. Erst Max Fleischer erfand mit der Rotoskopie ein Verfahren, das geeignet war, komplexe Bewegungen relativ einfach in Zeichentrick zu übertragen. Der Herr der Ringe (1978) von Ralph Bakshi entstand auf diese Weise ebenso wie zwei neuere Filme von Richard Linklater. Dennoch werden mittels Rotoskopie keine Bewegungsdaten erzeugt, sondern nur das äußere Erscheinungsbild der Schauspieler (teilweise Software-unterstützt) in die Animation übertragen.

Motion Capture für Animationsfilme

Weiterverarbeitung

Nach der Digitalisierung können die Rohdaten über ein geeignetes Plug-in in aktuelle 3-D-Systeme importiert und dort weiterbearbeitet werden. Sie werden dabei auf ein virtuelles Skelett (eine Art dreidimensionales Strichmännchen) übertragen. Dieses Skelett ist wiederum mit einem Drahtgittermodell verknüpft, das so den aufgezeichneten Bewegungen folgt. Die Konstruktion des Skeletts (Rigging) und dessen Verknüpfung mit der zu bewegenden Figur (Skinning) tragen wesentlich zur glaubwürdigen Wiedergabe der aufgezeichneten Bewegungsdaten bei.

Nach dem Rendern sieht es für den Betrachter aus, als würde die virtuelle Figur die Bewegungen des ursprünglichen Schauspielers ausführen. Diese Technik wird verstärkt in computergenerierten Filmen wie Final Fantasy: Die Mächte in dir oder Shrek eingesetzt. Aber auch in vielen neuen PC- und Videospielen (z. B. Tony Hawk’s Project 8 oder der FIFA Serie von EA Sports) findet diese Technik Verwendung. Außerdem wurde bei dem Rockstar-Games-Spiel L.A. Noire sowohl der Produktions-, als auch der Marketingfokus auf die Performance-Capturing-Technik, die im Spiel Anwendung findet, gelegt. Sämtlichen im Spiel existenten Figuren wurde mittels Performance Capturing ein möglichst realitätsnahes Gesicht und die dazugehörige Mimik verliehen, um die atmosphärische Wirkung zu steigern.

Die „Bewegungsqualität“ der Computermodelle hängt von mehreren Faktoren ab:

- Anzahl der auszuwertenden, gleichartigen Bewegungen:

- Dieselbe Bewegung wird von dem Akteur mehrmals vorgenommen, die Bewegungsmuster werden verglichen und ein Mittelwert aus ihnen gebildet.

- „Gelenke des Computermodells“:

- Ein Computermodell besteht aus verschiedenen Gelenken und Knochen (ähnlich der eines Menschen). Ist die Anzahl der Gelenke im Arm und der Hand des Modells kleiner als die des Akteurs, so können nicht alle Daten der realen Bewegung verwendet werden. Es entstehen „kantige“ Bewegungen.

- Detailtreue:

- Bei der Skelett-Animation (im Gegensatz zum Performance Capture, siehe unten) werden subtile Bewegungen wie Muskelverformung, die Bewegung von Hautfalten und Ähnliches nicht durch die MoCap-Systeme erfasst. Die (an sich unsichtbare) Bewegung des Skeletts gibt jedoch nur einen Teil des Gesamteindrucks einer Bewegung wieder, der daher nicht nur von der Qualität der Rohdaten, sondern auch vom handwerklichen Geschick der Animationskünstler bei der Konstruktion der Figur abhängt.

Die Animation von Comicfiguren, die gerade durch eine deutliche Übertreibung natürlicher Bewegungsabläufe lebendig werden, hat sich in der Praxis als einfacher erwiesen als die naturgetreue Nachbildung, die mit dem Einsatz von Motion-Capture-Techniken theoretisch möglich wäre. Untersuchungen haben gezeigt, dass Animationen als befremdlicher wahrgenommen werden, je mehr sie sich um Realitätstreue und Vermeidung bewusster Übertreibung bemühen. Diese „Delle“ in der Wahrnehmungskurve wird als Uncanny Valley bezeichnet. Die Überwindung dieses „unheimlichen Tals“ gilt derzeit trotz Einsatz von Motion-Capture-Setups noch nicht als vollständig gelöst.[1][2]

Vorteile

Durch Bewegungserfassung können komplexe Bewegungsabläufe (z. B. Laufen, Tanzen) mit relativ geringem (zeitlichen) Aufwand realisiert werden, die über andere Animationsmethoden (z. B. Schlüsselbildanimation bzw. engl. keyframe animation) schwer, oder nur mit hohem zeitlichen Aufwand möglich gewesen wären.

Nachteile

Die Bewegungen bei Motion Capturing können einen künstlichen Eindruck machen, obwohl die zugrundeliegenden Daten eines natürlichen Ursprungs sind. Dies rührt daher, dass das sogenannte Retargeting (das Übertragen von Animationsdaten auf eine virtuelle Figur mit möglicherweise unterschiedlicher Statur) ein komplexer Prozess ist. Unterscheiden sich der menschliche Darsteller und die Computerfigur in der Physiognomie, müssen die Daten in irgendeiner Form umgerechnet werden. Dienen die Bewegungen eines normal gewachsenen menschlichen Darstellers beispielsweise dazu, einen Zwerg mit sehr kurzen Beinen zu bewegen, muss die Entscheidung getroffen werden, ob beim Gehen die Art der Bewegung übertragen wird (dann geht der Zwerg natürlich, macht aber sehr kleine Schritte) oder die absolute Distanz verwendet wird (in diesem Fall macht der Zwerg Riesenschritte, was möglicherweise unnatürlich aussieht oder ganz unmöglich ist). Da die grundsätzliche Problematik bei jeder Anpassung von Motion-Capture-Daten auf eine künstliche Figur vorhanden ist, ist dieser Prozess eigentlich der komplexeste Teil des Ganzen, wenn man funktionierende Motion-Capture-Daten zur Verfügung hat. In größeren Produktionen werden daher die Bewegungsdaten öfter von erfahrenen Animatoren nachbearbeitet oder gar nur als Vorlage für Handarbeit benutzt (Titanic – der Begriff hierfür ist die sog. Rotoanimation).

Performance Capture

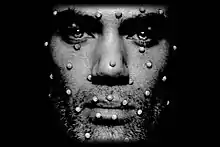

Als Performance Capture wird eine Weiterentwicklung der Motion-Capture-Technologie bezeichnet, bei der nicht nur die Körperbewegungen, sondern auch die Gesichtsausdrücke der Schauspieler gescannt werden. Ein anderes, häufig verwendetes Merkmal, um zwischen Motion Capture und Performance Capture zu unterscheiden, ist das Ausmaß des Unterschieds zwischen aufgenommenem Schauspieler und animierter Figur: Ist der Unterschied nur sehr gering, kann die Bewegung mit geringen Nachbesserungen verwendet werden; bei großen Unterschieden müssen komplexe Umrechnungsverfahren die Bewegung auf die neue Figur übertragen.

In folgenden Filmen wurde Performance Capture zur Animation vollständig computergenerierter Figuren eingesetzt:

- 2001: Final Fantasy: Die Mächte in dir (Regie: Hironobu Sakaguchi)

- 2004: Der Polarexpress (Regie: Robert Zemeckis)

- 2005: Final Fantasy VII: Advent Children (Regie: Tetsuya Nomura)

- 2006: Renaissance (Regie: Christian Volckman)

- 2006: Monster House (Regie: Gil Kenan)

- 2007: Die Legende von Beowulf (Regie: Robert Zemeckis)

- 2009: Disneys Eine Weihnachtsgeschichte (Regie: Robert Zemeckis)

- 2009: Avatar – Aufbruch nach Pandora (Regie: James Cameron)

- diverse Barbie-Märchenfilme

- 2010: Tron: Legacy (Regie: Joseph Kosinski)

- 2011: Planet der Affen: Prevolution (Regie: Rupert Wyatt)

- 2011: Die Abenteuer von Tim und Struppi – Das Geheimnis der Einhorn (Regie: Steven Spielberg)

- 2011: Real Steel (Regie: Shawn Levy)

- 2013: Tarzan (2013) (Regie: Reinhard Klooss)

- 2019: Alita: Battle Angel (Regie: Robert Rodriguez)

Integriertes Performance Capture

Filme, die zwischen in der realen Welt aufgenommenen Personen und vom Computer generierten Figuren schwanken, ohne dass hier eine Grenze sichtbar wird.

Filme mit einzelnen Performance-Capture-Figuren:

- 1998–2005: Jar Jar Binks (Ahmed Best) in Star Wars: Episode I, Star Wars: Episode II und Star Wars: Episode III (Regie: George Lucas)

- 2001–2003: Gollum (Andy Serkis) in Der Herr der Ringe: Die Gefährten und den beiden Fortsetzungen (Regie: Peter Jackson)

- 2004: Sonny (Alan Tudyk) in I, Robot (Regie: Alex Proyas)

- 2005: Kong (Andy Serkis) in King Kong (Regie: Peter Jackson)

- 2005–2011 Lord Voldemort (Ralph Fiennes) in Harry Potter und der Feuerkelch (Film) und den vier Fortsetzungen (Regie: Mike Newell, David Yates)

- 2006/2007: Davy Jones (Bill Nighy) in Pirates of the Caribbean – Fluch der Karibik 2 und Pirates of the Caribbean – Am Ende der Welt (Regie: Gore Verbinski)

- 2009: Dr. Manhattan (Billy Crudup) in Watchmen – Die Wächter (Regie: Zack Snyder)

- 2012: Ted (Seth MacFarlane) in Ted (Regie: Seth MacFarlane)

- 2012–2014: Azog (Manu Bennett) in Der-Hobbit-Trilogie (Regie: Peter Jackson)

- 2017: Kong in Kong: Skull Island (Regie: Jordan Vogt-Roberts)

Der Film Avatar (2009, Regie: James Cameron) nimmt hier eine spezielle Rolle ein, da große Teile der Figuren mit Performance Capture animiert wurden. Außerdem wurden, zusätzlich zu den Motion-Capture-Daten der Akteure, auch die der Kamera aufgenommen, um sie mit in die virtuellen Umgebungen übertragen zu können.

Siehe auch

Einzelnachweise

- Mori, Masahiro: Das unheimliche Tal. Übersetzung aus dem Japanischen: MacDorman, Karl F.; Schwind, Valentin. in: Haensch, Konstantin Daniel; Nelke, Lara; Planitzer, Matthias (Hrsg.): Uncanny Interfaces. Textem Verlag, Hamburg 2019. S. 212–219. ISBN 978-3-86485-217-6 [Wiederveröffentlichung]

- MacDorman, Karl F.: Masahiro Mori und das unheimliche Tal: Eine Retrospektive in: Haensch, Konstantin Daniel; Nelke, Lara; Planitzer, Matthias (Hrsg.): Uncanny Interfaces. Textem Verlag, Hamburg 2019. S. 220–234. ISBN 978-3-86485-217-6