Eye-Tracking

Mit Eye-Tracking, auch Blickerfassung[1][2] oder im medizinischen Bereich Okulographie[3][4] bezeichnet man das Aufzeichnen der hauptsächlich aus Fixationen (Punkte, die man genau betrachtet), Sakkaden (schnellen Augenbewegungen) und Regressionen bestehenden Blickbewegungen einer Person.

Als Eyetracker werden Geräte und Systeme bezeichnet, die die Aufzeichnung vornehmen und eine Analyse der Blickbewegungen ermöglichen.

Das Eye-Tracking wird als wissenschaftliche Methode in den Neurowissenschaften, der Wahrnehmungs-, Kognitions- und Werbepsychologie, der kognitiven bzw. klinischen Linguistik, bei Usability-Tests, im Produktdesign und der Leseforschung eingesetzt. Es wird auch bei der Untersuchung von Tieren, insbesondere im Zusammenhang mit der Erforschung ihrer kognitiven Fähigkeiten eingesetzt.[5]

Geschichte

Bereits im 19. Jahrhundert wurden Augenbewegungen durch direkte Beobachtung erfasst. Einer der Ersten war der Franzose Émile Javal, der die Augenbewegungen beim Lesen beschrieb.[7]

Mit der Erfindung der Filmkamera wurde es möglich, die direkte Beobachtung aufzuzeichnen und nachträglich zu analysieren. Dies erfolgte bereits 1905 durch Judd, McAllister und Steel.[8]

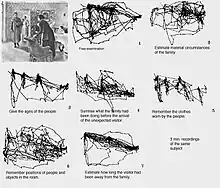

Als eigentlicher Pionier der Blickregistrierung mit hoher Genauigkeit gilt der Russe A.L.Yarbus, der insbesondere den Einfluss der Aufgabenstellung auf die Blickbewegungen beim Betrachten von Bildern nachwies.[6]

In den 1970er-Jahren wurden dann neue Verfahren entwickelt.

- Retinal-Nachbilder, durch eine Folge starker Lichtreize werden so genannte Nachbilder auf der Retina erzeugt, durch deren Position man auf die Augenbewegung schließen kann.

- Elektrookulogramme messen die elektrische Spannung zwischen Netzhaut (negativer Pol) und der Hornhaut (positiver Pol).

- Kontaktlinsenmethode, die verspiegelt sind und deren Reflexion von einer Kamera aufgezeichnet wird.

- search coil, bei der ebenfalls Kontaktlinsen eingesetzt werden, welche mit Spulen versehen sind und einem magnetischen Feld ausgesetzt werden. Aus der induzierten Spannung kann dann die Augenbewegung errechnet werden.

- Cornea-Reflex-Methode, welche die Reflexion einer oder mehrerer Lichtquellen (Infrarot oder spezielle Laser) auf der Hornhaut und deren Position zur Pupille nutzt. Das Augenbild wird mit einer geeigneten Kamera aufgenommen. Das Verfahren wird auch als „video based eye tracking“ bezeichnet.

Aufzeichnungsgeräte

Grundsätzlich lassen sich Eyetracker in zwei verschiedene Bauweisen unterteilen: mobile Eyetracker, die fest auf dem Kopf des Probanden angebracht werden und solche, die extern installiert sind. Letztere kann man wiederum in zwei Kategorien unterteilen: Remote-Geräte sowie solche, die mit einer Fixierung des Kopfes des Probanden verbunden sind.

Aufbau und Anwendung

Mobile Systeme, sogenannte Head-mounted Eye Tracker bestehen im Wesentlichen aus drei Komponenten: a) einer Infrarot-Lichtquelle zur Realisierung der Cornea-Reflex-Methode, b) einer oder mehreren Kameras, die die Reflexionsmuster auf der Hornhaut aufnehmen, und c) einer Blickfeldkamera, die den Bereich festhält, auf den der Proband schaut. Die Komponenten wurden früher in eine spezielle Vorrichtung eingebaut, die auf dem Kopf des Probanden montiert wurde. Heute sind die Komponenten so klein, dass sie in ein Brillengestell integriert werden können. Das Gewicht einer solchen Brille liegt häufig unter 50 g. Auch der zugehörige Steuerrechner – früher noch im Format eines Notebooks – lässt sich heute in einem Gerät von der Größe eines Handys unterbringen. Während bei externen Geräten lediglich der Blick auf einen Bildschirm aufgezeichnet werden kann, eignen sich mobile Eyetracker somit auch für Feldstudien außerhalb des Laborkontextes. Der Hauptgrund liegt darin, dass die Blickrichtung durch die Befestigung des Infrarotsenders und der Kameras unmittelbar an der Brille unabhängig von überlagernden Kopfbewegungen erfasst werden kann. Der Nachteil mobiler Eyetracker liegt in der bisher nicht parametrisierbaren Aufzeichnung der Daten. So wird lediglich der Blick des Probanden in einem Video seiner Blickfeldkamera eingeblendet. Für eine statistische Auswertung müssen diese Videos zurzeit noch mit hohem Aufwand manuell durchgesehen werden. Es ist davon auszugehen, dass dieses Problem in Zukunft mit Methoden der automatisierten Videoanalyse gelöst werden kann.

Anwendungen mobiler Eyetracker sind beispielsweise die Marktforschung (wohin schaut ein Proband beim Gang durch einen Supermarkt) oder die Usability-Forschung (wie lange schaut ein Proband beim Autofahren auf die Straße, wie lange auf das Navigationsgerät). Auswertungen und Analysen erfolgen im Wesentlichen individuell und anwenderzentriert. Die Methode erlaubt so online oder auch offline, eine Verfolgung des Blickpfades und der Verweildauer des Blicks (Fixation) auf bestimmte Objekte während einer freien Bewegung des Probanden. Generalisierungen über mehrere Probanden und Aufmerksamkeitsanalysen auf bestimmte Objekte lassen sich technisch über 3D/6D Positionserfassungssysteme (sogenannte Head Tracker) realisieren.

Das "EyeLink II (EL II)"

Das System „EL II“ besteht aus zwei mit entsprechender Software ausgestatteten Computern, einem „Programmrechner“ und einem damit verbundenen „Stimulusrechner“ inklusive Monitoren sowie aus einem Headset. An diesem befinden sich zwei an seitlichen Halterungen befestigte Kameras zur Aufzeichnung der Augenbewegungen. Eine weitere, oben befindliche Kamera ist auf vier – an einem der beiden Rechner montierten – Infrarotmarker abgestimmt. Damit ist es möglich, jede Art von Fixation auf Bilder oder Handlungen aufzuzeichnen. Das System arbeitet bereits nach der Methode der cornealen Reflexionen. Auch Störfaktoren wie der Muskeltremor können damit ausgeschlossen werden.

Montage des Headsets

Dem Probanden wird das Kopfband mit den Kameras aufgesetzt. Danach wird die oben befindliche Kamera in Position gebracht. Dafür wird sie möglichst genau auf mittlere Höhe und mittlere Breite des einen der beiden Monitore, nämlich des sogenannten Stimulusmonitors, eingestellt. An diesem Monitor sind auch die referentiellen Infrarotmarker für die Einstellung der Kamera montiert. Für die korrekte Justierung wird einfach entweder der Monitor selbst verschoben oder der Sessel des Probanden in der Höhe verstellt.

Die beiden auf den seitlichen Haltearmen befindlichen Augenkameras werden so geschwenkt, dass sie nicht störend im Blickfeld des Probanden liegen. Sie sollten sich ungefähr auf der Höhe der Nasenspitze befinden und können bereits in die ungefähre Position für die spätere Aufnahme gebracht werden. Die Kameras können mit dem Schwenkarm selbst sowie mittels Klemmen und Feststellschrauben dreidimensional verstellt werden.

Feineinstellung

Mit Hilfe einer mitgelieferten Software kann die Feineinstellung – Ausrichtung der Kamera und Schärfeneinstellung – vorgenommen werden. Letztere funktioniert über die im System integrierte automatische Schwellenwerteinstellung für die corneale Reflexion und die Pupillenerhellung.

Bei der Kalibrierung werden dem Probanden am Stimulusbildschirm in einer Autosequenz zufällige Punkte angeboten, die sich quer über den Bildschirm bewegen. Der Proband erhält die Anweisung, die Punkte mit beiden Augen zu verfolgen. Nach erfolgreicher Kalibrierung folgt die Validierung. Dies läuft wie das Kalibrieren ab, wobei aber die maximale Abweichung der Blickbewegungen in Grad gemessen wird. Dabei muss der Experimentleiter entscheiden, ob die Einstellung verwendbar ist oder ob nachjustiert werden soll. Eine einmal akzeptierte Einstellung lässt sich während des Experiments immer wieder nachjustieren, da zwischen den einzelnen Stimuli jeweils eine neutrale Bildschirmmaske mit Fixationspunkt erscheint. Das System selbst schlägt das besser eingestellte Auge vor.

Systemkonfiguration

Programmrechner und Stimulusrechner sind mittels eines Netzwerkkabels miteinander verbunden. Der Programmrechner steht darüber hinaus mit den Augenkameras und den Infrarotmarkern in Verbindung. Auf dem Stimulusrechner laufen eine Software zur Darbietung der Stimuli und die Programmiersprache Visual C++ für die Programmierung der Experimente. Der Monitor, auf dem die Stimuli präsentiert werden, sollte eine Größe von 17 Zoll aufweisen, da diese gerade für die Durchführung von Leseexperimenten am geeignetsten erscheint. Mit Hilfe eines Joysticks kann der Proband den jeweils nächsten Stimulus anfordern.

Programm- und Stimulusrechner sollten in einer bestimmten räumlichen Position aufgestellt werden, um Spiegelungen und unerwünschte Lichtreize während der Aufnahme zu verhindern. Zudem sollte sich der Programmrechner mit dem Kontrollmonitor außerhalb des Blickfeldes des Probanden befinden, um eine Ablenkung von den dargebotenen Stimuli zu vermeiden.

Das "Eye Tracking Device (ETD)"

Dieser Eyetracker wurde ursprünglich vom Deutschen Zentrum für Luft- und Raumfahrt (DLR) für den Einsatz auf der Internationalen Raumstation ISS entwickelt. Anfang 2004 wurde er als Teil des europäisch-russischen Raumfahrtprogramms auf die ISS befördert. Das Gerät wurde von Andrew H. Clarke vom Vestibular-Labor der Charité in Berlin in Zusammenarbeit mit den Unternehmen Chronos Vision und Mtronix in Berlin entwickelt und für die Anwendung im Weltraum von der Firma Kayser-Threde in München integriert.

Bei ersten Experimenten, ausgeführt von Clarkes Team in Kooperation mit dem Moskauer Institut für Biomedizinische Probleme (IBMP), wurde das ETD für die Messung der Listingschen Ebene – einem Koordinatensystem zur Bestimmung der Augenbewegungen relativ zum Kopf – genutzt. Das wissenschaftliche Ziel bestand darin, zu bestimmen, wie die Listingsche Ebene sich unter verschiedenen Gravitationsbedingungen verändert. Insbesondere wurde der Einfluss langfristiger Mikrogravitation an Bord der ISS und nach der anschließenden Rückkehr in die Erdgravitation untersucht.

Die Ergebnisse tragen zum Verständnis der neuralen Plastizität in Vestibular- und Oculomotor-Systemen bei.

Diese Experimente begannen im Frühling 2004 und wurden bis Ende 2008 von einer Reihe von Kosmonauten und Astronauten fortgeführt, die jeweils sechs Monate auf der ISS verbrachten.

Operationen

Die Untersuchung der Orientierung der Listingschen Ebene während einer langfristigen Raumfahrtmission ist von speziellem Interesse, weil die Listingsche Ebene auf der Erde scheinbar durch das vestibuläre System beeinflusst wird. Dies lässt sich durch Messung der Kopfposition relativ zur Gravitation feststellen. Das Experiment untersucht die Anpassung des Vestibularsystems des Astronauten während des Aufenthalts in der Schwerelosigkeit und nach der Rückkehr zur Erde. Das Experiment soll darüber hinaus klären, in welchem Maße sich die Orientierung der Listingschen Ebene in Abhängigkeit von der Adaption des vestibulären Systems an veränderte Gravitationsverhältnisse, insbesondere an die Schwerelosigkeit, verändert. Eine weitere Frage ist, ob der menschliche Körper während eines langen Raumfluges die fehlenden Inputs des Vestibularsystems durch andere Mechanismen kompensiert.[9]

Missionen

Das ETD kam für diese Studie zwischen 2004 und 2008 zum Einsatz. Während der sechsmonatigen Experimente wurden die Versuche im Drei-Wochen-Rhythmus wiederholt, wodurch die Adaption der Mikrogravitation evaluiert werden konnte. Ergänzend wurden in den ersten Wochen nach der Rückkehr zur Erde äquivalente Messungen bei jedem Kosmonauten oder Astronauten durchgeführt. Inzwischen ist das ETD-System ein universelles Instrument auf der ISS. Zurzeit wird es von einer Gruppe russischer Wissenschaftler des Instituts für Biomedizinische Probleme verwendet, die die Koordination der Augen- und Kopfbewegungen in der Mikrogravitation untersuchen.

Technologie

Die digitalen Kameras sind mit leistungsstarken CMOS-Bildsensoren ausgerüstet und werden via bidirektionalen, digitalen Hochgeschwindigkeitsverbindungen (400Mb/s) mit dem zugehörigen Prozessorboard des Host-PC verbunden. Auf diesem PCI-Prozessor-Bord befindet sich die Front-End-Steuerungsarchitektur, welche aus dem digitalen Signalprozessor (DSP) und programmierbaren integrierten Schaltkreisen (FPGA) besteht. Diese Komponenten sind so programmiert, dass sie die pixelorientierte Onlineakquisition und das Messen der 2D-Pupillenkoordinaten ermöglichen.[10]

Für die Aufgabe der Blickbewegungsregistrierung wird eine substanzielle Datenreduktion von den Sensoren und der Front-End-Steuerungsarchitektur ausgeführt. So werden nur vorselektierte Daten vom Bildsensor zum Host-PCs, auf dem die finalen Algorithmen und die Datenspeicherung ausgeführt werden, übertragen. Diese Entwicklung beseitigt die Flaschenhalsprobleme herkömmlicher Frame-by-Frame-Bildverarbeitung und ermöglicht eine wesentliche Steigerung der Bildwiederholungsraten.

Die Steuerungsarchitektur ist in einem PC integriert und ermöglicht die Visualisierung der Augen und der entsprechenden Signale bzw. Daten. Ein wichtiges Entwicklungsmerkmal ist die digitale Speicherung aller Bildsequenzen der Kameras als digitale Dateien auf austauschbaren Festplatten. Auf diese Weise kann die Festplatte mit den gespeicherten Augendaten, nach Abschluss der ISS-Mission zur Erde zurückgesendet werden. Dies gewährleistet eine umfangreiche und zuverlässige Bilddatenanalyse im Forschungslabor und minimiert die Zeit, die für das Experiment auf der ISS benötigt wird.

ETD auf der Erde

Parallel zu der im Weltraum eingesetzten Ausführung des ETD wurde von Chronos Vision auch eine kommerziell anwendbare Version entwickelt, die in vielen europäischen, nordamerikanischen und asiatischen Laboren für die neurophysiologische Forschung eingesetzt wird.

Externe Systeme

Externe Systeme, sogenannte Remote Eye Tracker ermöglichen die Durchführung berührungsloser Messungen. Hierbei entfallen mechanische Bauteile wie Übertragungskabel oder Kinnstützen. Der Proband kann sich nach erfolgreicher Kalibrierung in einem gewissen Bewegungsradius frei bewegen. Ein bedeutender Aspekt liegt hierbei in der Kompensation der Kopfbewegungen. Eine Person kann einen Ort fixieren und dabei Kopfbewegungen durchführen, ohne den Fixationsort zu verlieren.

Zur Registrierung von Blickbewegungen auf einem Computerbildschirm können die Komponenten des Gerätes entweder direkt in einen Bildschirm eingebaut oder unter beziehungsweise neben diesem angebracht werden. Die Augenkamera erkennt automatisch das Auge und „verfolgt“ dieses. Es besteht kein Kontakt zwischen Proband und Gerät. Dem gegenüberstehen Eyetracker in „Tower“-Bauweise, wobei der Kopf des Probanden im Gerät fixiert wird. Letztere Bauart ist in der Regel teurer in der Anschaffung und für den Probanden eher unbequem, liefert in der Regel dafür exaktere Ergebnisse in höherer Bildfrequenz.

Unterschiedliche Techniken werden dabei eingesetzt:

- Pan-Tilt-Systeme:

Mechanisch bewegliche Komponenten führen die Kamera mit Kameraoptik den Kopfbewegungen des Probanden nach. Aktuelle Systeme erreichen dabei Messraten von bis zu 120 Hz.

- Tilting-Mirror-Systeme:

Während Kamera und Optik raumfest bleiben erlauben servogetriebene Spiegel ein Nachverfolgen des Auges bei Kopfbewegungen.

- Fixed-Camera-Systeme:

Diese Systeme verzichten auf jegliche mechanisch bewegliche Komponenten und erzielen den Bewegungsfreiraum mittels Bildverarbeitungsmethoden.

Diese Varianten haben gegenüber der mobilen Bauart den Vorteil, dass sie Daten aufzeichnen, die eindeutig parametrisierbar sind und so einer statistischen Auswertung zugeführt werden können (es lässt sich also in exakten Werten angeben, zu welchem beliebigen Zeitpunkt die Person in welchen Bereich des Bildschirms geschaut hat). Während Remote-Eyetracker vorwiegend in der Markt- und Medienforschung zum Einsatz kommen (z. B. Nutzung von Webseiten, Blickbewegung beim Betrachten von Filmen), finden die Tower-Eyetracker in den Neurowissenschaften Verwendung (z. B. Forschung zu Mikrosakkaden).

Einfache Direktaufzeichnungen

Vor dem Aufkommen von komplexen Aufzeichnungsgeräten wurden einfache Filmaufzeichnungen eingesetzt, die durch Auswertung der Einzelbilder die Analyse der Augenbewegungen in bestimmten Fällen ermöglichten. Sie konnten dort eingesetzt werden, wo es genügte, die Blickpunkte oben, unten, rechts, links und Mitte zu erfassen. Zudem hatten diese den Vorteil, dass auch die Handbewegungen und der Gesichtsausdruck gesehen werden konnten.

Aufzeichnung mit der Webcam

Heutzutage werden auch vielfach Webcams für kosteneffektives Eye-Tracking eingesetzt. Einer der ersten kommerziellen Anbieter in diesem Bereich war die Firma GazeHawk, die 2013 von Facebook aufgekauft wurde.[12] Seitdem gab es weitere Aufkäufe von Webcam-Eyetracking-Anbietern, beispielsweise Sticky,[13] die 2017 von Tobii aufgekauft wurden.[14] Webcam-Eyetracker bietet die Möglichkeit, Daten zur Wahrnehmung innerhalb großer Stichproben zu relativ geringen Kosten zu erheben: Die Datenerhebung kann virtuell erfolgen, d. h. die Testteilnehmenden müssen nicht in ein Teststudio kommen. Da die Messung über die Webcam des Studienteilnehmenden erfolgt, fallen kaum Kosten für Geräte und Hardware an. Im Vergleich zu Infrarot-Eyetrackern liefern Webcam-Eyetracking-Studien weniger genaue Daten. Sie werden daher vor allem dann eingesetzt, wenn Varianten verglichen werden sollen, die sich konzeptionell deutlich unterscheiden.

Aufzeichnung mit der Computermaus

Moderne Verfahren wie das AttentionTracking ermöglichen eine Blickaufzeichnung mit Hilfe der Computermaus oder einem vergleichbaren Zeigegerät. Die Blickpunkte fallen in Form von Mausklicks an.

Komponenten von Eyetrackern

Die technische Ausführung eines Eyetrackers ist je nach Modell etwas unterschiedlich. Dennoch finden sich grundsätzliche Gemeinsamkeiten: jeder Eyetracker besitzt eine Augenkamera, eine Blickfeldkamera und eine Infrarot-Lichtquelle.

Darstellungsformen

Um Eye-Tracking-Daten visuell zu repräsentieren und Aufnahmen von einzelnen Personen oder aggregierten Personengruppen graphisch zu analysieren, werden verschiedene Visualisierungsverfahren verwendet. Die folgenden Visualisierungen sind die gängigsten:

- Gazeplot (alternativ Scanpath): Ein Gazeplot visualisiert die Reihenfolge und Dauer von Fixationen von einzelnen Personen. Die Reihenfolge wird dabei durch eine Nummerierung, die Dauer der Fixation über die Größe der Kreise abgebildet. Ein Gazeplot kann sowohl statisch über ein gewisses Zeitfenster als auch als Animation betrachtet werden (siehe Abbildung).

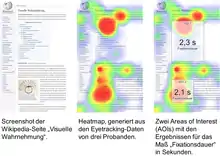

- Heatmap (alternativ Attentionmap): Eine Heatmap ist eine statische Visualisierung, die hauptsächlich für die aggregierte Darstellung mehrerer Personen verwendet wird. In dieser Repräsentation wird über eine Farbcodierung hervorgehoben wohin Personen lange und oft ihren Blick fixiert haben. Dadurch bietet sie einen guten Überblick, welche Regionen viel Aufmerksamkeit auf sich ziehen und welche Regionen ausgelassen werden.

Die Heatmap ist die am häufigsten verwendete Darstellung für Eye-Tracking-Daten, reicht aber für tiefere Analysen oft nicht mehr aus. Hier werden andere Visualisierungen oder statistische Methoden herangezogen, wie z. B. Parallel Scanpaths, Visualisierungen für spezielle Bereiche (Areas-of-Interest) oder Space-Time Cubes im 3D Raum.[16]

Gazeplot

Gazeplot Heatmap

Heatmap

Analyse von Eye-Tracking-Daten anhand von Areas of Interest (AOIs)

Eye-Tracking-Daten beschreiben, zu welchem Zeitpunkt eine Person welchen Punkt fixiert. Bei der Analyse werden die Daten in Bezug zu dem betrachteten Stimulus gesetzt. Im Usability-Bereich wird damit analysiert, welche Elemente einer Webseite betrachtet wurden, wie lange sie angeschaut wurden oder wann zuerst.

Dazu verwendet man Areas of Interest (AOIs). AOIs sind Bereiche, die manuell im Stimulus markiert werden und für die dann verschiedene Eye-Tracking-Maße berechnet werden. Es gibt eine Vielzahl an Maßen. Einige Maße berücksichtigen nur die Position der Fixationen, etwa „Number of Fixations“,[17] welches ausdrückt, wie viele Fixationen innerhalb einer AOI lagen. Maße werden auch häufig in Prozent ausgedrückt und zur Gesamtzahl der Fixationen auf einem Stimulus gesetzt.

Für das Maß „Total dwell time“,[17] auch Fixationsdauer, wird die Dauer der Fixationen aufaddiert. Es wird also die Gesamtdauer der Betrachtung einer AOI berechnet. Andere Maße berücksichtigen den Zeitpunkt bestimmter Fixationen. Das Maß „Time to First Fixation“[17] identifiziert den Zeitpunkt der ersten Fixation innerhalb einer AOI. Es drückt also aus, wie lange es gedauert hat, bis ein bestimmter Bereich zum ersten Mal betrachtet wurde. Die Berechnungen der Maße anhand von AOIs kann sowohl für die Daten eines einzelnen Probanden, also auch für die Daten mehrere Probanden durchgeführt werden. Dabei werden Durchschnittswerte über alle Probanden gebildet.

Die AOI-Analyse erlaubt es, Eye-Tracking-Daten quantitativ auszuwerten. Sie wird eingesetzt um z. B. die Aufmerksamkeitsverteilung innerhalb eines Stimulus, wie einer Webseite, zu beurteilen. Sie ist aber auch besonders geeignet um Eye-Tracking-Aufzeichnungen in A/B-Tests zu vergleichen, etwa auf verschiedenen Stimuli oder wenn zwei Probandengruppen miteinander verglichen werden sollen.

Anwendungsgebiete

Usability

Der Einsatz von Eye-Tracking-Analysen im Bereich der Software-Ergonomie ist weit verbreitet. Im Rahmen von Usability-Tests wird die Wahrnehmung von Versuchspersonen während der Ausführung von Aufgaben mit einer Software oder auf einer Webseite analysiert. Damit können Probleme etwa bei der Informationssuche oder der Interaktion identifiziert und die Softwareprodukte optimiert werden.[19][20]

Medizin

Die Laserbehandlung bei Fehlsichtigkeiten verdankt Ihren Erfolg u. a. dem Einsatz von Eye Trackern, welche sicherstellen, dass der Laser die Hornhaut an der geplanten Stelle behandelt und Augenbewegungen überwacht werden. Gegebenenfalls wird der Laser nachgeführt – oder aber abgeschaltet bis das Auge wieder die richtige Position hat. Andere Systeme werden in den Bereichen Neurologie, Gleichgewichtsforschung, Okulomotorik und Augenfehlstellungen eingesetzt. Auch in der Psychiatrie gewinnen Eye-Tracker immer mehr an Bedeutung: Mit Ihnen verbindet sich die Hoffnung, dadurch künftig zuverlässigere und frühere Diagnosen zu ermöglichen (z. B. bei Autismus oder ADHS).[21]

Neurowissenschaften

Eye Tracker werden als Vergleichssysteme bei funktioneller Bildgebung in Kernspintomographen (fMRI), bei Studien mit Magnetoenzephalographie-Geräten (MEG), oder Elektroenzephalografie (EEG)-Systemen eingesetzt.

Psychologie

- Bildwahrnehmung

- Bewegungswahrnehmung

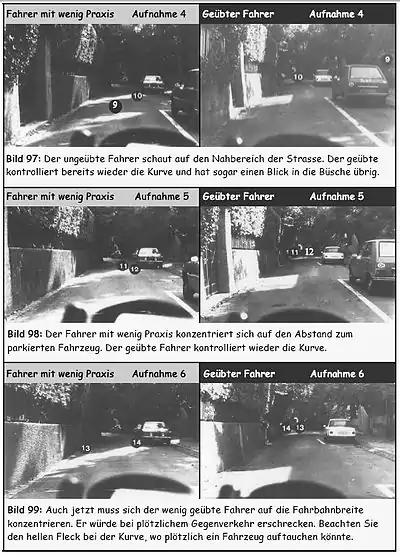

- Analyse von Lernfortschritten (Trainingsanalyse)

Marktforschung

- Packungsdesign

- Point-Of-Sale (POS)

- Werbung (Print, Online Analysen etc.)

Kommunikationswissenschaft

Informatik

- Aktivitätserkennung, wie Lesen oder Suchen[24][25][26]

- Benutzerauthentifizierung über Windows Hello[27]

- Anwendungen und Spiele für die Virtuelle Realität und Erweiterte Realität[28][29][30]; so sind in den neuesten Generationen von VR (z. B. HTC Vive Pro Eye[31]) und AR/MR Headsets (z. B. Microsoft Hololens 2[32]) erstmals Eyetracker direkt integriert.

Mensch-Maschine-Interaktion

- Computersteuerungen für körperlich beeinträchtigte Menschen durch eine Augenmaus. Meist repräsentiert dabei der Cursorpunkt den Blickpunkt. Eine Interaktion wird im Allgemeinen durch eine Fixation für eine bestimmte Zeit (dwell time) auf ein Objekt ausgelöst. Seit Windows 10 ist eine Augensteuerung für Benutzer mit Behinderungen integriert, um einerseits den Mauszeiger zu steuern, auf der anderen Seite aber auch die integrierte Bildschirmtastatur zu bedienen bzw. durch eine Text-zu-Sprache-Funktion mit anderen Menschen zu kommunizieren[33].

- Zur Adaption von autostereoskopischen Displays an den Betrachterstandpunkt. Der Bildschirminhalt und/oder der vor dem Bildschirm befindliche Strahlteiler wird so verändert, dass die jeweils passende Stereoteilbild beim linken, bzw. rechten Auge ankommt.

- Interaktion in Computerspielen. Mehr als 100 Spiele (u. a. Tom Glancy's The Division, Far Cry) unterstützen bereits Eyetracking Funktionen, wie z. B. blickgesteuertes Zielen, verschieben des Sichtfeldes je nach Blickpunkt oder ein scharfes Rendering der Darstellung im Bereich des Blickpunktes, während der restliche Bildschirm leicht unscharf bleibt (Foveated Rendering)[34].

Datenschutz

Vor dem Hintergrund, dass Eye-Tracking voraussichtlich in Geräten wie Smartphones,[35] Laptops[36] und Virtual-Reality-Headsets[37][38] breitflächig zum Einsatz kommen soll, wurden bereits Bedenken hinsichtlich möglicher Auswirkungen auf die Privatsphäre von Verbrauchern geäußert.[39][40] Mit Methoden des maschinellen Lernens können aus Eye-Tracking-Daten Informationen über Persönlichkeitsmerkmale, ethnische Herkunft, Ängste, Emotionen, Interessen, Fähigkeiten und den körperlichen und psychischen Gesundheitszustand von Nutzern abgeleitet werden.[41] Augenbewegungen können nicht immer bewusst kontrolliert werden. So ereignen sich beispielsweise impulsgesteuerte Blicke, Pupillenerweiterung, Augenzittern und spontanes Blinzeln meist unwillkürlich, ähnlich wie interne Prozesse der Verdauung und Atmung.[41] Daher kann es für Eye-Tracking-Nutzer schwierig oder sogar unmöglich sein, die Menge an preisgegebenen persönlichen Informationen abzuschätzen oder zu kontrollieren.

Literatur

- Alan Dix, Janet Finlay, Gregory Abowd, RussellBeale: Mensch, Maschine, Methodik. Prentice Hall, New York NY u. a. 1995, ISBN 3-930436-10-8.

- Andrew Duchowski: Eye Tracking Methodology. Theory and Practice. 2. Auflage. Springer, London 2007, ISBN 978-1-84628-608-7.

- Frank Lausch: Splitscreen als spezielle Werbeform im TV. Eine explorative Studie zur Rezeption von TV Inhalten mit Hilfe von Eyetracking. AV Akademikerverlag, Saarbrücken 2012, ISBN 978-3-639-39093-3 (Zugleich: Ilmenau, Technische Universität, Masterarbeit, 2011).

Weblinks

Einzelnachweise

- Andreas M. Heinecke: Mensch-Computer-Interaktion: Basiswissen für Entwickler und Gestalter. 2011.

- Tobias C. Breiner: Farb- und Formpsychologie. ISBN 978-3-662-57869-8, S. 111–117, doi:10.1007/978-3-662-57870-4_7.

- Danny Nauth: Durch die Augen meines Kunden: Praxishandbuch für Usability Tests mit einem Eyetracking System. 2012, S. 17.

- Christian Bischoff, Andreas Straube: Leitlinien Klinische Neurophysiologie. 2014, S. 63 ff.

- Fiona J. Williams, Daniel S. Mills, Kun Guo: Development of a head-mounted, eye-tracking system for dogs. In: Journal of neuroscience methods. Band 194, Nr. 2, Januar 2011, ISSN 1872-678X, S. 259–265, doi:10.1016/j.jneumeth.2010.10.022. PMID 21074562.

- Alfred L. Yarbus: Eye Movements and Vision. Plenum Press, New York NY 1967 (Russische Originalausgabe 1964: А. Л. Ярбус: Роль Движения Глаз в Процессе Зрения. Москва).

- Edmund Burke Huey: The psychology and pedagogy of reading. With a review of the history of reading and writing and of methods, texts, and hygiene in reading (= MIT Psychology. Band 86). MIT Press, Cambridge MA u. a. 1968.

- zit. in: Hans-Werner Hunziker: Im Auge des Lesers. Vom Buchstabieren zur Lesefreude. Foveale und periphere Wahrnehmung. transmedia Verlag Stäubli AG, Zürich 2006, ISBN 3-7266-0068-X.

- Andrew H. Clarke: Vestibulo-oculomotor research and measurement technology for the space station era. In: Brain Research Reviews. Band 28, Nr. 1/2, ISSN 0165-0173, S. 173–184, doi:10.1016/S0165-0173(98)00037-X.

- Andrew H. Clarke, Caspar Steineke, Harald Emanuel: High image rate eye movement measurement. In: Alexander Horsch (Hrsg.): Bildverarbeitung für die Medizin 2000. Algorithmen, Systeme, Anwendungen. Proceedings des Workshops vom 12.–14. März 2000 in München. Springer, Berlin u. a. 2000, ISBN 3-540-67123-4, S. 398–402, doi:10.1007/978-3-642-59757-2_75.

- Hans-Werner Hunziker: Visuelle Informationsaufnahme und Intelligenz: Eine Untersuchung über die Augenfixationen beim Problemlösen. In: Psychologie. Schweizerische Zeitschrift für Psychologie und ihre Anwendungen. Band 29, Nr. 1/2, 1970, ISSN 0033-2976, S. 165–171.

- gazehawk.com (Memento des Originals vom 22. August 2016 im Internet Archive) Info: Der Archivlink wurde automatisch eingesetzt und noch nicht geprüft. Bitte prüfe Original- und Archivlink gemäß Anleitung und entferne dann diesen Hinweis.

- sticky.com

- Tobii acquires Sticky, a leading solution provider for market research studies based on webcam eye tracking. 17. Mai 2017, abgerufen am 20. Januar 2021.

- A. H. Clarke, J. Ditterich, K. Drüen, U. Schönfeld, C. Steineke: Using high frame rate CMOS sensors for three-dimensional eye tracking. In: Behavior Research Methods, Instruments, & Computers. Band 34, Nr. 4, November 2002, ISSN 0743-3808, S. 549–560, doi:10.3758/BF03195484.

- T. Blascheck, K. Kurzhals, M. Raschke, M. Burch, D. Weiskopf, T. Ertl: State-of-the-art of visualization for eye tracking data. In: Proceedings of EuroVis. 2014.

- Holmqvist, K., Nyström, M., Andersson, R., Dewhurst, R., Jarodzka, H., & Van de Weijer, J.: Eye tracking : a comprehensive guide to methods and measures. Oxford University Press, Oxford 2011, ISBN 978-0-19-969708-3.

- Hans-Werner Hunziker: Im Auge des Lesers. Vom Buchstabieren zur Lesefreude. Foveale und periphere Wahrnehmung. Transmedia, Zürich 2006, ISBN 3-7266-0068-X, S. 67 (Nach Daten von A. S. Cohen: Informationsaufnahme beim Befahren von Kurven. In: Psychologie für die Praxis. Bulletin der Schweizerischen Stiftung für angewandte Psychologie, SSAP. Band 2, 1983).

- Jakob Nielsen, Kara Pernice: Eyetracking Web Usability. New Riders Publishing, Thousand Oaks, CA, USA 2009, ISBN 978-0-321-49836-6.

- Jennifer Romano Bergstrom, Andrew Schal: Eye Tracking in User Experience Design. Morgan Kaufmann, 2014, ISBN 978-0-12-416709-4.

- K. Bartl-Pokorny, F. Pokorny u. a.: Eye-Tracking: Anwendung in Grundlagenforschung und klinischer Praxis. In: Klinische Neurophysiologie. 44, 2013, S. 193–198, doi:10.1055/s-0033-1343458.

- Sabrina Heike Kessler, Niels G. Mede, Mike S. Schäfer: Eyeing CRISPR on Wikipedia: Using Eye Tracking to Assess What Lay Audiences Look for to Learn about CRISPR and Genetic Engineering. In: Environmental Communication. 11. März 2020, ISSN 1752-4032, S. 1–18, doi:10.1080/17524032.2020.1723668 (tandfonline.com [abgerufen am 14. März 2020]).

- Sabrina Heike Kessler, Arne Freya Zillich: Searching Online for Information About Vaccination: Assessing the Influence of User-Specific Cognitive Factors Using Eye-Tracking. In: Health Communication. Band 34, Nr. 10, 24. August 2019, ISSN 1041-0236, S. 1150–1158, doi:10.1080/10410236.2018.1465793 (tandfonline.com [abgerufen am 14. März 2020]).

- Andreas Bulling, Jamie A. Ward, Hans Gellersen, Gerhard Tröster: Robust Recognition of Reading Activity in Transit Using Wearable Electrooculography. In: Pervasive computing. 6th international conference, Pervasive 2008, Sydney, Australia, May 19–22, 2008. Proceedings. (= Lecture Notes in Computer Science. 5013). Springer, Berlin u. a. 2008, ISBN 978-3-540-79575-9, S. 19–37, doi:10.1007/978-3-540-79576-6_2.

- Andreas Bulling, Jamie A. Ward, Hans Gellersen, Gerhard Tröster: Eye Movement Analysis for Activity Recognition. In: UbiComp '09. Proceedings of the 11th ACM International Conference on Ubiquitous Computing, September 30 – October 3, 2009, Orlando, Florida, USA. Association for Computing Machinery, New York NY 2009, ISBN 978-1-60558-431-7, S. 41–50, doi:10.1145/1620545.1620552.

- Andreas Bulling, Jamie A. Ward, Hans Gellersen, Gerhard Troster: Eye Movement Analysis for Activity Recognition Using Electrooculography. In: IEEE Transactions on Pattern Analysis and Machine Intelligence. Band 33, Nr. 4, April 2011, ISSN 0162-8828, S. 741–753, doi:10.1109/TPAMI.2010.86.

- heise online: Windows 10 mit Blicken steuern. Abgerufen am 21. Mai 2019.

- Matthias Bastian: 11 Millionen US-Dollar für Virtual-Reality-Brille FOVE. auf: vrodo.de, 23. März 2016.

- Matthias Bastian: Virtual Reality: Eye-Tracking “kostet nur wenige US-Dollar”. auf: vrodo.de, 3. Januar 2016.

- Volker Briegleb: MWC 2016: Eyetracking senkt die Grafiklast bei Virtual Reality. auf heise.de, 22. Februar 2016.

- Matthias Bastian: Vive Pro Eye: Weshalb HTC Eye-Tracking verbaut hat. In: News zu VR, AR und KI | Into Mixed Reality. 14. Januar 2019, abgerufen am 21. Mai 2019 (deutsch).

- Michael Leitner: Angetestet: Wir haben die Microsoft HoloLens 2 für dich ausprobiert. Abgerufen am 21. Mai 2019.

- Erste Schritte mit der Augensteuerung in Windows 10. Abgerufen am 21. Mai 2019.

- Tobii – Eye-Tracking der Zukunft für Office, Adobe Photoshop, TV und Games. In: Trends der Zukunft. Abgerufen am 21. Mai 2019 (deutsch).

- Ben Dickson: Unlocking the potential of eye tracking technology. In: TechCrunch. 19. Februar 2017. Abgerufen am 8. April 2021.

- Venkateshwar Reddy: Eye Tracking Technology: Applications & Future Scope. In: IndustryARC. 15. April 2019. Abgerufen am 8. April 2021.

- Sol Rogers: Seven Reasons Why Eye-tracking Will Fundamentally Change VR. In: Forbes. 5. Februar 2019. Abgerufen am 13. Mai 2020.

- Scott Stein: Eye tracking is the next phase for VR, ready or not. In: CNET. 31. Januar 2020. Abgerufen am 8. April 2021.

- Jay Stanley: The Privacy-Invading Potential of Eye Tracking Technology. In: American Civil Liberties Union. 6. Mai 2013. Abgerufen am 8. April 2021.

- Loz Blain: Eye tracking can reveal an unbelievable amount of information about you. In: New Atlas. 29. März 2021. Abgerufen am 8. April 2021.

- Jacob Leon Kröger, Otto Hans-Martin Lutz, Florian Müller: What Does Your Gaze Reveal About You? On the Privacy Implications of Eye Tracking. In: M. Friedewald, M. Önen, E. Lievens, S. Krenn, S. Fricker (Hrsg.): Privacy and Identity Management. Data for Better Living: AI and Privacy. Privacy and Identity 2019. Band 576. Springer, 2020, ISSN 1868-4238, S. 226–241, doi:10.1007/978-3-030-42504-3_15.