Intelligenzquotient

Der Intelligenzquotient (IQ) ist eine durch einen Intelligenztest ermittelte Kenngröße zur Bewertung des intellektuellen Leistungsvermögens im Allgemeinen (allgemeine Intelligenz) oder innerhalb eines bestimmten Bereichs (z. B. Faktoren der Intelligenz) im Vergleich zu einer Referenzgruppe.[1] Er bezieht sich stets auf den jeweiligen Test, denn eine wissenschaftlich anerkannte, eindeutige Definition von Intelligenz existiert nicht.[2][3]

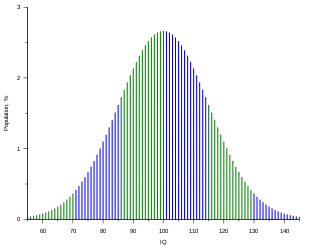

Die „bevölkerungsrepräsentative“ Referenzgruppe kann alters- bzw. schulklassenspezifisch sein (v. a. bei Kindern und Jugendlichen) oder spezifisch für Bildungsgrade (beispielsweise Gymnasiasten oder Berufsgruppen) (vergleiche Normierung). Bei den heutigen Tests, die eine IQ-Norm verwenden, wird anhand der Verteilung der Testergebnisse einer hinreichend großen Stichprobe der Normwert unter Annahme einer Normalverteilung der Intelligenz meist durch Normalrangtransformation ermittelt und in eine Skala mit dem Mittelwert 100 und der Standardabweichung 15 umgerechnet. Entsprechend einer Normalverteilung haben rund 68 % der Personen dieser Referenzgruppe einen IQ im sogenannten Mittelbereich (bei dem sich die größte Wahrscheinlichkeitsmasse der Dichtefunktion befindet) zwischen 85 und 115.

Unterschiede ergeben sich aus der Repräsentativität der Normierungsstichprobe für diese Referenzgruppe (Größe der Stichprobe, Repräsentativität beim Gewinnen der Personen). Bei der Interpretation des IQ muss die Art des Messverfahrens (z. B. Art des Intelligenztests) und das dahinterstehende Intelligenzkonzept sowie die für die Normierung verwendete Referenzgruppe beachtet werden, welche die Stabilität und die Generalisierbarkeit der Schätzung der Intelligenz einer Person beeinflussen. Die Normen müssen auch hinsichtlich der zeitlichen Stabilität geprüft und bei Veraltung neu ermittelt werden.

Neben anderen Fachgebieten beschäftigt sich die Kognitionswissenschaft auch mit der Messung von Intelligenz.

Berechnungen

Historisch

Alfred Binet, der 1905 mit dem Binet-Simon-Test den ersten brauchbaren Intelligenztest entwickelt hatte, gab die mentale Leistungsfähigkeit als Intelligenzalter an. Der Test bestand aus Aufgaben mit ansteigender Schwierigkeit, die möglichst trennscharf für die jeweiligen Altersgruppen lösbar sein sollten. Beispiel: Ein durchschnittlich entwickelter Achtjähriger sollte alle Aufgaben seiner Altersgruppe (und darunter) lösen können, nicht jedoch die Aufgaben der Neunjährigen. Schaffte ein Kind nicht alle Aufgaben seiner Altersgruppe, hatte es ein niedrigeres, schaffte es auch Aufgaben der höheren Altersgruppe, hatte es ein höheres „Intelligenzalter“.

William Stern setzte dieses Intelligenzalter ins Verhältnis zum Lebensalter und erfand so 1912 an der Universität Breslau den Intelligenzquotienten.[4]

Lewis M. Terman von der Universität Stanford entwickelte den von Goddard vom Französischen ins Englische übersetzten Simon-und-Binet-Quotienten weiter. Um die Kommastellen zu entfernen, multiplizierte er den Intelligenzalter-Lebensalter-Quotienten mit 100.

Modern

Da das Intelligenzalter langsamer zunimmt als das Lebensalter, sinkt der IQ nach Sterns Formel beständig. Terman erkannte dieses Problem bei seiner Weiterentwicklung ebenfalls. Um diesem Problem zu begegnen, normierte er den Test für verschiedene Altersgruppen. Die Verteilung glich er für jedes Alter einer Normalverteilung an. Beim 1937 entwickelten Stanford-Binet-Test variiert die Standardabweichung je nach Alter zwischen 15 und 16 IQ-Punkten (vgl. Valencia und Suzuki, 2000, S. 5 ff.).[5]

Die ursprünglich nur für Kinder, speziell für Schulreifetests, entwickelte IQ-Berechnung wurde später von David Wechsler durch Anwendung der populationsbezogenen Skalierung mit dem Mittelwert 100 auf Erwachsene ausgedehnt. Für die heutige Abweichungs-IQ-Skala gilt ein Mittel von 100 und eine Standardabweichung (SD) von 15. Sie findet z. B. Anwendung in der Hamburg-Wechsler-Intelligenztestreihe.[6] Da der IQ in der Öffentlichkeit als „Label“ von Personen beispielsweise hinsichtlich Stabilität und Universalität überschätzt wird, verwenden einige Tests bewusst andere Normskalen.

Umrechnungen

Man kann auch andere Normenskalen festlegen, wie etwa den Prozentrang (Perzentile). Über den Bezug zur Normalverteilung lassen sich Werte aus anderen Skalierungen in eine IQ-Skala mit dem Mittelwert 100 ohne Informationsverlust umrechnen:

(Siehe auch Standardisierung (Statistik)). Dabei bedeuten

- ermittelter Skalenwert im verwendeten Test

- Mittelwert der verwendeten Skala

- Standardabweichung der verwendeten Skala

Beispiel

Der IST-2000 verwendet die so genannte Standardwert-Skala (SW), die einen Mittelwert von 100 und eine Standardabweichung von 10 aufweist. Hat eine Person einen Standardwert von 110 erzielt, lässt sich dieser wie folgt in einen IQ-Normwert umrechnen:

Eingesetzt:

Da 110 der Standardwertskala genau eine Standardabweichung über dem Mittelwert liegt, muss gleiches auch für den AW-IQ-Wert gelten. Und, wie berechnet, trifft dies mit einem Wert von 115 auch zu. Einem AW-IQ-Wert von 85, der genau eine Standardabweichung unter dem Mittelwert liegt, entspricht ein IST-Wert von 90 (vgl. dazu auch Lineare Transformation).

Zuverlässigkeit und Messfehler

Bei der Interpretation von Ergebnissen sind der Messfehler und die in Kauf zu nehmende Irrtumswahrscheinlichkeit zu beachten (vgl. Fehler 1. Art). Die Irrtumswahrscheinlichkeit determiniert die Länge des Vertrauensintervalls. Letzteres wird von der notwendigen Sicherheit der zu treffenden diagnostischen Entscheidung beeinflusst.

Im Jahr 2014 hatte der Oberste Gerichtshof der USA darüber zu entscheiden, bis zu welchem IQ ein Täter als unzurechnungsfähig zu gelten habe und daher im Falle eines Todesurteils nicht hingerichtet werden dürfe. In diesem Prozess argumentierten die American Psychological Association und die American Association on Intellectual and Developmental Disabilities, dass IQ-Tests eine Fehlermarge von 10 Punkten nach oben und unten aufweisen.[7]

Die Intelligenztests müssen regelmäßig neu normiert (bzw. die Gültigkeit der Normen überprüft) werden, um den Durchschnittswert bei 100 zu halten. Bis in die 1990er Jahre hatten die IQ-Tests in den Industrieländern einen stetig steigenden Durchschnitt gezeigt. Über die Ursache dieses „Flynn-Effekts“ herrscht keine Einigkeit, etwa eine gleichmäßiger ausgeprägte Schulbildung oder der informative Einfluss von Massenmedien. Die Zahlenwerte sind ohne Kenntnis des zugrundeliegenden Tests und dessen Normierung nicht vergleichbar. Als Richtwert für die Überprüfung gelten acht Jahre, der in der DIN 33430 für den Bereich Eignungsdiagnostik vorgeschlagen wird.

Literatur

- Jürgen Guthke: Ist Intelligenz messbar? Einführung in Probleme der psychologischen Intelligenzforschung und Intelligenzdiagnostik. 2. Auflage. Deutscher Verlag der Wissenschaften, Berlin 1980.

- Walter Gutjahr: Die Messung psychischer Eigenschaften. Kiepenheuer und Witsch, Köln 1977, ISBN 3-462-01116-2.

- Siegfried Lehrl: Arbeitsspeicher statt IQ. Vless, Ebersberg 1997, ISBN 3-88562-079-0.

- Nicholas Mackintosh: IQ and Human Intelligence. Oxford University Press, Oxford 1998, ISBN 0-19-852368-8.

Weblinks

- „Die Intelligenzforschung ist eigentlich von jeher umstritten“ Der Arzt Thomas Grüter zum 100. Jahrestag der Erfindung des IQ. Deutschlandfunk, 19. April 2012.

- e-fellows.net: Wie gut sind Online-Intelligenztests wirklich?

Einzelnachweise

- Intelligenzquotient. In: DORSCH Lexikon der Psychologie. 18. Auflage.

- neuronation.de: Definition der Intelligenz - was ist das eigentlich?, abgerufen 16. Januar 2019

- tagesspiegel.de: Intelligentes Leben, abgerufen am 16. Januar 2019.

- W. Stern: Die psychologischen Methoden der Intelligenzprüfung und deren Anwendung an Schulkindern. Verlag von Johann Ambrosius Barth, Leipzig 1912.

- R. R. Valencia, L. A. Suzuki: Intelligence Testing and Minority Students: Foundations, Performance Factors, and Assessment Issues. Sage, New York 2000.

- P. G. Zimbardo: Psychologie. Springer, Heidelberg 1995, S. 529 ff.

- US Supreme Court strikes IQ cutoff for death penalty cases. Auf: nature.com vom 27. Mai 2014.