Generative Grammatik

Generative Grammatik (lateinisch generare ‚erzeugen‘ und ‚Grammatik‘) ist der Oberbegriff für Grammatik-Modelle, mit deren Regelsystem sich die Sätze einer Sprache – im Gegensatz zu den ausschließlich die Phänomene beschreibenden Sprachlehren – generieren lassen. Hauptvertreter ist Noam Chomsky mit der von ihm entwickelten generativen Transformationsgrammatik, die im Rahmen der sogenannten Linguistics Wars kontrovers diskutiert und – als Reaktion darauf – in verschiedenen Varianten verändert wurde. In diesem Zusammenhang entstanden auch weitere, alternative, generative Grammatik-Konzeptionen.

Ausgangsfrage: Woher „weiß“ der Mensch zu sprechen?

Die grundlegende Antwort der generativen Grammatik auf diese Frage lautet: Das Vermögen des Menschen zu sprechen, d. h. grammatikalisch korrekte Aussagen zu machen, fußt auf kognitiven Strukturen, die genetisch vererbt sind. Mit dieser Annahme grenzt sich die generative Grammatik vom Behaviorismus ab, der davon ausgeht, dass der Mensch ohne angeborene Fähigkeiten – als tabula rasa – geboren wird und so das Sprechen ausschließlich durch Imitation seiner Umwelt lernen muss. (In diesem Kontext wird in der Linguistik von der kognitiven Wende gesprochen.) Zwar lernen Kinder das „Wortmaterial“ durch ihre Umwelt kennen – die Anlagen jedoch zu dem Wissen, wie dieses Material grammatisch korrekt zu Sätzen verarbeitet werden kann, d. h. wie „richtige“ Sprache erzeugt wird, sind genetisch vererbt. Im Prozess des Spracherwerbs werden diese Anlagen zu konkreten Sprachbildungsfähigkeiten einer bestimmten Sprache ausgebildet.[1]

Verwendung

Häufig wird der Begriff auch synonym zu generative Transformationsgrammatik verwendet, womit alle generativen Grammatiken mit Transformationsregeln gemeint sind. Allerdings gibt es auch eine weitere Auffassung des Begriffs „generative Grammatik“, unter die dann auch alternative Grammatik-Modelle wie die Head-driven Phrase Structure Grammar („kopfgesteuerte Phrasenstrukturgrammatik“) oder die lexikalisch-funktionale Grammatik fallen. Die formalen Grundlagen dieser Ansätze wurden jedoch in den 1990er Jahren überarbeitet, so dass diese Modelle nicht mehr zu den generativen Grammatiken im engeren Sinne gehören.[2][3]

In den meisten Fällen ist eine generative Grammatik in der Lage, mithilfe rekursiver Regeln aus einer endlichen Zahl von Lexemen eine unendliche Zahl an Sätzen zu generieren. Diese Eigenschaft ist sehr wünschenswert für ein Modell natürlicher Sprachen, da menschliche Gehirne nur eine endliche Kapazität haben, die Anzahl der möglichen grammatischen Sätze jeder Einzelsprache aufgrund deren Rekursivität aber unendlich ist.

Abgrenzungen

Generative Grammatik muss von traditioneller Grammatik unterschieden werden, da Letztere oft stark präskriptiv (statt deskriptiv) und nicht mathematisch explizit ist und sich meist mit einer relativ kleinen Menge einzelsprachspezifischer syntaktischer Phänomene befasst. Genauso sollte die generative Grammatik von anderen deskriptiven Herangehensweisen unterschieden werden, wie z. B. den verschiedenen funktionalen Grammatiktheorien.

Generative Grammatik und Strukturalismus

Die generative Transformationsgrammatik zählt zum modernen amerikanischen Strukturalismus,[4] von anderen werden die Unterschiede zum herkömmlichen Strukturalismus betont.[5] Die generative Grammatik soll einen Paradigmenwechsel von der strukturalistischen Sprachwissenschaft weg vollzogen[6] und „eine grundlegende Neuorientierung in die Sprachwissenschaft gebracht“ haben.[5]

Als Unterschiede zwischen dem Strukturalismus (dann im engeren Sinn) und der generativen Transformationsgrammatik werden benannt:[7]

| Strukturalismus | generative Transformationsgrammatik |

|---|---|

| beschreibend | erzeugend |

| statisch (endliches Corpus) | dynamisch, Sprache als enérgeia |

| von der parole realer Sprecher ausgehend |

von der langage (= Kompetenz) des idealen Sprechers ausgehend |

| empirisch | mentalistisch[7] |

| Orientierung an den Naturwissenschaften | Orientierung am philosophischen Rationalismus |

| Orientierung am Positivismus | Orientierung an mathematischen und automaten-theoretischen Modellen |

Chomskys Syntax-betonte generative Grammatik

Spricht man von generativer Grammatik, ist zumeist die von Chomsky entwickelte gemeint, die zwar mit der Standardtheorie auch semantische Komponenten (Weiteres unter: Interpretative Semantik) einbezog, jedoch syntaktische betonte.

Entwicklungsstadien der generativen Grammatik Chomskys

Die generative Grammatik hat bei Chomsky mehrere Entwicklungsstadien durchlaufen:[6][8]

- 1955–1964: frühe Transformationsgrammatik (Chomskys Syntactic Structures)

- 1965–1970: Standardtheorie (ST)

- 1967–1980: Erweiterte Standardtheorie (EST) bzw. Revidierte Erweiterte Standardtheorie (REST) (Konzept der Modularität)

- seit 1980: Government and Binding Theory (GB)

- 1990er Jahre: „Minimalistisches Programm“

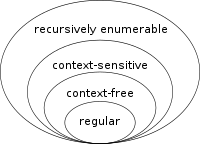

Bezug zur Chomsky-Hierarchie

Generative Grammatiken können mit Hilfe der Chomsky-Hierarchie verglichen und beschrieben werden, die von Noam Chomsky in den 50er Jahren entworfen wurde. Diese ordnet eine Reihe von verschiedenen Typen formaler Grammatiken nach ansteigender expressiver Kraft. Sie unterscheiden sich durch ihre Symbol- (Terminal- und Nichtterminal-Symbole) und Produktionsregelsysteme und müssen verschiedenen genau festgelegten Überprüfungsmethoden (z. B. durch Turingmaschinen) genügen. Typ 0 (uneingeschränkt formale Grammatiken) schließt alle formalen Grammatiken ein. Die einfachsten Typen sind die regulären Grammatiken (Typ 3). Nach Chomsky sind sie nicht zur Abbildung natürlicher Sprachen geeignet, da sie keine Sätze in einer hierarchischen Anordnung (Hypotaxe) modellieren können, welche seiner Meinung nach für das menschliche Kommunikationssystem typisch ist.

Diesen Anforderungen werden dagegen die auf einer höheren Komplexitätsstufe stehenden kontextsensitiven Grammatiken (Typ 1) und kontextfreien Grammatiken (Typ 2) gerecht, z. B. Chomskys „Phrasenstrukturgrammatik“, in der die Ableitung eines Satzes als Baumstruktur dargestellt wird. Sprachwissenschaftler, die im Feld der generativen Grammatik arbeiten, betrachten solche Bäume oft als ihr hauptsächliches Studienobjekt. Dieser Ansicht zufolge sind Sätze nicht nur Ketten von Wörtern, sondern Bäume mit unter- und übergeordneten Ästen, die durch Knotenpunkte verbunden sind.

Das Baummodell funktioniert in etwa wie in diesem Beispiel, in dem S ein Satz ist, D ein Determinierer, N ein Nomen, V ein Verb, NP eine Nominalphrase und VP eine Verbalphrase:[9]

S

/ \

NP VP

/ \ / \

D N V NP

Der Hund fraß / \

D N

den Knochen

- S – Satz

- D – Determinierer

- N – Nomen

- V – Verb

- NP – Nominalphrase

- VP – Verbalphrase

- Aux – Hilfsverben

- A – Adjektive

- Adv – Adverbien

- P – Präpositionen

- Pr – Pronomen

- C – Komplementierer

Der generierte Satz lautet „Der Hund fraß den Knochen“. Ein solches Baumdiagramm wird auch als Phrasenstrukturmodell bezeichnet. Derartige Baumdiagramme lassen sich aufgrund der zugrundegelegten Regeln automatisch generieren (siehe Weblinks).

Der Baum kann auch als Text dargestellt werden, auch wenn dieser schwieriger zu lesen ist:

[S [NP [D Der ] [N Hund ] ] [VP [V fraß ] [NP [D den ] [N Knochen ] ] ] ]

Chomsky gelangte zu der Erkenntnis, dass auch die Phrasenstruktur nicht ausreicht, um natürliche Sprachen zu beschreiben. Um das zu beheben, formulierte er das komplexere System der Transformationsgrammatik.

Wurzeln und Parallelen

- Cartesianische Logik

- Chomsky griff bei seinen Überlegungen auf die Cartesianische Logik (s. Cartesianische Linguistik[10]) zurück.[4] Ziel der generativen Transformationsgrammatik „ist es also, durch ein System von expliziten Regeln das implizite Wissen von Sprache abzubilden und damit eine logisch begründete Theorie über das Denken der Menschen zu schaffen“[11], womit „die aufklärerische Idee logischer Formen“[11] fortgesetzt wird.

- Proposition und Satz-Lexem

- Die Transformationsgrammatik „zeigt die rein formalen Methoden, wie man einen sprachlichen Ausdruck einer Frage in den eines Befehls z. B. umformt, und setzt dafür bei beides[m?] eine gemeinsame Basis voraus (deep structure)“.[12] Die Tiefenstruktur soll dem Satz-Lexem bei Menne entsprechen.[12] Das Satz-Lexem korrespondiert mit der Proposition.

- Kognitive Psychologie

- „Bei Chomsky dient die Analyse der Sprache letztlich dazu, Aufbau und Funktionsweise des menschlichen Gehirns zu erforschen, für ihn wird die Linguistik etwas wie die Teildisziplin der Kognitiven Psychologie“.[13] Kritisiert wird, dass alle Versuche der Sprachpsychologie zeigen sollen, dass die generative Grammatik „ein logisches, kein psychologisches Modell“ ist.[14]

Semantisch orientierte generative Grammatik George Lakoffs (generative Semantik)

Die generative Semantik ist eine generative Grammatik, die im Gegensatz zu der von Chomsky (der generativen Grammatik i. e. S.) „der Semantik primäre Wichtigkeit vor der Syntax einräumte“.[15] Sie entstand in kritischer Auseinandersetzung mit der generativen Transformationsgrammatik.[16] Sie ist eine „Grammatik-Theorie, in der statt der Syntax die Semantik generative Komponente und Basis der Satzbildung ist“.[16] Hauptvertreter der generativen Semantik ist George Lakoff.[17]

In der generativen Semantik ist die Tiefenstruktur eine abstrakte semantische und die Oberflächenstruktur eine normalsprachliche syntaktisch korrekte Repräsentationsebene.

Die generative Semantik erreicht durch eine Veränderung der Verb-Subjekt-Objekt-Beziehungen eine Verringerung der Projektionsregeln: V ist nicht mehr VP untergeordnet (Baumgraph s. o.: fraß den Knochen), sondern in Anlehnung an die Prädikatenlogik (V = Prädikat fordert NP (1) bzw. NP (2) und NP (3) als Ergänzungen/Argumente) wird V dem S-Knoten direkt unterstellt. Dadurch ergeben sich die Beziehungen V (fraß) → NP (Subj.: der Hund) und V → NP (Obj.: den Knochen) ohne Umweg und das Modell kommt mit weniger Ableitungsregeln aus. Außerdem ermöglicht das GS-System eine „Zerlegung einzelner Lexeme in semantische Merkmale (Dekomposition) und Durchführung von Transformationen bereits vor Einsetzung der Lexeme in den Stammbaum (= prälexikalische Transformationen)“. Das heißt: Beim Auswahlverfahren der sprachlich korrekten Sätze wird die Wortbedeutung in einem früheren Stadium beteiligt als bei der interpretativen Semantik mit ihren getrennten, aufeinander folgenden Syntax- und Semantik-Tests. Dadurch werden die Möglichkeiten begrenzt.

Kritiker der generativen Semantik[18] führen ins Feld, dass die Tiefenstruktur „hochgradig abstrakt“ und entsprechend der Transformationsteil „äußerst komplex“ sei. Auch sei der Grundsatz von der Bedeutungserhaltung der Transformationen nicht durchgängig aufrechtzuerhalten, oder mit anderen Worten: die syntaktischen Strukturverhältnisse bestimmten die semantische Interpretation mit.

Auswirkungen

Die generative Grundidee Chomskys wurde durch Fred Lerdahl und Ray Jackendoff auch zur Beschreibung einer möglichen musikalischen Grammatik aufgegriffen. Der französische Komponist Philippe Manoury übertrug das System der generativen Grammatik auf den Bereich der Musik. Auch im Bereich der computergestützten, algorithmischen Komposition findet die generative Grammatik ihre Anwendung, bspw. bei der Ordnung der musikalischen Syntax in Lisp-basierenden Programmiersprachen wie Open Music oder Patchwork.[19][20] Musikalische Formensprache ist generell nur innerhalb bestimmter, eng aufgefasster Stile als syntaktisch organisierte Grammatik zu beschreiben. Eine generelle Syntax, etwa der westlichen Grundton-basierten Musik (Western tonal music) konnte bisher nicht nachgewiesen werden.[21]

Literatur

- Jule Philippi und Michael Tewes: Basiswissen generative Grammatik, Vandenhoeck & Ruprecht, Göttingen 2010, ISBN 978-3-8252-3317-4 (UTB).[22][23]

Weblinks

- Kleine Einführung in die Generative Grammatik

- A. Max: The Syntax Student’s Companion. Java-Applet zur Generierung von Baumdiagrammen

Einzelnachweise

- Monika Schwarz: Einführung in die kognitive Linguistik. Francke, Tübingen/ Basel 1996, ISBN 3-7720-1695-2, S. 13–15.

- Geoffrey K. Pullum, Barbara C. Scholz: On the Distinction between Generative-Enumerative and Model-Theoretic Syntactic Frameworks. In: Logical Aspects of Computational Linguistics: 4th International Conference (= Lecture notes in computer science). Nr. 2099. Springer Verlag, Berlin 2001, ISBN 3-540-42273-0.

- Stefan Müller: Grammatiktheorie (= Stauffenburg Einführungen. Nr. 20). Stauffenburg, Tübingen 2010, ISBN 978-3-86057-294-8, 11.2 (hpsg.fu-berlin.de).

- Dietrich Homberger: Sachwörterbuch zur Sprachwissenschaft. Reclam, Stuttgart 2000, ISBN 3-15-010471-8 (Strukturalismus).

- Heidrun Pelz: Linguistik. Eine Einführung. Hoffmann und Campe, Hamburg 1996, ISBN 3-455-10331-6, S. 169 ff.

- Michael Dürr, Peter Schoblinski: Deskriptive Linguistik: Grundlagen und Methoden. 3. Auflage. Vandenhoeck und Ruprecht, Göttingen 2006, ISBN 3-525-26518-2, S. 115.

- Heidrun Pelz: Linguistik. 1996, S. 179.

- Heidrun Pelz: Linguistik. 1996, S. 174 ff. („Erste Version“ – ST – EST – RST – GB, dabei die generative Semantik zwischen ST und EST anführend).

- Einführung in die Grundlagen der Generativen Grammatik. (PDF) TU Dresden, WS 2003/2004, S. 1–19

- Noam Chomsky: Cartesianische Linguistik. Ein Kapitel in der Geschichte des Rationalismus. Tübingen 1971. Übersetzung (R. Kruse) von Noam Chomsky: Cartesian linguistics: a chapter in the history of rationalist thought. University Press of America, Lanham, Maryland 1965. Reprint: University Press, Cambridge 2009.

- Radegundis Stolze: Übersetzungstheorien: eine Einführung. 4. Auflage. Narr, Tübingen 2005, ISBN 3-8233-6197-X, S. 42.

- Albert Menne: Einführung in die Methodologie: elementare allg. wiss. Denkmethoden im Überblick. 2. Auflage. Wissenschaftliche Buchgesellschaft, Darmstadt 1984, S. 45.

- Heidrun Pelz: Linguistik. 1996, S. 172.

- Christoph Schwarze, Dieter Wunderlich (Hrsg.): Handbuch der Lexikologie. Athenäum, Königstein/Ts. 1985, ISBN 3-7610-8331-9, Zur Zerlegbarkeit von Wortbedeutungen, S. 64, 88.

- Heidrun Pelz: Linguistik. 1996, S. 175.

- Winfried Ulrich: Wörterbuch linguistische Grundbegriffe. 5. Auflage. Gebr.-Borntraeger-Verl.-Buchh., Berlin/Stuttgart 2002, ISBN 3-443-03111-0 (generative Semantik).

- George Lakoff: Linguistik und natürliche Logik. Frankfurt 1971.

- Heidrun Pelz: Linguistik. 1996, S. 176.

- Fred Lehrdal, Ray Jackendoff: A Generative Theory of Tonal Music. The MIT Press, Cambridge MA 1996, ISBN 0-262-62107-X (englisch, web.archive.org [abgerufen am 5. November 2021]).

- Jonah Katz, David Pesetsky: The Identity Thesis for Language and Music. 2009 (ling.auf.net).

- Julian Klein, Thomas Jacobsen: Music is not a Language: Re-interpreting empirical evidence of musical ‘syntax’. Research Catalogue (englisch, academia.edu – 2008–2012).

- Verlagsinfo

- Rezension von Kevin Ch. Masalon am 9. August 2010