Dispersionsmaß (Stochastik)

Ein Dispersionsmaß[1], auch Streuungsmaß[2] oder Streuungsparameter[3] genannt, ist in der Stochastik eine Kennzahl der Verteilung einer Zufallsvariable beziehungsweise eines Wahrscheinlichkeitsmaßes. Anschaulich ist es die Aufgabe eines Dispersionsmaßes, ein Maß für die Streuung der Zufallsvariable um einen „typischen“ Wert anzugeben. Dabei wird der typische Wert durch ein Lagemaß angegeben.

Der Begriff des Dispersionsmaßes wird in der Literatur nicht immer eindeutig verwendet. So spricht man auch in der Statistik von Dispersionsmaßen von Stichproben. Eine genaue Abgrenzung erfolgt im unten stehenden Abschnitt.

Typische Dispersionsmaße

Um den Erwartungswert

Häufig werden Dispersionsmaße um den Erwartungswert angegeben, sie beruhen meist auf den Momenten zweiter Ordnung, selten auch auf denen erster oder höherer Ordnung. Bekannteste Beispiele sind:

- Die Varianz als zentriertes zweites Moment:

- Die Standardabweichung als Wurzel der Varianz:

- Der Variationskoeffizient als Verhältnis von Standardabweichung und Erwartungswert:

Dies sind alles Dispersionsmaße, die auf das zweite Moment zurückgreifen. Eines, das nur auf das erste Moment zurückgreift ist der mittlere absolute Abstand:

- .

Der mittlere absolute Abstand ist also das absolute zentrierte erste Moment.

Um den Median

Dispersionsmaße um den Median werden meist über die Quantilfunktion definiert, da der Median auch ein Quantil ist (das 0,5-Quantil). Gängig ist der Interquartilabstand

Dieser entspricht naiv der Breite des Intervalls, in dem sich die „mittleren 50 % der Wahrscheinlichkeit“ befinden. Der Interquartilabstand lässt sich verallgemeinern, indem man für beliebiges die Differenz von und bildet. Dies liefert die Breite des Intervalls, in dem sich die mittleren 200p % der Wahrscheinlichkeit befinden. Dieses Dispersionsmaß wird Interquantilsabstand genannt.

Mehrdeutigkeiten des Begriffes

An zwei Stellen ist die Verwendung des Begriffs des Dispersionsmaßes zweideutig:

- Bei Verwendung von Verteilungsklassen, die durch ein oder mehrere (reelle) Parameter näher bestimmt werden können

- Im Übergang zur deskriptiven Statistik, in der Stichproben Kennzahlen zugeordnet werden sollen, im Gegensatz zu Wahrscheinlichkeitsmaßen

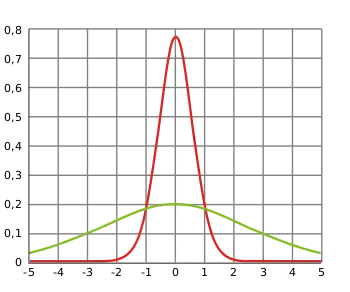

Beispiel für den ersten Fall ist die Normalverteilung: Sie wird durch zwei Parameter bestimmt. Dabei bestimmt der Parameter die Varianz und wird dementsprechend auch der Streuparameter genannt. Allerdings existiert nicht zu jeder Verteilung ein Parameter, der die Streuung bestimmt. Selbst wenn solch ein Formparameter für die „Breite“ der Verteilung existiert, muss er nicht mit dem gewählten Dispersionsmaß zusammenfallen.

Im zweiten Fall sind Dispersionsmaße Kennzahlen einer Stichprobe, wohingegen die hier besprochenen Dispersionsmaße Kennzahlen von Wahrscheinlichkeitsmaßen, also (Mengen)funktionen sind. So wäre ein Dispersionsmaß in der despriptiven Statistik beispielsweise die Spannweite. Sie ist die Differenz des größten und des kleinsten Messwertes in der Stichprobe. Dieses Konzept kann nicht ohne Weiteres auf Wahrscheinlichkeitsmaße übertragen werden. Zusätzlich verwirrend ist oft, dass dieselbe Bezeichnung für Kennzahlen von Stichproben und von Wahrscheinlichkeitsverteilungen verwendet werden (Interquartilabstand, Standardabweichung etc.)

Beziehung zu den Kennzahlen der deskriptiven Statistik

Die Beziehung zwischen den Kennzahlen einer Stichprobe und denen eines Wahrscheinlichkeitsmaßes wird durch die empirische Verteilung hergestellt. Ist eine Stichprobe, so gilt:

- Die Varianz der empirischen Verteilung zu ist die unkorrigierte Stichprobenvarianz von der Stichprobe

- ebenso ist die Standardabweichung und der Variationskoeffizient der empirischen Verteilung die empirische Standardabweichung und der empirische Variationskoeffizient von .

- Da sich auch die Quantile entsprechend übertragen ist der Interquartilsabstand (Interquantilsabstand) der empirischen Verteilung der Interquartilsabstand (Interquantilsabstand) der Stichprobe.

Weblinks

- V.V. Sazonov: Dispersion. In: Michiel Hazewinkel (Hrsg.): Encyclopedia of Mathematics. Springer-Verlag und EMS Press, Berlin 2002, ISBN 978-1-55608-010-4 (englisch, online).

Literatur

- Christian Hesse: Angewandte Wahrscheinlichkeitstheorie. 1. Auflage. Vieweg, Wiesbaden 2003, ISBN 3-528-03183-2, doi:10.1007/978-3-663-01244-3.

- Norbert Kusolitsch: Maß- und Wahrscheinlichkeitstheorie. Eine Einführung. 2., überarbeitete und erweiterte Auflage. Springer-Verlag, Berlin Heidelberg 2014, ISBN 978-3-642-45386-1, doi:10.1007/978-3-642-45387-8.

- Klaus D. Schmidt: Maß und Wahrscheinlichkeit. 2., durchgesehene Auflage. Springer-Verlag, Heidelberg Dordrecht London New York 2011, ISBN 978-3-642-21025-9, doi:10.1007/978-3-642-21026-6.

Einzelnachweise

- Hesse: Angewandte Wahrscheinlichkeitstheorie. 2003, S. 153.

- Schmidt: Maß und Wahrscheinlichkeit. 2011, S. 286.

- Kusolitsch: Maß- und Wahrscheinlichkeitstheorie. 2014, S. 241.