QCDOC

Der QCDOC, Quantum Chromodynamics On a Chip, ist ein an verschiedenen Orten realisiertes Supercomputer-Konzept, das darauf abzielt, durch preiswerte und einfache, aber effektive Hardware einen massiv-parallelen Supercomputer zu erhalten, der in den Ausmessungen klein ist und vorzugsweise Rechnungen für die Quantenchromodynamik (QCD) durchführt. Er ist also gleichzeitig ein „billiger Spezialrechner“ und, wegen des massiven Parallelismus, ein hocheffizienter Supercomputer, vorzugsweise für die QCD. Zugleich wurde sehr auf die Energieeffizienz des Rechners geachtet.

Überblick

Das Konzept wurde zunächst als gemeinsames Projekt verschiedener Institutionen entworfen: der University of Edinburgh (UKQCD), der Columbia University (New York), des RHIC-Beschleunigerzentrums am Brookhaven National Laboratory (NY), sowie des Konzerns IBM. Ziel war es, in der Gitter-QCD höchsteffektive Computersimulationen zu ermöglichen. Erreicht werden sollten mindestens 10 Tflops bei einer Auslastung von 50 %.

Es existieren drei implementierte QCDOCs, jede mit der angestrebten Höchstleistung, (10 Tflops).

- University of Edinburgh (Parallel Computing Centre (EPCC); in Betrieb seit 2005)

- Brookhaven 1 (RHIC)

- Brookhaven 2 (U.S. Department of Energy) (DOE-Hochenergie-Programm am Beschleuniger in Brookhaven.)

23 angestellte Wissenschaftler (UK), ihre Postdocs und Studenten, von sieben Universitäten, gehören zum UKQCD. Die Kosten übernahm ein Joint Infrastructure Fund Award, der mit von 6,6 Millionen Pfund ausgestattet war. Die Personalkosten einschließlich der System-Unterstützung, der zur Programmierung angestellten Physiker und Postdocs betrugen ungefähr 1 Million Pfund pro Jahr, andere Computing- und Operating-Kosten beliefen sich auf ungefähr 0,2 Million £ ,[1]

QCDOC ersetzt ein früheres Projekt, QCDSP, das die Rechnereffizienz dadurch erzeugte, dass eine große Anzahl von Signalprozessoren auf ähnliche Weise zusammengeschaltet wurden.

Der QCDSP-Rechner verband 12.288 Knoten zu einem vierdimensionalen Netz, das 1998 erstmals 1 Tflops erreichte.

QCDOC kann als Vorläufer des sehr erfolgreichen IBM-Superrechners Blue Gene/L (BG/L) angesehen werden. Beide Rechner haben viele Gemeinsamkeiten, die über Zufallsübereinstimmungen hinausgehen. Der „Blue Gene“ ist ebenfalls ein massiv-paralleler Supercomputer, der aus einer Vielzahl billiger und relativ einfacher 'PowerPC 440'-Prozessoren aufgebaut ist (system on a chip, SoC). Dabei sind diese „Knoten-Rechner“ zu einem hochdimensionalen Netz hoher „Bandbreite“ zusammengeschaltet. Die Rechner unterscheiden sich jedoch dadurch, dass die Prozessoren im BG/L mächtiger sind und dass sie zu einem schnelleren und effektiveren Netz zusammengeschaltet sind, das mehrere hunderttausend Knoten umfasst.

Architektur

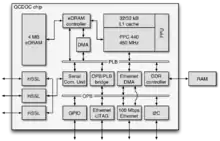

Knotenrechner

Die Rechnerknoten sind speziell angefertigte ASICs mit jeweils ca. 50 Millionen Transistoren. Sie werden von IBM selbst hergestellt und arbeiten bei etwa 500 MHz, mit PowerPC 440-Prozessor-Kernen. Jeder Knoten hat einen DIMM-Sockel, der zwischen 128 and 2048 MB bei 333 MHz arbeitet.

Die Knoten arbeiten insgesamt mit bis zu 1 double precision GFLOPS.

Gesamtsystem

Die Knotenrechner werden zu zweit auf einer Computer-Doppelkarte untergebracht, mit einem DIMM-Sockel und einem 4:1-Ethernet-Knoten für Kommunikationsprozesse mit anderen Knoten. Die Doppelkarten haben zwei Anschlüsse, einen für die Verbindungen zwischen den Karten und einen für die Stromversorgung, das Ethernet, die Uhr und andere notwendige Dinge.

32 solcher Computer-Doppelkarten werden, in zwei Reihen, auf einer Hauptplatine untergebracht, das die 800 Mbit/s-schnelle Ethernet-Verbindung unterstützt. Je acht Motherboards werden in einer Art „Abteil“ (einer so genannten „Kiste“) untergebracht; jedes „Abteil“ enthält 512 Prozessor-Knoten und ein Gesamtverbindungsnetzwerk entsprechend einem sechsdimensionalen Würfel mit 26 Eckpunkten. Ein Knotenrechner verbraucht eine Leistung von ungefähr 5 Watt, und jedes „Abteil“ hat entsprechende Luft- und Wasserkühlung nötig.

Ein vollständiges System kann aus einer beliebigen Anzahl von „Abteilen“ bestehen. Insgesamt haben die Systeme bis zu mehreren zehntausend Knoten.

Kommunikation zwischen den Knoten

Jeder Knoten kann Informationen an die zwölf nächsten Nachbarn (des zugehörigen sechsdimensionalen Gitters) senden, bzw. von diesen empfangen, mit einer Taktrate von 500 Mbit/s. Dadurch ergibt sich eine totale Bandbreite von 12 Gbit/s. Das Betriebssystem kommuniziert mit den Knoten über ein Ethernet. Dies wird auch für Fehlerdiagnostik, Konfigurations- und Kommunikations-Prozesse (z. B. Kommunikation mit Festplatten) benutzt.

Operating System

Auf dem QCDOC läuft ein spezielles Betriebssystem, QOS, das u. a. das Hochfahren („booten“) des Rechners, Laufzeit- und Monitoring-Prozesse ermöglicht und das Verwalten der zahlreichen Rechnerknoten vereinfacht. Es benutzt einen spezifischen Kernel und sorgt u. a. für Kompatibilität mit POSIX-Prozessen („unix-like“), wobei es die Cygnus-Bibliothek (newlib) benutzt.

Nachfolger

Der QCDOC ist inzwischen (2010) veraltet (siehe QPACE). An der Universität Regensburg, z. B. dient er jetzt als „Vorzeigeobjekt“ im Eingangsbereich der Physikfakultät.

Siehe auch

Weblinks

- QCDOC Architecture – Columbia University

- Overview of the QCDSP and QCDOC computers – IBM (Memento vom 12. März 2008 im Internet Archive)

- UK supercomputer probes secrets of universe, The Register

Literatur

- P.A. Boyle u. a.: QCDOC: A 10 Teraflops Computer for Tightly-Coupled Calculations. In: SC ’04: Proceedings of the 2004 ACM/IEEE Conference on Supercomputing. 2004, S. 40–40, doi:10.1109/SC.2004.46 (bnl.gov (Memento vom 10. Oktober 2012 im Internet Archive) [PDF]).

Einzelnachweise

- PPARC Road Map Projects. 29. April 2009, archiviert vom Original am 29. April 2009; abgerufen am 12. August 2021.