Publikationsbias

Der Publikationsbias auch Publikationsverzerrung ist die statistisch verzerrte (engl. bias [ˈbaɪəs]) Darstellung der Datenlage in wissenschaftlichen Zeitschriften infolge einer bevorzugten Veröffentlichung von Studien mit „positiven“ bzw. signifikanten Ergebnissen. Er wurde 1959 von dem Statistiker Theodore Sterling entdeckt.[1][2][3] Positive Befunde sind leichter zu publizieren als solche mit „negativen“, also nicht-signifikanten Ergebnissen und sind zudem häufiger in Fachzeitschriften mit hohem Einflussfaktor veröffentlicht.

Beschreibung

Synonym zu Publikationsbias wird häufig auch der Begriff File Drawer Problem („Schubladenproblem“) verwendet, den der Psychologe Robert Rosenthal 1979 geprägt hatte.[4] Damit wird das mit dem Publikationsbias verwandte Phänomen beschrieben, dass Forscher zunehmend ihre nicht signifikanten Ergebnisse erst gar nicht mehr zur Veröffentlichung einreichen, sondern gleich in der Schublade verschwinden lassen.[5]

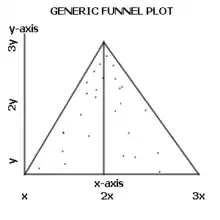

Aufgrund der erhöhten Häufigkeit positiver Ergebnisse kann in der Medizin etwa die Wirksamkeit von Therapien überschätzt werden, da Studien mit nachgewiesener Wirksamkeit leichter zu publizieren sind als solche, die die Wirksamkeit nicht nachweisen können. Dies ist besonders relevant, wenn aufgrund der bereits publizierten Datenlage anhand einer Metaanalyse Therapieempfehlungen generiert werden sollen. Der Verdacht auf einen Publikationsbias kann durch das Erstellen eines Funnel-Plots erhärtet werden.

Auch Interessenkonflikte können zu einem Publikationsbias führen, insbesondere wenn wirtschaftliche Interessen eine Rolle spielen. In der medizinischen Arzneimittelforschung wurde bei Antidepressiva herausgefunden, dass die in Zeitschriften publizierten Artikel einen positiveren Tenor hatten als die bei der amerikanischen Zulassungsbehörde FDA eingereichten Zulassungsdossiers.[6] Ein möglicher Grund ist hier ein wirtschaftliches Interesse, zum Beispiel ist eine Pharmafirma, die eine Studie gesponsert hat, deutlich interessierter an der Publikation positiver Ergebnisse zu ihren Produkten als an negativen Ergebnissen.

Aus den genannten Gründen verlangen mittlerweile einige der renommierten medizinischen Fachzeitschriften, dass alle durchgeführten Studien vorher bekannt gemacht werden müssen. Nur solche angekündigten Studien werden zur Publikation angenommen. Dies soll neben anderen Aspekten einen Überblick über die zum Thema durchgeführten Studien ermöglichen, um den Publikationsbias zumindest abschätzen zu können. Auch die Offenlegung von Interessenkonflikten der Autoren wird aus diesem Grund von vielen Fachzeitschriften verlangt, indem zum Beispiel die finanzielle Förderung durch Stiftungen, Forschungsvereine usw. angegeben wird.

Darüber hinaus gibt es bereits Fachzeitschriften (vorrangig im Internet, s. u.), die gezielt Studien mit „negativem“, d. h. im Sinne der Fragestellung nicht signifikanten Ergebnissen publizieren, darunter das Journal of Unsolved Questions. Auch die Cochrane Collaboration ist an solchen Ergebnissen sehr interessiert, um sie in ihren Analysen zu den Standards in der Medizin verwenden zu können.

Methoden zur Bestimmung des Publikationsbias

Eine grundlegende Technik ist die Erstellung eines Funnel-Plots (wörtlich „Trichterdiagramm“, ein gebräuchlicher deutscher Begriff existiert nicht), der 1984 von dem Statistiker Richard J. Light und dem Psychologen David B. Pillemer vorgestellt wurde.[7] Auf diesem Diagramm werden die in der Einzelstudie beobachtete Wirkung auf der x-Achse und die Präzision (je mehr Probanden oder Testobjekte, desto kleiner das Konfidenzintervall und desto höher die Präzision) auf der y-Achse eingetragen. Wenn die Punkte im Funnel-Plot symmetrisch verteilt sind, kann angenommen werden, dass sowohl „erwünschte“ als auch „unerwünschte“ Studienergebnisse veröffentlicht wurden, ein Publikationsbias also verneint werden.

Der Funnel-Plot wurde 1997 von dem Schweizer Epidemiologen Matthias Egger u. a. diskutiert und um den Egger-Test ergänzt, der eine statistisch signifikante Asymmetrie des Diagramms entweder bestätigt oder ausschließt.[8]

Relativ neu ist die Idee, die Rückfangmethode (engl. capture-recapture method) auf Publikations-Datenbanken und andere bibliografische Quellen anzuwenden: Man sucht Artikel zu einem bestimmten Thema auf einer Datenbank, und speichert die Resultate (capture). Dieselbe Suche wird auf einer zweiten Datenbank wiederholt (recapture). Dies erlaubt die Abschätzung der wahren Anzahl Publikationen zu einem bestimmten Thema.[9]

Siehe auch

- p-Hacking

- Questionable Research Practices (QRP)[10]

- Replikationskrise

Weblinks

- BioMed Central (BMC), London: Journal of Negative Results in Biomedicine. Von einem internationalen Wissenschaftlerteam betreutes Open-access-Projekt, das unter Peer-Review die wissenschaftliche Diskussion unerwarteter, widersprüchlicher, provokativer und/oder negativer Forschungsergebnisse aus dem Bereich der Biomedizin fördern sollte. Das Projekt wurde am 1. September 2017 eingestellt.

- Journal of Articles in Support of the Null Hypothesis

- CCT – Das Metaregister für klinische Studien

- Amerikanisches Verzeichnis klinischer Studien

- McGauran N, Wieseler B, Kreis J, Schüler YB, Kölsch H, Kaiser T: Reporting bias in medical research - a narrative review. In: Trials. 11, 2010, S. 37. doi:10.1186/1745-6215-11-37. PMID 20388211. PMC 2867979 (freier Volltext).

- PsychFileDrawer. Archive of Replication Attempts in Experimental Psychology: von einem internationalen Wissenschaftlerteam herausgegebenes Online-Journal, das experimentalpsychologische Wiederholungsstudien unabhängig von ihrem Ausgang veröffentlicht (Zuletzt geprüft am 6. Juni 2012)

- The All Results Journals: von einem internationalen Wissenschaftlerteam herausgegebenes Online-Journal, das experimentelle Untersuchungen aus Chemie, Biologie, Nanotechnologie und Physik veröffentlicht, die anderweitig nicht zur Veröffentlichung angenommen wurden, weil sie erwartete Ergebnisse nicht bestätigten bzw. zu keinen verwertbaren Ergebnissen geführt haben (zuletzt überprüft am 6. Juni 2012)

Literatur

- Hans-Hermann Dubben, Hans-Peter Beck-Bornholdt, Unausgewogene Berichterstattung in der medizinischen Wissenschaft, Hamburg: Institut für Allgemeinmedizin des Universitätsklinikums Hamburg-Eppendorf, 2004, ISBN 3-00-014238-X

- Bortz, J. & Döring, N. (2006). Forschungsmethoden und Evaluation für Human- und Sozialwissenschaftler (S. 695). Heidelberg: Springer. ISBN 3-540-33305-3

Einzelnachweise

- Arjo Klamer, Robert M. Solow, Donald N. McCloskey: The Consequences of economic rhetoric. Cambridge University Press, 1989, ISBN 978-0-521-34286-5, S. 173–74. Archiviert vom Original am 23. Mai 2011 Info: Der Archivlink wurde automatisch eingesetzt und noch nicht geprüft. Bitte prüfe Original- und Archivlink gemäß Anleitung und entferne dann diesen Hinweis. (Abgerufen am 8. Juli 2015).

- Jonah Lehrer: The Truth Wears Off. In: The New Yorker, 13. Dezember 2010. Abgerufen am 8. Juli 2015.

- Theodore D. Sterling: Publication decisions and their possible effects on inferences drawn from tests of significance—or vice versa Archiviert vom Original am 7. August 2011. In: Journal of the American Statistical Association. 54, Nr. 285, März 1959, S. 30–34. doi:10.2307/2282137. Abgerufen am 8. Juli 2015.

- PsychFileDrawer: The File Drawer Problem

- Daniele Fanelli: Negative results are disappearing from most disciplines and countries. Scientometrics, Vol. 90, Number 3 (2012), S. 891–904, doi:10.1007/s11192-011-0494-7; Manuela Lenzen: Journal zweiter Blicke. Eine Initiative fordert, mehr Experimente zu wiederholen. Frankfurter Allgemeine Zeitung, 6. Juni 2012, S. N 5

- Turner EH, Matthews AM, Linardatos E, Tell RA, Rosenthal R: Selective publication of antidepressant trials and its influence on apparent efficacy. In: N. Engl. J. Med.. 358, Nr. 3, Januar 2008, S. 252–60. doi:10.1056/NEJMsa065779. PMID 18199864.

- Richard J. Light, David B. Pillemer: Summing Up: The Science of Reviewing Research. Harvard University Press, Cambridge, Mass., ISBN 978-0-674-85431-4, S. 65 ff.

- Matthias Egger, George Davey Smith, Martin Schneider, Christoph Minder: Bias in meta-analysis detected by a simple, graphical test. In: BMJ. Band 315, Nr. 7109, 13. September 1997, ISSN 0959-8138, S. 629–634, doi:10.1136/bmj.315.7109.629, PMID 9310563 (bmj.com [abgerufen am 8. Dezember 2016]).

- Poorolajal J, Haghdoost AA, Mahmoodi M, Majdzadeh R, Nasseri-Moghaddam S, Fotouhi A. Capture-recapture method for assessing publication bias. Journal of Research in Medical Sciences : The Official Journal of Isfahan University of Medical Sciences. 2010;15(2):107-115. PMC 3082794 (freier Volltext)

- Leslie K. John, George Loewenstein, Drazen Prelec: Measuring the Prevalence of Questionable Research Practices With Incentives for Truth Telling. In: Psychological Science. Band 23, Nr. 5, Mai 2012, ISSN 0956-7976, S. 524–532, doi:10.1177/0956797611430953 (sagepub.com [abgerufen am 28. Februar 2022]).