Webcrawler

Ein Webcrawler (auch Spider, Searchbot oder Robot) ist ein Computerprogramm, das automatisch das World Wide Web durchsucht und Webseiten analysiert. Webcrawler werden vor allem von Suchmaschinen zur Indexierung von Webseiten eingesetzt. Weitere Anwendungen sind das Sammeln von Web-Feeds, E-Mail-Adressen oder von anderen Informationen.

Webcrawler sind eine spezielle Art von Bots, also Computerprogrammen, die weitgehend automatisch sich wiederholenden Aufgaben nachgehen.

Geschichte

Der erste Webcrawler war 1993 der World Wide Web Wanderer, der das Wachstum des Internets messen sollte. 1994 startete mit WebCrawler die erste öffentlich erreichbare WWW-Suchmaschine mit Volltextindex. Von dieser stammt auch der Name Webcrawler für solche Programme. Da die Anzahl der Suchmaschinen rasant wuchs, gibt es heute eine Vielzahl von unterschiedlichen Webcrawlern. Diese erzeugten nach einer Schätzung von 2002 bis zu 40 % des gesamten Internet-Datenverkehrs.[1]

Technik

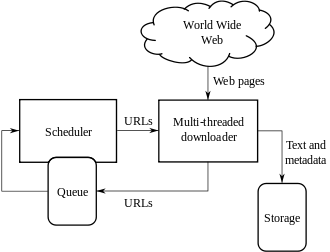

Wie beim Internetsurfen gelangt ein Webcrawler über Hyperlinks von einer Webseite zu weiteren URLs. Dabei werden alle aufgefundenen Adressen gespeichert und der Reihe nach besucht. Die neu gefundenen Hyperlinks werden zur Liste aller URLs hinzugefügt. Auf diese Weise können theoretisch alle verlinkten und nicht für Webcrawler gesperrten Seiten des WWW gefunden werden. In der Praxis wird jedoch oft eine Auswahl getroffen, der Prozess irgendwann beendet und von vorne begonnen. Je nach Aufgabe des Webcrawlers wird der Inhalt der gefundenen Webseiten beispielsweise mittels Indexierung ausgewertet und gespeichert, um ein späteres Suchen in den so gesammelten Daten zu ermöglichen.

Ausschluss von Webcrawlern

Mit Hilfe des Robots Exclusion Standards kann ein Webseitenbetreiber in der Datei robots.txt und in bestimmten Meta-Tags im HTML-Header einem Webcrawler mitteilen, welche Seiten er indexieren soll und welche nicht, sofern sich der Webcrawler an das Protokoll hält. Zur Bekämpfung unerwünschter Webcrawler gibt es auch spezielle Webseiten, sogenannte Teergruben, die den Webcrawlern falsche Informationen liefern und diese zusätzlich stark ausbremsen.

Probleme

Ein Großteil des gesamten Internets wird von Webcrawlern und damit auch von öffentlichen Suchmaschinen nicht erfasst, da viele Inhalte nicht über einfache Links, sondern beispielsweise nur über Suchmasken und zugangsbeschränkte Portale erreichbar sind. Man spricht bei diesen Bereichen auch vom „Deep Web“. Außerdem stellt die ständige Veränderung des Webs sowie die Manipulation der Inhalte (Cloaking) ein Problem dar.

Arten

Thematisch fokussierte Webcrawler werden als focused crawlers bzw. fokussierte Webcrawler bezeichnet. Die Fokussierung der Web-Suche wird einerseits durch die Klassifizierung einer Webseite an sich und die Klassifizierung der einzelnen Hyperlinks realisiert. Dadurch findet der fokussierte Crawler den besten Weg durch das Web und indexiert nur (für ein Thema bzw. eine Domäne) relevante Bereiche des Webs. Hürden bei der praktischen Umsetzung derartiger Webcrawler sind vor allem nicht-verlinkte Teilbereiche und das Training der Klassifizierer.[2]

Webcrawler werden auch zum Data-Mining und zur Untersuchung des Internets (Webometrie) eingesetzt und müssen nicht zwangsläufig auf das WWW beschränkt sein.

Eine Sonderform der Webcrawler sind E-Mail-Harvester („Harvester“ für „Erntemaschine“). Diese Bezeichnung wird für Software verwendet, die das Internet (WWW, Usenet usw.) nach E-Mail-Adressen absucht und diese „erntet“. So werden elektronische Adressen gesammelt und können danach vermarktet werden. Die Folge sind i. d. R., vor allem aber bei Spambots, Werbe-E-Mails (Spam). Daher wird von der früher gängigen Praxis, auf Webseiten E-Mail-Adressen als Kontaktmöglichkeit per mailto:-Link anzugeben, immer häufiger Abstand genommen; manchmal wird versucht, die Adressen durch den Einschub von Leerzeichen oder Wörtern für die Bots unlesbar zu machen. So wird a@example.com zu a (at) example (dot) com. Die meisten Bots können solche Adressen allerdings erkennen. Eine ebenfalls beliebte Methode ist, die E-Mail-Adresse in eine Grafik einzubetten. Die E-Mail-Adresse ist dadurch nicht als Zeichenkette im Quelltext der Webseite vorhanden und somit für den Bot nicht als Textinformation auffindbar. Das hat für den Benutzer jedoch den Nachteil, dass er die E-Mail-Adresse nicht durch „Anklicken“ bedienerfreundlich in sein E-Mail-Programm zum Versand übernehmen kann, sondern die Adresse abschreiben muss. Viel gravierender ist jedoch, dass die Seite damit nicht mehr barrierefrei ist und sehbehinderte Menschen genauso wie Bots ausgegrenzt werden.

Ein weiterer Verwendungszweck von Webcrawlern ist das Auffinden von urheberrechtlich geschützten Inhalten im Internet.

Siehe auch

- HTTrack Website Copier

- Wrapper (Informationsextraktion)

- Spider trap, Web-Struktur, die unerwünschte Webcrawler erkennen und optional an der Erfassung der Inhalte einer Website hindern soll

Einzelnachweise

- X. Yuan, M. H. MacGregor, J. Harms: An efficient scheme to remove crawler traffic from the Internet. Computer Communications and Networks, 2002. Proceedings. Eleventh International Conference on Communications and Networks

- Sotiris Batsakis, Euripides G. M. Petrakis, Evangelos Milios: Improving the Performance of Focused Web Crawlers. 9. April 2012. (englisch)