Äquivalenztest

Äquivalenztests sind eine Variation von Hypothesentests, mit denen statistische Schlussfolgerungen aus beobachteten Daten gezogen werden können. In Äquivalenztests wird die Nullhypothese definiert als ein Effekt, der groß genug ist, um als interessant angesehen zu werden, spezifiziert durch eine Äquivalenzgrenze. Die alternative Hypothese ist jeder Effekt, der weniger extrem ist als die gebundene Äquivalenz. Die beobachteten Daten werden statistisch mit den Äquivalenzgrenzen verglichen. Wenn der statistische Test zeigt, dass die beobachteten Daten überraschend sind, unter der Annahme, dass wahre Effekte mindestens so extrem wie die Äquivalenzgrenzen sind, kann ein Neyman-Pearson-Ansatz für statistische Schlussfolgerungen verwendet werden, um Effektgrößen, die größer als die Äquivalenzgrenzen sind, mit einer im Voraus festgelegten Typ-1-Fehlerrate abzulehnen.

Äquivalenztests stammen aus dem Bereich der Pharmakodynamik bzw. der Medikamentenentwicklung.[1] Eine Anwendung besteht darin, zu zeigen, dass ein neues Medikament, das billiger ist als verfügbare Alternativen, genauso gut funktioniert wie ein bestehendes Medikament. Im Wesentlichen bestehen Äquivalenztests darin, ein Konfidenzintervall um eine beobachtete Effektgröße herum zu berechnen und Effekte abzulehnen, die extremer sind als die Äquivalenzgrenze, wenn sich das Konfidenzintervall nicht mit der Äquivalenzgrenze überschneidet. Bei zweiseitigen Tests wird eine obere und untere Äquivalenzgrenze angegeben. In Nicht-Unterlegenheitsstudien, in denen das Ziel darin besteht, die Hypothese zu testen, dass eine neue Behandlung nicht schlechter ist als bestehende Behandlungen, ist nur eine niedrigere Äquivalenzgrenze im Voraus festgelegt.

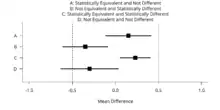

Äquivalenztests können zusätzlich zu Signifikanztests mit Nullhypothese durchgeführt werden.[2] Dies könnte häufige Fehlinterpretationen von p-Werten, die größer als der Alpha-Wert sind, verhindern, um das Fehlen eines wahren Effekts zu unterstützen. Darüber hinaus können Äquivalenztests statistisch signifikante, aber praktisch unbedeutende Effekte identifizieren, wenn die Effekte statistisch von Null verschieden sind, aber auch statistisch kleiner als jede als sinnvoll erachtete Effektgröße (siehe erste Abbildung).[3]

TOST-Verfahren

Ein sehr einfacher Äquivalenztestansatz ist das Verfahren der „zwei einseitigen t-Tests“ (englisch two one sided tests, kurz: TOST).[4] Im TOST-Verfahren wird eine obere (ΔU) und eine untere (–ΔL) Äquivalenzgrenze basierend auf der kleinsten Effektgröße von Interesse (z. B. eine positive oder negative Differenz von d = 0,3) angegeben. Zwei zusammengesetzte Nullhypothesen werden getestet: H01: Δ ≤ -ΔL und H02: Δ ≥ ΔU. Wenn beide einseitigen Tests statistisch abgelehnt werden können, können wir zu dem Schluss kommen, dass -ΔL < Δ < ΔU, oder dass der beobachtete Effekt innerhalb der Äquivalenzgrenzen liegt und statistisch kleiner ist als jeder als sinnvoll erachtete und praktisch gleichwertige Effekt.[5] Alternativen zum TOST-Verfahren wurden ebenfalls entwickelt.[6] Eine kürzlich erfolgte Modifikation von TOST macht den Ansatz bei wiederholten Messungen und der Bewertung mehrerer Variablen möglich.[7]

Vergleich zwischen t-Test und Äquivalenztest

Der Äquivalenztest kann zu Vergleichszwecken aus dem t-Test „induziert“ werden.[8] Bei einem t-Test zum Signifikanzniveau αt-Test und welcher für eine Effektgröße dr eine Power von 1-βt-Test erreicht, führen beide Tests zu der gleichen Schlussfolgerung, wenn die Parameter Δ=dr sowie αequiv.-test=βt-test und βequiv.-test=αt-test zusammenfallen, d. h. die Fehler (Typ I und Typ II) zwischen dem t-Test und dem Äquivalenztest sind vertauscht. Um dies für den t-Test zu gewährleisten, muss entweder die Fallzahlplanung korrekt durchgeführt werden oder durch Anpassung des Signifikanzniveaus αt-test ein korrigierter Test bestimmt werden.[8] Beide Ansätze haben praktische Probleme, da die Fallzahlplanung auf nicht überprüfbaren Annahmen hinsichtlich der Standardabweichung beruht und beim Anpassen von αt-test (sogenannter revised t-Test) numerische Probleme auftreten.[8] Diese Einschränkungen treten bei Anwendung des Äquivalenztests nicht auf.

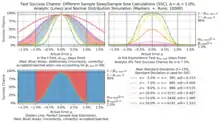

Die zweite Abbildung ermöglicht einen Vergleich des Äquivalenztests und des t-Tests, wenn die Fallzahlplanung von Differenzen zwischen der A-priori-Standardabweichung und der Standardabweichung aus der Stichprobe betroffen ist. Die Verwendung eines Äquivalenztests anstelle eines t-Tests stellt sicher, dass αequiv.-test (bzw. βt-test) beschränkt ist, was der t-Test nicht tut. Insbesondere im Fall kann im t-Test der Typ II Fehler beliebig groß werden. Demgegenüber führt dazu, dass der t-Test strenger ausfällt als der für dr geplante, was zu zufälligen Nachteilen (z. B. eines Geräteherstellers) führen kann. Dies macht den Äquivalenztest sicherer in der Anwendung.

Weiterführende Literatur

- Esteban Walker, Amy S. Nowacki: Understanding Equivalence and Noninferiority Testing. In: Journal of General Internal Medicine. 26, February 2011, S. 192–6. doi:10.1007/s11606-010-1513-8. PMID 20857339. PMC 3019319 (freier Volltext).

Referenzen

- Walter W. Hauck, Sharon Anderson: A new statistical procedure for testing equivalence in two-group comparative bioavailability trials. In: Journal of Pharmacokinetics and Biopharmaceutics. 12, Nr. 1, 1. Februar 1984, ISSN 0090-466X, S. 83–91. doi:10.1007/BF01063612. PMID 6747820.

- James L. Rogers, Kenneth I. Howard, John T. Vessey: Using significance tests to evaluate equivalence between two experimental groups.. In: Psychological Bulletin. 113, Nr. 3, 1993, S. 553–565. doi:10.1037/0033-2909.113.3.553.

- Daniël Lakens: Equivalence Tests. In: Social Psychological and Personality Science. 8, Nr. 4, 5. Mai 2017, S. 355–362. doi:10.1177/1948550617697177. PMID 28736600.

- Donald J. Schuirmann: A comparison of the Two One-Sided Tests Procedure and the Power Approach for assessing the equivalence of average bioavailability. In: Journal of Pharmacokinetics and Biopharmaceutics. 15, Nr. 6, 1. Dezember 1987, ISSN 0090-466X, S. 657–680. doi:10.1007/BF01068419.

- Michael A. Seaman, Ronald C. Serlin: Equivalence confidence intervals for two-group comparisons of means.. In: Psychological Methods. 3, Nr. 4, 1998, S. 403–411. doi:10.1037/1082-989x.3.4.403.

- Stefan Wellek: Testing statistical hypotheses of equivalence and noninferiority. Chapman and Hall/CRC, 2010, ISBN 978-1439808184.

- Evangeline M. Rose, Thomas Mathew, Derek A. Coss, Bernard Lohr, Kevin E. Omland: A new statistical method to test equivalence: an application in male and female eastern bluebird song. In: Animal Behaviour. 145, 2018, ISSN 0003-3472, S. 77–85. doi:10.1016/j.anbehav.2018.09.004.

- Michael Siebert, David Ellenberger: Validation of automatic passenger counting: introducing the t-test-induced equivalence test. In: Transportation. 10. April 2019, ISSN 0049-4488. doi:10.1007/s11116-019-09991-9.

- Michael Siebert, David Ellenberger: Validation of automatic passenger counting: introducing the t-test-induced equivalence test. In: Transportation. 10. April 2019, ISSN 0049-4488. doi:10.1007/s11116-019-09991-9.