Explainable Artificial Intelligence

Explainable Artificial Intelligence (XAI; deutsch: erklärbare künstliche Intelligenz[1][2][3] oder erklärbares Maschinenlernen) ist ein Neologismus, der seit etwa 2004 in der Forschung und Diskussion über Maschinenlernen verwendet wird.

XAI soll eindeutig nachvollziehbar machen, auf welche Weise dynamische und nicht linear programmierte Systeme[4], z. B. künstliche neuronale Netze, Deep-Learning-Systeme (reinforcement learning) und genetische Algorithmen, zu Ergebnissen kommen. XAI ist eine technische Disziplin, die operative Methoden erarbeitet und bereitstellt, die zur Erklärung von AI-Systemen dienen.

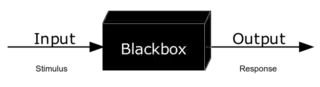

Ohne XAI gleichen einige Methoden des maschinellen Lernens (insbesondere das zurzeit populäre Deep Learning) einem Black-Box-Vorgang,[1][5] bei dem die Introspektion eines dynamischen Systems unbekannt oder unmöglich ist und der Anwender keine Kontrollmöglichkeiten hat zu verstehen, wie eine Software zur Lösung eines Problems gelangt.

Definition

Es gibt derzeit noch keine allgemein akzeptierte Definition von XAI.

Das XAI-Programm der Defense Advanced Research Projects Agency (DARPA),[6] deren Ansatz sich schematisch darstellen lässt,[7] definiert seine Ziele mit den folgenden Forderungen:

- Produzieren Sie erklärbarere Modelle, während Sie gleichzeitig eine hohe Lernleistung beibehalten (Vorhersagegenauigkeit).

- Ermöglichen Sie menschlichen Nutzern, die entstehende Generation künstlich intelligenter Partner zu verstehen, ihnen angemessen zu vertrauen und mit ihnen effektiv umzugehen.[8]

Geschichte

Während der Begriff „XAI“ noch relativ neu ist – eine frühe Erwähnung des Konzepts erfolgte 2004[9] – hat der bewusste Ansatz, das Vorgehen von maschinellen Lernsystemen komplett verstehen zu wollen, eine längere Geschichte. Forscher sind seit den 1990er Jahren daran interessiert, Regeln aus trainierten neuronalen Netzen abzuleiten,[10] und Wissenschaftler im Gebiet der klinischen Expertensysteme, die neuronale Entscheidungshilfen für Mediziner liefern, haben versucht, dynamische Erklärungssysteme zu entwickeln, die diese Technologien in der Praxis vertrauenswürdiger machen.[11]

In letzter Zeit wird aber der Schwerpunkt darauf gelegt, Maschinenlernen und KI den Entscheidungsträgern – und nicht etwa den Konstrukteuren oder direkten Nutzern von Entscheidungssystemen zu erklären und verständlich zu machen. Seit der Einführung des Programms durch DARPA im Jahr 2016 versuchen neue Initiativen das Problem der algorithmic accountability (etwa ‚algorithmische Rechenschaftspflicht‘) anzugehen und Transparenz zu schaffen (Glass-Box-Vorgang[12]), wie Technologien in diesem Bereich funktionieren:

Methoden

Verschiedene Methoden werden für XAI angewendet:

- Layer-wise relevance propagation (LRP; etwa‚ Schicht für Schicht erfolgende Übertragung von Bedeutung‘)[5] wurde erstmals 2015 beschrieben und ist eine Technik zu Bestimmung der Merkmale von bestimmten Eingangsvektoren, die am stärksten zum Ausgabeergebnis eines neuronalen Netzwerks beitragen.[15][16]

- Counterfactual method (etwa‚ kontrafaktische Methode‘): Nach dem Erhalten eines Resultats werden gezielt Input-Daten (Text, Bilder, Diagramme etc.) verändert und man beobachtet, wie sich dadurch das Ausgaberesultat verändert.[17]

- Local interpretable model-agnostic explanations (LIME)[18][17]

- Generalized additive model (GAM)[19][17]

- Rationalization: Speziell bei AI-basierten Robotern wird die Maschine in die Lage versetzt, dass sie ihre eigenen Handlungen „verbal erklären“ kann.[20][21][17]

Anwendungsbeispiele

Bestimmte Industriezweige und Dienstleistungsbereiche sind von XAI-Anforderungen besonders betroffen, da durch die dort immer intensivere Anwendung von KI-Systemen die „Rechenschaftspflicht“ (englisch accountability) mehr und mehr auf die Software und deren – teilweise überraschende – Ergebnisse verlagert („delegiert“) wird.

Folgende Bereiche stehen dabei besonders im Fokus (alphabetische Auflistung):

- Antennendesign[22]

- Hochfrequenzhandel (algorithmischer Handel)[23][24]

- Medizinische Diagnostik[25]

- Selbstfahrende Kraftfahrzeuge[26][27][28]

- Neuronale Netzwerk-Bildgebung[29]

- Training militärischer Strategien[30]

Internationaler Austausch über die Thematik und Forderungen

Da Regulierungsbehörden, Behörden und allgemeine Nutzer von dynamischen Systemen auf KI-Basis abhängig sind, wird eine klarere Rechenschaftspflicht für die Entscheidungsfindung erforderlich sein, um Vertrauen und Transparenz zu gewährleisten.

Ein Beleg dafür, dass diese berechtigte Forderung an Dynamik gewinnt, ist war die International Joint Conference on Artificial Intelligence: Workshop on Explainable Artificial Intelligence (XAI) im Jahr 2017.[31]

In Bezug auf KI-Systeme fordern die australische Publizistin und Wissenschaftlerin Kate Crawford und ihre Kollegin Meredith Whittaker (AI Now Institute), dass „die wichtigsten öffentlichen Einrichtungen, wie z. B. die für Strafjustiz, Gesundheit, Wohlfahrt und Bildung zuständigen Stellen […], keine Black-Box-KI und algorithmische Systeme mehr verwenden sollten“.[32][33] Zusätzlich fordern sie – noch über die rein technischen Maßnahmen und Methoden der Erklärbarkeit solcher Systeme hinaus – verbindliche ethischen Maßstäbe, wie sie beispielsweise in der pharmazeutischen Industrie und klinischen Forschung angewendet werden.[34]

Primär im Europarecht wurde die Existenz eines "Rechts auf Erläuterung" ("right to [an] explanation") anhand der DSGVO bereits seit 2017 intensiv diskutiert.[35] Potentielle Ansatzpunkte für die Ableitung eines solchen Rechtes finden sich in Art 22 DSGVO, der ein (prinzipielles) Verbot der vollautomatisierten Entscheidungsfindung statuiert, in Verbindung mit Erwägungsgrund 71 ("In jedem Fall sollte eine solche Verarbeitung mitangemessenen Garantien verbunden sein, einschließlich [...] des Anspruchs [...] auf Erläuterung der nach einer entsprechenden Bewertung getroffenen Entscheidung"). Auch die Informationspflichten (Art 13-14 DSGVO) bzw. das Auskunftsrecht (Art 15 DSGVO) normieren, dass "aussagekräftige Informationen über die involvierte Logik sowie die Tragweite und die angestrebten Auswirkungen einer derartigen Verarbeitung" proaktiv bzw. auf Anfrage bereitgestellt werden müssen. Allerdings ist die Existenz eines solchen Rechts aufgrund der Natur von Erwägungsgründen im Unionsrecht, diese besitzen vor allem Klarstellungsfunktion,begründen jedoch selbst kein verbindliches Recht, umstritten.[36] Auch Art 13-15 DSGVO werden teilweise restriktiv im Sinne einer Erläuterung der abstrakten Systemfunktionalität interpretiert während die Notwendigkeit der Erklärung einer konkreten Entscheidung, das heißt eine Form von lokaler Interpretierbarkeit, verneint wird.[37] Diese restriktive Interpretation ist jedoch nicht unumstritten.[38] So wurde in der Literatur unter anderem die Existenz eines "rights to legibility" bejaht, das die Fähigkeiten der Betroffenen Informationen zu verstehen einbezieht,[39] die Rolle der Datenschutzfolgenabschätzung (Art 35 DSGVO) im Kontext des Rechts auf Erläuterung betont[40][41] oder die Existenz eines Rechts auf Erläuterung als (implizite) Garantie im Rahmen von Art 22 Abs 3 DSGVO[42] oder in einer holistischen Lesung verschiedener Bestimmungen der DSGVO angenommen.[43][44]

Andere potentielle rechtliche Ausgangspunkte für die Notwendigkeit von Interpretierbarkeit beim Einsatz von KI wurden anhand des Vertrags- und Schadenersatzrechts[45] oder anhand der informierten Aufklärung ("informed consent") zwischen Arzt und Patient im Medizinrecht diskutiert.[46][47]

Weblinks und Literatur

- Explainable AI: Making machines understandable for humans. In: Explainable AI: Making machines understandable for humans. Abgerufen am 2. November 2017.

- Explaining How End-to-End Deep Learning Steers a Self-Driving Car. In: Parallel Forall. 23. Mai 2017. Abgerufen am 2. November 2017.

- New isn't on its way. We're applying it right now.. In: Accenture. 25. Oktober 2016. Abgerufen am 2. November 2017.

- David Alvarez-Melis und Tommi S. Jaakkola: A causal framework for explaining the predictions of black-box sequence-to-sequence models, arxiv:1707.01943, 6. Juli 2017.

- TEDx Talk von Peter Haas über die Notwendigkeit von transparenten KI-Systemen: The Real Reason to be Afraid of Artificial Intelligence (engl.)

- Mengnan Du, Ninghao Liu, Xia Hu: Techniques for Interpretable Machine Learning, Communications of the ACM, January 2020, Vol. 63 No. 1, Pages 68–77 DOI: 10.1145/3359786 (engl.)

Einzelnachweise

- Patrick Beuth: Die Automaten brauchen Aufsicht, Die Zeit, 25. Oktober 2017, S. 3; abgerufen am 25. Januar 2018.

- Ein allgemein verwendeter deutscher Begriff hat sich noch nicht durchgesetzt, weshalb hier im Artikel der englische Begriff und seine Abkürzung verwendet werden.

- Andreas Holzinger: Explainable AI (ex-AI). In: Informatik-Spektrum. Band 41, Nr. 2, 1. April 2018, ISSN 0170-6012, S. 138–143, doi:10.1007/s00287-018-1102-5.

- Optimization Technology Center of Northwestern University and Argonne National Laboratory: Nonlinear Programming – Frequently Asked Questions; abgerufen am 2. Dezember 2017.

- Patrick Beuth: Die rätselhafte Gedankenwelt eines Computers, DIE ZEIT Online, 24. März 2017; abgerufen am 29. Januar 2018.

- Will Knight: DARPA is funding projects that will try to open up AI’s black boxes, MIT Technology Review, 14. März 2017; abgerufen am 2. November 2017.

- W. F. Lawless, Ranjeev Mittu, Donald Sofge und Stephen Russell: Autonomy and Artificial Intelligence: A Threat or Savior?, 24. August 2017, Springer International Publishing, ISBN 978-3-319-59719-5, S. 95.

- David Gunning: Explainable Artificial Intelligence (XAI) (DARPA/I2O); abgerufen am 3. Dezember 2017.

- Michael van Lent und William Fisher: An Explainable Artificial Intelligence System for Small-unit Tactical Behavior, Proceedings of the 16th Conference on Innovative Applications of Artifical Intelligence (2004), S. 900–907.

- A. B. Tickle, R. Andrews, M. Golea und J. Diederich: The truth will come to light: directions and challenges in extracting the knowledge embedded within trained artificial neural networks, Transactions on Neural Networks, Band 9(6) (1998), S. 1057–1068, doi:10.1109/72.728352.

- Lilian Edwards and Michael Veale: Slave to the Algorithm? Why a 'Right to an Explanation' Is Probably Not the Remedy You Are Looking For, Duke Law and Technology Review (2017), doi:10.2139/ssrn.2972855.

- Andreas Holzinger, Markus Plass, Katharina Holzinger, Gloria Cerasela Crisan, Camelia-M. Pintea: A glass-box interactive machine learning approach for solving NP-hard problems with the human-in-the-loop. In: arXiv:1708.01104 [cs, stat]. 3. August 2017 (arXiv:1708.01104 [abgerufen am 27. Mai 2018]).

- M. Bojarski, P. Yeres, A. Choromanska, K. Choromanski, B. Firner, L. Jackel und U. Muller: Explaining How a Deep Neural Network Trained with End-to-End Learning Steers a Car, arxiv:1704.07911.

- Responsible AI: Why we need Explainable AI. In: YouTube. Accenture. Abgerufen am 17. Juli 2017.

- Dan Shiebler: Understanding Neural Networks with Layerwise Relevance Propagation and Deep Taylor Series. In: Dan Shiebler. 16. April 2017. Abgerufen am 3. November 2017.

- Sebastian Bach, Alexander Binder, Grégoire Montavon, Frederick Klauschen, Klaus-Robert Müller und Wojciech Samek: On Pixel-Wise Explanations for Non-Linear Classifier Decisions by Layer-Wise Relevance Propagation. In: Public Library of Science (PLoS) (Hrsg.): PLOS ONE. 10, Nr. 7, 10. Juli 2015. doi:10.1371/journal.pone.0130140.

- Paul Voosen: How AI detectives are cracking open the black box of deep learning, Science, 6. Juli 2017; abgerufen am 27. März 2018.

- Christoph Molnar: Interpretable Machine Learning – A Guide for Making Black Box Models Explainable: 5.4 Local Surrogate Models (LIME), 29. März 2018; abgerufen am 31. März 2018.

- Simon N. Wood: Generalized Additive Models: An Introduction with R, Second Edition. CRC Press, 18 May 2017, ISBN 978-1-4987-2837-9.

- Upol Ehsan, Brent Harrison, Larry Chan und Mark O. Riedl: Rationalization: A Neural Machine Translation Approach to Generating Natural Language Explanations, Cornell University Library, 15. Februar 2017; abgerufen am 31. März 2018.

- Dong Huk Park, Lisa Anne Hendricks, Zeynep Akata, Bernt Schiele, Trevor Darrell und Marcus Rohrbach: Attentive Explanations: Justifying Decisions and Pointing to the Evidence, Cornell University Library, 16. Dezember 2016; abgerufen am 31. März 2018.

- NASA 'Evolutionary' software automatically designs antenna. In: NASA. NASA. Abgerufen am 17. Juli 2017.

- Matt Levine: Dark Pools and Money Camps, Bloomberg View, 10. Juli 2017; abgerufen am 20. Januar 2018.

- The Flash Crash: The Impact of High Frequency Trading on an Electronic Market. In: CFTC. CFTC. Abgerufen am 17. Juli 2017.

- Stephen F. Weng, Jenna Reps, Joe Kai, Jonathan M. Garibaldi, Nadeem Qureshi, Bin Liu: Can machine-learning improve cardiovascular risk prediction using routine clinical data?. In: PLOS ONE. 12, 2017, S. e0174944, doi:10.1371/journal.pone.0174944.

- Will Knight: The Dark Secret at the Heart of AI, MIT Technology Review, 11. April 2017; abgerufen am 20. Januar 2018.

- Tesla says it has 'no way of knowing' if autopilot was used in fatal Chinese crash. In: Guardian. Guardian. Abgerufen am 17. Juli 2017.

- Joshua Brown, Who Died in Self-Driving Accident, Tested Limits of His Tesla. In: New York Times. New York Times. Abgerufen am 17. Juli 2017.

- Neual Network Tank image. In: Neil Fraser. Neil Fraser. Abgerufen am 17. Juli 2017.

- Chee-Kit Looi: Artificial Intelligence in Education: Supporting Learning Through Intelligent and Socially Informed Technology. IOS Press, 2005, ISBN 978-1-58603-530-3, S. 762 ff.

- IJCAI 2017 Workshop on Explainable Artificial Intelligence (XAI). In: Earthlink. IJCAI. Abgerufen am 17. Juli 2017.

- Im Original: „Core public agencies, such as those responsible for criminal justice, healthcare, welfare, and education (e.g “high stakes” domains) should no longer use ‘black box’ AI and algorithmic systems.“

- AI Now Institute: The 10 Top Recommendations for the AI Field in 2017, 18. Oktober 2017; abgerufen am 29. Januar 2018.

- Scott Rosenberg: Why AI Is Still Waiting For Its Ethics Transplant, Wired, 11. Januar 2017; abgerufen am 25. Januar 2018. Siehe auch die PDF AI Now 2017 Report.

- Bryce Goodman, Seth Flaxman: European Union Regulations on Algorithmic Decision-Making and a 'Right to Explanation. In: AI Magazine. Band 38, Nr. 3, 2017, S. 50–57.

- Andrew D. Selbst, Julia Powles: Meaningful information and the right to explanation. In: International Data Privacy Law. Band 7, Nr. 4, 2017, S. 233–242.

- Sandra Wachter, Brent Mittelstadt, Luciano Floridi: Why a Right to Explanation of Automated Decision-Making Does Not Exist in the General Data Protection Regulation. In: International Data Privacy Law. Band 7, Nr. 2, 2017, S. 76–99.

- Andrew D. Selbst, Julia Powles: Meaningful information and the right to explanation. In: International Data Privacy Law. Band 7, Nr. 4, 2017, S. 233–242.

- Gianclaudio Malgieri, Giovanni Comandé: Why a Right to Legibility of Automated Decision-Making Exists in the General Data Protection Regulation. In: International Data Privacy Law. Band 7, Nr. 4, 2017, S. 243–265.

- Margot E. Kaminski, Gianclaudio Malgieri: Algorithmic impact assessments under the GDPR: producing multi-layered explanations. In: International Data Privacy Law. Band 11, Nr. 2, 2021, S. 125–144.

- Bryan Casey, Askhon Farhangi, Roland Vogl: Rethinking Explainable Machines: The GDPR's 'Right to Explanation' Debate and the Rise of Algorithmic Audits in Enterprise. In: Berkeley Technology Law Journal. Band 34, Nr. 1, 2019, S. 143–188.

- Lee A. Bygrave: Minding the Machine v2.0: The EU General Data Protection Regulation and Automated Decision Making. In: Karen Yeung, Martin Lodge (Hrsg.): Algorithmic Regulation. Oxford University Press, Oxford 2019, S. 248–262.

- Margot E. Kaminski: The Right to Explanation, Explained. In: Berkeley Technology Law Journal. Band 34, 2019, S. 189–218.

- Maja Brkan: Do algorithms rule the world? Algorithmic decision-making and data protection in the framework of the GDPR and beyond. In: International Journal of Law and Information Technology. Band 27, Nr. 2, 2019, S. 91–121.

- Philipp Hacker, Ralf Krestel, Stefan Grundmann, Felix Naumann: Explainable AI under contract and tort law: legal incentives and technical challenges. In: Artificial Intelligence and Law. Nr. 4, 2020, S. 415–439.

- Karl Stöger, David Schneeberger, Andreas Holzinger: Medical artificial intelligence: the European legal perspective. In: Communications of the ACM. Band 64, Nr. 11, 2021, S. 34–36.

- David Schneeberger, Karl Stöger, Andreas Holzinger: The European legal framework for medical AI. In: Andreas Holzinger, Peter Kieseberg, A Min Tjoa, Edgar Weippl (Hrsg.): Machine Learning and Knowledge Extraction. 4th IFIP TC 5, TC 12, WG 8.4, WG 8.9, WG 12.9 International Cross-Domain Conference, CD-MAKE 2020, Dublin, Ireland, August 25–28, 2020, Proceedings. Springer, Cham 2020, ISBN 978-3-03057321-8, S. 209–226.