Confusion of the Inverse

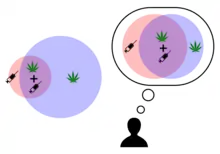

Confusion of the Inverse (engl. für „Verwechslung der Umkehrung“; auch: Conditional Probability Fallacy [„Fehlschluss der bedingten Wahrscheinlichkeit“], Inverse fallacy [„Umkehrungsfehlschluss“], Fallacy of the Transposed Probability [„Fehlschluss der transponierten Wahrscheinlichkeit“], Prosecutor’s Fallacy [„Trugschluss des Anklägers“]) ist ein logischer Fehlschluss, der darin besteht, dass eine bedingte Wahrscheinlichkeit mit ihrer Umkehrung gleichgesetzt wird.[1]

Eine bedingte Wahrscheinlichkeit (z. B. die Wahrscheinlichkeit, dass ein Professor in Deutschland eine Frau ist: 25 %) ist mit ihrer Umkehrung (der Wahrscheinlichkeit, dass eine Frau in Deutschland Professor ist: 0,03 %) keineswegs identisch. Bei Confusion of the Inverse wird dieser Unterschied aber nicht verstanden und der eine Wert fehlerhaft für den anderen eingesetzt.

Den Begriff Confusion of the Inverse hat der amerikanische Psychologe Robyn Dawes geprägt.[2]

Beispiele

Allgemeine Beispiele

„Wie in einer Studie aufgewiesen wurde, hat fast jeder zweite Terrorist eine technische Ausbildung absolviert.[3] Eltern, die ihrem Kind eine technische Ausbildung ermöglichen, sollten sich darauf gefasst machen, dass das Kind eine Terroristenlaufbahn einschlägt.“

„Die meisten Unfälle passieren zu Hause. Um sicher zu sein, sollte man sich möglichst wenig zu Hause aufhalten.“

„Die meisten Drogensüchtigen haben mit der Einstiegsdroge Haschisch angefangen. Wer Haschisch raucht, geht ein hohes Risiko ein, später von härteren Drogen abhängig zu werden.“

Beispiele aus der Medizin

Die Confusion of the Inverse ist bei Studierenden und Akademikern weithin verbreitet und führt insbesondere bei der Deutung medizinischer Testergebnisse zu gravierenden und teilweise folgenreichen Verzerrungen.

| Relative Größe | Bösartig | Gutartig | Summe |

|---|---|---|---|

| Test positiv |

0,8 (korrekt positiv) | 9,9 (falsch positiv) |

10,7 |

| Test negativ |

0,2 (falsch negativ) | 89,1 (korrekt negativ) |

89,3 |

| Summe | 1 | 99 | 100 |

Zu den heute bekanntesten Beispielen zählt eines, auf das 1982 David M. Eddy aufmerksam gemacht hat. Eddy hatte 100 Ärzte aufgefordert, sich zu folgendem Fall zu äußern: Eine Patientin hat einen Knoten in der Brust. Eine Mammographie liefert den Befund, dass der Tumor bösartig sei. Der Arzt weiß Folgendes:

- Nur 1 % aller Brusttumoren sind bösartig.

- Mammographien erkennen einen bösartigen Tumor in 80 % der Fälle als solchen (während sie ihn in 20 % der Fälle falsch als gutartig einstufen).

- Mammographien erkennen einen gutartigen Tumor in 90 % der Fälle als solchen (während sie ihn in 10 % der Fälle falsch als bösartig einstufen).[4]

Die meisten der von Eddy befragten Ärzte bezifferten die Wahrscheinlichkeit, dass bei der Patientin ein bösartiger Tumor vorliege, auf 75 % (0,75). Korrekt, nach dem Satz von Bayes berechnet beträgt das Risiko jedoch nur 7,5 % (0,075).[4]

Bereits 1979 hatten zwei Forscher aus Massachusetts ähnliche systematische Missinterpretationen im Vorfeld ärztlicher Verordnungen von Amniozentesen bei Schwangeren aufgewiesen.[5]

Literatur

- Pavel Kalinowski, Fiona Fidler, Geoff Cumming: Overcoming the Inverse Probability Fallacy: A Comparison of Two Teaching Interventions. In: Methodology European Journal of Research Methods for the Behavioral and Social Sciences. Band 4, Nr. 4, Januar 2008, S. 152–158.

Weblinks

- Richardo Franco, Jerome Busemeyer: A quantum probability explanation for the inverse fallacy. Abgerufen am 14. Juli 2020 (Indiana University).

Einzelnachweise

- Christopher J. Wild, Jessica M. Utts, Nicholas J. Horton: What Is Statistics? In: Dani Ben-Zvi, Katie Makar, Joan Garfield (Hrsg.): International Handbook of Research in Statistics Education. Springer, ISBN 978-3-319-66193-3, S. 5–36, hier: S. 24 (eingeschränkte Vorschau in der Google-Buchsuche).

- Scott Plous: The Psychology of Judgment and Decision Making. McGraw-Hill, 1993, ISBN 978-0-07-050477-6, S. 132.

- Diego Gambetta, Steffen Hertog: Engineers of Jihad : the curious connection between violent extremism and education. Princeton University Press, Princeton, Oxford 2016, ISBN 978-0-691-14517-4.

- David M. Eddy: Probabilistic reasoning in clinical medicine: Problems and opportunity. In: Daniel Kahneman, Paul Slovic, AAmos Tversky (Hrsg.): Judgment under Uncertainty: Heuristic and Biases. Cambridge University Press, Cambridge 1982, ISBN 978-0-521-28414-1, S. 249–267. Zitiert nach: Jessica Utts, Robert Heckard: Statistical Ideas and Methods. Thomson, Belmont, CA 2006, ISBN 0-534-40284-4, S. 234 (eingeschränkte Vorschau in der Google-Buchsuche).

- Susan P. Pauker, Stephen G. Pauker: The amniocentesis decision: an explicit guide for parents. In: Birth Defects Original Article Series. Band 15, 5C, 1979, S. 289–324, PMID 160805.