Skinner-Box

Eine Skinner-Box (gelegentlich auch: problem box, puzzle box) ist ein äußerst reizarmer Käfig für ein Testtier, in dem es standardisiert und weitgehend automatisiert ein neuartiges Verhalten erlernen kann. Die Bezeichnung Skinner-Box verweist auf Burrhus Frederic Skinner, durch den sie weithin bekannt wurde. Das Gerät ist eine Variante des von Edward Lee Thorndike entwickelten Vexier-, Problem- bzw. Versuchskäfigs.[1] Der von Skinner ursprünglich gewählte Name lautet Operant conditioning chamber (Kammer zum operanten Konditionieren);[2] erst später wurde die Bezeichnung zu einem Eponym.

Von den Vertretern des Behaviorismus wird teilweise die Anschauung vertreten, dass das Verhalten eines Tieres vollständig durch Belohnung für erwünschtes Verhalten (und – weniger verlässlich – durch Bestrafung für unerwünschtes Verhalten) beeinflusst werden kann, das heißt durch operante Konditionierung. Die Konditionierung von Verhalten (Synonyme: Verhaltensformung, shaping) in einer Skinner-Box gilt als besonders effiziente und überdies objektive Methode, da sie dem Testtier erlaubt, ohne allzu unnatürliche Einschränkung unterschiedlichste Verhaltensweisen zu zeigen und der Versuchsleiter nicht lenkend eingreift (Magazintraining).

Funktionsweise

Im typischen Fall besteht eine Skinner-Box aus einem vollständig leeren Käfig mit glatten Wänden, in dem ein kleiner Hebel (zum Beispiel für Ratten) oder eine kleine Pickscheibe (zum Beispiel für Tauben) angebracht ist, ein Ausgabeschacht für Futter sowie häufig zusätzlich eine kleine Lichtquelle. Die Hebel oder Pickscheiben sind mit einer Vorrichtung verbunden, die sowohl die Anzahl als auch die zeitliche Abfolge der Hebeldrücke oder des Pickens auf die Scheibe registriert. Die Versuchsanordnung ist denkbar einfach: Ein mit der Skinner-Box gänzlich unvertrautes, hungriges Tier wird in die Box gesetzt – und der Testleiter wartet ab, was geschieht.

Die „Bausteine“ der Apparatur können in derartigen Lerntests zum Beispiel wie folgt miteinander verschaltet sein: Solange die Lichtquelle aufleuchtet, führt ein Hebeldruck oder das Berühren der Pickscheibe dazu, dass etwas Futter in den Ausgabeschacht fällt; leuchtet die Lichtquelle nicht auf, hat das Berühren von Hebel oder Pickscheibe keine Futterausgabe zur Folge.

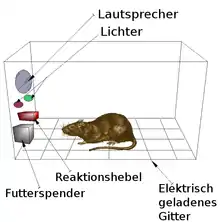

Eine eher ungewöhnliche Variante ist in der Abbildung dargestellt: Das Versuchstier erhält einen schwachen, „strafenden“ Stromstoß an den Füßen, wenn es nach einem akustischen oder visuellen Signal nicht binnen einer vorgegebenen Zeitspanne den Hebel drückt.

Da Hebel oder Pickscheibe in der Regel die einzigen „ungewöhnlichen“ Elemente im Inneren der Skinner-Box sind, wird das Testtier diese Elemente immer wieder einmal (und häufig besonders intensiv) beschnüffeln oder kräftiger berühren – zufälligerweise gerade auch dann einmal, während das Licht aufleuchtet. Da dann Futter ausgeschüttet wird, steigt die Wahrscheinlichkeit, dass das Testtier erneut am gleichen Ort im Käfig schnüffelt oder pickt – im Ergebnis lernen sowohl Ratten als auch Tauben außerordentlich rasch, das Aufleuchten der Lampe mit Hebeldruck oder Pickscheibe und Futterausgabe in Verbindung zu bringen. Ohne dass der Versuchsleiter in irgendeiner Weise lenkend eingreifen muss, lernen die Testtiere in der Skinner-Box also, dass eine bestimmte Aktion zur Futterausgabe führt.

Mit Ratten und anderen Nagern sind solche Lerntests praktisch überall reproduzierbar und zugleich äußerst anschaulich und beeindruckend, so dass sie mancherorts auch zum Repertoire des Schulunterrichts gehören.

Siehe auch

Einzelnachweise

- H. Roth: Skinner Box, S. 2095 in Wilhelm Arnold, Hans Jürgen Eysenck, Richard Meili: Lexikon der Psychologie, Bechtermünz Verlag, 1996

- B. F. Skinner: Cumulative record. 1999 definitive ed. Skinner Foundation, Cambridge, MA 1999, S. 620.