Sprachsynthese

Unter Sprachsynthese versteht man die künstliche Erzeugung der menschlichen Sprechstimme. Ein Text-to-Speech-System (TTS) (oder Vorleseautomat) wandelt Fließtext in eine akustische Sprachausgabe.

._%22The_Carrier_Nature_of_Speech%22._Bell_System_Technical_Journal%252C_XIX(4)%253B495-515._--_Fig.7_Schematic_circuit_of_the_vocoder_(derived_from_Fig.8).jpg.webp)

Grundsätzlich lassen sich zwei Ansätze zur Erzeugung von Sprachsignalen unterscheiden. Zum einen kann durch die sogenannte Signalmodellierung auf Sprachaufnahmen (Samples) zurückgegriffen werden. Zum anderen kann das Signal aber auch durch die sogenannte physiologische (artikulatorische) Modellierung vollständig im Rechner erzeugt werden. Während die ersten Systeme auf Formantsynthesen beruhten, basieren die zurzeit industriell eingesetzten Systeme vorwiegend auf Signalmodellierung.

Ein besonderes Problem für die Sprachsynthese ist die Erzeugung einer natürlichen Sprachmelodie (Prosodie).

Geschichte

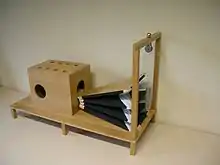

_(14733635746).jpg.webp)

Schon lange vor der Erfindung der elektronischen Signalverarbeitung versuchten Wissenschaftler Maschinen zu konstruieren, die menschliche Sprache erzeugen können. Gerbert von Aurillac (1003) wird ein aus Bronze gefertigter „Sprechender Kopf“ zugeschrieben, von dem berichtet wurde, dass er „ja“ und „nein“ sagen konnte. Wohl eher in den Bereich der Legenden gehören die Apparate von Albertus Magnus (1198–1280) und Roger Bacon (1214–1294).

Der deutsche, in Kopenhagen tätige Wissenschaftler Christian Kratzenstein baute 1779 aufgrund eines Preisausschreibens der St. Petersburger Akademie eine „Sprachorgel“, die durch freischwingende Lingualpfeifen mit dem menschlichen Vokaltrakt nachgebildeten Resonatoren fünf lange Vokale (a, e, i, o und u) synthetisieren konnte. Wolfgang von Kempelen entwickelte bereits seit ca. 1760 eine Sprechmaschine, die er 1791 in seiner Veröffentlichung „Mechanismus der menschlichen Sprache nebst der Beschreibung seiner sprechenden Maschine“ darstellte. Diese Synthese basierte wie Kratzensteins auf einem Blasebalg als Lungenäquivalent, die eigentliche Anregung geschah aber erheblich anatomienäher durch eine einzelne, aufschlagende Lingualpfeife. Damit waren einige Vokale und auch Plosive möglich. Darüber hinaus ließen sich über verschiedene Mechanismen einige Frikative darstellen. An den Stimmbändern schloss ein Ledertubus an, der durch eine Hand verformt werden konnte, und so die variable Geometrie und Resonanzverhalten des Vokaltrakts nachbildete. Von Kempelen schrieb:

„in einer Zeit von drei Wochen eine bewundernswerte Fertigkeit im Spielen erlangen, besonders wenn man sich auf die lateinische, französische oder italienische Sprache verlegt, denn die deutsche ist [aufgrund der häufigen Konsonantenbündel] um vieles schwerer.“

Charles Wheatstone baute 1837 eine Speaking Machine, die auf diesem Entwurf beruht, ein Nachbau findet sich im Deutschen Museum. 1857 baute Joseph Faber die Euphonia, die ebenso diesem Prinzip folgt.

Ende des 19. Jahrhunderts entwickelte sich das Interesse weg vom Nachbau menschlicher Sprachorgane (genetische Sprachsynthese), hin zur Simulation des akustischen Raumes (gennematische Sprachsynthese). So synthetisierte Hermann von Helmholtz erstmals Vokale mit Hilfe von Stimmgabeln, die auf die Resonanzfrequenzen des Vokaltraktes in bestimmten Vokalstellungen abgestimmt waren. Diese Resonanzfrequenzen werden als Formanten bezeichnet. Sprachsynthese durch Kombination von Formanten war technischer Mainstream bis in die Mitte der 1990er Jahre.

In den Bell Labs wurde in den 1930ern der Vocoder, ein tastaturgesteuerter elektronischer Sprachsynthesizer entwickelt, über den gesagt wurde, dass er klar verständlich war. Homer Dudley verbesserte diese Maschine zum Voder, der in der Weltausstellung 1939 präsentiert wurde. Der Voder benutzte elektrische Oszillatoren zur Erzeugung der Formantfrequenzen.

Die ersten computerbasierten Sprachsynthesesysteme wurden in den späten 1950ern entwickelt, das erste komplette Text-To-Speech-System 1968 fertiggestellt. Der Physiker John Larry Kelly, Jr entwickelte 1961 bei den Bell Labs eine Sprachsynthese mit einem IBM 704 und ließ ihn das Lied Daisy Bell singen. Der Regisseur Stanley Kubrick war davon so beeindruckt, dass er es in den Film 2001: A Space Odyssey integrierte.

Gegenwart

Während frühe elektronische Sprachsynthesen noch sehr roboterhaft klangen und teilweise schwer verständlich waren, erreichen sie etwa seit der Jahrtausendwende eine Qualität, bei der es mitunter schwierig ist, sie von menschlichen Sprechern zu unterscheiden. Das ist hauptsächlich der Tatsache zu verdanken, dass sich die Technologie von der eigentlichen Synthese des Sprachsignals abgewandt hat und sich darauf konzentriert, aufgenommene Sprachsegmente optimal zu verketten.[1][2][3]

Synthese

Sprachsynthese setzt eine Analyse der menschlichen Sprache voraus, bezüglich der Phoneme, aber auch der Prosodie, weil eben ein Satz allein durch die Satzmelodie unterschiedliche Bedeutungen haben kann.

Was den Syntheseprozess an sich betrifft, gibt es verschiedene Methoden. Gemeinsam ist allen Methoden, dass sie auf eine Datenbank zurückgreifen, in der charakteristische Informationen über Sprachsegmente hinterlegt sind. Elemente aus diesem Inventar werden zur gewünschten Äußerung verknüpft. Sprachsynthesesysteme lassen sich anhand des Inventars der Datenbank und insbesondere der Methode zur Verknüpfung klassifizieren. Tendenziell fällt die Signalsynthese umso einfacher aus, je größer die Datenbank ist, da diese dann bereits Elemente enthält, die der gewünschten Äußerung näher sind und weniger Signalbearbeitung notwendig ist. Aus dem gleichen Grund gelingt bei einer großen Datenbank meistens eine natürlicher klingende Synthese.

Eine Schwierigkeit der Synthese liegt in dem Aneinanderfügen von Inventarelementen. Da diese aus verschiedenen Äußerungen stammen, unterscheiden sie sich auch in der Lautstärke, der Grundfrequenz und der Lage der Formanten. Bei einer Vorverarbeitung der Datenbank oder beim Verbinden der Inventarelemente müssen diese Unterschiede möglichst gut ausgeglichen werden (Normalisierung), um nicht die Qualität der Synthese zu beeinträchtigen.

Unit Selection

Die Unit Selection liefert die beste Qualität besonders bei einer eingeschränkten Domäne. Die Synthese verwendet eine große Sprachdatenbank, in der jede aufgenommene Äußerung in einige oder alle der folgenden Einheiten segmentiert wird:

Diese Segmente werden mit einem Verzeichnis von einer Reihe akustischer und phonetischer Eigenschaften wie Grundfrequenzverlauf, Dauer oder Nachbarn gespeichert.

Für die Synthese werden durch spezielle Suchalgorithmen, gewichtete Entscheidungsbäume, eine Reihe von möglichst großen Segmenten bestimmt, die der zu synthetisierenden Äußerung hinsichtlich dieser Eigenschaften möglichst nahekommen. Da diese Reihe ohne oder mit wenig Signalverarbeitung ausgegeben wird, bleibt die Natürlichkeit der gesprochenen Sprache erhalten, solange wenige Verkettungsstellen erforderlich sind.

Diphonsynthese

Anfang des 21. Jahrhunderts durchgeführte Experimente haben gezeigt, dass die korrekte Wiedergabe der Lautübergänge wesentlich für die Verständlichkeit der Sprachsynthese ist. Um alle Lautübergänge zu speichern, wird eine Datenbasis mit etwa 2500 Einträgen verwendet. Darin ist jeweils der Zeitbereich des stationären Teils, die Phonemmitte eines Phonems, bis zum stationären Teil des folgenden Phonems abgespeichert. Für die Synthese werden die Informationen entsprechend zusammengefügt (konkateniert).

Weitere Koartikulationseffekte, die viel zur Natürlichkeit der Sprache beitragen, können durch umfangreichere Datenbasen berücksichtigt werden. Ein Beispiel dafür ist Hadifix, das Halbsilben, Diphone und Suffixe enthält.

Signalerzeugung

Die Signalerzeugung gibt die gewünschten Segmente aus der Datenbank mit dem vorgegebenen Grundfrequenzverlauf wieder. Diese Ausprägung des Grundfrequenzverlaufs kann auf verschiedene Arten geschehen, worin sich die folgenden Verfahren unterscheiden.

Quelle-Filter-Modell

Bei Synthesen, die eine Quelle-Filter-Separation verwenden, wird eine Signalquelle mit periodischer Signalform verwendet. Deren Periodenlänge wird passend zur Grundfrequenz der zu synthetisierenden Äußerung eingestellt. Dieser Anregung wird je nach Phonemtyp zusätzlich Rauschen beigemischt. Die abschließende Filterung prägt die lautcharakteristischen Spektren auf. Vorteilhaft bei dieser Klasse von Verfahren ist die einfache Grundfrequenzsteuerung der Quelle. Ein Nachteil ergibt sich durch die in der Datenbank gespeicherten Filterparameter, deren Bestimmung aus Sprachproben schwierig ist. Je nach Art des Filters bzw. der zugrunde liegenden Sichtweise des Sprechens unterscheidet man die folgenden Verfahren:

Formantsynthese

Die Formantsynthese beruht auf der Beobachtung, dass es zur Unterscheidung der Vokale genügt, die ersten zwei Formanten treffend zu reproduzieren. Jeder Formant wird durch einen in der Mittenfrequenz und Güte steuerbaren Bandpass, ein Polfilter 2. Ordnung, nachgebildet. Die Formantsynthese ist durch analoge elektronische Schaltungen vergleichsweise einfach realisierbar.

Akustisches Modell

Das akustische Modell bildet die gesamten Resonanzeigenschaften des Vokaltrakts durch einen geeigneten Filter nach. Häufig wird der Vokaltrakt dazu vereinfacht als Rohr variablen Querschnitts betrachtet, wobei Quermoden vernachlässigt werden, da die seitliche Ausdehnung des Vokaltrakts klein ist. Die Querschnittsänderungen werden weiterhin durch äquidistante Querschnittssprünge approximiert. Ein häufig gewählter Filtertyp ist der Kreuzgliedketten-Filter, bei dem eine direkte Beziehung zwischen Querschnitt und Filterkoeffizient besteht.[4]

Diese Filter sind eng verwandt mit dem Linear Predictive Coding (LPC), das ebenfalls für Sprachsynthesen eingesetzt wird. Bei dem LPC werden ebenfalls die gesamten Resonanzeigenschaften berücksichtigt, es besteht jedoch kein direkter Zusammenhang zwischen Filterkoeffizienten und Querschnittsverlauf des Vokaltrakts.

Artikulatorische Synthese

Die artikulatorische Synthese stellt gegenüber dem akustischen Modell eine Beziehung zwischen der Stellung der Artikulatoren und dem daraus resultierenden Querschnittsverlauf des Vokaltrakts her. Hier kommen zur Nachbildung der Resonanzcharakteristik neben zeitdiskreten Kreuzgliedkettenfiltern auch Lösungen der zeitkontinuierlichen Horngleichung zum Einsatz, aus denen das Zeitsignal durch Fouriertransformation gewonnen wird.

Overlap Add

Pitch Synchronous Overlap Add, abgekürzt PSOLA, ist ein Syntheseverfahren, bei dem sich in der Datenbank Aufzeichnungen des Sprachsignals befinden. Sofern es sich um periodische Signale handelt, sind diese mit einer Information über die Grundfrequenz (Pitch) versehen und der Anfang jeder Periode ist markiert. Bei der Synthese werden diese Perioden mit einem bestimmten Umfeld mittels einer Fensterfunktion ausgeschnitten und dem zu synthetisierenden Signal an passender Stelle hinzuaddiert: Je nachdem ob die gewünschte Grundfrequenz höher oder tiefer liegt als die des Datenbankeintrags, werden sie entsprechend dichter oder weniger dicht als in dem Original zusammengefügt. Zur Anpassung der Lautdauer können Perioden entfallen oder doppelt ausgegeben werden. Dieses Verfahren wird auch als TD-PSOLA oder PSOLA-TD (TM) bezeichnet, wobei TD für Time Domain steht und hervorhebt, dass die Verfahren im Zeitbereich arbeiten.

Eine Weiterentwicklung ist das Multi Band Resynthesis OverLap Add – Verfahren, kurz MBROLA. Hier werden die Segmente in der Datenbank durch eine Vorverarbeitung auf eine einheitliche Grundfrequenz gebracht und Phasenlage der Harmonischen wird normalisiert. Dadurch entstehen bei der Synthese eines Übergangs von einem Segment auf das nächste weniger perzeptiv wahrnehmbare Störungen und die erzielte Sprachqualität ist höher.

Diese Syntheseverfahren sind mit der Granularsynthese verwandt, die in Klangerzeugung und -verfremdung bei elektronischer Musikproduktion zum Einsatz kommt.

Parametrische Sprachsynthese aus Hidden-Markov-Modellen (HMM) und/oder stochastischen Markov-Graphen (SMG)

Die parametrische Sprachsynthese ist eine Gruppe von Verfahren, welche auf stochastischen Modellen basieren. Bei diesen Modellen handelt es sich entweder um Hidden Markov Modelle (HMM), um stochastische Markov-Graphen (SMG), oder neuerdings auch um eine Kombination dieser beiden. Grundprinzip ist, dass die aus einer Textvorverarbeitung gewonnenen, symbolischen Phonemfolgen eine statistische Modellierung durchlaufen, indem sie zunächst in Segmente zerlegt und jedem dieser Segmente sodann ein bestimmtes Modell aus einer bestehenden Datenbasis zugeordnet wird. Jedes dieser Modelle wiederum wird durch eine Reihe von Parametern beschrieben und schließlich mit den anderen Modellen verkettet. Die Verarbeitung zu einem künstlichen Sprachsignal, das sich an den besagten Parametern orientiert, schließt die Synthese dann ab. Im Falle der Verwendung flexiblerer, stochastischer Markov-Graphen, lässt sich ein solches Modell sogar insofern optimieren, als dass ihm vorab und mittels Zuführung von Beispielen natürlicher Sprache eine gewisse Grundnatürlichkeit antrainiert werden kann. Statistische Verfahren dieser Art entstammen dem konträren Bereich der Spracherkennung und motivieren sich durch Erkenntnisse über den Zusammenhang zwischen der Wahrscheinlichkeit einer bestimmten, gesprochenen Wortfolge und der dann zu erwartenden, ungefähren Sprechgeschwindigkeit, oder ihrer Prosodie.[5][6][7]

Einsatzmöglichkeiten von Text-to-Speech-Software

Die Nutzung von Sprachsynthese-Software muss kein Selbstzweck sein. Menschen mit Sehbehinderungen – z. B. Grauem Star oder Altersbedingter Makuladegeneration – nutzen TTS-Softwarelösungen, um sich Texte direkt am Bildschirm vorlesen zu lassen. Blinde Menschen können einen Computer mittels einer Screenreader-Software bedienen und bekommen Bedienelemente und Textinhalte angesagt. Aber auch Dozenten nutzen die Sprachsynthese für die Aufzeichnung von Vorträgen. Ebenso nutzen Autoren TTS-Software, um selbst geschriebene Texte auf Fehler und Verständlichkeit hin zu prüfen.

Ein weiteres Einsatzgebiet findet sich in Form von Software, die das Erzeugen von MP3-Dateien erlaubt. Hierdurch kann Sprachsynthese-Software für die Erzeugung einfacher Podcasts bzw. Audioblogs genutzt werden. Erfahrungsgemäß kann die Produktion von Podcasts bzw. Audioblogs sehr zeitintensiv sein.

Bei der Arbeit mit US-amerikanischer Software ist zu beachten, dass die vorhandenen Stimmen von unterschiedlicher Güte sind. Englische Stimmen haben eine höhere Qualität als deutsche. Eine Ursache ist die reduzierte Verfügbarkeit größerer deutscher Sprachdatenbanken, welche als Grundlage für das Training eines künstlichen Modells erforderlich sind. Das deutschsprachige Projekt Thorsten (Stimme) versucht diese Lücke zu schließen. Eine 1:1-Kopie der Texte in eine TTS-Software kann nicht empfohlen werden, eine Nachbearbeitung ist in jedem Fall nötig. Dabei geht es nicht nur um das Ersetzen von Abkürzungen und Zahlen in geschriebenen Text, auch das Einfügen von Satzzeichen – auch wenn diese grammatikalisch nicht korrekt sind – kann helfen, um auf das Satztempo Einfluss zu nehmen. Deutsche „Übersetzungen“ mit Anglizismen stellen für die Sprachsynthese i. d. R. ein unüberwindbares Problem dar.

Häufige Anwendungen sind Ansagen in Telefon- und in Navigationssystemen.

Sprachsynthese-Software

- AnalogX SayIt

- Aristech

- Audiodizer

- Balabolka (Freeware, 26 Sprachen, SAPI4 und SAPI5)

- BOSS, entwickelt am Institut für Kommunikationswissenschaften der Universität Bonn

- Browsealoud von textHELP

- Cepstral Text-to-Speech

- CereProc

- Coqui AI[8]

- DeskBot

- espeak (Open Source, viele Sprachen, SAPI5)

- Festival

- Festvox

- FreeTTS (Open Source)

- GhostReader

- Gnuspeech

- Infovox

- IVONA Text-to-Speech

- Linguatec Voice Reader 15

- Logox Clipreader

- Loquendo TTS

- MacinTalk und narrator.device von SoftVoice

- MARY Text-To-Speech entwickelt vom DFKI Language Technology Lab

- MBROLA[9] unterschiedliche Stimmen (fertigen Phoneme) in verschiedenen Sprachen, die von Sprachsynthesesoftware wie eSpeak oder Festival benutzt werden können.[10]

- Modulate[11] Software zur Stimmkonversion, benutzt Generative Adversarial Networks[12]

- Mozilla TTS[13]

- NaturalReader von NaturalSoft

- OnScreenVoices von tom weber software

- ReadSpeaker: Webseiten vorlesen und Podcasting

- Realspeak von Nuance (ehem. ScanSoft), jetzt Kobaspeech 3

- SAM von Don't Ask Software[14]

- SpeechConcept

- Sprechomat

- libttspico-utils von SVOX (Kommandozeilen gesteuerte Sprachsynthese in Deutsch, Englisch (GB und US), Spanisch, Französisch und Italienisch)[15]

- Synte 2

- Synte 3

- SYNVO

- Tacotron (Google)[16]

- Text Aloud MP3

- Toshiba ToSpeak

- TTS Robot

- virsyn CANTOR Vokalsynthese

- Virtual Voice

Sprachsynthese-Hardware

- Votrax

- SC-01A (analog formant)

- SC-02 / SSI-263 / „Arctic 263“

- General Instrument Speech Processor

- SP0250

- SP0256-AL2 „Orator“ (CTS256A-AL2)

- SP0264

- SP1000

- Mullard MEA8000[17]

- National Semiconductor DT1050 Digitalker (Mozer)

- Silicon Systems SSI 263 (analog formant)

- Texas Instruments

- Oki Semiconductor

- MSM5205

- MSM5218RS (ADPCM)

- Toshiba T6721A C²MOS Voice Synthesizing LSI

Siehe auch

Literatur

- Karlheinz Stöber, Bernhard Schröder, Wolfgang Hess: Vom Text zur gesprochenen Sprache. In: Henning Lobin, Lothar Lemnitzer (Hrsg.): Texttechnologie. Perspektiven und Anwendungen. Stauffenburg, Tübingen 2004, ISBN 3-86057-287-3, S. 295–325.

- Jessica Riskin: Eighteenth-Century Wetware. In: Representations. Bd. 83, Nr. 1, 2003, ISSN 0734-6018, S. 97–125, doi:10.1525/rep.2003.83.1.97.

- James L. Flanagan: Speech Analysis, Synthesis and Perception (= Kommunikation und Kybernetik in Einzeldarstellungen. Bd. 3). 2nd edition. Springer, Berlin u. a. 1972, ISBN 3-540-05561-4. 1. Aufl. 1965, 3. Aufl. 2008[18]

- Ville Pulkki, Matti Karjalainen: Communication Acoustics: An Introduction to Speech, Audio and Psychoacoustics. John Wiley & Sons, 2015, ISBN 978-1-118-86654-2.

Weblinks

Geschichte

- Geschichte der Sprachsynthese anhand von Beispielen. Studienarbeit (PDF; 480 kB).

- Magic Voice Speech Module für den C64

Systeme

- Produkttests und ausführliche Informationen zu Vorlesesystemen im INCOBS

- Produkttests und ausführliche Informationen zu Screenreader im INCOBS

- Liste von Sprachsynthesesystemen mit Beispielen

Webinterfaces

- Pediaphon – Sprachausgabe für deutschsprachige Wikipedia-Artikel

- Online-Demo des Text-to-Speech-Sprachsynthese-Programmes MARY – Text-to-Speech-Ausgabe in verschiedene Formate.

- Online-Demo „Text in Sprache“ via Google Chrome.

Fußnoten

- Dennis Klatt’s History of Speech Synthesis (Memento vom 4. Juli 2006 im Internet Archive)

- Sami Lemmetty: History and Development of Speech Synthesis. In: Review of Speech Synthesis Technology. HELSINKI UNIVERSITY OF TECHNOLOGY, 1. Juni 1999, abgerufen am 14. März 2019 (englisch).

- Arne Hoxbergen: Die Geschichte der Sprachsynthese anhand einiger ausgewählter Beispiele (PDF; 490 kB). Berlin 2005.

- Karl Schnell: Rohrmodelle des Sprechtraktes. Frankfurt 2003.

- Patent DE10040991C1: Verfahren zur parametrischen Synthese von Sprache. Angemeldet am 18. August 2000, veröffentlicht am 27. September 2001, Anmelder: Technische Universität Dresden, Erfinder: Matthias Eichner, Matthias Wolf.

- [https://de.wikipedia.org/w/index.php?title=Wikipedia:Defekte_Weblinks&dwl=http://www.ims.uni-stuttgart.de/lehre/studentenarbeiten/fertig/Diplomarbeit_Breitenbuecher.ps.gz Seite nicht mehr abrufbar], Suche in Webarchiven: [http://timetravel.mementoweb.org/list/2010/http://www.ims.uni-stuttgart.de/lehre/studentenarbeiten/fertig/Diplomarbeit_Breitenbuecher.ps.gz Diplomarbeit_Breitenbuecher]

- Archivierte Kopie (Memento vom 21. Juli 2014 im Internet Archive)

- Homepage Coqui AI - https://coqui.ai

- Welcome to MBROLA project. In: GitHub. UMONS Institute for Creative Technologies, 30. Januar 2022, abgerufen am 30. Januar 2022 (englisch).

- Sprachausgabe. In: Wiki.ubuntuusers.de. Abgerufen am 30. Januar 2022.

- Modulate: Unlock your voice. Abgerufen am 14. März 2019.

- Technology Review: Sprechen wie Barack Obama. 14. März 2019, abgerufen am 14. März 2019.

- mozilla/TTS. Mozilla, 7. Februar 2021, abgerufen am 7. Februar 2021.

- https://simulationcorner.net/index.php?page=sam

- libttspico-utils - Paketbeschreibung bei Debian

- Sebastian Grüner: Tacotron 2: Googles Sprachsynthese erreicht fast menschliche Qualität - Golem.de. In: golem.de. 21. Dezember 2017, abgerufen am 14. März 2019.

- http://vesta.homelinux.free.fr/wiki/le_synthetiseur_vocal_mea_8000.html

- Inhaltsverzeichnis (pdf)